一种基于SLAM和人群异常行为识别的安防巡检系统和方法

- 国知局

- 2024-07-31 21:37:34

本发明属于自动化安全巡视,具体涉及一种基于slam和人群异常行为识别的安防巡检系统和方法。

背景技术:

1、随着智慧社区发展的进一步深入,监管低效、应急滞后和成本高昂的人工社区安全监管制度导致社区出现人群异常行为时无法及时预警和处理。而这些行为可能会给居民带来较大的损失,所以及时预警人群异常行为并快速响应社区中发生的意外状况变得十分重要。作为一种智能化生产巡视的方法,人群异常行为预警是视频理解与计算机视觉领域炙手可热的研究内容,备受国内外学者的关注,在智能监控、人机交互等多领域被广泛应用。

2、当前,社区活动和生活场所的人群异常行为预警通常是采用固定摄像头配合人工巡检的方式,但是人工巡视存在人力成本开销大、应急能力不足以及人员情绪化等问题。而且当人群异常行为发生时,社区监管往往无法第一时间响应,只能在事后调取监控或走访调查,无法及时预警危险。并且,常见的基于摄像机的人群异常行为识别方案受制于摄像机位置,只能对社区小部分地区的小部分人群行为进行分析。而且受制于摄像机的清晰度,基于摄像机的人群异常行为识别方案往往也无法准确的判断人群的行为,只能进行粗略的判断。针对于环境相关度大的人群异常行为,也无法正确有效的识别及相应预警。

技术实现思路

1、针对当人群异常行为发生时,社区监管往往无法第一时间响应,只能在事后调取监控或走访调查,无法及时预警危险等问题,本发明提供了一种基于slam和人群异常行为识别的安防巡检系统和方法。

2、为了达到上述目的,本发明采用了下列技术方案:

3、一种基于slam和人群异常行为识别的安防巡检系统,包括上层系统和下层系统;所述的上层系统配置激光建图单元、自主导航单元和人群异常行为检测单元;所述的激光建图单元以单线激光雷达为硬件基础,gmapping算法为软件基础完成建图功能;所述的自主导航单元采用a*和dwa融合算法完成自主导航功能;所述的人群异常行为检测单元以rgb-d深度相机为硬件基础,以st-gcn算法为深度学习算法模型完成人群异常行为检测;

4、所述的下层系统配置车身控制单元、通信预警单元;所述的车身控制单元以六轴加速度传感器、履带、电源以及电机为基础完成机器人控制;通信预警单元采用六麦克风语音阵列和云服务器完成语音识别和通信预警;

5、所述的上层系统与下层系统通过串口通信连接,上层系统控制下层系统,并扩充下层系统的运算资源。

6、进一步,上层控制系统采用英伟达jetson nano为核心,安装有ros系统,以python3.8、pytorch 1.13.0和mmcv 2.1为深度学习算法运行环境;

7、激光建图单元依托ros系统和改进的gmapping算法、以2d单线激光雷达为硬件基础,使用rbpf算法完成2d栅格地图构建,采用粒子滤波算法对机器人位姿进行准确估计;

8、自主导航单元采用a*算法搜索二维栅格地图网络中机器人当前位姿与目标点之间的最短路径,同时采用dwa算法根据移动机器人当前的位置状态和速度状态,然后计算机器人在这些速度情况下移动一定时间内的轨迹,从而有效的避开障碍物。

9、人群异常行为检测单元使用改进的yolov7算法对rgb-d深度相机采集到的视频进行采集和片段截取,利用改进的simcc提取出视频中行人的关键点,结合st-gcn算法对目标人员行为进行判断,并根据空间信息确定人员是否出现跌倒或者打架行为。

10、进一步,下层控制系统采用stm32f407作为主控芯片,采用串口通信控制车身控制单元和通信预警单元。车身包括车头、车体和底盘。车头安装rgb-d深度相机和单线激光雷达,车体安装通信模块以及上下层控制电路板。底盘的内部安装电源模块、电机驱动板、解码器以及履带。

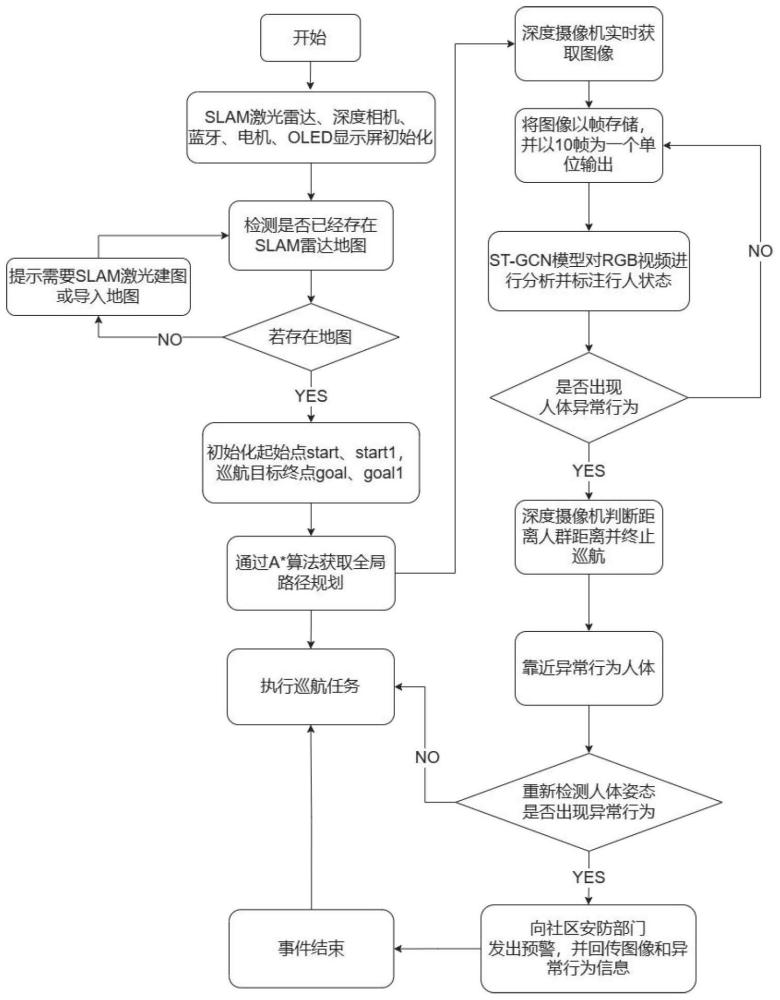

11、一种基于slam和人群异常行为识别的安防巡检系统的巡检方法,其工作步骤如下:

12、步骤1:将安防巡检机器人置于工作区域的地面上,打开安装在底盘上电源模块的总电源,开启车身上jetson nano电路板开关,进入安防巡检机器人运行模式;

13、步骤2:在ros系统中选择地图自主建模模式,设置安防巡检机器人的移动速度;机器人开始移动,通过激光雷达返回周围环境的点云数据判断周围是否存在障碍物,并逐步完善地图信息;在经过运动畸变去除处理后,提取出激光雷达扫描获取的2d栅格地图,并将其保存在map路径下;

14、进一步,步骤2的具体方法为:

15、步骤2.1:安防巡检机器人开始运行后,使用单线激光雷达360度扫描周围环境,当激光雷达按照所设定的扫描频率20hz工作时,激光雷达每隔一个扫描周期50ms完成一次360度环境的扫描,并将所扫描的360度的环境数据作为完整的一帧数据;

16、步骤2-2,在激光雷达获得完整一帧扫描数据期间,由于机器人的运动,所以收到的激光雷达的扫描数据是在激光雷达处于不同的位置时获得的,因此,需要在该扫描周期50ms期间,获得在每个激光扫描点时刻机器人所对应的位姿;采用改进的gmapping算法对当前时刻所接收到的激光雷达获取到的扫描数据进行处理,由此可得到在同一时间戳时刻且在同一位置处,激光雷达扫描360度环境完整一帧的扫描数据;其中改进的gmapping算法过程包括:

17、步骤2.2.1:输入最近时刻t的粒子群、采样子集并初始化粒子群,遍历上一时刻粒子群中的粒子,并获取粒子携带的位姿、权重和地图;

18、步骤2.2.2:通过里程计进行位姿更新,采用极大似然估计求取局部极值;如果未求得局部极值,则使用观测模型更新粒子位姿权重状态;如果求得局部极值,则在局部极值附近取k个位姿,并计算k个位姿得均值、权重以及方差;然后使用多元正态分布近似新的位姿,并计算新的位姿粒子权重。

19、步骤2.2.3:更新地图,更新粒子群,循环遍历上一时刻的所有粒子;计算所有粒子权重的离散程度,并根据阈值判断粒子权重是否符合要求;若小于阈值,则说明粒子差异性过大,需要进行重新采样;若大于阈值,则结束进程。

20、步骤2.3:根据优化后的完整一帧扫描数据,逐帧进行位姿变换并拼接,然后采用相邻帧边约束的方法,根据与当前帧相关联的关键候选帧,通过对齐匹配地标来校正姿态累计误差,其中关键候选帧的选择条件和添加的约束表示为:

21、||xip-xjp||<thdist (1)

22、‖path(xi,xj)‖<thpath (2)

23、score(xi,xj)<thscore (3)

24、式中:xi为第i个关键帧的估计位姿;p为关键帧权重;path为关键帧的最小距离;score为匹配结果的评分;thdist为设定的阈值;thpath为设定的距离阈值;thscore为设定的得分阈值;||...||表示取绝对值。最后得到全局静态2d栅格地图,并将其保存至“map”的路径下。

25、步骤3:在2d栅格地图中标定巡检区域与目标点,机器人采用a*算法搜索二维栅格地图网络中机器人当前位姿与目标点之间的最短路径,同时根据激光雷达捕获到的障碍物信息,采用dwa算法进行局部路径规划,从而避开临时障碍物;

26、进一步,步骤3的具体方法为:

27、步骤3.1:基于步骤2生成的2d栅格地图网络,标注机器人巡航区域和巡航目标位置;

28、步骤3.2:使用a*算法进行机器人巡航的全局路径规划,生成初始路径;所述a*算法过程为:

29、步骤3.2.1:从机器人起点a开始,检查其相邻的栅格,并将它们加入到由栅格构成的openlist中;

30、步骤3.2.2:检查与起点a相邻的方格,忽略其中不可通行障碍物所占领的方格,把其中可行走的或者可到达的方格加入到openlist中;

31、步骤3.2.3:遍历openlist,并计算估价函数f(n),其中f(n)的计算公式为:

32、f(n)=g(n)+h(n) (4)

33、其中,g(n)为从起点a移动到指定方格的移动代价,g(n)为当前位置的g值,h(n)为计算从当前方格横向或纵向移动到达目标所经过的方格数,忽略对角移动,总数乘以10;从openlist中选择f值最小的方格节点,将其设置为起点a,并再次执行步骤3.2.2;当相邻最小f(n)的方格已经存在openlist时,判断最小f(n)方格的g值是否小于g(n),即判断g值是否为下一个位置的g值,检查这条路径是否更好,用g(n)值做参考;更小的g值表示这是更好的路径,但是如果不是,则回退至上层起点,并在剔除本次方格的情况下重新计算它的g值和f值,然后重新选择路径;

34、步骤3.2.4:当终点b加入到openlist中时,则保存路径;

35、步骤3.3:安防巡航机器人按照a*算法的全局规划路径执行巡航任务,并利用激光雷达检测周围环境是否存在动态障碍物,当发现障碍物时,则在全局路径的基础上调用dwa算法进行局部路径规划,从而规避动态障碍物;所述dwa算法过程包括:

36、步骤3.3.1:根据小车当前状态(v,ω),求解机器人在不同速度和角速度状态下的预测状态,并模拟这些速度在一定时间内的运动轨迹;

37、步骤3.3.2:采用评价函数评价不同预测状态下的评价函数的值;其中评价函数g(v,ω)表示为:

38、g(v,ω)=σ(α*heading(v,ω)+β*dist(v,ω)+γ*vel(v,ω)) (5)

39、其中,heading(v,ω)为方位角评价函数:评价机器人在当前的设定的速度下,轨迹末端朝向与目标点之间的角度差距;dist(v,ω)表示机器人处于预测轨迹末端点位置时与地图上最近障碍物的距离,对于靠近动态障碍物的采样点进行惩罚,确保机器人的避障能力,降低机器人与障碍物发生碰撞的概率;vel(v,ω)为当前机器人的线速度,保证机器人快速到达目标;α、β、γ、σ为权重;

40、步骤3.3.3:归一化评价函数,采用softmax选取合适的评价函数对应的预测状态的线速度和角速度作为下一个原始状态的线速度和角速度;

41、步骤3.4:更新机器人状态,采用a*算法重新为机器人规划全局路径,并继续执行巡航任务。

42、步骤4:机器人在执行巡检任务的同时,集成在英伟达jetson nano电路板上集成的机器学习视觉模块通过rgb-d深度相机进行图像检测和信息提取;采用改进的yolov7算法检测行人和物品,利用改进的simcc算法提取出相机中采集到的人体关键点,然后采用st-gcn算法融合多帧图像信息,结合时空卷积判断人体姿态;

43、进一步,步骤4的具体方法为:

44、步骤4.1:读取rgb-d深度相机获取的视频流信息,作为系统输入;

45、步骤4.2:利用改进的yolov7,提取视频流中的行人目标以及与危险行为有关的目标物体;

46、所述的改进的yolov7算法具体为:网络结构上,在yolov7框架上使用部分卷积压缩卷积核的通道数,降低模型的参数量;重新构建一个ca注意力模块,使得网络在获取跨通道信息的同时,捕获到图像的位置信息和方向信息;损失函数上,采用wise-iou损失函数替换原算法中的ciou,引入非单调动态聚焦机制,提升算法的特征提取能力;

47、步骤4.3:以提取到的目标人员区域作为人体姿态检测的输入,利用改进的simcc提取出视频流中行人的人体关键点表示;

48、所述的改进的simcc算法具体为:网络结构上,通过将自注意机制和一种新颖的空间卷积相结合,litefnet使特征图在底层网络中获得更具信息性的全局特征表示;改进的simcc算法添加大核卷积和自注意机制的方式,增强simcc处理空间信息的能力,获取有效关键点特征表示。

49、所述步骤4.3:以提取到的目标人员区域作为人体姿态检测的输入,利用改进的simcc提取出视频流中行人的人体关键点表示时,使用yolov7作为simcc的人体检测算法,并对检测出的行人进行翻转和裁剪处理,最终预测的关键点一共17个,包括:鼻子、左眼、右眼、左耳、右耳、左肩、右肩、左肘、右肘、左腕、右腕、左胯、右胯、左膝、右膝、左踝、右踝。

50、步骤4.4:使用st-gcn对目标人员行为进行分析判断,结合空间信息确定人员是否出现异常行为;

51、所述步骤4.4:使用st-gcn对目标人员行为进行分析判断,结合空间信息确定人员是否出现异常行为中检测跌倒的具体步骤为:

52、首先检测是否存在行人,当存在行人时,对采集到的行人进行翻转和裁剪处理,检测每一位行人的关键点表示,采用st-gcn网络结合时间卷积判断人群行为,如果人群行为分类为跌倒且跌倒得分超越阈值,阈值如表1所示,认为行人存在跌倒的状况;如果连续8s均检测出行人跌倒的状况,则靠近跌倒目标进行语音求助并向上位机发送求助信息。

53、表1人群异常行为检测指标

54、

55、所述步骤4.4:使用st-gcn对目标人员行为进行分析判断,结合空间信息确定人员是否出现异常行为中检测打架的具体步骤为:

56、首先同时检测危险物品和人群,如果存在危险物品,则立刻向上位机进行预警处理,如果没有危险物品则根据st-gcn的人群行为进行分类,当分类为打架且得分超过阈值时,则将人群标注为fighting,当fighting状态持续保持5s时,则认为人群存在打架的危险行为,进行语音预警并向上位机发送信息。

57、步骤4.5:将判断出的危险行为信息传输到前端进行显示以及预警,同时控制小车靠近异常人群进行预警或者救助。

58、步骤5:当检测到图像范围内出现人群异常行为时,上层系统会将行为信息数据传递给底层控制系统,此时安防巡检机器人会移动至目标行人或人群附近,提醒人群这里需要救助或者预警人群不要发生冲突,并把事件信息通过通信模块返回至社区管理部门。

59、与现有技术相比本发明具有以下优点:

60、1.本发明创新性的将激光slam、st-gcn视频理解算法与ros机器人进行了有效的结合,相比于目前普通的无人巡航车,引入了视频流分析,克服了目前无人巡航车作用小、适用范围小以及成本高的问题;

61、2.本发明设计了相邻帧边约束算法来优化复杂环境下的slam建图的位姿累积误差,相比于目前只采用闭环检测算法的slam建图算法来说,相邻帧边约束算法能够对点云地图的累计误差进行更好的优化,且对于连续变化的场景也能够获得更好的效果;

62、3.本发明通过改进yolov7算法,首先重新设计了elan模块,通过使用部分卷积有效降低参数量与运算量;然后添加了ca注意力机制,获取通道信息与位置信息,帮助算法高效地定位识别目标以提高在识别小物体上的准确率。经过测试验证,改进算法的准确率提升2.3%,参数量降低12.3%,在达到轻量化的同时避免检测精度降低,如表2所示。

63、表2对比实验结果

64、

65、4.本发明通过改进simcc人体姿态估计识别算法,有效地将自注意机制和一种新颖的空间卷积相结合,在底层网络中获得了更具信息性的全局特征表示。此外,改进的simcc算法还通过添加大核卷积和自注意机制的方式,增强了simcc处理空间信息的能力,获取了更有效的关键点特征表示。经过测试验证,相比于基于resnet的simcc算法,改进的simcc算法在减少了46.0%的gflops的同时取得了2.0pck的提升,与其他的基于热图或回归的算法相比,改进的simcc算法也在gflops和精度上取得了最佳的平衡,如表3所示。

66、表3mpii数据集中不同算法结果对比。

67、

68、5.本设计采用结构优化后的人群异常行为检测算法在多个检测数据集上取得了精度的提升,如表4所示。相比于同类型的视频理解算法,我们的算法在距离人群15m内均能够更加有效的识别人体关键点和人群异常行为。

69、表4人群异常行为检测精度对比

70、

本文地址:https://www.jishuxx.com/zhuanli/20240731/190364.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表