一种卫星NOMA通信系统分组与功率分配联合优化方法与流程

- 国知局

- 2024-08-02 14:36:26

本发明属于卫星移动通信领域,具体涉及到卫星非正交多址接入(nonorthogonal multipleaccess,noma)通信系统中一种卫星noma通信系统分组与功率分配联合优化方法,用于解决卫星noma通信系统中手机用户和物联网设备资源调度问题。

背景技术:

1、由于地面移动蜂窝网络的覆盖范围有限,无法为海洋、荒漠等偏远地区提供通信服务。手机直接与卫星连接,可以有效解决目前地面移动通信系统覆盖范围有限和服务质量(qos)不足的问题。但是,手机需要更多的带宽和功率来保证宽带通信质量,因此,提高时频资源利用率成为了亟待解决的问题。noma可允许多个用户同时使用相同的时频资源进行通信,它在相同无线资源上分配多个信息流,并在发送端引入干扰信息,在接收端通过串行干扰消除技术(sic)来分离多个用户的信息,是一种提高频谱效率的多用户接入方式。

2、基于非正交多址的手机直连卫星与卫星物联网(iot)的融合是当前的热门研究方向。采用noma技术进行通信时,根据用户的信道条件和通信需求设计合适的用户分组和功率分配方式,可以降低系统的干扰并提升频谱利用率。在手机直连卫星与卫星物联网融合的场景中,由于手机的qos要求较高,而物联网的系统吞吐量通常较小,卫星首先保证手机的qos要求,将每部手机和一个物联网终端划分为一个noma用户组,使用相同的频域资源。上述基于noma的手机与物联网融合卫星网络的方案在满足手机qos要求的同时,还能有效提高卫星资源的利用效率。

3、资源调度是上述融合网络一个重要的研究课题,因为资源调度直接影响到qos要求和资源利用率。基于noma的手机和iot融合卫星网络的资源调度将面临三大挑战,分别是noma用户分组、组间资源调度和组内资源调度。针对这三个问题有许多可行的优化算法,但是独立优化的方法很难获得较好的全局解。

4、深度强化学习(drl)框架可以通过代理的不断探索和学习获得相当大的全局解,已在5g移动通信中得到广泛研究。基于近端策略优化(ppo)算法是强化学习领域主流的算法之一,能够实现对同一批次数据的多次梯度更新,提升数据的利用率。此外,ppo算法能够处理离散和连续的动作空间,这使得该算法具有广泛的应用性。其次,相较于标准梯度策略算法每次数据采样只能进行一次梯度更新,ppo算法所使用的目标函数能够利用同一批次数据进行多次梯度更新,大大提高了学习效率。ppo算法计算效率高,容易实现,能够保证算法稳定性和较高的性能。

技术实现思路

1、有鉴于此,本发明为了解决背景技术中的问题设计了一种卫星noma通信系统分组与功率分配联合优化方法。

2、本发明采用的技术方案为:

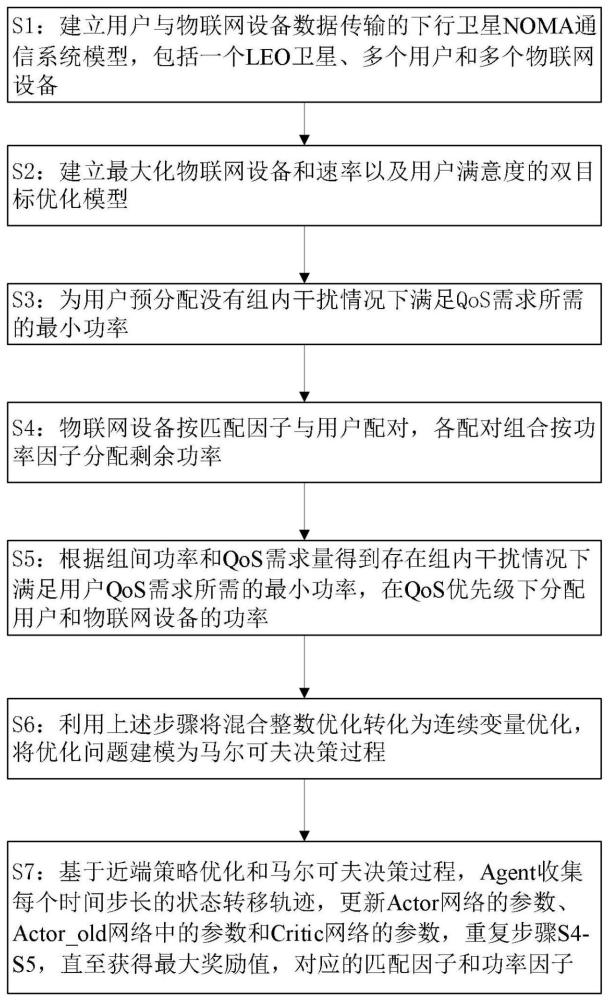

3、一种卫星noma通信系统分组与功率分配联合优化方法,包括如下步骤:

4、s1:建立用户与物联网设备数据传输的下行卫星noma通信系统模型,包括一个leo卫星、多个用户和多个物联网设备;

5、s2:建立最大化物联网设备和速率以及用户满意度的双目标优化模型;

6、s3:基于双目标优化模型为用户预分配没有组内干扰情况下满足qos需求所需的最小功率,得到卫星的剩余发射功率;

7、s4:物联网设备按匹配因子与用户配对,各配对组合按功率因子分配剩余发射功率;

8、s5:根据组间功率和qos需求量,计算存在组内干扰情况下满足用户qos需求所需的最小功率,在qos优先级下分配用户和物联网设备的功率;

9、s6:利用上述步骤将混合整数优化转化为连续变量优化,将优化问题建模为马尔可夫决策过程,并定义马尔可夫决策过程的状态空间、动作空间和奖励;

10、s7:基于近端策略优化算法执行马尔可夫决策过程,并收集每个时间步长的状态转移轨迹,更新近端策略优化算法中网络参数,得到最优匹配因子和功率因子,然后返回s4,直至获得最大奖励值以及对应的匹配因子和功率因子。

11、进一步的,s2包括如下步骤:

12、s21:将第i个用户的信干噪比表示为其中pi和pj分别表示卫星对用户i和物联网设备j的发射功率,σ2为高斯白噪声,gi为第i个用户的信道增益;将第j个物联网设备的速率表示为其中b为带宽,gj为第j个物联网设备的信道增益;

13、s22:将用户的qos满意率表示为其中为满足用户i的qos需求所需的最小信噪比,为序号为i的用户集合;

14、s23:构建最大化物联网设备和速率以及用户满意度的双目标优化模型:

15、

16、

17、

18、

19、

20、式中,目标函数(1)表示最大化物联网设备和速率以及用户满意度,g为noma分组矩阵,pi和pj分别为用户和物联网设备的功率分配矩阵,为物联网设备集合;(2)表示leo卫星发射功率约束,最大发射功率为pmax;(3)和(4)分别对应表示一个noma组中只有一个用户和一个物联网设备;(5)表示确保每个用户或物联网设备只在一个noma组中,gm,n为noma组m的用户n。

21、进一步的,s3包括如下步骤:

22、s31:计算分配给用户的功率之和:

23、

24、式中,piq为满足用户i的qos需求所需的最小发射功率,表示为:

25、

26、式中,qi为用户i的qos需求;

27、s32:若预分配功率超过最大发送功率,则忽略具有最大要求传输功率的用户,直到pmax-pres≥0,其中pres为卫星的剩余发射功率,表示为:

28、

29、式中,κ为忽略的用户集合。

30、进一步的,s4包括以下步骤:

31、s41:定义物联网设备的匹配因子为α,根据匹配因子的值对物联网设备重新排序,基于排序结果将物联网设备与用户配对,确定noma的分组,利用匹配算法,将整数匹配问题转化为连续变量优化问题;

32、s42:各组的功率包括满足用户qos的预分配功率和按功率因子分配的物联网设备功率,将第g组的功率表示为:

33、

34、式中,βg第g组的功率因子。

35、进一步的,s5中第g组内用户i和物联网设备j的功率表示为:

36、

37、

38、式中,为第g组的总功率,qi为用户的qos需求。

39、进一步的,s6中马尔可夫决策过程的状态空间、动作空间和奖励定义如下:

40、状态空间:状态空间包括匹配因子和功率因子的可能解,其维数为2*i;

41、动作空间:动作空间由匹配因子和功率因子的可能变化组成,与状态空间具有相同的维度;

42、奖励:由物联网设备速率决定,定义为:

43、

44、式中,ρ是将奖励限制在一个设定范围内的参数。

45、进一步的,s7中近端策略优化算法中的网络包括actor网络、actor_old网络和critic网络;更新actor网络的参数θ、actor_old网络中的参数θold和critic网络的参数φ,得到最优匹配因子和功率因子,包括以下步骤:

46、s71:每一个时间步t,agent以当前匹配因子和功率因子的值作为状态st,根据策略πθ(a|s)选择一个动作at,按照s4和s5计算分组和功率分配结果,根据式(12)计算奖励值,agent实施动作at并转移到下一个状态,并将状态转移轨迹记录到缓存中;

47、s72:利用actor网络拟合agent的策略πθ(a|s),其中a和s分别表示动作和状态,复制actor网络的参数到actor_old网络用来保持旧策略,agent每收集t个时间步的状态转移轨迹,则进行一轮更新,更新actor网络训练过程的参数:

48、

49、式中,k为更新轮次,第k轮更新的旧策略,为时间步长t处的优势函数,ε为修正范围,t为设定值;

50、s73:利用critic网络估计状态值v(s),训练目标是基于均方误差最小化损失函数,更新critic网络φ的参数:

51、

52、式中,vφ(st)为状态st的状态值,为根据状态转移轨迹数据计算的积累奖励,根据更新后的actor网络的参数θk+1和critic网络的参数φk+1得到新策略;

53、s74:重复s71、s72和s73,直至找到使累积奖励最大的匹配因子和功率因子,得到用户与物联网设备的功率分配结果。

54、本发明的有益效果在于:

55、本发明提高了资源利用效率:以手机用户的qos满意率和物联网设备的总和率最大化为目标,双优化目标,既满足了手机用户的qos需求,又尽可能多的为物联网设备提供服务,提高了资源利用效率。

56、本发明提供了一个联合优化方案:将noma用户分组、组间功率分配和组内功率分配的联合优化,首先通过预分配和引入权因子,将原来的混合整数问题转化为连续变量优化问题。相比于启发式的算法,能够更加接近最优解。

本文地址:https://www.jishuxx.com/zhuanli/20240801/243361.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表