基于多时间粒度特征融合的视频摘要方法及其系统

- 国知局

- 2024-08-02 14:50:15

本发明涉及视频摘要领域,具体涉及一种基于多时间粒度特征融合的视频摘要方法。

背景技术:

1、近年来,随着视频拍摄技术和设备的发展,互联网上的视频量快速增长,根据相关统计显示,2022年,在线视频在互联网总流量中达到82%,电影、纪录片、体育比赛等不同的视频类型层出不穷。尤其是短视频的出现,凭借其时间短、内容简练的特点而广受欢迎。将一个长视频合理地精简为短视频,实现用户对长视频的快速浏览,具有较高的应用需求。视频摘要是一种通过提取视频中的关键信息来自动生成短视频的技术,将视频摘要应用于电影、体育比赛等长视频,可以在保留视频主要脉络的同时极大地压缩视频时长。因此,视频摘要是用于实现视频快速浏览的一大研究热点。

2、视频摘要的关键在于准确地提取出视频中的关键信息,实现这一点首先需要对视频内容的时序关系进行合理地建模。在过去的一些工作中,主要使用了以rnn为核心的深度网络来建模视频时序关系,将视频视为一个帧序列,采用rnn及其变种(lstm和gru等)对各帧之间的前后关联信息进行捕获,并对每一帧的重要性进行评估,实现视频关键信息地提取。但是,rnn网络存在短期记忆的问题,在用rnn在处理长序列时,梯度容易在反向传播的过程中变得非常小,从而出现梯度消失的问题,且进行视频摘要的对象往往是长视频,rnn难以捕获时间上相隔较远的帧之间的时间依赖关系。基于rnn的工作为了避免这一问题,把视频分成多个片段,用rnn对每个片段分别进行处理。该类方法一定程度上缓解了rnn短期记忆的问题,但由于rnn对于每一帧的计算都会依赖于前一帧,这种循环结构使得基于rnn的方法在训练和推理时计算效率低下。不同于rnn,transformer基于self-attention机制,能够对序列中所有位置的信息同时进行交互,有效地捕捉序列中的长距离依赖关系。在视频摘要中,基于transformer的方法可以更好地理解视频中不同帧之间的相关性并考虑整个视频的上下文,生成出比基于rnn的方法更具有代表性的摘要。

3、但是这些基于transformer的方法缺乏对于视频内不同镜头时长差异的考虑。一个视频内通常包含多个时长不等的镜头,全局视角下的时序关系建模会忽略序列内部,尤其是短镜头内的局部关联,导致最终生成的摘要缺少部分重要细节。部分工作基于kts方法,根据不同镜头的边界对视频进行分段,再通过self-attention或结合lstm等方法来提取每个镜头序列中的局部关联。但是,kts通过计算帧间的相似性对视频进行分段,计算代价较高,进而影响整个摘要模型的计算代价。

4、针对上述问题,本发明考虑提取视频在不同时间粒度下的全局和局部时序依赖,使网络更好地适应不同距离之间的时序关系。此外,为了强化视频局部的重要细节,本发明设计了一个局部注意力模块,用于对视频片段的短距离依赖关系进行建模。因此,本发明提出了基于多时间粒度特征融合的视频摘要方法,其由一个全局时序特征提取器和三个多粒度时序特征提取器分支组成。

技术实现思路

1、本发明的目的在于克服现有方法中所存在的上述不足,提出了一种基于多时间粒度特征融合的视频摘要方法,实现视频关键帧的准确提取和视频摘要的生成。

2、为实现上述目的,本发明提供了如下方案:

3、本发明提供一种基于多时间粒度特征融合的视频摘要方法,所述方法为:

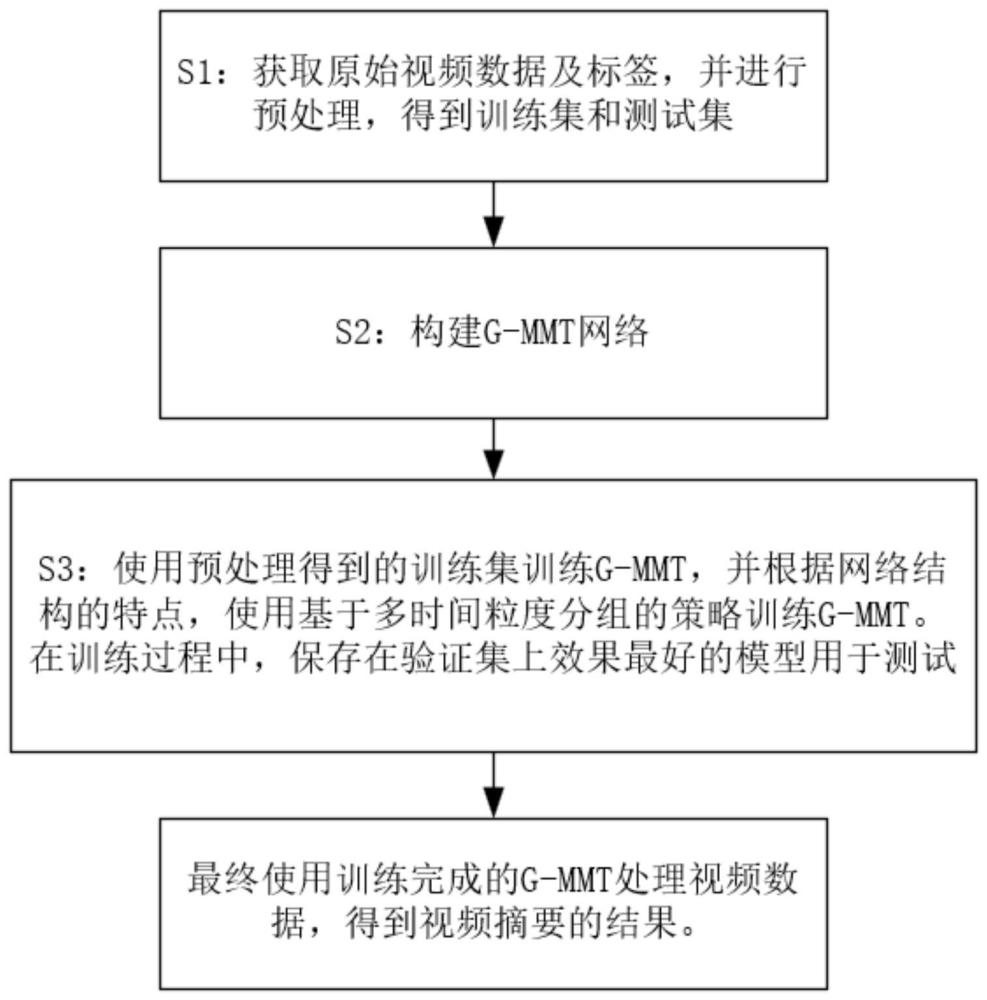

4、s1、获取原始视频数据及标签,并进行预处理,得到训练集和测试集;

5、s2、构建g-mmt网络;

6、s3、使用预处理得到的训练集训练所述g-mmt网络,其中网络结构以transformer为基本结构,并根据网络结构的特点,使用基于多时间粒度分组的策略训练所述g-mmt网络;

7、s4、使用训练完成的g-mmt网络处理视频数据,得到视频摘要的结果。

8、进一步,还有一种优选实施例,上述步骤s1具体为:

9、s11、根据不同用户对于视频给出的帧级重要性标注,将其平均化处理,得到平均后的帧级重要性标注;

10、s12、将视频与平均后的帧级重要性标注对应进行下采样,每隔15帧取1帧画面,并取出对应的重要性标注;

11、s13、将所述重要性标注归一到[0,1]范围内;

12、s14、将所有视频的80%作为训练数据组成训练集,将其余的20%作为测试数据组成测试集。

13、进一步,还有一种优选实施例,上述步骤s2中的g-mmt网络包括一个全局时序特征提取器和三个独立的多粒度时序特征提取器分支。

14、进一步,还有一种优选实施例,上述全局时序特征提取器首先通过预训练好的googlenet网络对训练视频的每一帧进行图像特征提取,获得提取的时序特征;然后采用transformer结构对视频内部的时序特征进行建模;最后在对帧序列进行时序特征建模之前,对所有帧特征加上位置编码,并采用帧序列的多粒度时域分组方案;

15、在上述三个独立的多粒度时序特征提取器分支中,将原本的特征序列按照不同的分组间隔t进行不重叠的分组,将特征序列内每连续的t个元素作为一行,转变为阵列形式,阵列中的每一行是时间粒度为t的局部序列组,对其进一步建模原视频的局部特征,每一列是时间粒度为t的全局序列组,对其进一步建模原视频的全局特征。

16、进一步,还有一种优选实施例,上述多粒度时序特征提取器包括局部注意力模块和辅助全局注意力模块。

17、进一步,还有一种优选实施例,上述骤s3具体为:

18、分别融合多种时间粒度下经过特征更新的特征序列,得到一个新的特征序列后,再用标签进行监督训练;训练过程中通过mse损失函数计算每个分支的输出结果与标记结果的误差,并通过不同权重将各分支损失进行叠加,用于后续训练;同时,通过梯度反向传播方法,采用adam优化算法对网络中的参数进行更新,以获得训练好的g-mmt网络。

19、进一步,还有一种优选实施例,上述骤s4具体为:使用训练得到的g-mmt网络模型预测测试样本的每帧的重要性分数,依据帧级重要性分数结合视频每个片段的时间边界,计算出每个片段的重要性分数;分数较高的片段为该视频的关键片段;选取占视频总帧数不多于15%的片段按时间顺序组合成新的摘要视频。

20、本发明所述的一种基于多时间粒度特征融合的视频摘要方法可以全部采用计算机软件实现,因此,对应的,本发明还提供一种基于多时间粒度特征融合的视频摘要系统,所述系统包括:

21、用于获取原始视频数据及标签,并进行预处理,得到训练集和测试集的存储装置;

22、用于构建g-mmt网络的存储装置;

23、用于使用预处理得到的训练集训练g-mmt网络,其中网络结构以transformer为基本结构,并根据网络结构的特点,使用基于多时间粒度分组的策略训练所述g-mmt网络的存储装置;

24、用于最终使用训练完成的g-mmt网络处理视频数据,得到视频摘要的结果的存储装置。

25、本发明还提供一种计算机可读存储介质,该计算机可读存储介质上存储有计算机程序,该计算机程序被处理器运行时执行上述任意一项所述的一种基于多时间粒度特征融合的视频摘要方法。

26、本发明还提供一种计算机设备,该设备包括存储器和处理器,所述存储器中存储有计算机程序,当所述处理器运行所述存储器存储的计算机程序时,所述处理器执行上述任意一项所述的基于多时间粒度特征融合的视频摘要方法。

27、本发明的有益效果为:

28、1、本发明提供的一种基于多时间粒度特征融合的视频摘要方法,采用以transformer为基本框架的网络结构,针对视频帧间的长距离依赖关系建模,用全局时序特征提取器初步提取全局依赖关系,并进一步提取多种时间粒度下的全局信息,强化时间依赖关系的全局性。

29、2、本发明提供的一种基于多时间粒度特征融合的视频摘要方法,针对关键帧提取提出了g-mmt网络。该网络通过多粒度时序特征提取器对视频片段的短距离依赖关系进行建模,充分提取视频的局部事件以来,增强片段中关键帧的代表性。

30、本发明适用于视频摘要领域。

本文地址:https://www.jishuxx.com/zhuanli/20240801/244015.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表