一种结合数据公平调度和联邦平均的均衡联邦学习方法与流程

- 国知局

- 2024-08-02 12:42:03

本发明涉及联邦学习,尤其是一种结合数据公平调度和联邦平均的均衡联邦学习方法。

背景技术:

1、随着数据安全隐私保障意识的日益增强,而隐私计算技术能够保护个人隐私数据的同时发掘其潜在价值,特别是联邦学习。这种由谷歌首创的分布式机器学习方法,已经成为保障数据隐私的同时发挥其价值的关键技术。联邦学习允许多个客户端(如智能手机或其他边缘设备)在不共享原始数据的前提下,共同训练和完善机器学习模型。这是通过仅在客户端和中心服务器之间交换模型更新,而非数据本身,从而有效地保护了用户的隐私信息,实现了“数据不动,模型动”的要求。这种方法不仅减少了隐私数据被泄露的可能性,而且还促进了跨客户端的协作,提高了模型的整体性能和准确度。因此,联邦学习为合规性数据共享和利用提供了一条可行且前景广阔的道路。

2、联邦学习作为一种创新的隐私保护技术,其核心流程体现了分布式协作的精髓。首先,中心服务器负责初始化一个全局模型,并将其分发给一组随机选定的客户端。这些客户端各自利用自己的本地数据独立训练模型,确保数据的隐私性得到保护。训练完成后,客户端仅将模型的更新参数发送回中心服务器,而不是原始数据。中心服务器接收到所有客户端的更新后,进行聚合处理,优化全局模型。这个过程会循环多次,每次都通过分布式的力量提高模型的整体性能和准确性,直至达到预设的停止条件。这样的设计不仅确保了数据隐私的安全,还通过集体智慧提升了模型的有效性。

3、但在,传统联邦学习中,由于参与者的数据分布和数据量存在显著差异,常规的模型聚合操作可能会无意中偏向某些设备的数据,从而导致数据资源使用的不公平现象。出现该不公平的现象主要是因为参与者之间的数据异构性和数据调度不均。这种情况下,数据质量较高或数据量较大的客户端对模型的贡献被高估,而数据质量较低或数据量较小的客户端则被低估,从而影响了整个模型的公平性和有效性,导致最终模型在不同参与者数据上的准确率有较大差异。此外,客户端的计算能力和通信资源也会影响其参与训练的机会,进一步加剧了不公平现象。

技术实现思路

1、针对现有技术的不足,本发明提供一种结合数据公平调度和联邦平均的均衡联邦学习方法,本发明综合考虑联邦学习系统的性能和数据调度的公平性,引入公平数据调度准则公平挑选客户端,利用公平的聚合因子方法,得以兼顾系统性能和数据调度的公平性,使得在联邦学习的过程中的数据调度更具公平性。

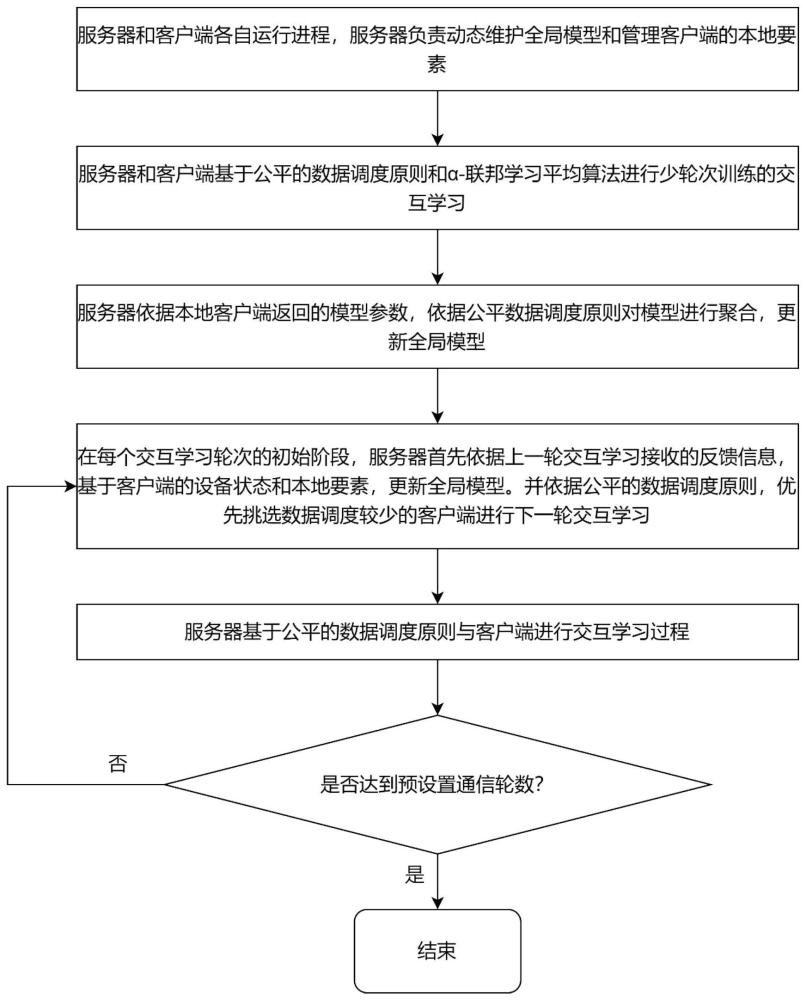

2、本发明的技术方案为:一种结合数据公平调度和联邦平均的均衡联邦学习方法,所述的均衡联邦学习方法的系统包括一个服务器和多个客户端;所述的服务器动态维护全局模型和管理多个客户端;所述的方法包括以下步骤:

3、s1)、所述的服务器和多个客户端各自运行相应的进程;

4、s2)、服务器和客户端基于公平的数据调度原则和α-联邦学习平均算法进行少轮次训练的交互学习;

5、s3)、服务器依据本地客户端返回的模型参数,依据公平的数据调度原则对模型进行聚合,更新全局模型;

6、s4)、在每个交互学习轮次的初始阶段,服务器首先依据上一轮交互学习接收的反馈信息,基于客户端的设备状态和本地要素,更新全局模型;并依据公平的数据调度原则,优先挑选数据调度较少的客户端进行下一轮交互学习;

7、s5)、服务器基于公平的数据调度原则与挑选的客户端进行交互学习。

8、作为优选的,步骤s1)中,所述的服务器运行的进程为状态跟踪进程,通过所述的状态跟踪进程记录客户端的进程活动信息。

9、作为优选的,步骤s1)中,所述的客户端运行的进程为状态上报进程,所述的状态上报进程用于向服务器传递本地特征和自身设备相关信息。

10、作为优选的,步骤s1)中,所述的本地特征包括但不限于本地客户端模型的参数、本地测试的准确率、参与轮次、数据集大小和测试时间;所述的自身设备相关信息包括但不限于计算资源、电量状态、网络带宽、设备类型、操作系统、软件版本和位置信息。

11、作为优选的,步骤s2)中,所述的服务器和客户端基于公平的数据调度原则和α-联邦学习平均算法进行少轮次训练的交互学习,具体包括以下步骤:

12、s21)、所述的服务器设定联邦学习相关的超参数,所述的超参数包括迭代沟通的次数τ、本地模型的学习率η、本地模型的优化器、本地客户端的训练轮次n、本地客户端学习率衰减系数β、本地客户端训练的批次大小β、α-联邦平均算法的公平因子α和客户端损失影响程度因子μ;

13、s22)、所述的服务器和本地客户端基于公平的数据调度原则和α-fedavg算法执行n个轮次的交互学习。

14、作为优选的,步骤s22)中,所述的α-fedavg算法中的一个迭代学习轮次包括如下步骤:

15、s221)、所述的服务器先设定全局模型ωe的初始参数,其中,e表示所述的服务器与客户端进行通信的轮次;然后再将预测参数的模型广播给系统内所有的客户端;

16、s222)、各个客户端接收到服务器发来的全局模型ωe,每个客户端基于本地持有的数据以及选用的机器学习算法和预设的超参数,进行模型更新,从而得到每个客户端i的本地模型

17、s223)、k个参与交互学习的客户端将更新后的本地模型发回给服务器;

18、s224)、服务器将各参与训练的本地客户端同时考虑公平的数据调度原则和α-fairness公平度量,进行更公平的权重分配,从而得到各个本地客户端对系统的全局模型的聚合因子pi:

19、

20、式中,k为联邦学习的客户端总数;ai表示第i个本地客户端在本地数据上的模型准确率;clossi表示第i个本地客户端的损失值;

21、s225)、所述的服务器根据聚合因子pi聚合得到第e+1轮次的全局模型聚合公式为:

22、

23、式中,第i个本地客户端第e轮次聚合因子,表示第i个本地客户端第e轮次更新的模型;表示参与第e+1轮次交互学习的客户端集合的全局模型;

24、作为优选的,步骤s224)中,所述的公平的数据调度原则包括:

25、s2241)、优先挑选在交互学习中等待服务器较久的、训练时间较短的本地客户端;

26、s2242)、同时考虑本地客户端的损失值与准确率,使参与在联邦学习中因为本地数据量较少,导致服务器分配资源较少的客户端能够在此过程中得到更公平的资源分配。

27、作为优选的,步骤s224)中,所述的公平的数据调度原则为优先挑选等待训练时间长和训练轮次少的客户端,并通过公平的权重计算公式得到聚合因子pi,其中,第i个本地客户端的损失值clossi由twait、ttrain和客户端损失影响程度因子μ所决定,所述的损失值clossi表示为:

28、

29、客户端等待时间越长,twait越大;客户端训练轮次越少,ttrain越小;利用此客户端的损失值,系统能够更公平的将资源分配到更多本地数据量较少,训练准确率较低的客户端,从而使得这些客户端的准确率能够得到提升。

30、作为优选的,步骤s224)中,所述的α-fairness公平度量通过改变预设定的公平因子α的取值来达到系统公平和系统效率之间的权衡,其公式表示如下:

31、

32、式中,uα(x)表示单个客户端的效用,随着公平因子α的值升高,代表资源的分配越公平;

33、通过使用scorei=u(ai)pi表示聚合后参与训练的本地客户端i获得的实际效用值,则本次训练过程中系统的有效性e可以量化为:

34、

35、式中,scorei客户端i的实际效用,通过调节公平因子α的值,来实现系统实际效用的最优值,最大化了公平性的同时兼顾了系统的性能。

36、作为优选的,步骤s3)中,所述的服务器依据公平的数据调度原则对模型进行聚合,更新全局模型,具体包括如下步骤:

37、s31)、服务器的进程接收依据公平的数据调度原则挑选出的本地客户端模型参数和本地准确率;

38、s32)、服务器依据公平的数据调度原则和α-fairness公平度量,计算出每个本地客户端模型的聚合因子;

39、s33)、服务器依据α-联邦平均算法的公平聚合规则将参与训练的各个客户端的模型系数加权聚合,以更新全局模型。

40、作为优选的,步骤s4)具体包括如下步骤:

41、s41)、在每个交互学习轮次的初始阶段,服务器首先依据上一轮交互学习接收的反馈信息,基于客户端的设备状态和本地要素,对全局模型进行更新;

42、s42)、服务器依据公平的数据调度原则,优先选择数据调度较少的客户端,以进行新一轮的交互式学习;

43、s43)、服务器在通信初始阶段,收集各个客户端的设备状态和本地要素并进行分析,依据计算得出的权重因子,以更公平的聚合方式对各本地客户端模型进行聚合,以此更新整个系统的全局模型;

44、s44)、服务器在通信的初始阶段,根据一系列条件筛选可用的客户端,以便对其本地模型进行更新操作;

45、s45)、服务器依据公平的数据调度原则,选取数据调度较少的本地客户端进行交互学习;在这个过程中,那些之前参与训练时间较短或参与轮次较少的客户端将被视为数据调度较少的对象;所述的服务器将优先选择这些等待时间较长的客户端进行下一轮的交互式学习,以确保训练资源得到公平的分配。

46、作为优选的,步骤s44)中,筛选的可用的客户端满足以下条件:属主非使用状态、网络连接正常且电量足够满足训练要求、非任务执行中状态。

47、作为优选的,步骤s5)中,具体包括以下步骤:

48、s51)、服务器依据公平的数据调度原则,选择一组本轮次参与交互学习的本地客户端集合ge,并向它们发送了本轮通信的初始化模型ωe;

49、s52)、参与本轮次交互学习的客户端集合ge中各客户端ci使用服务器广播的模型参数ωe初始化本轮的本地模型再依据各客户端ci的本地数据di使用随机梯度下降算法进行模型参数的更新,得到

50、s53)、参与本轮次训练的客户端ci将训练完的模型参数和准确率ai发回给服务器;

51、s54)、服务器基于公平的数据调度原则和α-fairness计算各客户端的聚合因子系数;

52、s55)、服务器检查当前通信轮次r是否满足预定的通信轮次r的条件,若r<r,则流程返回到步骤s4)并执行s5);如果r≥r,那么联邦学习的过程结束。

53、本发明的有益效果为:

54、1、本发明通过在联邦学习中加入公平的客户端挑选机制,有效的控制客户端的损失,使用等待交互学习时间和训练时长指标来衡量数据调度的公平性,使得在联邦学习的过程中的数据调度更具公平性;

55、2、本发明在联邦平均算法中进一步考虑了聚合公平性,利用公平度量因子衡量每个客户端的贡献度,在兼顾系统效率的前提下,进一步提升联邦学习系统的公平性;

56、3、本发明在联邦学习中综合考虑系统性能和公平性,能够更好地权衡数据调度和模型的性能要求。

本文地址:https://www.jishuxx.com/zhuanli/20240802/237395.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表