一种驾驶员行为策略的生成方法、装置、设备和可读存储介质与流程

- 国知局

- 2024-09-14 14:32:53

本技术涉及自动驾驶仿真交通流生成,具体涉及一种驾驶员行为策略的生成方法、装置、设备和可读存储介质。

背景技术:

1、近几年,自动驾驶技术发展迅速,但自动驾驶系统大规模落地应用之前必须经过大量安全测试。通常一套自动驾驶系统达到量产必须通过110亿英里的测试,然而,仿真测试可以解决在真实道路测试周期长、成本高、效率低的问题,但如果仿真场景交通流缺乏真实性,那么测试效果将大打折扣。因此对交通流驾驶行为建模,生成真实自然的仿真交通流是至关重要的。

2、当前交通流仿真建模方法非常多样,例如轨迹回放方法,行为克隆方法,生成对抗模仿学习方法等。通常,轨迹回放方法需要收集丰富的自然场景数据,除此之外轨迹回放方法生成的自然交通流中的背景车辆与被测主车无交互,极大影响测试效果与效率;行为克隆方法本质是监督学习,需要通过大量数据去训练,通常行为克隆智能体的输出缺乏多样性,尤其当遇到没有见过的场景时,智能体决策非常糟糕,并且存在错误累计的缺陷;生成对抗模仿学习需要同时训练生成器与判别器以达纳什均衡,该算法需要让智能体与环境交互但是无法从环境中获得奖励,存在模式崩塌、环境交互样本利用效率低的问题,以至于智能体的决策缺乏真实性。

技术实现思路

1、本技术提供一种驾驶员行为策略的生成方法、装置、设备和可读存储介质,该方法可以提升驾驶员行为策略模型泛化能力,提高生成的驾驶员行为策略的多样性、交互性和真实性。

2、本技术的技术方案是这样实现的:

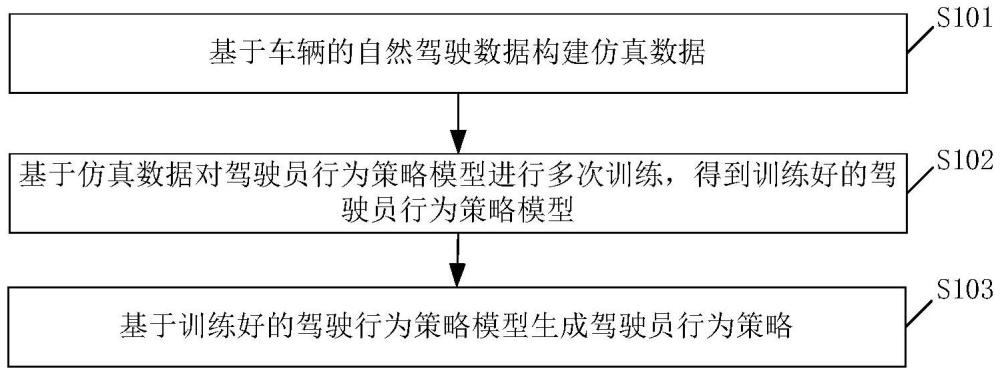

3、本技术实施例提供一种驾驶员行为策略的生成方法,包括:基于车辆的自然驾驶数据构建仿真数据;基于所述仿真数据对初始驾驶员行为策略模型进行多次训练,得到训练好的驾驶员行为策略模型;其中,驾驶员行为策略模型包括基于条件扩散模型构建的条件扩散策略网络和价值网络,所述条件扩散策略网络用于生成表征驾驶员行为的动作数据;基于所述训练好的驾驶行为策略模型生成驾驶员行为策略。

4、根据上述技术手段,驾驶员行为策略模型包括的基于条件扩散模型构建的条件扩散策略网络,可以捕捉仿真数据的多模态分布和细节,从而提高驾驶员行为策略模型生成的驾驶员行为策略的多样性,进一步地,基于根据自然驾驶数据构建的仿真数据,对驾驶员行为策略模型进行多次训练,可以在保证驾驶员行为策略模型生成接近真实驾驶行为的驾驶员行为策略的同时,探索更多的驾驶行为,从而提升驾驶员行为策略模型的泛化能力,提高生成的驾驶员行为策略的多样性和真实性。

5、在一些实施例中,所述仿真数据包括离线仿真数据和在线仿真数据;所述基于所述仿真数据对初始驾驶员行为策略模型进行多次训练,得到训练好的驾驶员行为策略模型,包括:基于所述离线仿真数据对所述初始驾驶员行为策略模型进行预训练,得到第一驾驶员行为策略模型;基于所述离线仿真数据和所述在线仿真数据对所述第一驾驶员行为策略模型进行训练,得到训练好的驾驶员行为策略模型。

6、根据上述技术手段,基于离线仿真数据对初始驾驶员行为策略模型进行预训练,使得策略网络输出的动作尽可能接近人类的驾驶动作,从而提升训练效率、保证生成交通流的自然性,进一步地,基于离线仿真数据和在线仿真数据对经过预训练得到的第一驾驶行为策略模型再次进行训练,可以在探索更多的驾驶行为的情况下生成接近真实驾驶行为的驾驶员行为策略,从而达到提高驾驶行为策略模型的泛化能力和获得的交通流的真实性的目的。

7、在一些实施例中,所述离线仿真数据中包括离线状态数据和奖励值标签,所述初始驾驶员行为策略模型包括初始条件扩散策略网络和初始价值网络;所述基于所述离线仿真数据对初始驾驶员行为策略模型进行预训练,包括:将所述离线状态数据输入至所述初始条件扩散策略网络,得到多个第一动作数据;基于所述初始价值网络确定所述多个第一动作数据各自对应的动作价值,以及多个动作价值中值最大的第一动作价值;基于所述第一动作价值和相应的奖励值标签,对所述初始价值网络和所述初始条件扩散策略网络进行训练,直至满足第一收敛条件,得到第一价值网络和第一条件扩散策略网络。

8、根据上述技术手段,通过将离线状态数据出入至初始条件扩散策略网络,得到多个第一动作数据,并根据初始价值网络确定各个第一动作数据对应的动作价值,以及多个动作价值中值最大的第一动作价值,并基于第一动作价值和奖励值标签对初始价值网络和初始条件扩散策略网络进行训练,可以提高初始价值网络和初始条件扩散策略网络的训练效率。

9、在一些实施例中,所述初始驾驶员行为策略模型包括初始目标网络;所述驾驶员行为策略的生成方法还包括:基于所述初始价值网络的网络参数更新所述初始目标网络的网络参数,得到第一目标网络。

10、根据上述技术手段,通过初始价值网络的网络参数更新初始目标价值网络的网络参数,可以得到训练后的第一目标网络,以便于后续的训练过程中,根据第一目标网络控制第一价值网络的学习过程,使得第一价值网络可以输出更加稳定的预测结果(动作价值最大的动作数据)。

11、在一些实施例中,所述第一驾驶员行为策略模型包括第一条件扩散策略网络和第一价值网络;

12、所述基于所述离线仿真数据和所述在线仿真数据对所述第一驾驶员行为策略模型进行训练,得到训练好的驾驶员行为策略模型,包括:从所述离线仿真数据中采样出预设比例的第一离线仿真数据,并从所述在线仿真数据中采样出数量和所述第一离线仿真数据相同的第一在线仿真数据;固定所述第一条件扩散策略网络的网络参数,利用所述第一离线仿真数据和所述第一在线仿真数据对所述第一价值网络进行训练,直至所述第一离线仿真数据和所述第一在线仿真数据循环完成,得到经过训练的第一价值网络。

13、根据上述技术手段,通过固定第一条件扩散策略网络的网络参数,可以利用第一离线仿真数据和第一在线仿真数据对第一价值网络的网络参数进行调整,完成对第一价值网络的训练,使得经过训练的第一价值网络后续可以提供可靠的动作价值估计。

14、在一些实施例中,所述驾驶员行为策略的生成方法还包括:获取从所述离线仿真数据中采样得到的第二离线仿真数据,以及从所述在线仿真数据中采样得到的第二在线仿真数据;其中,所述第二离线仿真数据和所述第一离线仿真数据不同,且所述第二离线仿真数据的数量少于所述第二在线仿真数据的数量;固定所述经过训练的第一价值网络的网络参数,基于第二离线仿真数据和第二线仿真数据对所述第一条件扩散策略网络进行训练,直至满足第二收敛条件,得到经过训练的第一条件扩散策略网络。

15、根据上述技术手段,由于第二离线仿真数据的数量小于第二在线仿真数据的数量,因此通过固定经过训练的第一价值网络的网络参数,利用第二离线仿真数据和第二在线仿真数据对第一条件扩散策略网络进行训练,可以保证经过训练的第一条件扩散策略网络输出的动作数据的自然性。

16、在一些实施例中,所述第二离线仿真数据和所述第二在线仿真数据中包括参考状态数据;所述基于第二离线仿真数据和第二线仿真数据对所述第一条件扩散策略网络进行训练,包括:将所述参考状态数据输入至所述第一条件扩散策略网络,得到多个第二动作数据;基于所述多个第二动作数据,对所述第一条件扩散策略网络进行训练。

17、根据上述技术手段,通过第一条件扩散策略网络进行训练对参考状态数据进行学习,得到多个第二动作数据,并基于多个第二动作数据对第一条件扩散网络进行训练,可以使得第一条件扩散策略网络不断更新自身的网络参数,提升决策能力。

18、在一些实施例中,所述基于所述多个第二动作数据,对所述第一条件扩散策略网络进行训练,包括:基于所述经过训练的第一价值网络确定所述多个第二动作数据各自对应的动作价值,以及多个动作价值中数值最大的第二动作价值;将所述第二动作价值对应的第二动作数据与仿真环境进行交互,获得下一状态数据;基于所述下一状态数据和预设奖励函数,对所述第一条件扩散策略网络的网络参数进行反向传播训练。

19、根据上述技术手段,通过经过训练的第一价值网络输出的价值最大的第二动作数据,并根据该第二动作数据与仿真环境的交互结果获得的下一状态数据和预设奖励函数,对第一条件扩散策略网络的网络参数进行调优训练,可以提高第一条件扩散策略网络的训练效率和准确性。

20、在一些实施例中,所述基于所述多个第二动作数据,对所述第一条件扩散策略网络进行训练,包括:向所述多个第二动作数据中的至少一个第二动作数据中添加噪声数据,得到更新后的第二动作数据;基于所述更新后的第二动作数据对所述第一条件扩散策略网络进行训练。

21、根据上述技术手段,通过向第二动作数据中添加噪声数据,可以提高第二动作数据的丰富性,从而增加第一条件扩散策略网络的探索性,基于添加噪声后得到的更新后的第二动作数据对第一条件扩散策略网络进行训练,可以提升第一条件扩散策略网络的泛化能力和鲁棒性。

22、在一些实施例中,所述第一驾驶员行为策略模型还包括第一目标网络,所述驾驶员行为策略的生成方法还包括:在对所述第一条件扩散策略网络训练之前,基于所述第一价值网络的网络参数更新所述第一目标网络的网络参数,或者,在对所述第一条件扩散策略网络训练之后,基于所述经过训练的第一价值网络的网络参数更新所述第一目标网络的网络参数。

23、根据上述技术手段,可以实现根据第一价值网络的网络参数或经过训练的第一价值网络的网络参数对第一目标网络的网络参数的更新,得到训练好的第一价值网络,便于后续在基于经过训练的驾驶员行为策略模型生成驾驶员行为策略时,可以获得更加稳定和准确的驾驶员行为策略。

24、在一些实施例中,所述基于所述离线仿真数据和所述在线仿真数据对所述第一驾驶员行为策略模型进行训练,得到训练好的驾驶员行为策略模型,包括:确定观测场景中的目标车辆和背景车辆,以及所述目标车辆对应的第一仿真数据和所述背景车辆对应的第二仿真数据;所述第一仿真数据和所述第二仿真数据均至少包括相应的在线仿真数据;在仿真环境中,基于所述第一仿真数据和所述第二仿真数据,对所述目标车辆对应的第一驾驶员行为策略模型和所述背景车辆对应的第一驾驶员行为策略模型进行交互训练,直至满足第三收敛条件,得到所述目标车辆对应的训练好的驾驶行为策略模型。

25、根据上述技术手段,目标车辆对应的第一驾驶员行为策略模型和所述背景车辆对应的第一驾驶员行为策略模型进行交互训练,可以基于第一仿真数据和第二仿真数据在仿真环境中交互训练,保证目标车辆和背景车辆的可交互性,可以使得训练得到的目标车辆对应的第一驾驶员行为策略模型可以生成更加真实、更加自然的驾驶员行为策略。

26、在一些实施例中,所述基于所述第一仿真数据和所述第二仿真数据,对所述目标车辆对应的第一驾驶员行为策略模型和所述背景车辆对应的第一驾驶员行为策略模型进行交互训练,包括:将所述第一仿真数据输入所述目标车辆对应的第一驾驶员行为策略模型,得到所述目标车辆的驾驶员行为策略,并将所述第二仿真数据输入所述背景车辆对应的第一驾驶员行为策略模型,得到所述背景车辆的驾驶员行为策略;基于所述目标车辆的驾驶员行为策略和所述背景车辆的驾驶员行为策略,确定所述目标车辆对应的下一状态数据和所述背景车辆对应的下一状态数据;利用所述目标车辆对应的下一状态数据和所述背景车辆对应的下一状态数据,对所述目标车辆对应的第一驾驶员行为策略模型进行训练。

27、根据上述技术手段,可以根据目标车辆和背景车辆交互的状态,确定目标车辆对应的第一驾驶员行为策略模型生成的驾驶员行为策略模型是否合理,从而通过不断对目标车辆对应的第一驾驶员行为策略模型进行训练,使得第一驾驶员行为策略模型生成更加准确、更加自然的驾驶员行为策略。

28、在一些实施例中,所述基于车辆的自然驾驶数据构建仿真数据,包括:获取观测场景中车辆的所述自然驾驶数据;所述自然驾驶数据包括所述车辆的历史驾驶数据;在仿真环境中,基于所述观测场景和所述历史驾驶数据对交通流逐帧进行模拟,得到多个交通流图像帧;基于交通流图像帧中车辆的环境数据和预设奖励函数,确定环境奖励值;基于所述交通流图像帧中车辆的环境数据、下一交通流图像帧中车辆的环境数据、驾驶员行为策略和所述环境奖励值,构建所述离线仿真数据。

29、根据上述技术手段,基于观测场景和车辆的历史驾驶数据,以及预设奖励函数,可以构建出包含当前状态数据、动作数据、环境奖励值和下一状态数据的离线仿真数据,多个离线仿真数据便构成了离线训练数据集,便于用户利用该离线训练数据集对初始驾驶员行为策略模型进行训练。

30、本技术实施例提供一种驾驶员行为策略的生成装置,包括:

31、第一创建模块,用于基于车辆的自然驾驶数据构建仿真数据;

32、第一训练模块,用于基于所述仿真数据对初始驾驶员行为策略模型进行多次训练,得到训练好的驾驶员行为策略模型;其中,驾驶员行为策略模型包括基于条件扩散模型构建的条件扩散策略网络和价值网络,所述条件扩散策略网络用于生成表征驾驶员行为的动作数据;

33、第一生成模块,用于基于所述训练好的目标驾驶行为策略模型生成驾驶员行为策略。

34、本技术实施例提供一种驾驶员行为策略的生成设备,包括:

35、存储器,用于存储驾驶员行为策略的生成指令;

36、处理器,用于执行所述存储器中存储的可执行驾驶员行为策略的生成指令时,实现本技术实施例中提供的方法。

37、本技术实施例提供一种计算机可读存储介质,计算机存储介质中存储有计算机可执行指令,计算机可执行指令配置为执行上述驾驶员行为策略的生成方法。

本文地址:https://www.jishuxx.com/zhuanli/20240914/294685.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表