基于时空注意力机制和高斯过程的个性化视线追踪方法

- 国知局

- 2024-10-09 16:18:44

本发明属于视线追踪,涉及一种基于时空注意力机制和高斯过程的个性化视线追踪方法。

背景技术:

1、凝视方向是用于分析人类行为和注意力的有效提示信息。近年来,对从面部视频中确定凝视方向引起了许多专注于图像处理领域研究人员的兴趣。然而,视频凝视估计面临着巨大的挑战,如理解视频序列中凝视的动态演变、动静态背景的处理以及适应随机光照带来的影响。

2、人类的凝视是传达人们意图的重要线索,这使得它在人机交互、ar/vr和显著性检测等现实应用中很有前景。此外,凝视在许多计算机视觉任务中起着至关重要的作用,包括但不限于物体检测、视觉注意和动作识别。由于主要的研究重点是从图像中进行凝视估计,因此了解眼球运动基于时间上的动态特征对视频凝视估计的潜在有效性相对地被忽视了。构建一个准确的基于视频的凝视估计模型需要解决视频固有的独特挑战。其中包括整个视频中眼球运动的演变,连续帧中凝视方向之间的相关性,静态背景所占像素比例远高于有效像素占比的可能性,以及由于个体特定特征而产生的变化。意识到空间和运动线索在视频领域的潜力,先前的研究已经将剩余帧和光流用于其他视觉任务并取得良好效果。具体来说,这些方法集成rgb图像和残余帧等不同的输入流,需要更大的模型,具有更长的推理时间和内存要求。类似地,3d卷积神经网络也可以从视频中捕获时空信息,但它们需要许多模型参数。此外,将知识从预训练的3d cnn转移到新的视频任务中也很重要,因为大多数预训练模型依赖于大型2d图像数据集,如imagenet数据集。由于在视频中检测空间和运动线索至关重要,因此迫切需要为视频相关任务设计有效的基于注意力的方法,包括视频凝视估计。

技术实现思路

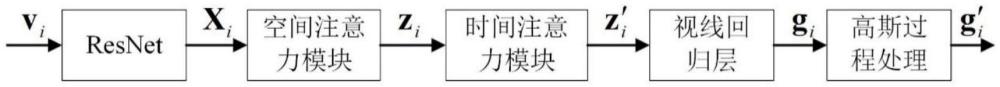

1、有鉴于此,本发明的目的在于从模型算法角度出发,为解决有效地从视频中提取与凝视相关的细节,并促进沿着时间轴的凝视预测难题提供一种基于时空注意力机制和高斯过程的个性化视线追踪方法。通过使用混合空间注意力模型和时序神经网络模型的组合代替传统3d卷积神经网络提取视频中凝视特征,使用多层感知器模块从视频帧嵌入向量预测视线方向。最后提出一种高效样本法,利用预训练的高斯过程处理以得到凝视预测的偏差校正模型以个性化时空注意力模型。

2、为达到上述目的,本发明提供如下技术方案:

3、一种基于时空注意力机制和高斯过程的个性化视线追踪方法,该方法包括以下步骤:

4、s1、采用基于深度残差网络的卷积神经网络模型接收输入视频并提取所有帧的特征映射;

5、s2、通过基于双重和交叉结构的混合空间注意力模型来处理特征映射,得到连续帧之间的空间运动信息;

6、s3、空间运动信息通过时间注意力模型学习使用过去帧嵌入的时间动态,得到具有时间维度动态信息的特征;

7、s4、通过视线回归层将时间注意力模型输出的具有时间维度动态信息的特征映射到预测视线方向序列中;

8、s5、通过基于高斯过程的个性化时空注意力模型得到的后验均值函数预测凝视角残差值,并将其用于校正预测视线方向序列后输出最终预测视线方向向量。

9、进一步,在步骤s1中,通过resnet模型将视频序列v转换为特征其中w、h、k分别为resnet提取的特征图的宽度、高度和通道数;resnet网络模型将视频帧首先通过一个cnn卷积神经网络,再通过最大池化层,然后通过多个残差块,再经过平均池化层,最后通过全连接层得到视频帧的特征映射。

10、进一步,在步骤s2中,通过共享的空间注意力模型传递每个连续的特征对(xt-1,xt);空间注意力模型通过融合策略聚合了xt-1和xt的rgb特征信息,以及(xt-xt-1)的特征差异以生成具有空间信息的特征zt;空间注意力模型至少包括双重-空间注意力模型、交叉-空间注意力模型以及混合-空间注意力模型。

11、双重-空间注意力模型预测当前xt和过去xt-1帧的各自的空间注意特征图以比较当前帧和过去帧,并识别运动变化最相关的区域;若两者的空间注意图相似,则推断连续帧之间无实质性变化,仅存在微小差异,进而在输出向量中编码微差异;如果两者的空间注意图存在差异,则将此变化合并到输出向量zt中。

12、交叉-空间注意力模型通过transformer模型中的交叉注意力模型来处理过去帧和当前帧中每对分块图像之间的密集相关性;交叉-空间注意力模型能够识别两个视频帧之间的多个变化,并过滤不相关的干扰。

13、混合-空间注意力模型通过位置嵌入使用全局上下文交叉注意机制来处理多个变化特征;混合-空间注意力模型使用当前帧和过去帧之间的差异作为键和值,强调运动差异最显著的区域,双重-空间注意力模型被用作池化处理器,选择性地关注最相关的变化特征。

14、进一步,在步骤s3中,时间注意力模型接收由空间注意力模型产生的空间增强特征zt,根据zt捕捉视频中眼球运动的时间维度上的动态特征;时间注意力模型结合时序位置嵌入层以确保transformer模型识别输入特征序列之间的时序关系,嵌入层特征为模型提供关于序列中元素的相对顺序的显式信息,嵌入特征通过多个层传递,每个层由掩码多头注意、层归一化和多层感知机三种模块组成,zt经过transformer模型以生成具有时间维度动态信息的特征z′t。

15、进一步,在步骤s4中,视线回归层由多层感知机mlp组成且所有时间戳共享,其作用在于利用时间序列模块生成的特征z′t预测视线方向gi。模型训练的损失函数为:

16、

17、其中,b表示不同个体的样本总量,n表示一个样本中的视频帧长度,表示真实视线向量的转置,和分别表示真实视线向量和预测视线向量。

18、进一步,在步骤s4中,针对个性化的高斯过程处理,用于为每个不同用户建模偏差校正项,该过程作用于空间注意力模型和时间注意力模型,包括:

19、设f:v→g代表空间注意力模型和时间注意力模型的作用过程,则新用户p的最终预测为:

20、

21、其中rp为对p的基于高斯过程的偏差校正模型,其用于预测残差值;

22、高斯过程rp使用两个一维独立的高斯过程在帧水平上独立建模凝视方向的组成部分,凝视方向包括偏航和俯仰,则有:

23、rp(v)=[(rp,θ(v1),rp,φ(v1)),(rp,θ(v2),rp,φ(v2)),…,(rp,θ(vn),(rp,φ(vn)]

24、其中rp,θ和rp,φ分别是俯仰和偏航分量的一维高斯预测;

25、对于高斯过程的超参数调优和推理,收集利用一组p的训练帧其中为空间注意力模型和时间注意力模型平展处理后的resnet输出特征,yi为俯仰角或偏航角的残差值,其中gi和分别代表了凝视真值和模型预测值;以矩阵的形式表示数据集设为预测结果的残差向量,其中第i行为resnet特征hi,l表示视频帧长度,d表示resnet输出特征维度;与核函数k(h,h′):相关的高斯过程为一个函数上的分布,对于任意将特征映射到残差角向量:

26、

27、其中是数据点h上的核(协方差)矩阵,r有一个常数均值函数,其值设为μ0;

28、残差向量yi被建模为服从分布的高斯噪声,k(h,h′)=τ被用于计算自动相关性确定核:

29、

30、其中τ和为核超参数;

31、在收集到的训练数据集上对高斯模型进行调理后,预测后验均值和协方差函数如下:

32、

33、其中向量存在第i个核值k(h,hi),即任意特征向量h,hi与数据点i之间的核值;后验均值函数预测凝视角残差值并用于校正。

34、本发明的有益效果在于:

35、本发明通过使用混合空间注意力模型和时序神经网络模型的组合代替传统3d卷积神经网络提取视频中凝视特征,使用多层感知器模块从视频帧嵌入向量预测视线方向,最后利用预训练的高斯过程处理以得到凝视预测的偏差校正模型以个性化时空注意力模型,本发明能够有效地从视频中提取与凝视相关的细节,推动解决沿着时间轴的凝视预测难题。

36、本发明的其他优点、目标和特征在某种程度上将在随后的说明书中进行阐述,并且在某种程度上,基于对下文的考察研究对本领域技术人员而言将是显而易见的,或者可以从本发明的实践中得到教导。本发明的目标和其他优点可以通过下面的说明书来实现和获得。

本文地址:https://www.jishuxx.com/zhuanli/20240929/312635.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。