使用自回归生成神经网络来生成音频的制作方法

- 国知局

- 2024-11-06 14:23:42

本技术涉及使用自回归生成神经网络来生成音频。

背景技术:

1、神经网络是采用一层或多层非线性单元来预测所接收的输入的输出的机器学习模型。除了输出层之外,一些神经网络还包括一个或多个隐藏层。每个隐藏层的输出用作网络中的下一层(即,下一隐藏层或输出层)的输入。网络的每一层根据相应的参数的集合的当前值输入从所接收的输入生成输出。

技术实现思路

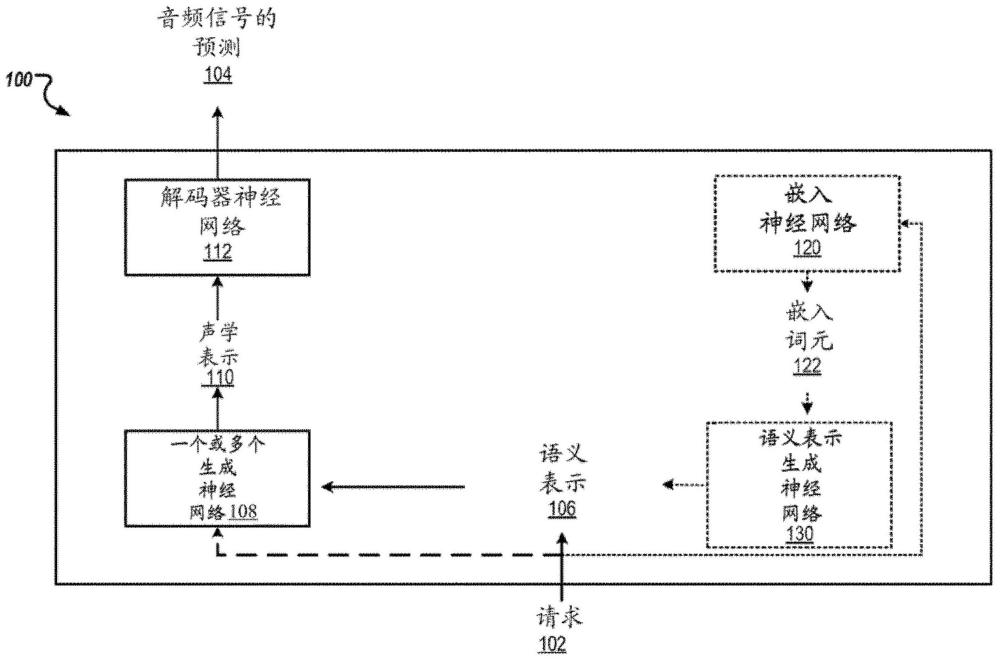

1、本说明书描述了一种在一个或多个位置中的一个或多个计算机上实现为计算机程序的系统,所述系统使用一个或多个生成神经网络来生成音频信号。

2、一般来讲,所述输出音频信号是输出音频示例,其包括在跨越指定时间窗口的一系列输出时间步长中的每个输出时间步长处的音频波的样本。例如,所述输出时间步长可在所述指定时间窗口内以规则间隔排列。

3、给定输出时间步长处的音频样本可以是所述音频波的幅度值或已压缩、压扩(compand)或进行两者的幅度值。例如,所述音频样本可以是原始幅度值或所述幅度值的mu律(mu-law)压扩表示。

4、根据第一方面,提供了一种用于生成音频信号的预测的计算机实现的方法,所述方法包括:接收生成音频信号的请求,所述音频信号具有在跨越时间窗口的多个输出时间步长中的每个输出时间步长处的相应音频样本;获得所述音频信号的语义表示,所述语义表示指定在跨越所述时间窗口的多个第一时间步长中的每个第一时间步长处的相应语义词元,每个语义词元是从语义词元词表中选择的并且表示所述音频信号在对应第一时间步长处的语义内容;使用一个或多个生成神经网络以至少所述语义表示为条件来生成所述音频信号的声学表示,所述声学表示指定在跨越所述时间窗口的多个第二时间步长中的每个第二时间步长处的一个或多个相应声学词元的集合,每个第二时间步长处的所述一个或多个相应声学词元表示所述音频信号在对应的第二时间步长处的声学特性;以及使用解码器神经网络来处理至少所述声学表示以生成所述音频信号的所述预测。

5、在一些实现方式中,所述解码器神经网络是神经音频编解码器的解码器神经网络,所述解码器神经网络已基于目标与编码器神经网络进行联合训练,所述目标度量由所述解码器神经网络从声学表示生成的预测音频信号的重建质量,所述声学表示是使用由所述编码器神经网络生成的输出生成的。

6、在一些实现方式中,所述声学表示是从编码器神经网络通过处理所述音频信号的输出会生成的真实值声学表示的预测。

7、在一些实现方式中,所述编码器神经网络在所述多个第二时间步长中的每个第二时间步长处输出相应嵌入,并且其中所述真实值声学表示是通过对所述相应嵌入中的每个嵌入应用量化来生成的。

8、在一些实现方式中,所述量化是残差向量量化,所述残差向量量化使用多个向量量化器的层次结构来对每个嵌入进行编码,所述多个向量量化器各自从所述向量量化器的对应声学词元词表生成相应声学词元,其中所述层次结构包括位于所述层次结构中的前一个或多个位置处的一个或多个粗向量量化器和位于所述层次结构中的后一个或多个位置处的一个或多个细向量量化器,并且每个第二时间步长处的所述一个或多个相应声学词元的集合针对每个向量量化器包括相应声学词元,所述相应声学词元是从所述向量量化器的所述词表中选择的并且是由所述向量量化器从真实值嵌入会生成的真实值声学词元的预测,所述真实值嵌入是由所述编码器神经网络在所述第二时间步长处生成的。

9、在一些实现方式中,所述多个第二时间步长中的每个第二时间步长处的所述一个或多个相应声学词元的集合包括多个声学词元,所述多个声学词元共同表示应用于嵌入的残差向量量化的输出的预测,所述嵌入表示所述音频信号在所述第二时间步长处的声学特性,所述残差向量量化使用多个向量量化器的层次结构来对所述嵌入进行编码,所述多个向量量化器各自从所述向量量化器的对应声学词元词表生成相应声学词元,其中所述层次结构包括位于所述层次结构中的前一个或多个位置处的一个或多个粗向量量化器和位于所述层次结构中的后一个或多个位置处的一个或多个细向量量化器,并且每个第二时间步长处的所述声学词元的集合针对每个向量量化器包括从所述向量量化器的所述词表中选择的相应声学词元。

10、在一些实现方式中,使用一个或多个生成神经网络以至少所述语义表示为条件来生成所述音频信号的声学表示包括:针对所述层次结构中的所述一个或多个粗向量量化器中的每个粗向量量化器,使用第一生成神经网络以至少所述语义表示为条件来生成所述向量量化器的所述第二时间步长的相应声学词元。

11、在一些实现方式中,所述第一生成神经网络是自回归神经网络,所述自回归神经网络被配置为根据第一生成顺序自回归地生成所述声学词元,并且其中每个特定粗向量量化器的在每个特定第二时间步长处的每个特定声学词元是以至少所述语义表示和在所述第一生成顺序中在所述特定声学词元之前的任何声学词元为条件。

12、在一些实现方式中,每个特定粗向量量化器的在每个特定第二时间步长处的每个特定声学词元在所述第一生成顺序中是在以下声学词元之后:(i)所述粗向量量化器中的任何粗向量量化器在所述特定第二时间步长之前的任何第二时间步长处的任何声学词元,以及(ii)在所述层次结构中在所述特定向量量化器之前的任何粗向量量化器在所述特定第二时间步长处的任何声学词元。

13、在一些实现方式中,所述第一生成神经网络具有仅解码器transformer架构或编码器-解码器transformer架构。

14、在一些实现方式中,使用一个或多个生成神经网络以至少所述语义表示为条件来生成所述音频信号的声学表示包括:针对所述层次结构中的所述一个或多个细向量量化器中的每个细向量量化器,使用第二生成神经网络以所述层次结构中的所述一个或多个粗向量量化器的所述第二时间步长的相应声学词元为条件来生成所述向量量化器的所述第二时间步长的相应声学词元。

15、在一些实现方式中,所述第二生成神经网络不以所述语义表示为条件。

16、在一些实现方式中,所述第二生成神经网络是自回归神经网络,所述自回归神经网络被配置为根据第二生成顺序自回归地生成所述声学词元,并且其中每个特定细向量量化器的在每个特定第二时间步长处的每个特定声学词元以以下各项为条件:(i)所述一个或多个粗向量量化器的所述第二时间步长的至少子集的相应声学词元,以及(ii)在所述第二生成顺序中在所述特定声学词元之前的所述声学词元的至少子集。

17、在一些实现方式中,每个特定细向量量化器的在每个特定第二时间步长处的每个特定声学词元在所述第二生成顺序中是在以下声学词元之后:(i)所述细向量量化器中的任何细向量量化器在所述特定第二时间步长之前的任何第二时间步长处的任何声学词元,以及(ii)在所述层次结构中在所述特定向量量化器之前的任何细向量量化器在所述特定第二时间步长处的任何声学词元。

18、在一些实现方式中,每个特定细向量量化器的在每个特定第二时间步长处的每个特定声学词元是以以下各项为条件:(i)所述一个或多个粗向量量化器的在所述第二时间步长之前至多阈值数量的第二时间步长的相应声学词元,以及(ii)在所述第二生成顺序中在所述特定第二时间步长之前的并且是在所述第二时间步长之前至多阈值数量的第二时间步长的第二时间步长处的任何声学词元。

19、在一些实现方式中,所述第二生成神经网络具有仅解码器transformer架构或编码器-解码器transformer架构。

20、在一些实现方式中,获得所述音频信号的语义表示包括:使用第三生成神经网络来自回归地生成所述语义表示。

21、在一些实现方式中,所述请求指定所述音频信号的上下文并且所述音频信号是以所述上下文为条件。

22、在一些实现方式中,所述上下文指定所述音频信号的语义特性,并且获得所述音频信号的语义表示包括:以所述上下文为条件来生成所述语义表示。

23、在一些实现方式中,所述上下文指定所述音频信号的声学特性,并且使用一个或多个生成神经网络以至少所述语义表示为条件来生成所述音频信号的声学表示包括:使用一个或多个生成神经网络以所述语义表示和所述上下文为条件来生成所述音频信号的声学表示。

24、在一些实现方式中,针对所述层次结构中的所述一个或多个粗向量量化器中的每个粗向量量化器,使用第一生成神经网络以至少所述语义表示为条件来生成所述向量量化器的所述第二时间步长的相应声学词元包括:针对所述层次结构中的所述一个或多个粗向量量化器中的每个粗向量量化器,使用第一生成神经网络以所述语义表示和所述上下文为条件来生成所述向量量化器的所述第二时间步长的相应声学词元。

25、在一些实现方式中,使用解码器神经网络来处理至少所述声学表示以生成所述音频信号的所述预测包括:使用所述解码器神经网络来处理所述声学表示和所述上下文的声学表示以生成所述音频信号的所述预测。

26、在一些实现方式中,所述上下文包括音频输入。

27、在一些实现方式中,所述上下文包括视觉数据。

28、在一些实现方式中,所述文本包括文本数据。

29、在一些实现方式中,跨越所述时间窗口的第一时间步长的数量和第二时间步长的数量小于跨越所述时间窗口的输出时间步长的数量。

30、在一些实现方式中,跨越所述时间窗口的所述第一时间步长的数量小于跨越所述时间窗口的所述第二时间步长的数量。

31、根据第二方面,提供了一种用于生成音频信号的预测的计算机实现的方法,所述方法包括:接收以输入为条件来生成音频信号的请求,所述音频信号具有在跨越时间窗口的多个输出时间步长中的每个输出时间步长处的相应音频样本;使用嵌入神经网络来处理所述输入以将所述输入映射到一个或多个嵌入词元;生成所述音频信号的语义表示,所述语义表示指定在跨越所述时间窗口的多个第一时间步长中的每个第一时间步长处的相应语义词元,每个语义词元是以所述嵌入词元为条件从语义词元词表中选择的并且表示所述音频信号在对应第一时间步长处的语义内容;使用一个或多个生成神经网络以至少所述语义表示和所述嵌入词元为条件来生成所述音频信号的声学表示,所述声学表示指定在跨越所述时间窗口的多个第二时间步长中的每个第二时间步长处的一个或多个相应声学词元的集合,每个第二时间步长处的所述一个或多个相应声学词元表示所述音频信号在对应第二时间步长处的声学特性;以及使用解码器神经网络来处理至少所述声学表示以生成所述音频信号的所述预测。

32、在一些实现方式中,使用嵌入神经网络来处理所述输入以将所述输入映射到一个或多个嵌入词元包括:使用所述嵌入神经网络来生成所述输入在联合嵌入空间中的嵌入向量;以及量化所述嵌入向量以生成嵌入词元。

33、在一些实现方式中,所述输入包括文本序列,并且其中所述嵌入神经网络已被训练为将文本和音频映射到联合嵌入空间。

34、在一些实现方式中,所述输入包括文本序列,并且所述音频信号的所述预测是由所述文本序列描述的音乐的预测。

35、在一些实现方式中,所述输入进一步包括表示旋律的音频信号,并且所述音频信号的所述预测是由所述文本序列描述并且随循所述旋律的音乐的预测。

36、在一些实现方式中,所述方法还包括:使用旋律嵌入神经网络来处理所述音频信号以将所述音频信号映射到一个或多个旋律嵌入词元;以及将所述旋律嵌入词元与所述嵌入词元连结。

37、在一些实现方式中,所述输入包括表示旋律的音频信号,并且所述音频信号的所述预测是随循所述旋律的音乐的预测。

38、在一些实现方式中,所述方法进一步包括:使用旋律嵌入神经网络来处理所述音频信号以将所述音频信号映射到一个或多个旋律嵌入词元;并且其中每个语义词元是以所述旋律嵌入词元为条件从语义词元词表中选择的。

39、在一些实现方式中,使用旋律嵌入神经网络来处理所述音频信号以将所述音频信号映射到一个或多个旋律嵌入词元包括:使用所述旋律嵌入神经网络来生成所述音频信号在联合嵌入空间中的一个或多个旋律嵌入向量;以及量化所述一个或多个旋律嵌入向量以生成旋律嵌入词元。

40、在一些实现方式中,所述文本序列包括多个文本子序列,并且所述音频信号的所述预测是具有音乐部段的音乐的预测,所述音乐部段与所述子序列中的每个子序列相对应并且反映所述子序列中的每个子序列。

41、在一些实现方式中,所述嵌入神经网络是基于包括音频信号的训练数据进行训练的。

42、在一些实现方式中,所述嵌入神经网络已基于目标进行训练,使得描述音频信号的文本和对应的音频信号具有在所述联合嵌入空间中彼此靠近的嵌入。

43、在一些实现方式中,所述解码器神经网络是神经音频编解码器的解码器神经网络,所述解码器神经网络已基于目标与编码器神经网络进行联合训练,所述目标度量由所述解码器神经网络从声学表示生成的预测音频信号的重建质量,所述声学表示是使用由所述编码器神经网络生成的输出生成的。

44、在一些实现方式中,所述声学表示是从编码器神经网络通过处理所述音频信号的输出会生成的真实值声学表示的预测。

45、在一些实现方式中,所述编码器神经网络在所述多个第二时间步长中的每个第二时间步长处输出相应嵌入,并且其中所述真实值声学表示是通过对所述相应嵌入中的每个嵌入应用量化来生成的。

46、在一些实现方式中,所述量化是残差向量量化,所述残差向量量化使用多个向量量化器的层次结构来对每个嵌入进行编码,所述多个向量量化器各自从所述向量量化器的对应声学词元词表生成相应声学词元,其中所述层次结构包括位于所述层次结构中的前一个或多个位置处的一个或多个粗向量量化器和位于所述层次结构中的后一个或多个位置处的一个或多个细向量量化器,并且每个第二时间步长处的所述一个或多个相应声学词元的集合针对每个向量量化器包括相应声学词元,所述相应声学词元是从所述向量量化器的所述词表中选择的并且是由所述向量量化器从真实值嵌入会生成的真实值声学词元的预测,所述真实值嵌入是由所述编码器神经网络在所述第二时间步长处生成的。

47、在一些实现方式中,所述多个第二时间步长中的每个第二时间步长处的所述一个或多个相应声学词元的集合包括多个声学词元,所述多个声学词元共同表示应用于嵌入的残差向量量化的输出的预测,所述嵌入表示所述音频信号在所述第二时间步长处的声学特性,所述残差向量量化使用多个向量量化器的层次结构来对所述嵌入进行编码,所述多个向量量化器各自从所述向量量化器的对应声学词元词表生成相应声学词元,其中所述层次结构包括位于所述层次结构中的前一个或多个位置处的一个或多个粗向量量化器和位于所述层次结构中的后一个或多个位置处的一个或多个细向量量化器,并且每个第二时间步长处的所述声学词元的集合针对每个向量量化器包括从所述向量量化器的所述词表中选择的相应声学词元。

48、在一些实现方式中,使用一个或多个生成神经网络以至少所述语义表示和所述嵌入词元为条件来生成所述音频信号的声学表示包括:针对所述层次结构中的所述一个或多个粗向量量化器中的每个粗向量量化器,使用第一生成神经网络以至少所述语义表示和所述嵌入词元为条件来生成所述向量量化器的所述第二时间步长的相应声学词元。

49、在一些实现方式中,所述第一生成神经网络是自回归神经网络,所述自回归神经网络被配置为根据第一生成顺序自回归地生成所述声学词元,并且其中每个特定粗向量量化器的在每个特定第二时间步长处的每个特定声学词元是以至少所述语义表示和所述嵌入词元以及在所述第一生成顺序中在所述特定声学词元之前的任何声学词元为条件。

50、在一些实现方式中,每个特定粗向量量化器的在每个特定第二时间步长处的每个特定声学词元在所述生成顺序中是在以下声学词元之后:(i)所述粗向量量化器中的任何粗向量量化器在所述特定第二时间步长之前的任何第二时间步长处的任何声学词元,以及(ii)在所述层次结构中在所述特定向量量化器之前的任何粗向量量化器在所述特定第二时间步长处的任何声学词元。

51、在一些实现方式中,所述第一生成神经网络具有仅解码器transformer架构或编码器-解码器transformer架构。

52、在一些实现方式中,使用一个或多个生成神经网络以至少所述语义表示和所述嵌入词元为条件来生成所述音频信号的声学表示包括:针对所述层次结构中的所述一个或多个细向量量化器中的每个细向量量化器,使用第二生成神经网络以所述层次结构中的所述一个或多个粗向量量化器的所述第二时间步长的相应声学词元为条件来生成所述向量量化器的所述第二时间步长的相应声学词元。

53、在一些实现方式中,所述第二生成神经网络不以所述语义表示和所述嵌入词元为条件。

54、在一些实现方式中,所述第二生成神经网络是自回归神经网络,所述自回归神经网络被配置为根据第二生成顺序自回归地生成所述声学词元,并且其中每个特定细向量量化器的在每个特定第二时间步长处的每个特定声学词元以以下各项为条件:(i)所述一个或多个粗向量量化器的所述第二时间步长的至少子集的相应声学词元,(ii)在所述第二生成顺序中在所述特定声学词元之前的所述声学词元的至少子集。

55、在一些实现方式中,每个特定细向量量化器的在每个特定第二时间步长处的每个特定声学词元在所述生成顺序中是在以下声学词元之后:(i)所述细向量量化器中的任何细向量量化器在所述特定第二时间步长之前的任何第二时间步长处的任何声学词元,以及(ii)在所述层次结构中在所述特定向量量化器之前的任何细向量量化器在所述特定第二时间步长处的任何声学词元。

56、在一些实现方式中,每个特定细向量量化器的在每个特定第二时间步长处的每个特定声学词元是以以下各项为条件:(i)所述一个或多个粗向量量化器的在所述第二时间步长之前至多阈值数量的第二时间步长的相应声学词元,以及(ii)在所述第二生成顺序中在所述特定第二时间步长之前的并且是在所述第二时间步长之前至多阈值数量的第二时间步长的第二时间步长处的任何声学词元。

57、在一些实现方式中,所述第二生成神经网络具有仅解码器transformer架构或编码器-解码器transformer架构。

58、在一些实现方式中,生成所述音频信号的语义表示包括:以嵌入词元作为条件化(conditioning)信号使用第三生成神经网络来自回归地生成所述语义表示。

59、在一些实现方式中,跨越所述时间窗口的第一时间步长的数量和第二时间步长的数量小于跨越所述时间窗口的输出时间步长的数量。

60、在一些实现方式中,跨越所述时间窗口的所述第一时间步长的数量小于跨越所述时间窗口的所述第二时间步长的数量。

61、在一些实现方式中,所述输入包括文本序列,嵌入是联合嵌入空间中的嵌入,其中所述一个或多个生成神经网络已至少部分地基于仅音频训练数据进行训练,其中在所述训练期间,所述语义表示和所述声学表示是以音频输入在所述联合嵌入空间中的嵌入为条件。

62、根据另一方面,还描述了一种系统,所述系统包括:一个或多个计算机;以及一个或多个存储装置,所述一个或多个存储装置存储指令,所述指令在由所述一个或多个计算机执行时使所述一个或多个计算机执行本文所述的方法。

63、根据另一方面,还描述了一种或多种计算机可读存储介质,所述一种或多种计算机可读存储介质存储指令,所述指令在由一个或多个计算机执行时使所述一个或多个计算机执行本文所述的方法。

64、本说明书中描述的主题的特定实施例可被实施以便实现以下优点中的一个或多个优点。

65、本说明书中描述的系统提供具有长期连贯结构的高质量音频生成。例如,为了生成音频信号的预测,所述系统可获得音频信号的语义表示。语义表示可通过表示诸如语音的语言内容或音乐的旋律和节奏的特征来确保长期一致性。所述系统可使用一个或多个生成神经网络基于语义表示来生成音频信号的声学表示。声学表示可通过表示诸如声学细节的特征来确保高质量的音频合成。然后,所述系统可使用解码器神经网络来处理声学表示以生成音频信号的预测。因此,所述系统可使用来自语义表示和声学表示两者的信息来生成高质量且结构连贯的音频。

66、常规的生成音频的系统可能无法在没有条件化或文本注释的情况下生成具有连贯语音的音频。本说明书中描述的系统可在没有任何文本注释的情况下生成句法和语义连贯的语音。例如,所述系统可使用语义表示来捕获局部依赖关系(诸如发音(phonetic))和长期语义信息(诸如语言内容和时间结构)。

67、此外,常规的生成语音的系统可能会生成声学多样性或质量有限的语音。例如,常规系统可仅基于干净语音进行训练,并且以单个说话者的嗓音生成语音。其他常规系统可能会生成低质量的音频。本说明书中描述的系统可生成保留任何未见过的说话者的嗓音、语调和韵律的语音延续。例如,所述系统可使用声学表示来捕获给定上下文的音频输入的说话者身份和录音条件。

68、在一些实现方式中,由所述系统生成的音频是音乐。例如,所述系统可生成音频输入的延续,所述延续包括在旋律、和声、音调、演奏风格、音色和节奏方面与输入连贯的音乐。所述系统可使用语义表示来捕获信息诸如和声、节奏和旋律。例如,语义表示可提供与提示一致的旋律和时间结构。然后,所述系统可使用语义表示来指导声学表示的生成。

69、所述系统可在训练期间节省计算资源。例如,可在训练一个或多个生成神经网络之前对从声学表示生成音频信号的预测的解码器神经网络进行预训练和冻结。也可在训练一个或多个生成神经网络之前对可用于获得目标语义表示的音频表示神经网络和可用于获得目标声学表示的神经音频编解码器进行预训练和冻结。此外,虽然常规系统是基于干净音频语音样本进行训练的,但本说明书中描述的系统在基于更加多样化和嘈杂的样本进行训练时显示出了强大的性能。对训练数据质量的增加的稳健性减少了准备训练数据并使其干净所需的计算资源和时间。

70、所述系统还可在推断期间节省计算资源。例如,所述系统获得语义表示,然后使用所述语义表示作为生成声学表示的条件化。因此,与诸如处理交织的语义和声学词元序列的替代方案相比,所述系统处理的词元的数量减少,从而允许更高效的推断和训练。此外,与诸如直接处理音频样本的替代方案相比,自回归地生成语义和声学词元、然后将声学词元映射到音频样本节省了计算资源。

71、在一些实现方式中,所述系统可鉴于包括文本的输入来生成音乐。与常规音乐生成系统相比,所述系统可生成遵循更复杂的给定高级文本描述的长的、高质量的、且连贯的音乐。例如,由于所述系统使用具有音频和文本的联合嵌入空间的嵌入神经网络以及本说明书中描述的生成神经网络,所以与常规的从文本生成音乐的系统相比,所述系统可更高效地以文本为条件来生成音乐。

72、另外,并非所有期望的音乐特性都易于使用文本来描述。例如,旋律可能是一段音乐的重要特性,但难以使用文本来描述。鉴于表示旋律的输入音频剪裁片(clip),在一些实现方式中,所述系统可生成随循旋律的音乐。例如,输入音频剪裁片可包括哼唱的旋律。所述系统可通过使用旋律嵌入神经网络为一个或多个生成神经网络提供条件化来生成遵循旋律的音乐。在一些实现方式中,所述系统可生成随循输入旋律并且反映输入文本序列的音乐。例如,所述系统可使用嵌入神经网络和旋律嵌入神经网络来生成嵌入词元(也称为音频嵌入词元)。

73、所述系统可以文本为条件来生成音乐,而无需成对的文本-音乐训练数据的大的训练数据集。所述系统可基于仅音乐数据集进行训练。仅基于音乐来训练所述系统还有助于使所述系统对嘈杂的标签具有稳健性,这在实现常规音乐生成系统时可能是一项限制。

74、在所述系统可鉴于包括文本的输入生成音乐的一些实现方式中,可独立地训练所述系统的每个组件,从而在训练期间实现灵活性和效率。例如,可单独训练或同时训练嵌入神经网络和解码器神经网络。

75、本说明书的主题的一个或多个实施例的细节在附图和以下描述中进行阐述。根据所述描述、附图和权利要求书,本主题的其他特征、方面和优点将变得显而易见。

本文地址:https://www.jishuxx.com/zhuanli/20241106/321789.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表