基于结构自注意力GAN的金属齿面三维测量高动态范围条纹修复方法

- 国知局

- 2024-11-18 18:22:03

本发明属于计算机视觉三维重建,涉及一种基于结构自注意力gan的金属齿面三维测量高动态范围条纹修复方法。

背景技术:

1、齿轮是工业设备中的关键部件。为了保证齿轮的制造质量和安全运行,对齿轮轮齿及其缺陷进行三维测量是非常重要的。条纹投影轮廓术(fringe projectionprofilometry,fpp)是一种新型的非接触式三维测量技术,具有精度高、操作简单、分辨率高、表面无损测量、硬件成本低等优点。然而,对于fpp方法,高反射表面的3d重建仍然具有挑战性。当条纹图案投影到金属齿轮齿上时,会发生漫反射和镜面反射。对于金属表面,当摄像机光轴与镜面反射方向平行时,所捕获的条纹强度超过传感器的动态范围,导致条纹信息丢失。很明显,信息丢失严重影响了三维重建的精度。此问题源于金属表面的高反射性,因此无法通过调整摄像机曝光或投影仪强度来完全解决。相位测量偏折术(pmd)可以解决过度反射的问题,但仅限于测量连续镜面。在实际工程中,常用的方法包括将成像剂喷射到表面上,以将镜面反射转换成漫反射,从而减轻高反射率问题。然而,这种方法不适用于这些可能未喷涂的部件,并且处理在线测量是具有挑战性的。

2、为了解决上述问题,已经提出了多种高动态范围(hdr)方法,这些方法主要被分类为:(i)多次曝光融合方法。这种方法通过改变相机曝光时间、光圈大小或感光度来调整曝光,然后连续拍摄多个图案。最后,合成了高信噪比的方向图。然而,对于反射率变化范围较大的物体,需要采集到很多条纹图,因此该技术不适合复杂场景。(ii)自适应投影法。这种类型的方法调整投影条纹的强度以降低图案饱和度。然而,当投影强度较低时,暗反射区域更容易受到环境光的干扰,同时该技术还需要将多个条纹融合成单个图案,导致计算非常耗时。(iii)偏振器滤波方法。这类方法通常会在摄像机前加一个特殊的偏光片,滤除镜面反射光,从而有效降低金属表面的过饱和度。但是,偏振角需要适应系统条纹的明暗变化,需要多个偏振器,增加了测量系统的复杂性和硬件成本。(iv)光度立体技术。物体表面的重建是使用不同的光度信息的模式从不同的方向性光源。然而,该技术要求物体具有朗伯反射属性,因此不能正确处理具有镜面反射属性的物体区域。而且,它不适用于绝对高度重建。由此可见,光度立体方法不能替代典型的3d重建算法。尽管上述方法在一定程度上解决了高反射率的问题,但是仍然存在以下挑战,包括条纹图案数量的增加、测量效率的降低、曝光区域和曝光不足区域之间的不平衡、高计算复杂度、硬件成本的增加等。

3、深度学习在测量和缺陷检测方面表现出了令人印象深刻的优点。关于条纹修补,xi等人使用了一个附加的反射先验网络来生成特征掩模,以指导编码和解码网络。该网络生成高质量的非反射条纹图,实现了多种金属零件表面条纹的恢复。该方法还存在训练时间长、训练过程复杂、训练不稳定等问题。另外,所产生的条纹图案的质量需要进一步提高。

技术实现思路

1、有鉴于此,本发明的目的在于提供一种基于结构自注意力gan的金属齿面三维测量高动态范围条纹修复方法。

2、为达到上述目的,本发明提供如下技术方案:

3、一种基于结构自注意力gan的金属齿面三维测量高动态范围条纹修复方法,包括以下步骤:

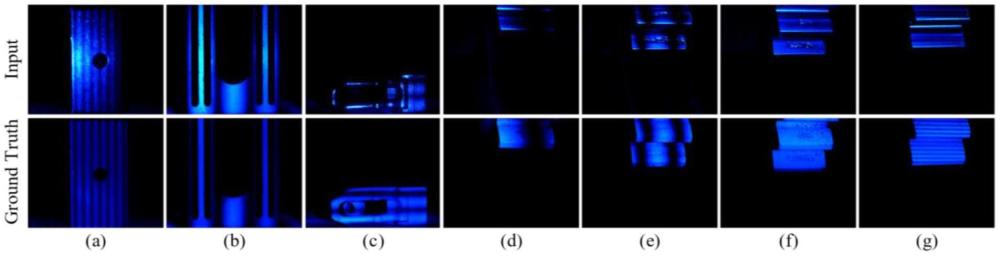

4、s1:采集金属齿面过曝光条纹图和正常条纹图成对图像数据集;

5、s2:在传统生成对抗网络gan基础上融合上采样过程中的局部高反射特征和下采样过程中的浅层语义特征,设计一种自注意力跳跃上采样模块(self-attention skippingupsampling block),构建结构自注意力生成对抗网络ssa-gan;

6、s3:对所述ssa-gan进行训练,训练时在损失函数中加入结构性损失函数,关注条纹的光照、对比度、纹理信息,并赋予三者各自的权重;

7、s4:利用ssa-gan生成的修复后条纹图,结合相移法和多频外差法,对反光齿面进行三维重建,得到相位信息以及点云信息。

8、进一步,步骤s1中,通过结构光投影仪和工业相机来投影和捕获图像,具体包括以下步骤:

9、s11:控制结构光投影仪将四频九步条纹图案[1,3,9,36]投影到物体表面上,用工业相机拍摄条纹图案;

10、s12:固定齿轮的位置,将显影剂喷射到齿表面上,待显影剂稳定,重复投影和图像捕获步骤,以获得对应的理想的无反光条纹图;

11、s13:获得由多对过曝光条纹图和正常条纹图构成的成对数据集;

12、s14:将成对数据集按比例划分为训练集、测试集和验证集。

13、进一步,所述结构自注意力生成对抗网络ssa-gan由生成器网络g和判别器网络d组成;

14、生成器网络g结构基于u-net,其下采样模块由卷积、正则化、relu激活函数和dropout层构成;上采样模块由自注意力跳跃上采样模块构成,所述自注意力跳跃上采样模块中的网络共七层,输入为1024*1280的过曝光条纹图,输出为1024*1280的正常曝光条纹图;

15、判别器网络d由卷积、归一化、relu操作组成,共三层,最后将特征图扩充后,再经过卷积操作得到输出,其输入为g生成的1024*1280假条纹图,输出为1024*1280的判断图,每个像素点的值为0或1,即判断生成器生成的图像为假或者真;

16、g和d通过各损失函数交替训练直到收敛,即生成器生成了与真值正常曝光条纹图最接近的条纹图。

17、进一步,所述自注意力跳跃上采样模块的输入的特征图来自于生成器u-net网络的上采样过程,首先获取上采样过程中无关噪声少的特征,借助simam赋予高反光区域额外的注意力权重,接着和u-net网络下采样过程提取的特征拼接融合,经过通道过滤的特征,与初始上采样的特征拼接输出,以替代原始u-net网络的上采样过程;

18、所述自注意力跳跃上采样模块由以下公式表示:

19、

20、其中up代表上采样得到的特征,且concat代表拼接操作,conv表示卷积操作,drop表示屏蔽神经元操作,relu表示激活函数,norm表示归一化,transconv表示反卷积操作,表示u-net网络下采样的特征,k表示u-net网络的层数,表示给上采样特征图高反光区域赋予simam注意力。

21、进一步,所述ssa-gan中,在特征信息传递过程中注意力需要估计网络中单个神经元的重要性,通过测量目标神经元和其他神经元的线性可分性鉴别出重要神经元,神经元最小能量的解为:

22、

23、其中,是该通道中除了目标神经元t以外的所有神经元的均值和方差;m=h×w代表该通道中神经元的数量,λ是一个常数;能量越低,神经元与周围神经元区别越大,重要性越高;

24、用1/e*表示每个神经元的重要性,按照注意力机制,对特征赋予不同程度的重要性,即进行增强处理:

25、

26、其中e代表通道和空间维度内所有的x代表特征。

27、进一步,步骤s3中,ssa-gan的优化目标表示为:

28、

29、其中a代表输入的反光条纹图breal是条纹图的标签,g(a)和bfake代表网络生成的条纹图;生成器g最小化该目标函数,鉴别器d则最大化目标函数;

30、在具体训练过程中,单个参数训练时其他参数保持固定,随着对抗训练的进行,g和d将在某个时刻达到纳什均衡。

31、进一步,所述结构性损失函数构建步骤如下:

32、首先,成对条纹图的光照相似度表示为:

33、

34、其中μa代表像素范围内的平均像素值,c1=(k1l)2是一个常数,k1为常数,l是灰度范围,条纹图对比度相似性表示为:

35、

36、其中σx代表像素范围内的标准差;

37、条纹图的结构相似性表示为:

38、

39、将整体结构相似度转化为结构性损失函数:

40、

41、其中α,β和γ表示每个相似度的重要程度,根据具体不同的目标设置不同的值。

42、进一步,结构自注意力生成对抗网络ssa-gan的整体损失函数如下:

43、

44、

45、其中a表示输入的反光条纹图breal表示条纹图的标签,bfake表示网络生成的条纹图;表示l1损失函数;

46、旨在约束假条纹图案和真实条纹图案之间要具有联系,权重分配原则为α>β>γ。

47、旨在使生成的假条纹接近真实条纹图,在中分配权重的原则是α=β=γ。

48、进一步,步骤s4具体包括以下步骤:

49、投影的条纹表示如下:

50、

51、其中a(x,y)代表背景光强度,b(x,y)代表条纹调制,是物体的展开相位,(x,y)是物体的像素坐标,且n是相移系数,n=1,2,3...n;包裹相位用n步相移法来计算;根据投影条纹公式,展开相位表示为:

52、

53、获得相位信息后,需要进行相位展开,以保证像素点与相位值之间一一对应;

54、全场相位展开通过基于时域和空间域的技术来实现;基于时间的相位展开方法应用广泛。利用多频外差方法来实现基于时域的相位展开,投射不同频率的不同条纹图案来实现,获得的绝对相位是覆盖整个像素范围的连续相位分布,绝对相位表示为:

55、

56、其中φ(x,y)是绝对相位,k(x,y)代表条纹级数。

57、本发明的有益效果在于:本发明可以有效修复条纹投影三维重建过程中,因为金属反光导致的条纹图过曝光,相位信息丢失的情况,而且可以处理各种类型的调制条纹图案,包括不同的金属材料、条纹类型和过度曝光程度,并且比现有方法能够更准确地修复条纹图案,从而提高后续3d检测的准确性。

58、本发明的其他优点、目标和特征在某种程度上将在随后的说明书中进行阐述,并且在某种程度上,基于对下文的考察研究对本领域技术人员而言将是显而易见的,或者可以从本发明的实践中得到教导。本发明的目标和其他优点可以通过下面的说明书来实现和获得。

本文地址:https://www.jishuxx.com/zhuanli/20241118/328448.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。