基于联合优化的LLMs组合压缩方法、电子设备和存储介质

- 国知局

- 2025-01-10 13:13:41

本发明涉及神经网络的压缩与加速,特别是指一种基于联合优化的llms组合压缩方法、电子设备和存储介质。

背景技术:

1、大型语言模型(large language models,llms)在人工智能领域,尤其是在自然语言处理(nlp)领域,扮演着重要的角色。大型语言模型通过分析大量的文本数据来学习语言的结构、含义和用法,从而能够理解和生成自然语言文本。这些模型通常具有数十亿甚至数千亿个参数,能够处理和生成极其复杂的文本内容。

2、在深度学习领域,transformer结构在各种视觉任务中已经广泛应用,其性能随着模型尺寸的增大而显著提升。然而,transformer模型的复杂性和规模也带来了计算资源需求的大幅增加。因此,研究人员提出了多种模型压缩技术来应对这一挑战,包括量化和稀疏化等方法:

3、(1)量化是一种将模型的权重和激活值从高精度浮点数转换为低位定点数的技术。这种方法能够减少模型的大小,提高内存访问效率,从而加速计算过程。在支持低位运算的硬件上,量化模型可以显著提升推理速度。训练后量化(ptq)是一种常用的方法,不需要进行大量的重新训练,只需少量的校准数据即可实现。然而,量化过程中会引入一定的量化误差,尤其是在处理异常值时,误差更加显著。

4、(2)稀疏化是通过将稠密的权重矩阵转换为稀疏矩阵来实现模型压缩的方法。稀疏化可以显著减少计算量,提高模型推理速度。与量化类似,稀疏化也面临着如何在减少计算资源的同时保持模型性能的问题。

5、尽管量化和稀疏化技术在模型压缩方面都取得了显著进展,但它们在应用于llms模型时存在一些主要缺点:

6、①量化误差增加:在处理llms时,异常值的存在使得量化误差显著增加,异常值的幅值在后续的transformer块中往往会增加,这会导致大量的舍入误差;

7、②稀疏化不稳定:稀疏化过程中,如果未能有效处理权重的重要性评估,可能会导致关键权重的丢失,从而影响模型的性能;

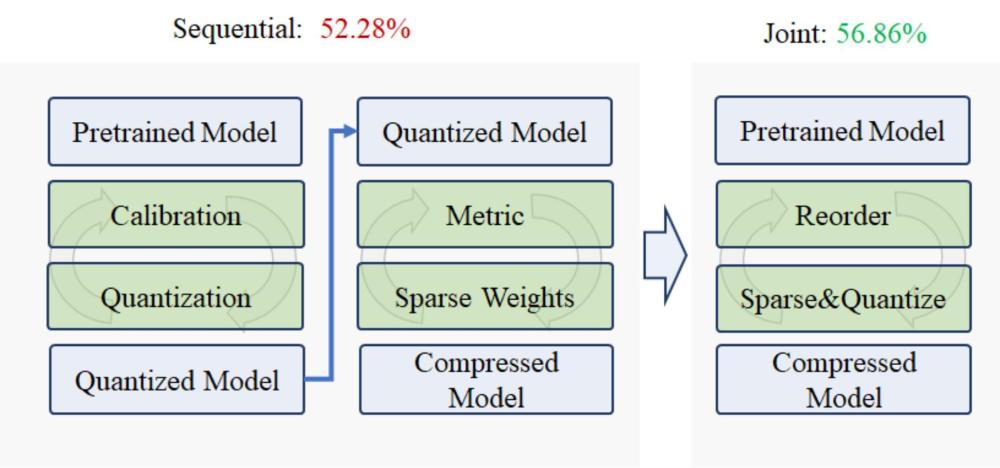

8、③重建粒度问题:现有方法在处理llms的量化时,往往忽略了稀疏化的重要性;不同压缩算法同时考虑可以有效减少对应压缩损失,但如果顺序压缩,则会导致模型性能的下降。

9、综上所述,现有的量化和稀疏化方法在应用于llms模型时存在显著的挑战,主要表现在异常值处理、稀疏化稳定性以及量化与稀疏化的结合方式上。这些缺点需要通过更为精细和优化的方法来解决,以实现更高效的模型压缩和更好的模型性能。

技术实现思路

1、本发明的目的在于提供一种基于联合优化的llms组合压缩方法、电子设备和存储介质,解决现有技术中存在的问题,将量化和稀疏化方法相结合,并同时最小化量化和稀疏化带来的误差。

2、为了达成上述目的,本发明的解决方案是:

3、一种基于联合优化的llms组合压缩方法,包括以下步骤:

4、步骤1、数据准备

5、从wikitext2训练语料库中采样128个片段,每个片段包含2048个标签;

6、步骤2、初始权重量化

7、使用统计指标初始化对角线变换矩阵,使用等效变换操作对权重进行初步量化,确定量化步长和零点,并通过步骤1采样的数据对其进行校准;

8、步骤3、应用稀疏掩码

9、计算稀疏掩码,使用重要性指标进行重新排列权重,优先稀疏化不重要的权重;重要性指标的计算公式是,其中表示f范数,表示第个输出通道的激活值,表示取绝对值,表示第行第列的权重值;

10、步骤4、联合优化

11、4-1. 同时最小化量化和稀疏化的误差,在优化过程中对变换矩阵进行梯度更新,确保权重的分布在每次迭代中都能有效优化;

12、4-2. 在每次迭代中,重新计算稀疏掩码,确保权重的稀疏性和量化误差最小化;

13、步骤5、模型评估

14、使用不同的数据集对压缩后的模型进行评估,验证其性能提升。

15、一种电子设备,包括处理器、存储器和应用程序;所述应用程序被存储在所述存储器中,并被配置为由所述处理器执行所述的基于联合优化的llms组合压缩方法。

16、一种计算机可读存储介质,所述存储介质存储有计算机程序;所述计算机程序在所述计算机中执行时,使所述计算机执行所述的基于联合优化的llms组合压缩方法。

17、采用上述技术方案后,本发明具有以下技术效果:

18、通过步骤3和4,引入联合优化策略,通过使用可学习的变换矩阵,在每次迭代中同时优化量化和稀疏化的误差,避免了传统序列优化方法中的误差累积问题,从而提高了模型的整体性能;通过步骤4,提出了一种动态重排序方法,在每次迭代中根据稀疏性度量重新排列权重,优先稀疏化不重要的权重,确保稀疏化过程的稳定性和压缩效果;通过联合优化策略和动态重排序方法,联合优化量化和稀疏化的损失,显著提高了模型在低比特量化和高稀疏配置下的性能,例如在llama2-13b模型中,采用2比特量化和75%稀疏配置时,平均准确率比现有技术中最先进的方法提高了9.03%;通过避免大规模的微调过程,本发明的联合优化策略显著减少了计算资源的消耗,使得模型压缩更加高效;本发明在不同模型和数据集上均表现出显著的性能提升,具有广泛的适用性和通用性。综上所述,本专利通过引入联合优化和动态重排序方法,有效解决了现有技术中存在的误差累积、稀疏化策略不当和局部最优等问题,从而在压缩效果和模型性能上具有显著的有益效果。

技术特征:1. 一种基于联合优化的llms组合压缩方法,其特征在于包括以下步骤:

2.一种电子设备,其特征在于包括处理器、存储器和应用程序;所述应用程序被存储在所述存储器中,并被配置为由所述处理器执行如权利要求1所述的基于联合优化的llms组合压缩方法。

3.一种计算机可读存储介质,其特征在于所述存储介质存储有计算机程序;所述计算机程序在所述计算机中执行时,使所述计算机执行如权利要求1所述的基于联合优化的llms组合压缩方法。

技术总结本发明公开一种基于联合优化的LLMs组合压缩方法、电子设备和存储介质,将量化和稀疏化方法相结合,并同时最小化量化和稀疏化带来的误差,包括以下步骤:从WikiText2训练语料库中采样128个片段,每个片段包含2048个标签;使用统计指标初始化对角线变换矩阵,使用等效变换操作对权重进行初步量化,确定量化步长和零点,并通过步骤1采样的数据对其进行校准;计算稀疏掩码,使用重要性指标进行重新排列权重,优先稀疏化不重要的权重;进行联合优化;使用不同的数据集对压缩后的模型进行评估,验证其性能提升。技术研发人员:纪荣嵘,马跃萧,郑侠武,谢展豪,吴宇航,晁飞受保护的技术使用者:厦门大学技术研发日:技术公布日:2025/1/6本文地址:https://www.jishuxx.com/zhuanli/20250110/351745.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表