一种多层联级式的快递包装图像识别方法

- 国知局

- 2025-01-10 13:13:39

本发明涉及快递包装识别,特别是涉及一种多层联级式的快递包装图像识别方法。

背景技术:

1、面对海量的快递包装废弃物及其引发的环境影响,快递包装的快速识别是分析快递包装使用现状、跟踪行业绿色化表现、评估政策实施效果和提出管理路径改进方向的基础。然而,由于目前缺乏高效、智能、可持续、低成本的应用工具,难以实现广泛持久的追踪和监管。因此,设计一种多层联级式的快递包装图像识别方法是十分有必要。

技术实现思路

1、为了克服现有技术的不足,本发明的目的是提供一种多层联级式的快递包装图像识别方法。

2、为实现上述目的,本发明提供了如下方案:

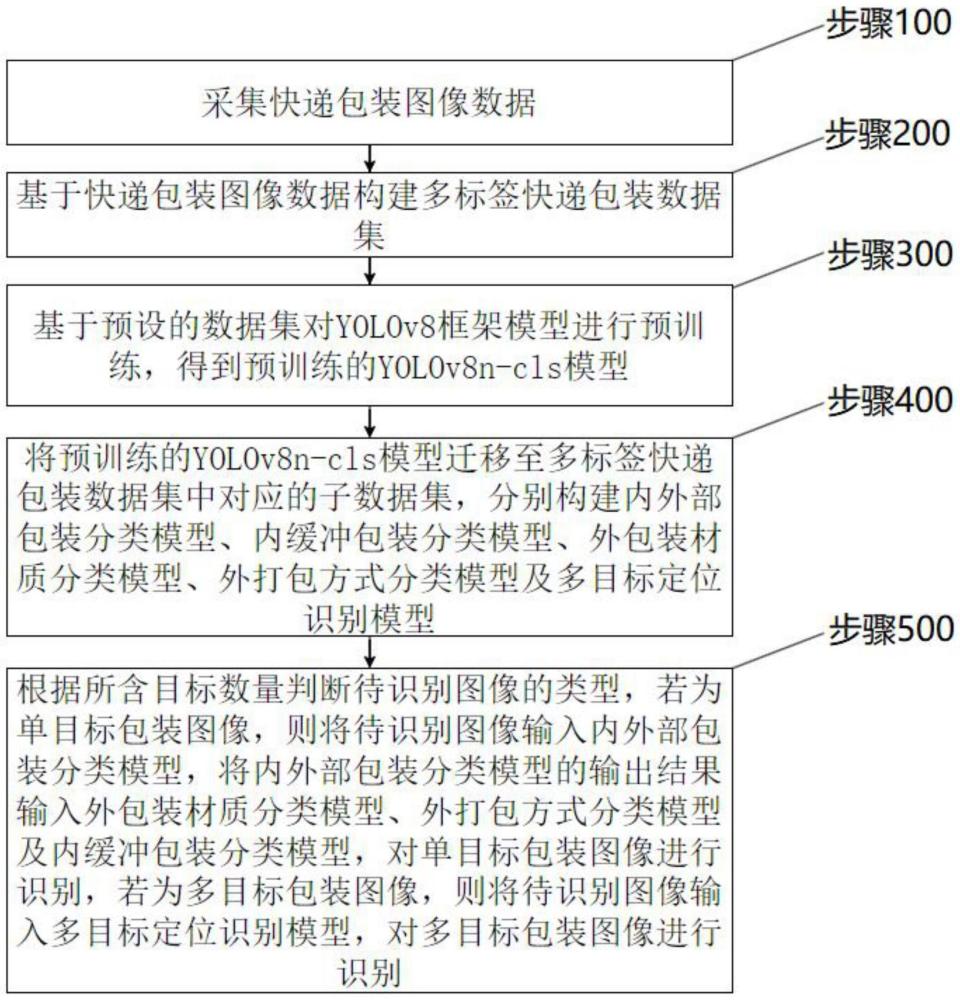

3、本发明提供了一种多层联级式的快递包装图像识别方法,包括:

4、采集快递包装图像数据;

5、基于快递包装图像数据构建多标签快递包装数据集;

6、基于预设的数据集对yolov8框架模型进行预训练,得到预训练的yolov8n-cls模型;

7、将预训练的yolov8n-cls模型迁移至多标签快递包装数据集中对应的子数据集,分别构建内外部包装分类模型、内缓冲包装分类模型、外包装材质分类模型、外打包方式分类模型及多目标定位识别模型;

8、根据所含目标数量判断待识别图像的类型,若为单目标包装图像,则将待识别图像输入内外部包装分类模型,将内外部包装分类模型的输出结果输入外包装材质分类模型、外打包方式分类模型及内缓冲包装分类模型,对单目标包装图像进行识别,若为多目标包装图像,则将待识别图像输入多目标定位识别模型,对多目标包装图像进行识别。

9、根据本发明提供的具体实施例,本发明公开了以下技术效果:

10、本发明提供了一种多层联级式的快递包装图像识别方法,该方法包括采集快递包装图像数据,基于快递包装图像数据构建多标签快递包装数据集,基于预设的数据集对yolov8框架模型进行预训练,得到预训练的yolov8n-cls模型,将预训练的yolov8n-cls模型迁移至多标签快递包装数据集中对应的子数据集,分别构建内外部包装分类模型、内缓冲包装分类模型、外包装材质分类模型、外打包方式分类模型及多目标定位识别模型,根据所含目标数量判断待识别图像的类型,若为单目标包装图像,则将待识别图像输入内外部包装分类模型,将内外部包装分类模型的输出结果输入外包装材质分类模型、外打包方式分类模型及内缓冲包装分类模型,对单目标包装图像进行识别,若为多目标包装图像,则将待识别图像输入多目标定位识别模型,对多目标包装图像进行识别。本发明能够实现快递包装图像识别,便于使用。

技术特征:1.一种多层联级式的快递包装图像识别方法,其特征在于,包括:

2.根据权利要求1所述的方法,其特征在于,采集快递包装图像数据,具体为:

3.根据权利要求1所述的方法,其特征在于,基于快递包装图像数据构建多标签快递包装数据集,具体为:

4.如权利要求3所述的方法,其特征在于,将预训练的yolov8n-cls模型迁移至多标签快递包装数据集中对应的子数据集,构建内外部包装分类模型,具体为:

5.根据权利要求3所述的方法,其特征在于,将预训练的yolov8n-cls模型迁移至多标签快递包装数据集中对应的子数据集,构建内缓冲包装分类模型,具体为:

6.根据权利要求3所述的方法,其特征在于,将预训练的yolov8n-cls模型迁移至多标签快递包装数据集中对应的子数据集,分别构建外包装材质分类模型,具体为:

7.根据权利要求3所述的方法,其特征在于,将预训练的yolov8n-cls模型迁移至多标签快递包装数据集中对应的子数据集,构建外打包方式分类模型,包括:

8.根据权利要求3所述的方法,其特征在于,将预训练的yolov8n-cls模型迁移至多标签快递包装数据集中对应的子数据集,构建多目标定位识别模型,包括:

技术总结本发明提供了一种多层联级式的快递包装图像识别方法,该方法包括采集快递包装图像数据,构建多标签快递包装数据集,对YOLOv8框架模型进行预训练,将预训练的模型迁移至多标签快递包装数据集中对应的子数据集,分别构建内外部包装分类模型、内缓冲包装分类模型、外包装材质分类模型、外打包方式分类模型及多目标定位识别模型,判断待识别图像的类型,若为单目标包装图像,则将待识别图像输入内外部包装分类模型,将内外部包装分类模型的输出结果输入外包装材质分类模型、外打包方式分类模型及内缓冲包装分类模型,进行识别,若为多目标包装图像,则将待识别图像输入多目标定位识别模型,对多目标包装图像进行识别。本发明能够实现快递包装图像识别。技术研发人员:温宗国,谭旖琦受保护的技术使用者:清华大学技术研发日:技术公布日:2025/1/6本文地址:https://www.jishuxx.com/zhuanli/20250110/351742.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表