推理系统的内存管理方法和装置与流程

- 国知局

- 2025-01-10 13:27:30

本申请一个或多个实施例涉及人工智能,尤其涉及一种推理系统的内存管理方法和装置。

背景技术:

1、推理系统(inference system)是一种计算机程序,它使用逻辑规则和已知的事实来得出新的结论或决策。推理系统是人工智能领域的一个重要组成部分,主要用于模拟人类的决策过程。它基于一组已定义的知识库和推理引擎来推导出结论。推理系统可以执行其获取到的推理请求(inference request),并输出对应的推理结果。

2、一个典型的推理系统通常由以下几个部分组成:知识库(knowledge base)、推理引擎(inference engine)、用户界面(user interface)、解释机制(explanationfacility)。其中,知识库包括存储系统所知道的所有事实和规则,这些事实可以是关于世界的状态、对象属性等,而规则则是描述如何从已知事实中得出新结论的逻辑表达式。推理引擎是推理系统的核心组件,它负责执行推理过程中的逻辑运算,即从给定的知识库中得出新的结论或决策;推理引擎使用一系列规则和已知事实来推导出新的知识,从而帮助系统解决问题或做出决定。用户界面允许用户与系统交互,输入查询或观察推理过程的结果。解释机制用来解释系统是如何得出特定结论的,这对于透明度和信任度非常重要。

3、推理引擎通常使用计算资源、存储资源、网络资源等(例如:gpu、gpu内存、存储、网络接口等)资源来执行推理任务,这些资源的高效利用直接影响推理引擎的性能。因此,期望能够更好、更灵活地对推理引擎使用的资源进行管理。

技术实现思路

1、本申请一个或多个实施例提供技术方案如下:

2、本申请提供一种推理系统的内存管理方法,应用于推理系统中的推理引擎;所述推理引擎的计算资源包括用于部署所述推理引擎的计算设备上搭载的gpu;所述推理引擎维护了用于调度处于prefill阶段的推理请求集合的prefill调度队列,以及用于调度处于decode阶段的推理请求集合的decode调度队列;所述方法包括:

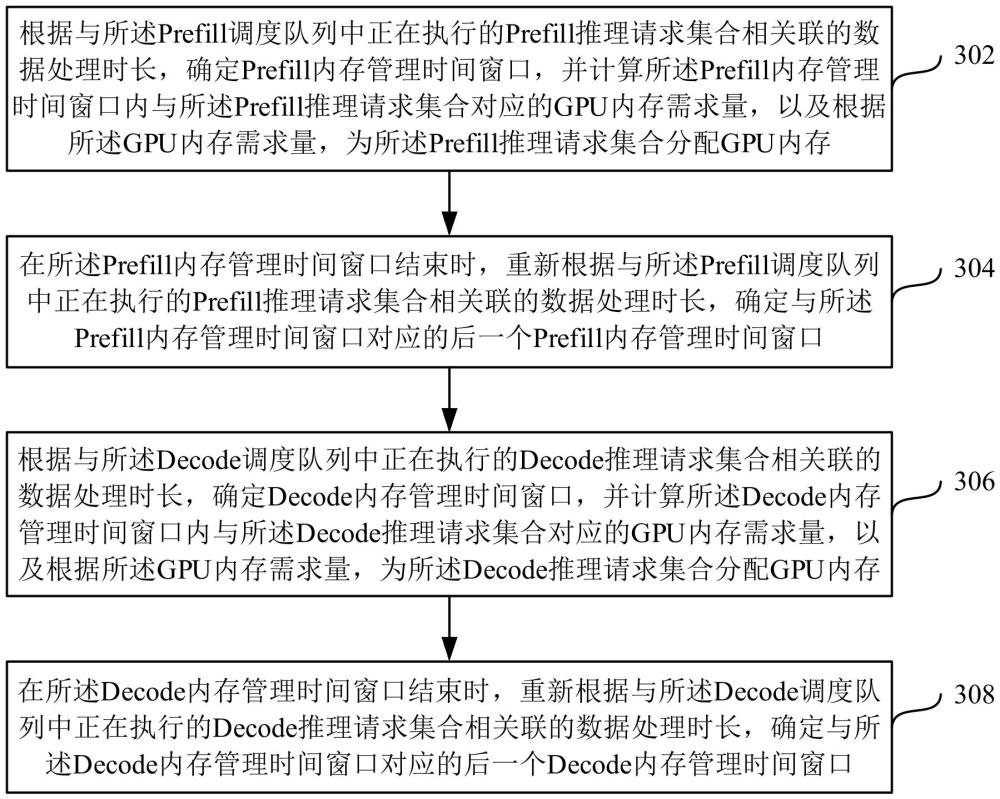

3、根据与所述prefill调度队列中正在执行的prefill推理请求集合相关联的数据处理时长,确定prefill内存管理时间窗口,并计算所述prefill内存管理时间窗口内与所述prefill推理请求集合对应的gpu内存需求量,以及根据所述gpu内存需求量,为所述prefill推理请求集合分配gpu内存;

4、在所述prefill内存管理时间窗口结束时,重新根据与所述prefill调度队列中正在执行的prefill推理请求集合相关联的数据处理时长,确定与所述prefill内存管理时间窗口对应的后一个prefill内存管理时间窗口;

5、根据与所述decode调度队列中正在执行的decode推理请求集合相关联的数据处理时长,确定decode内存管理时间窗口,并计算所述decode内存管理时间窗口内与所述decode推理请求集合对应的gpu内存需求量,以及根据所述gpu内存需求量,为所述decode推理请求集合分配gpu内存;

6、在所述decode内存管理时间窗口结束时,重新根据与所述decode调度队列中正在执行的decode推理请求集合相关联的数据处理时长,确定与所述decode内存管理时间窗口对应的后一个decode内存管理时间窗口。

7、本申请还提供一种推理系统的内存管理装置,应用于推理系统中的推理引擎;所述推理引擎的计算资源包括用于部署所述推理引擎的计算设备上搭载的gpu;所述推理引擎维护了用于调度处于prefill阶段的推理请求集合的prefill调度队列,以及用于调度处于decode阶段的推理请求集合的decode调度队列;所述装置包括:

8、第一内存管理模块,根据与所述prefill调度队列中正在执行的prefill推理请求集合相关联的数据处理时长,确定prefill内存管理时间窗口,并计算所述prefill内存管理时间窗口内与所述prefill推理请求集合对应的gpu内存需求量,以及根据所述gpu内存需求量,为所述prefill推理请求集合分配gpu内存;在所述prefill内存管理时间窗口结束时,重新根据与所述prefill调度队列中正在执行的prefill推理请求集合相关联的数据处理时长,确定与所述prefill内存管理时间窗口对应的后一个prefill内存管理时间窗口;

9、第二内存管理模块,根据与所述decode调度队列中正在执行的decode推理请求集合相关联的数据处理时长,确定decode内存管理时间窗口,并计算所述decode内存管理时间窗口内与所述decode推理请求集合对应的gpu内存需求量,以及根据所述gpu内存需求量,为所述decode推理请求集合分配gpu内存;在所述decode内存管理时间窗口结束时,重新根据与所述decode调度队列中正在执行的decode推理请求集合相关联的数据处理时长,确定与所述decode内存管理时间窗口对应的后一个decode内存管理时间窗口。

10、本申请还提供一种电子设备,包括:

11、处理器;

12、用于存储处理器可执行指令的存储器;

13、其中,所述处理器通过运行所述可执行指令以实现如上述任一项所述方法的步骤。

14、本申请还提供一种计算机可读存储介质,其上存储有计算机指令,该指令被处理器执行时实现如上述任一项所述方法的步骤。

15、在上述技术方案中,推理系统中的推理引擎可以使用其所在的计算设备上搭载的gpu作为计算资源来执行推理请求,并对gpu内存进行管理。具体地,该推理引擎可以维护用于调度推理请求集合的调度队列,并根据与该调度队列中正在执行的推理请求集合相关联的数据处理时长,确定内存管理时间窗口,后续可以计算该内存管理时间窗口内与该推理请求集合对应的gpu内存需求量,并根据该gpu内存需求量,为该推理请求集合分配gpu内存,而在该内存管理时间窗口结束后,可以重新根据与该调度队列中正在执行的推理请求集合相关联的数据处理时长,确定与该内存管理时间窗口对应的下一个内存管理时间窗口,以在下一个内存管理时间窗口内再进行gpu内存管理。

16、采用上述方式,一方面,无需在推理引擎启动时为其预留大量gpu内存,而是可以在推理引擎批量执行推理请求的过程中,不断地设置内存管理时间窗口,并预测在该内存管理时间窗口内与正在执行的推理请求集合对应的gpu内存需求量,以根据该gpu内存需求量为该推理请求集合分配gpu内存,这样不仅可以保证推理引擎在批量执行推理请求的过程中有足够的gpu内存可以使用,还可以避免gpu内存的浪费;另一方面,可以根据推理过程中的不同阶段来设置内存管理时间窗口,以及预测在所设置的内存管理时间窗口内的gpu需求量,实现推理过程中的分阶段的gpu内存管理,从而可以提高gpu内存管理的准确性和适应性。

技术特征:1.一种推理系统的内存管理方法,应用于推理系统中的推理引擎;所述推理引擎的计算资源包括用于部署所述推理引擎的计算设备上搭载的gpu;所述推理引擎维护了用于调度处于prefill阶段的推理请求集合的prefill调度队列,以及用于调度处于decode阶段的推理请求集合的decode调度队列;所述方法包括:

2.根据权利要求1所述的方法,所述根据与所述prefill调度队列中正在执行的prefill推理请求集合相关联的数据处理时长,确定prefill内存管理时间窗口,包括:

3.根据权利要求1所述的方法,所述根据与所述decode调度队列中正在执行的decode推理请求集合相关联的数据处理时长,确定decode内存管理时间窗口,包括:

4.根据权利要求1所述的方法,计算内存管理时间窗口内与推理请求集合对应的gpu内存需求量,包括:

5.根据权利要求4所述的方法,所述计算内存管理时间窗口内与推理请求集合对应的静态gpu内存使用量,包括:

6.根据权利要求4所述的方法,所述计算内存管理时间窗口内与推理请求集合对应的静态gpu内存使用量,包括:

7.根据权利要求1所述的方法,所述根据所述gpu内存需求量,为所述decode推理请求集合分配gpu内存,包括:

8.根据权利要求7所述的方法,所述gpu内存分配条件,包括:

9.根据权利要求7所述的方法,所述释放用于执行所述decode推理请求集合的gpu内存,包括:

10.一种推理系统的内存管理装置,应用于推理系统中的推理引擎;所述推理引擎的计算资源包括用于部署所述推理引擎的计算设备上搭载的gpu;所述推理引擎维护了用于调度处于prefill阶段的推理请求集合的prefill调度队列,以及用于调度处于decode阶段的推理请求集合的decode调度队列;所述装置包括:

11.一种电子设备,包括:

12.一种计算机可读存储介质,其上存储有计算机指令,该指令被处理器执行时实现如权利要求1至9中任一项所述的方法。

技术总结本申请一个或多个实施例提供一种推理系统的内存管理方法和装置,所述方法应用于推理系统中的推理引擎;所述推理引擎的计算资源包括用于部署所述推理引擎的计算设备上搭载的GPU;所述推理引擎维护了用于调度推理请求集合的调度队列;所述方法包括:根据与所述调度队列中正在执行的推理请求集合相关联的数据处理时长,确定内存管理时间窗口;计算所述内存管理时间窗口内与所述推理请求集合对应的GPU内存需求量,并根据所述GPU内存需求量,为所述推理请求集合分配GPU内存;在所述内存管理时间窗口结束时,重新根据与所述调度队列中正在执行的推理请求集合相关联的数据处理时长,确定与所述内存管理时间窗口对应的后一个内存管理时间窗口。技术研发人员:丁治强,杨统凯受保护的技术使用者:支付宝(杭州)信息技术有限公司技术研发日:技术公布日:2025/1/6本文地址:https://www.jishuxx.com/zhuanli/20250110/353210.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表