一种基于二阶循环神经网络的环境声音识别方法

- 国知局

- 2024-06-21 10:38:26

本发明涉及声学和计算机科学领域;在音频监控和机器人导航的音频场景识别中有很广的适用场景。为此提出了基于二阶循环神经网络的环境声音识别方法。

背景技术:

1、与语音识别相比,环境声音识别的声音更加复杂,因为后者往往没有特定的结构,并且在频率和时间维度的相关性上的先验知识非常有限。环境声音没有语音结构,也没有固定的节奏和旋律。环境声音识别的主要识别对象是三类声音事件,包括单一的声音(如鼠标点击),离散重复声音(如键盘打字)和稳定连续声音(如发动机引擎)。

2、环境声音识别任务通常分为以下几个步骤:数据预处理,特征提取,特征选择和聚合,分类。与语音识别不同,环境声音的预处理过程往往非常原始。因为环境音并不具有语音所具有的单词概念,所以声音的预处理一般直接作为信号处理。例如使用梅尔倒谱系数(mfcc),离散小波变换(dwt),伽马特征图(gammatone-spectrogram),梅尔特征图(mel-spectrogram),过零率(zcr)等。或者对于原始声音直接进行特征提取,这种端到端(end-to-end)的训练方法在近些年来也不断变得流行。

3、近年来随着深度学习的快速发展,深度神经网络(dnn),卷积神经网络(cnn)相比于传统机器学习模型变现出更好的性能。相比于传统方法,深度学习方法可以更加灵活的选择特征。卷积神经网络可以从低维特征中提取高级特征,提高分类精度。循环神经网络(rnn)能够对具有时间特性的序列数据建模。然而由于常常将提取后的声音样本当做二维图像处理,在环境声音分类中往往只会使用卷积神经网络作为模型模块,这使得声音在时间维度上的信息没有被整合到模型提取中。

技术实现思路

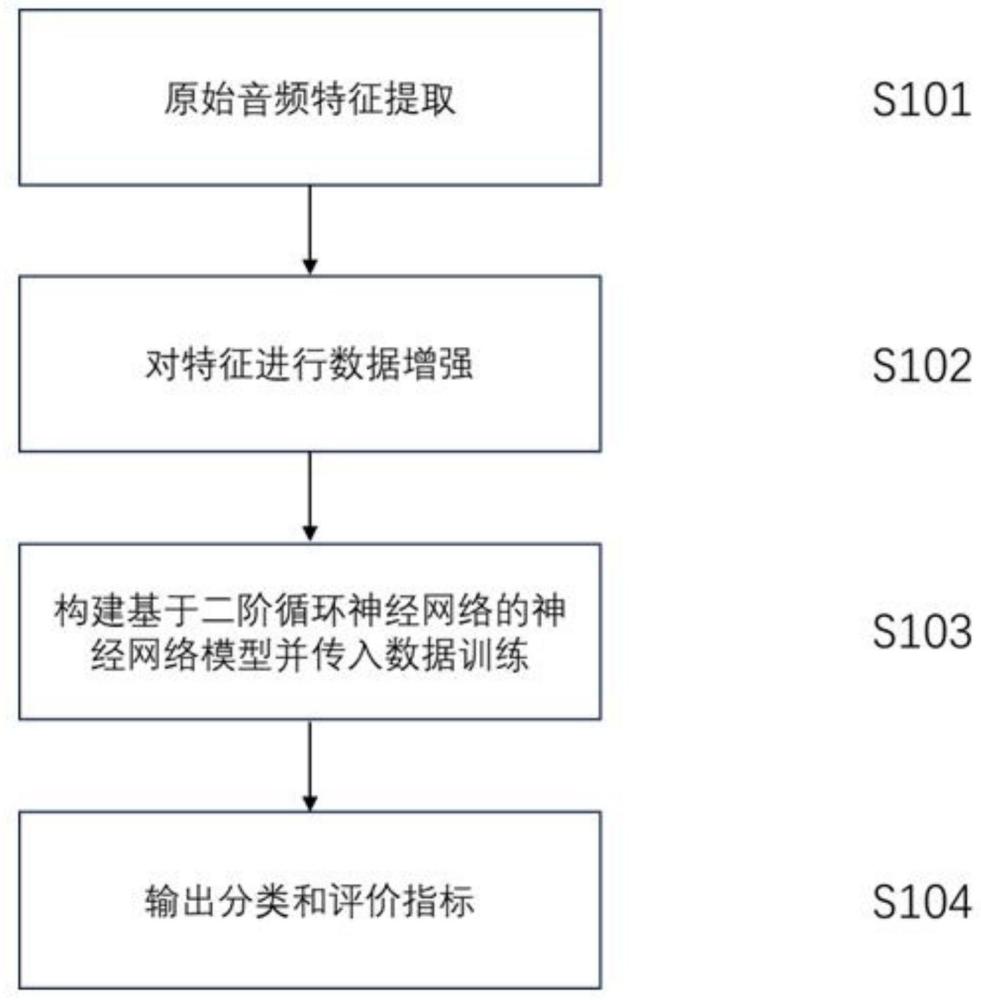

1、本发明提供了一种基于二阶循环神经网络的环境声音识别方法,其特征在于,能够解决其他卷积神经网络对环境声音提取时间维度上的信息的不足,同时捕获更多全局信息用于分类,提高分类的准确度,具体技术方案如下:

2、步骤1:构建环境声音的特征提取模块,具体步骤如下:

3、步骤1.1:把环境声音表示成时间序列x[n],0≤n≤n,其中n=fstx,fs是采样频率,tx是音频信号长度;

4、步骤1.2:用大小为ws的窗口对样本点分帧,共计划分出帧,其中n表示样本点总数,每一帧内含有ws个样本点;用窗函数w[n]对上述每一帧加窗,加窗后的样本点可以看成一个周期信号;

5、步骤1.3:用频率依次为的基信号对第j(1≤j≤nf)帧进行滤波,用公式可以表示为对复数xj[k]取模可以得到第j帧频率为ωk的能量ej[k],e表示自然常数,i2=-1;对第j帧频率为ωk的能量ej[k]按照频率维度拼接,可以得到第j帧的能量分布ej,其中ej=[ej[0],ej[1],...,ej[n-1]]t;

6、步骤1.4:按帧顺序拼接每一帧的能量分布ej形成频谱图s(ω,f),其中s(ω,f)=[e1,e2,e3,...,enf];

7、步骤1.5:将s(ω,f)通过梅尔滤波器生成梅尔频谱图,对s(ω,f)中的频率ω,根据公式将其转化为梅尔刻度的频率表示,其中是梅尔刻度的频率,转化后的频谱图称为梅尔频谱图

8、步骤2:构建对原数据集进行扩充的数据增强模块,具体步骤如下:

9、步骤2.1:选取数据集d中两个样本和yi,yj表示这两个样本的标签;

10、步骤2.2:设置混合比例λ,0≤λ≤1;

11、步骤2.3:根据混合公式生成混合梅尔频谱图以及根据公式yi,j=(1-λ)yi+λyj生成的标签yi,j;

12、步骤2.4:对数据集d中任意相邻两个样本进行一次上述步骤2.1至步骤2.3的混合操作,所生成的所有混合样本构成一个大小为|d|-1的混合集dmix,其中|d|表示数据集d的样本数量;混合数据集d和dmix构成新的扩充数据集

13、步骤3:构建基于二阶循环神经网络的序列模型,输入梅尔频谱图通过二阶循环神经网络,输出和输入相同维度的序列数据二阶循环神经网络是在普通神经网络的基础上改进的模型,其聚合了更多时序信息,二阶循环神经网络的计算公式如下:

14、ot=soft max(wo·ht+bo)

15、其中的ht,ht-1和ht-2分别表示t时刻,t-1时刻和t-2时刻隐藏单元的输出;ot表示t时刻的输出;xt表示t时刻的输入,是根据步骤1.4和步骤1.5,对梅尔频谱图取第t帧所得能量et,1≤t≤nf;wx,和wo分别表示不同的权重向量;bh和bo表示隐藏单元的偏置和输出单元的偏置;f表示一种激活函数,最常用的激活函数是σ函数。更进一步地,二阶lstm神经网络分为遗忘门,输入门和输出门,构建的步骤具体如下:

16、步骤3.1:根据步骤1.4和步骤1.5所述梅尔频谱图定义,将梅尔频谱图按照帧拆分成序列输入xt,1≤t≤nf,将序列通过遗忘门,遗忘门公式如下:

17、

18、其中xt表示t时刻的输入;ht-1和ht-2分别表示t-1时刻和t-2时刻隐藏单元的输出;wfx,和分别表示可训练的权重矩阵;bf表示偏置项;σ表示激活函数是sigmod函数;ft表示t时刻遗忘门的计算结果;

19、步骤3.2:根据步骤1.4和步骤1.5所述梅尔频谱图定义,将梅尔频谱图按照帧拆分成序列输入xt,1≤t≤nf,将序列通过输入门,输入门公式如下:

20、

21、

22、ct=ct-1 ft+ct it

23、在第一个公式中xt表示t时刻的输入;ht-1和ht-2分别表示t-1时刻和t-2时刻隐藏单元的输出;wix,和分别表示可训练的权重矩阵;bi表示偏置项;σ表示激活函数是sigmod函数;it表示t时刻输入门的中间结果;

24、在第二个公式中xt表示t时刻的输入;ht-1和ht-2分别表示t-1时刻和t-2时刻隐藏单元的输出;wcx,和分别表示可训练的权重矩阵;bc表示偏置项;ct表示t时刻输入门的中间结果;

25、对遗忘门的结果ft和输入门的结果it分别加权,ct-1,ct表示记忆的占比,最后得到输入门的输出ct;

26、步骤3.3:根据步骤1.4和步骤1.5所述梅尔频谱图定义,将梅尔频谱图按照帧拆分成序列输入xt,1≤t≤nf,将序列通过输出门,输出门公式如下:

27、

28、ht=ot tanh(ct)

29、其中xt表示t时刻的输入;ht-1和ht-2分别表示t-1时刻和t-2时刻隐藏单元的输出;wox,和分别表示可训练的权重矩阵;bo表示偏置项;σ表示激活函数是sigmod函数;ht表示t时刻的隐藏层输出;

30、步骤3.4:将不同时刻的隐藏层输出ht按照时间顺序拼接,得到和输入的梅尔频谱图维度相同的序列数据其中

31、步骤4:构建带有全局注意力机制的注意力模块,构建音频分类器模块,生成评价指标,具体包括以下步骤:

32、步骤4.1:将二阶循环神经网络的输出作为输入,依次通过第一个线性层(线性层1),一个dropout层,一个tanh激活函数,第二个线性层(线性层2),一个softmax激活函数;其中输入维度可以表示为df,分别表示帧数的维度和频率的维度,线性层1的输入维度为df,输出维度为df,dropout层选用了0.5的参数设置,线性层2的输入维度为df,输出维度为1;上述过程可用如下公式表述:

33、

34、其中w1∈ddf×df,w2∈ddf×1表示可训练的线性层权重,表示可训练的线性层偏置,是频率的注意力向量,其维度是

35、步骤4.2:将二阶循环神经网络的输出作为输入,首先对其进行矩阵转置,然后依次通过第一个线性层(线性层3),一个dropout层,一个tanh激活函数,第二个线性层(线性层4),一个softmax激活函数;其中输入的维度可以表示为df,分别表示帧数的维度和频率的维度,线性层1的输入维度为输出维度为dropout层选用了0.5的参数设置,线性层2的输入维度为输出维度为1;上述过程可用如下公式表述:

36、

37、其中表示可训练的线性层权重,表示可训练的线性层偏置,attf是帧(时间)的注意力向量,其维度是1×df;

38、步骤4.3:将二阶循环神经网络的输出和频率的注意力向量做元素矩阵乘法,并将结果根据帧的维度相加求和,得到频率向量将二阶循环神经网络的输入做矩阵转置,转置后的矩阵和帧的注意力向量attf做元素矩阵乘法,并将此结果根据帧(时间)的维度相加求和,得到帧向量vecf∈1×df,

39、步骤4.4:将频率向量和帧向量vecf做笛卡尔积,生成全局注意力矩阵attg,

40、步骤4.5:展平全局注意力矩阵attg,使其成为向量形式

41、步骤4.6:以步骤4.5的输出vecg作为输入,通过一个由全连接层构成的分类器,分类器的输入维度是输出维度是分类任务的目标类别数dt;这一过程可以用公式表示,其中表示全连接层的权重,b∈dt×1表示全连接层的偏置,表示预测的标签值;

42、步骤4.7:以步骤4.6的输出以及样本真是标签y作为输入,损失函数选择交叉熵函数来计算模型的损失,反向传播损失使模型在验证集上的准确率最高,保存最佳模型参数。

43、本发明提供的技术方案带来的有益效果至少包括:

44、本发明对原音频数据集进行了扩充,事实证明混合增强的效果非常拔群;构建了二阶循环神经网络用于聚合时序信息,对时间维度的信息提炼程度相比于普通的一阶循环神经网络展现出更好的效果;在循环神经网络的基础上应用了全局注意力机制,在时间和频率维度上分别提炼信息,最后融合。针对仅用卷积处理环境声音的现状,本发明利用循环神经网络的时序性,更好的提取了信息,获得了更高的准确性。相对于重量型的卷积模型,本发明的参数量和网络规模都非常小。

本文地址:https://www.jishuxx.com/zhuanli/20240618/20864.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表