一种定制化语音生成方法、装置、设备及可读介质与流程

- 国知局

- 2024-06-21 11:29:47

本申请涉及语音合成,具体涉及一种定制化语音生成方法、装置、设备及可读介质。

背景技术:

1、语音合成(text-to-speech,tts)是指根据文本序列合成语音波形,也就是让设备根据相应的输入文本发出语音,近年来,语音合成技术高速发展,摆脱了传统方法冗杂的合成流程,不再依赖高度专业的文法、词法特征提取,而是将原始文本经过神经网络转成梅尔谱,再将梅尔谱转成声音波形,实现了端到端的语音合成系统,所合成的语音质量近似人声,其在人工智能行业有着非常重要的应用,比如语音助手和各种场景的翻译、有声读物、新闻播报、ai电话和ai主播等。

2、当前语音合成技术,语音数据集中通常包括目标说话人数小时甚至数十小时的语音音频,才能训练得到目标说话人的音色。这就导致了不能对说话人的音色进行个性化定制。

3、因此,亟需一种定制化语音生成方法、装置、设备及可读介质。

技术实现思路

1、为此,本申请提供一种定制化语音生成方法、装置、设备及可读介质,以解决现有技术中由于所需语音数据集数据量大而导致的难以个性化定制的问题。

2、为了实现上述目的,本申请第一方面提供一种定制化语音生成方法,包括:

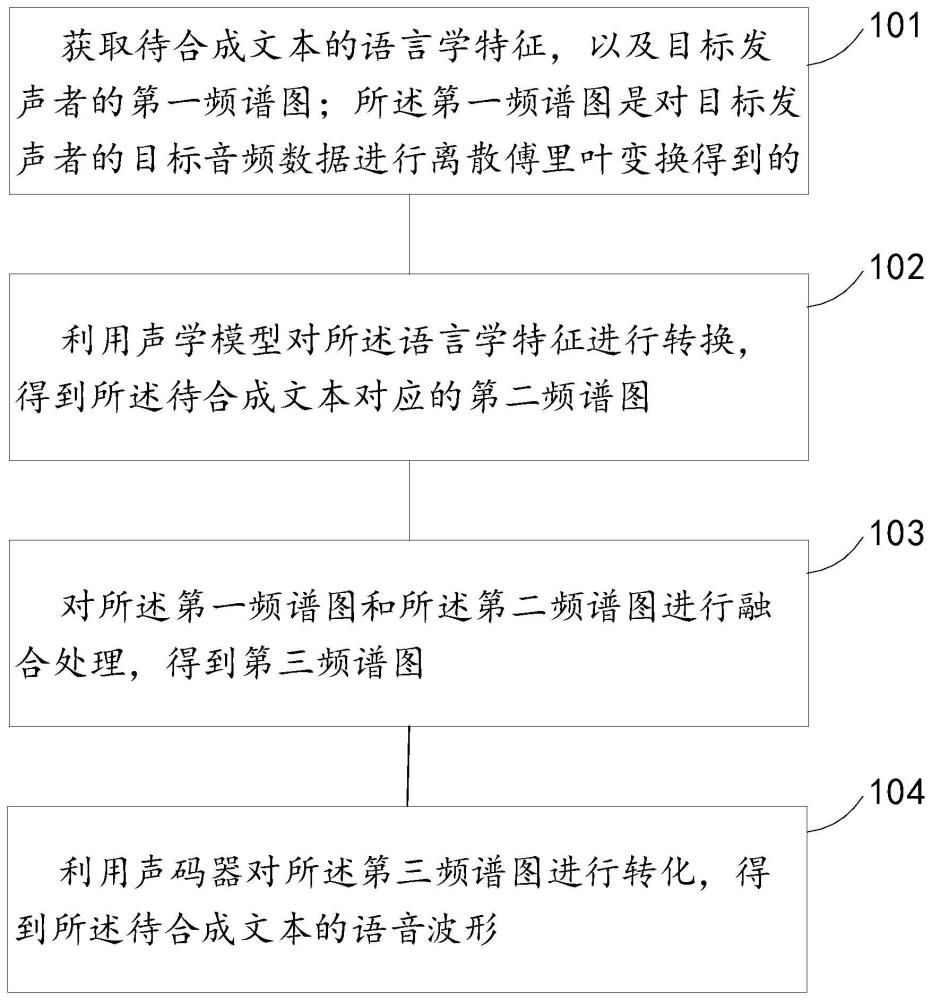

3、获取待合成文本的语言学特征,以及目标发声者的第一语谱图;所述第一语谱图是对所述目标发声者的目标音频数据进行离散傅里叶变换得到的;

4、利用声学模型对所述语言学特征进行转换,得到所述待合成文本对应的第二语谱图;

5、对所述第一语谱图和所述第二语谱图进行融合处理,得到第三语谱图;

6、利用声码器对所述第三语谱图进行转化,得到所述待合成文本的语音波形。

7、可选的,在所述获取待合成文本的语言学特征,以及目标发声者的第一语谱图之前,还包括:

8、获取针对所述目标发声者采集的目标音频数据;

9、对所述目标音频数据进行断句拆分处理,得到多条语音片段数据;

10、针对每个所述语音片段数据,将所述语音片段数据作为一个整体进行离散傅里叶变换,得到所述语音片段数据对应的第四语谱图,得到频谱集合;

11、对所述频谱集合中的多个所述第四语谱图进行叠加融合操作,得到所述目标发声者的所述第一语谱图。

12、可选的,所述对所述频谱集合中的多个所述第四语谱图进行叠加融合操作,得到所述目标发声者的所述第一语谱图,具体包括:

13、若所述第四语谱图对应的时长不等于预设时长,则对所述第四语谱图的时长进行调节,得到处理后第四语谱图;所述处理后第四语谱图的时长等于所述预设时长;

14、根据所述处理后第四语谱图进行叠加融合操作,得到所述目标发声者的所述第一语谱图。

15、可选的,所述对所述频谱集合中的多个所述第四语谱图进行叠加融合操作,得到所述目标发声者的所述第一语谱图,具体包括:

16、计算多个所述第四语谱图中相同位置的像素值的平均值,得到所述第一语谱图中该位置的像素值。

17、可选的,所述对所述第一语谱图和所述第二语谱图进行融合处理,得到第三语谱图,具体包括:

18、计算所述第一语谱图和所述第二语谱图中相同位置的像素值的加权平均值,得到所述第三语谱图中该位置的像素值。

19、可选的,在所述获取待合成文本的语言学特征,以及目标发声者的第一语谱图之前,还包括:

20、获取待朗读图像;

21、利用文字识别模型对待识别图像进行文字识别,得到所述待合成文本;其中,所述文字识别模型的第一样本图片是根据所述第一样本图片中文本的朗读发音进行标注的。

22、可选的,在所述利用文字识别模型对待识别图像进行文字识别,得到所述待合成文本之前,还包括:

23、利用目标检测模型,识别所述待朗读图像的待朗读文字区域;其中,所述目标检测模型为采用偶数卷积核的深度学习模型;所述目标检测模型的第二样本图片中包括用于表示待朗读文字区域的第一标签,和/或,表示非朗读文字区域的第二标签;

24、所述利用文字识别模型对待识别图像进行文字识别,得到所述待合成文本,具体包括:

25、利用文字识别模型对所述待朗读文字区域进行文字识别,得到所述待合成文本。

26、可选的,所述第一语谱图、所述第二语谱图和所述第三语谱图均为语谱图。

27、可选的,所述第一语谱图、所述第二语谱图和所述第三语谱图均为梅尔语谱图。

28、第二方面,本申请实施例提供了一种定制化语音生成装置,包括:

29、获取模块,用于获取待合成文本的语言学特征,以及目标发声者的第一语谱图;所述第一语谱图是对所述目标发声者的目标音频数据进行离散傅里叶变换得到的;

30、频谱转换模块,用于利用声学模型对所述语言学特征进行转换,得到所述待合成文本对应的第二语谱图;

31、第一融合模块,用于对所述第一语谱图和所述第二语谱图进行融合处理,得到第三语谱图;

32、波形转换模块,用于利用声码器对所述第三语谱图进行转化,得到所述待合成文本的语音波形。

33、第三方面,本申请实施例提供了一种电子设备,包括:

34、一个或多个处理器;

35、存储器,其上存储有一个或多个程序,当所述一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现上述的定制化语音生成方法;

36、一个或多个i/o接口,连接在所述处理器与存储器之间,配置为实现所述处理器与存储器的信息交互。

37、第四方面,本申请实施例提供了一种计算机可读介质,其上存储有计算机程序,所述程序被处理器执行时实现上述的定制化语音生成方法。

38、本说明书实施例中,首先获取对目标发声者的目标音频数据进行离散傅里叶变换得到的第一语谱图,进而将目标发声者的第一语谱图,与所述待合成文本对应的第二语谱图进行融合处理,得到同时反映目标发声者的音色和待合成文本的第三语谱图;从而使得根据所述第三语谱图转化得到的语音波形,能够反映目标发声者的音色。由于目标发声者的第一语谱图可以根据目标发声者的少量语音文件即可得到,由此可以根据目标发声者的少量语音文件,实现语音的定制化。

技术特征:1.一种定制化语音生成方法,其特征在于,包括:

2.如权利要求1所述的方法,其特征在于,在所述获取待合成文本的语言学特征,以及目标发声者的第一语谱图之前,还包括:

3.如权利要求2所述的方法,其特征在于,所述对所述频谱集合中的多个所述第四语谱图进行叠加融合操作,得到所述目标发声者的所述第一语谱图,具体包括:

4.如权利要求2所述的方法,其特征在于,所述对所述频谱集合中的多个所述第四语谱图进行叠加融合操作,得到所述目标发声者的所述第一语谱图,具体包括:

5.如权利要求1所述的方法,其特征在于,所述对所述第一语谱图和所述第二语谱图进行融合处理,得到第三语谱图,具体包括:

6.如权利要求1所述的方法,其特征在于,在所述获取待合成文本的语言学特征,以及目标发声者的第一语谱图之前,还包括:

7.如权利要求6所述的方法,其特征在于,在所述利用文字识别模型对待识别图像进行文字识别,得到所述待合成文本之前,还包括:

8.如权利要求1-7中任意一项所述的方法,其特征在于,

9.一种定制化语音生成装置,其特征在于,包括:

10.一种电子设备,其特征在于,包括:

11.一种计算机可读介质,其上存储有计算机程序,所述程序被处理器执行时实现根据权利要求1-8中任意一项所述的方法。

技术总结本申请公开了一种定制化语音生成方法、装置、设备及可读介质,属于语音合成技术领域。该方案包括:获取待合成文本的语言学特征,以及目标发声者的第一语谱图;所述第一语谱图是对所述目标发声者的目标音频数据进行离散傅里叶变换得到的;利用声学模型对所述语言学特征进行转换,得到所述待合成文本对应的第二语谱图;对所述第一语谱图和所述第二语谱图进行融合处理,得到第三语谱图;利用声码器对所述第三语谱图进行转化,得到所述待合成文本的语音波形。该方案能够根据目标发声者的少量语音文件,实现语音的定制化。技术研发人员:何鑫,王涛,张博伦受保护的技术使用者:中国联合网络通信集团有限公司技术研发日:技术公布日:2024/2/21本文地址:https://www.jishuxx.com/zhuanli/20240618/21847.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表