基于深度学习的音频话者分离方法与流程

- 国知局

- 2024-06-21 11:30:10

本发明涉及音频处理,尤其涉及一种基于深度学习的音频话者分离方法。

背景技术:

1、在多人语音通信或多人会议中,混合音频中包含多个说话者的声音,这会导致语音识别和语音分析任务变得更加复杂。目前再从混合音频中准确地分离不同说话者的声音,以便更好地理解和处理语音数据中,通常依赖于信号处理技术,如独立成分分析和盲源分离。然而,这些方法在复杂的环境中表现不佳,影响音频话者分离效果。

技术实现思路

1、本发明的目的在于提供一种基于深度学习的音频话者分离方法,旨在解决现有技术中的在复杂的环境中音频话者分离效果不佳的技术问题。

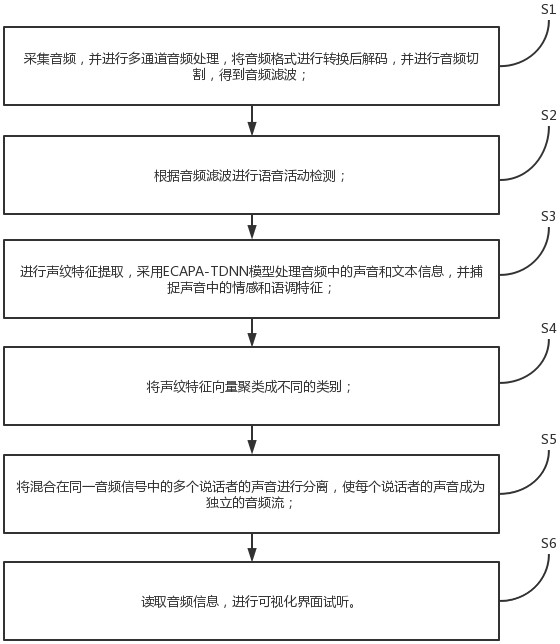

2、为实现上述目的,本发明采用的一种基于深度学习的音频话者分离方法,包括如下步骤:

3、采集音频,并进行多通道音频处理;

4、根据音频滤波进行语音活动检测;

5、进行声纹特征提取;

6、将声纹特征向量聚类成不同的类别;

7、将混合在同一音频信号中的多个说话者的声音进行分离,使每个说话者的声音成为独立的音频流;

8、读取音频信息,进行可视化界面试听。

9、其中,在采集音频,并进行多通道音频处理的步骤中:

10、将音频格式进行转换后解码,并进行音频切割,得到音频滤波。

11、其中,在根据音频滤波进行语音活动检测的步骤中:

12、设定能量阈值;

13、对音频滤波进行特征提取,得到音频滤波的能量值;

14、对比能量值和能量阈值,当能量值超过能量阈值,判断该音频为语音。

15、其中,在将声纹特征向量聚类成不同的类别的步骤中:

16、切割音频,根据能量值和能量阈值的对比结果,在音频中按照语音活动起止时刻进行切割,得到多条音频片段;

17、对音频片段进行特征提取,对切割后的多条音频片段分别进行声纹特征的提取,并将提取到的特征进行标准化处理;

18、对特征数据进行聚类操作;

19、输出结果。

20、其中,在对特征数据进行聚类操作的步骤中:

21、将声纹特征向量分成不同的簇或类别,每个簇代表一个声纹身份,确保相同个体的声纹特征向量被分到同一个簇中,不同个体的声纹特征向量被分到不同簇中。

22、其中,在输出结果的步骤中:

23、将声纹身份与其对应的簇标签关联,并存储。

24、其中,在进行声纹特征提取的步骤中:

25、采用ecapa-tdnn模型处理音频中的声音和文本信息,并捕捉声音中的情感和语调特征。

26、本发明的一种基于深度学习的音频话者分离方法,通过采集音频,并进行多通道音频处理;根据音频滤波进行语音活动检测;进行声纹特征提取;将声纹特征向量聚类成不同的类别;将混合在同一音频信号中的多个说话者的声音进行分离,使每个说话者的声音成为独立的音频流;读取音频信息,进行可视化界面试听;实现了提高在复杂的环境中音频话者分离效果。

技术特征:1.一种基于深度学习的音频话者分离方法,其特征在于,包括如下步骤:

2.如权利要求1所述的基于深度学习的音频话者分离方法,其特征在于,在采集音频,并进行多通道音频处理的步骤中:

3.如权利要求1所述的基于深度学习的音频话者分离方法,其特征在于,在根据音频滤波进行语音活动检测的步骤中:

4.如权利要求3所述的基于深度学习的音频话者分离方法,其特征在于,在将声纹特征向量聚类成不同的类别的步骤中:

5.如权利要求4所述的基于深度学习的音频话者分离方法,其特征在于,在对特征数据进行聚类操作的步骤中:

6.如权利要求5所述的基于深度学习的音频话者分离方法,其特征在于,在输出结果的步骤中:

7.如权利要求1所述的基于深度学习的音频话者分离方法,其特征在于,在进行声纹特征提取的步骤中:

技术总结本发明涉及音频处理技术领域,具体涉及一种基于深度学习的音频话者分离方法;采集音频,并进行多通道音频处理;根据音频滤波进行语音活动检测;进行声纹特征提取;将声纹特征向量聚类成不同的类别;将混合在同一音频信号中的多个说话者的声音进行分离,使每个说话者的声音成为独立的音频流;读取音频信息,进行可视化界面试听,通过上述方式,实现了提高在复杂的环境中音频话者分离效果。技术研发人员:薛凯翔,丁卓受保护的技术使用者:南京龙垣信息科技有限公司技术研发日:技术公布日:2024/2/25本文地址:https://www.jishuxx.com/zhuanli/20240618/21903.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。