一种基于人脸唇动语音分离的声纹识别方法及装置与流程

- 国知局

- 2024-06-21 11:44:46

本发明涉及数据处理,具体涉及一种基于人脸唇动语音分离的声纹识别方法及装置。

背景技术:

1、现实中经常存在多人同时说话的场景,这时往往需要获取其中一个人的干净语音来进行声纹识别。一种比较典型的场景是,有一台支持语音交互的设备,用户与设备进行交互前需要进行多模态的身份识别,在使用中设备也需要提取目标用户的语音从而进行语音交互流程,但是周围环境存在各种背景噪音,也包括其他人说话的声音,无法直接使用原始录音进行声纹识别来判定身份信息。这些场景需要通过自动化的语音分离来获取干净的个人语音。

2、目前的语音分离方法依赖于音频流,会使用多个麦克风来促进分离,但对于单通道语音,目前还没有很好的语音分离方法。

技术实现思路

1、有鉴于此,有必要提供一种基于人脸唇动语音分离的声纹识别方法及装置,用以解决多人同时说话的场景下单通道语音难以进行语音分离的技术问题。

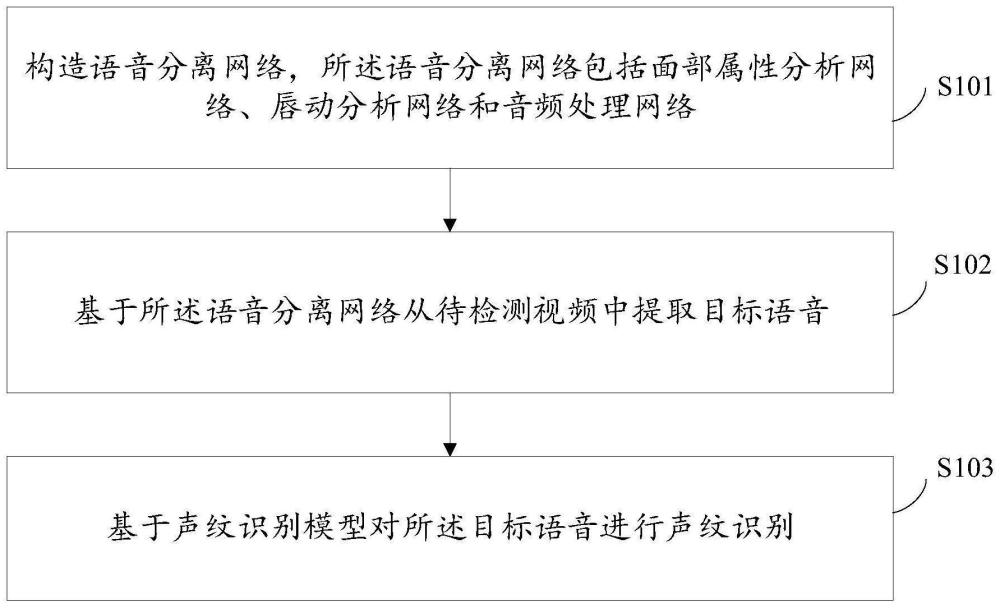

2、为了实现上述目的,本发明提供了一种基于人脸唇动语音分离的声纹识别方法,包括:

3、构造语音分离网络,所述语音分离网络包括面部属性分析网络、唇动分析网络和音频处理网络;

4、基于所述语音分离网络从待检测视频中提取目标语音;

5、基于声纹识别模型对所述目标语音进行声纹识别;

6、其中,所述面部属性分析网络提取面部属性特征,所述唇动分析网络用于提取嘴唇运动特征,所述音频处理网络用于进行语音分离,所述声纹识别模型是基于注册语音训练得到的。

7、进一步地,所述语音分离网络的训练方式包括:

8、将第一说话人对应的第一视频和第二说话人对应的第二视频混合,得到第一混合视频,将所述第一说话人对应的第三视频和所述第二说话人对应的第二视频混合,得到第二混合视频;

9、将所述第一混合视频和所述第二混合视频分别转换为复数音频频谱,并基于复数理想比率掩膜,从所述复数音频频谱中提取所述第一说话人对应的语音和所述第二说话人对应的语音。

10、进一步地,所述语音分离网络训练时的损失函数基于以下公式确定:

11、l=lmask-prediction+λ1lcross-modal+λ2lconsistency

12、其中,l表示所述语音分离网络训练时的损失函数,lmask-prediction表示掩码预测损失,lcross-modal表示跨模态匹配损失,lconsistency表示说话人一致性损失,λ1表示所述跨模态匹配损失的权重,λ2表示所述说话人一致性损失的权重。

13、进一步地,所述掩码预测损失基于以下公式确定:

14、

15、其中,lmask-prediction表示所述掩码预测损失,表示用于从所述第一混合视频转换得到的复数音频频谱中提取所述第一说话人对应的语音的复数理想比率掩膜,表示用于从所述第二混合视频转换得到的复数音频频谱中提取所述第一说话人对应的语音的复数理想比率掩膜,表示用于从所述第一混合视频转换得到的复数音频频谱中提取所述第二说话人对应的语音的复数理想比率掩膜,表示用于从所述第二混合视频转换得到的复数音频频谱中提取所述第二说话人对应的语音的复数理想比率掩膜,∥·∥2表示l2范数运算。

16、进一步地,所述跨模态匹配损失基于以下公式确定:

17、

18、lt(a,i+,i-)=max{0,d(a,i+)-d(a,i-)+m}

19、

20、其中,lcross-modal表示所述跨模态匹配损失,lt(·)表示三重态损失函数,表示所述音频处理网络从所述第一混合视频转换得到的复数音频频谱中提取的所述第一说话人对应的音频嵌入,表示所述音频处理网络从所述第二混合视频转换得到的复数音频频谱中提取的所述第一说话人对应的音频嵌入,表示所述音频处理网络从所述第一混合视频转换得到的复数音频频谱中提取的所述第二说话人对应的音频嵌入,表示所述音频处理网络从所述第二混合视频转换得到的复数音频频谱中提取的所述第二说话人对应的音频嵌入,ia表示所述面部属性分析网络提取的所述第一说话人对应的面部图像嵌入,ib表示所述面部属性分析网络提取的所述第二说话人对应的面部图像嵌入,x(a,i)表示嵌入a和嵌入i的余弦距离,m表示嵌入a和嵌入i的余弦距离之间的裕度,φ(·)表示残差网络,1表示所述第一混合视频转换得到的复数音频频谱,d2表示所述第二混合视频转换得到的复数音频频谱,表示用于从所述第一混合视频转换得到的复数音频频谱中提取所述第一说话人对应的语音的复数理想比率掩膜,表示用于从所述第二混合视频转换得到的复数音频频谱中提取所述第一说话人对应的语音的复数理想比率掩膜,表示用于从所述第一混合视频转换得到的复数音频频谱中提取所述第二说话人对应的语音的复数理想比率掩膜,表示用于从所述第二混合视频转换得到的复数音频频谱中提取所述第二说话人对应的语音的复数理想比率掩膜。

21、进一步地,所述说话人一致性损失基于以下公式确定:

22、

23、lt(a,i+,i-)=max{0,d(a,i+)-d(a,i-)+m}

24、

25、其中,lconsistency表示所述说话人一致性损失,lt(·)表示三重态损失函数,aa1表示所述音频处理网络从所述第一混合视频转换得到的复数音频频谱中提取的所述第一说话人对应的音频嵌入,表示所述音频处理网络从所述第二混合视频转换得到的复数音频频谱中提取的所述第一说话人对应的音频嵌入,表示所述音频处理网络从所述第一混合视频转换得到的复数音频频谱中提取的所述第二说话人对应的音频嵌入,表示所述音频处理网络从所述第二混合视频转换得到的复数音频频谱中提取的所述第二说话人对应的音频嵌入,d(a,i)表示嵌入a和嵌入i的余弦距离,m表示嵌入a和嵌入i的余弦距离之间的裕度,φ(·)表示残差网络,x1表示所述第一混合视频转换得到的复数音频频谱,x2表示所述第二混合视频转换得到的复数音频频谱,表示用于从所述第一混合视频转换得到的复数音频频谱中提取所述第一说话人对应的语音的复数理想比率掩膜,表示用于从所述第二混合视频转换得到的复数音频频谱中提取所述第一说话人对应的语音的复数理想比率掩膜,表示用于从所述第一混合视频转换得到的复数音频频谱中提取所述第二说话人对应的语音的复数理想比率掩膜,表示用于从所述第二混合视频转换得到的复数音频频谱中提取所述第二说话人对应的语音的复数理想比率掩膜。

26、进一步地,所述基于声纹识别模型对所述目标语音进行声纹识别,包括:

27、对所述目标语音进行预处理,并提取预处理后的所述目标语音的梅尔倒谱系数特征;

28、基于所述声纹识别模型和所述预处理后的所述目标语音的梅尔倒谱系数特征,对所述目标语音进行声纹识别。

29、本发明还提供了一种基于人脸唇动语音分离的声纹识别装置,包括:

30、构造模块,用于构造语音分离网络,所述语音分离网络包括面部属性分析网络、唇动分析网络和音频处理网络;

31、提取模块,用于基于所述语音分离网络从待检测视频中提取目标语音;

32、识别模块,用于基于声纹识别模型对所述目标语音进行声纹识别;

33、其中,所述面部属性分析网络提取面部属性特征,所述唇动分析网络用于提取嘴唇运动特征,所述音频处理网络用于进行语音分离,所述声纹识别模型是基于注册语音训练得到的。

34、本发明还提供了一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,处理器执行程序时,实现如上所述的基于人脸唇动语音分离的声纹识别方法。

35、本发明还提供了一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现如上所述的基于人脸唇动语音分离的声纹识别方法。

36、与现有技术相比,本发明的有益效果包括:通过构造包含面部属性分析网络、唇动分析网络和音频处理网络的语音分离网络,对待检测视频进行基于人脸唇动的语音分离,提取目标语音,然后根据声纹识别模型对目标语音进行声纹识别,实现了多人说话场景下的单通道语音分离,提高了语音分离的灵活性。

本文地址:https://www.jishuxx.com/zhuanli/20240618/23314.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

上一篇

一种语音控制方法及系统

下一篇

返回列表