一种基于脑电的想象语音解码方法与流程

- 国知局

- 2024-06-21 11:56:16

本发明属于脑机接口,涉及从神经信号中解码想象语音,具体涉及一种基于脑电的想象语音解码方法。

背景技术:

1、每一年,有相当多的人因为脑中风或渐冻症丧失说话能力。对于这些患者,想象语音解码技术提供了一种潜在的沟通方式,帮助他们表达思想和需要,提高生活质量。想象语音解码指采集使用者想象发出语音(但是不产生声音和发声器官活动)时的神经信号,对数据进行分析处理后解码出使用者想说出的语音。基于想象语音解码技术的脑机接口(brain-computer interface,bci)系统的优势在于发声想象是一个直觉的自发的过程,它是最为接近日常生活中口头交流的一种形式,而且语音中包含着大量丰富的信息,通过解码想象的不同语音可以产生种类丰富的输出指令。

2、近5年来,脑机接口在想象语音解码方面取得了重大的进步。人们已经可以从不能发声,但大脑认知加工基本正常的患者上通过最新的脑机接口技术直接生成他想说的话。然而,这些方法都是基于颅内电极植入(electrocorticography,ecog)的方式记录神经反应,受试者均为患有癫痫的病人,他们接受植入电极是为了定位癫痫病灶而非脑机交互,使用这种神经记录手段只适用于小部分特定人群。其次,他们采集的数据都是要求受试者在特定训练条件下完成发声或者想象发声的任务,利用深度神经网络学习从神经信号到语音表征的映射,在限定数据集的集内测试能获得不错的性能,但解码模型普遍缺乏可解释性和推广性。

3、由于脑电(electroencephalogram,eeg)记录具有便携性的优势,已有大量研究开展了基于脑电的想象语音解码。早期的工作主要是记录受试者在完成想象发声任务时的脑电,提取脑电特征并构建分类器。这类研究在分析脑电特征上具有一定的启示性,但由于分类目标局限于少数类别,当分类数量增加时,分类准确率会显著下降,仅适用于少数场景。近年来,一些工作开始直接从受试者在完成想象发声任务时的脑电预测语音声学特征,进而合成语音。这类方法能够直接合成语音,使用者能通过语音与外界进行高效且自然的交流,然而解码目标仍局限于少量词汇且从神经信号到语音特征的映射存在效果差,可解释性不足的缺点。

技术实现思路

1、有鉴于此,本发明实施例提供一种基于脑电的想象语音解码方法,以解决上述技术问题。

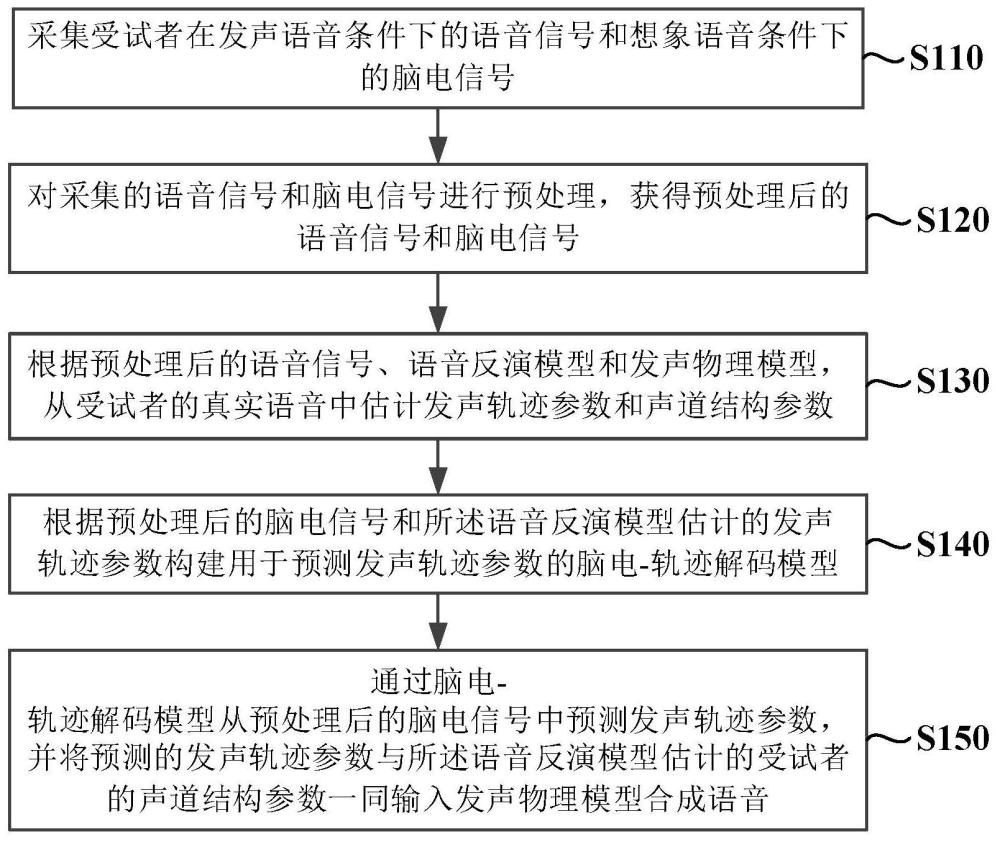

2、为实现上述目的,提供一种基于脑电的想象语音解码方法,所述方法包括如下步骤:

3、采集受试者在发声语音条件下的语音信号和想象语音条件下的脑电信号;

4、对采集的语音信号和脑电信号进行预处理,获得预处理后的语音信号和预处理后的脑电信号;

5、根据预处理后的语音信号、语音反演模型和发声物理模型,从受试者的真实语音中估计发声轨迹参数和声道结构参数;

6、根据预处理后的脑电信号和估计的发声轨迹参数构建用于预测发声轨迹参数的脑电-轨迹解码模型;

7、通过脑电-轨迹解码模型从预处理后的脑电信号中预测发声轨迹参数,并将预测的发声轨迹参数与语音反演模型估计的受试者的声道结构参数一同输入发声物理模型合成语音。

8、在一些可能的实施方式中,所述的采集受试者在发声语音条件下的语音和想象语音条件下的脑电信号,具体包括:

9、a)提供一组词语,每个词语对应一个提示文本和提示语音;

10、b)通过显示设备向受试者展示所述提示文本,并通过音频输出设备播放对应的提示语音;

11、c)指导受试者在听到提示语音后,口头说出相应的词语,以采集受试者的语音信号;

12、d)在受试者口头说出词语后,指导受试者在内心重复想象说出该词语多次,而不实际发声;

13、e)在步骤c)和步骤d)中,同步采集受试者的脑电信号;

14、f)将采集到的语音信号和脑电信号进行同步记录,以便于后续分析;

15、其中,步骤e)中采集脑电信号的过程包括使用多通道脑电图设备,将脑电电极置于受试者头皮上预定的位置;

16、其中,步骤c)和步骤d)中,受试者的语音信号采集通过麦克风完成。

17、在一些可能的实施方式中,所述的对采集的语音信号和脑电信号进行预处理,具体包括:

18、将采集的原始语音信号分段,并重采样至44100hz;

19、对重采样后的语音信号进行去除背景噪声处理;

20、对去噪后的语音信号进行响度归一化操作;

21、对采集的原始脑电数据进行平均重参考处理;

22、对重参考处理后的脑电数据进行带通滤波处理,滤波频率范围为1hz至100hz;

23、对带通滤波处理后的脑电数据进行陷波滤波处理,滤波频率范围为49hz至51hz;

24、对陷波滤波处理后的脑电数据进行下采样至200hz;

25、使用独立成分分析ica对下采样后的脑电数据去除眨眼伪迹;

26、对ica处理后的每个脑电通道数据沿时间维度进行标准化操作。

27、在一些可能的实施方式中,所述的根据预处理后的语音信号、语音反演模型和发声物理模型,从受试者的真实语音中估计发声轨迹参数和声道结构参数,具体包括:

28、在数据采样阶段,利用语音反演模型估计预处理后的受试者的语音信号所对应的发声轨迹参数和声道结构参数;将估计得到的参数输入发声物理模型中生成重构语音;

29、在模型训练阶段,基于所生成的重构语音与估计得到的发声轨迹参数和声道结构参数,对语音反演模型进行训练;

30、其中,所述发声物理模型为声道实验室vtl模型,所述vtl模型接收30维时变的发声轨迹参数和13维说话人相关的声道结构参数作为输入,以生成语音;所述语音反演模型的输入为语音的144维的对数梅尔语谱图,由特征提取模块和输出层组成,所述特征提取模块包括一个基于卷积神经网络的局部特征提取模块和一个基于conformer的序列建模模块;所述特征提取模块之后的输出层包括两个分支网络,一个分支网络用于映射为13维的声道结构参数,另一个分支网络用于逐帧映射到30维的发声轨迹参数。

31、在一些可能的实施方式中,所述基于卷积神经网络的局部特征提取模块包括一个u-net结构的二维卷积网络和一个一维卷积网络,u-net由4层残差卷积和3层反卷积组成,卷积层和反卷积层的卷积核大小均为3;所述一维卷积网络由3个堆叠的一维卷积模块构成,每个一维卷积模块包括一个一维逐点卷积层和一个一维逐通道卷积层;所述两个分支网络中,声道结构参数分支由单层隐单元数量为128的双向长短期记忆blstm网络和一个单层的全连接网络组成,发声轨迹参数分支由单层全连接网络构成的输出层组成。

32、在一些可能的实施方式中,所述网络采用多任务学习的方式优化网络参数,优化的目标函数为:

33、

34、式中,和分别表示对发音参数轨迹和声道结构参数估计的损失,均使用均方误差损失,λ是对两项损失加权的超参数。

35、在一些可能的实施方式中,所述的根据预处理后的脑电信号和估计的发声轨迹参数构建用于预测发声轨迹参数的脑电-轨迹解码模型,具体包括:

36、采集受试者的脑电信号,所述脑电信号为62通道,100hz采样率;

37、将所述脑电信号输入至一个特征提取模块,所述特征提取模块包括一个基于卷积神经网络的局部特征提取模块和一个基于conformer的序列建模模块,其中所述卷积神经网络模块包括三层一维卷积神经网络,每层卷积神经网络的卷积核大小为3;

38、在所述脑电信号特征通过所述卷积神经网络模块处理后,加入一个额外的分类令牌,并添加位置编码,然后输入至所述基于conformer的序列建模模块,所述基于conformer的序列建模模块包括3个堆叠的conformer模块;

39、通过两个分支网络处理所述基于conformer的序列建模模块的输出,所述两个分支网络均由单层全连接网络构成,其中一个分支网络用于输出分类token的类别,另一个分支网络用于将conformer模块输出的特征逐帧映射到30维的发声轨迹参数;

40、采用多任务学习方式优化网络参数,所述优化包括最小化一个目标函数,所述目标函数为:

41、

42、式中,和分别表示发声轨迹参数的均方误差损失和分类的交叉熵损失函数,是对两项损失加权的超参数。

43、在一些可能的实施方式中,所述的发声轨迹参数作为金标准训练脑电-轨迹解码模型,用于在想象语音阶段没有语音产生的条件下,通过受试者的脑电信号预测发声轨迹参数;所述的超参数λ通过验证集上的性能评估来确定,以实现发声轨迹参数预测和分类任务之间的最优权衡。

44、在一些可能的实施方式中,所述的通过脑电-轨迹解码模型从预处理后的脑电信号中预测发声轨迹参数,并将预测的发声轨迹参数与语音反演模型估计的受试者的声道结构参数一同输入发声物理模型合成语音,具体包括:

45、通过脑电-轨迹解码模型从脑电信号中预测得到100hz采样率的30维发声轨迹参数;

46、将所述预测得到的30维发声轨迹参数进行插值上采样至250hz采样率;

47、获取语音反演模型估计的13维说话人相关的声道结构参数;

48、将上采样后的30维发声轨迹参数与所述13维声道结构参数一同输入到vtl模型中;

49、通过所述vtl模型合成语音。

50、在一些可能的实施方式中,所述脑电-轨迹解码模型是通过机器学习训练得到,用于将脑电信号映射到发声轨迹参数。

51、上述技术方案具有如下有益技术效果:

52、本发明实施例使用了发声特征作为预测目标,通过神经网络建立了脑电特征到发声特征的映射,符合想象发声的神经活动过程,优于现有的基于语音特征的建模方式。

53、本发明实施例使用了发声物理模型,实现了从脑电信号中预测发声特征,再生成语音的生成式解码,效果优于现有的从脑电预测梅尔谱特征,再生成语音的解码方案。

本文地址:https://www.jishuxx.com/zhuanli/20240618/24582.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表