基于跨模态语法-视觉图卷积网络的方面级情感分析方法及设备

- 国知局

- 2024-07-31 22:48:47

本发明涉及计算机感知领域,具体指一种基于跨模态语法-视觉图卷积网络的方面级情感分析方法及设备。

背景技术:

1、在当今信息爆炸的时代,情感分析成为了理解和处理用户生成内容的强有力工具。随着技术进步,情感分析从基于文本的简单形式发展到了更为复杂的方面级情感分析和多模态情感分析。方面级情感分析专注于识别和分析文本中特定方面或属性的情感倾向,提供了细致入微的情感理解方式。而多模态情感分析则结合文本、图像、声音等多种数据模态,旨在全面捕捉和解析情感信息,这不仅提升了情感分析的精准度,还拓宽了理解人类复杂情感表达的途径。

2、在实际应用场景中,文本和图像作为最常见的信息载体,经常一起出现,尤其在社交媒体、新闻报道和在线内容中十分普遍。这种文本和图像的结合,通过语言直接传达信息和情感,同时借助视觉元素来加强或补充文本内容,提供了一种更加直观和感性的情感表达。例如,社交媒体用户经常通过文字和配图的结合来分享个人经历和情绪,这种跨模态的信息展示方式,使得联合分析文本和图像变得尤为重要,因为它能提供比单一模态更加全面和深刻的理解。

3、尽管在文本方面情感分析和视觉信息分析领域,单模态研究已经取得了显著成就,但面对跨不同数据类型和分析技术的多模态方面情感分析,研究仍然面临众多挑战。目前的方法大多关注于在句子层面和图片层面上的信息融合,这一做法并没有充分挖掘文本的句法结构和图像中的局部区域等更加细粒度的信息,从而限制了对复杂情感信息的深入理解和分析。

技术实现思路

1、本发明针对现有技术在多模态方面级情感分析领域的不足,提出一种基于语法-视觉图网络的多模态方面情感分析方法及设备。

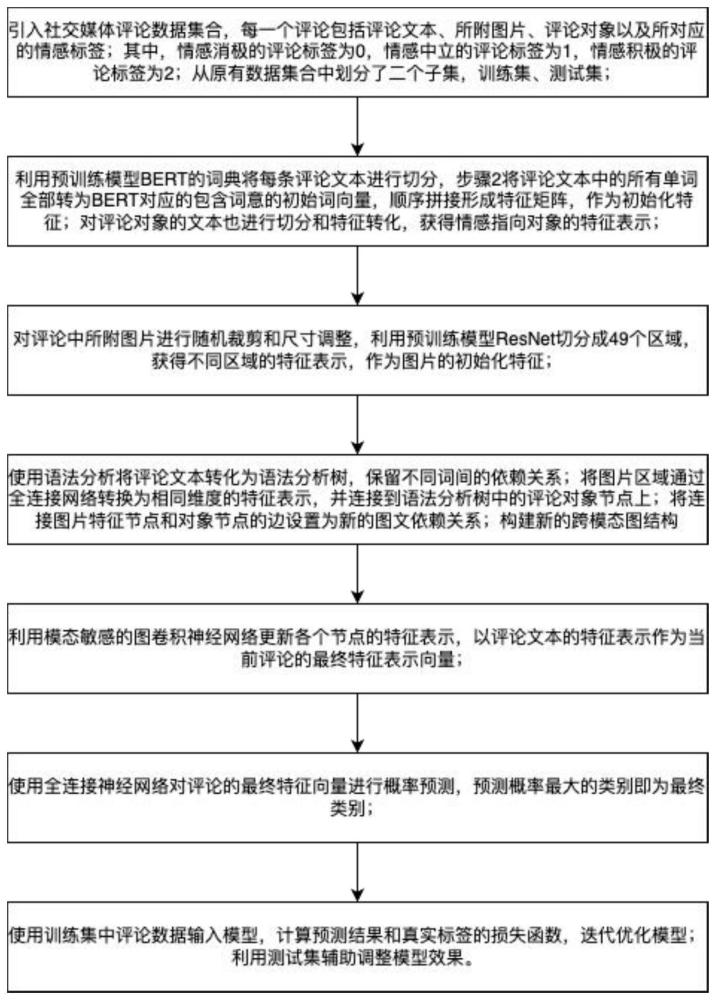

2、本发明所设计的基于跨模态语法-视觉图卷积网络的方面级情感分析方法,包括以下步骤:

3、步骤1:构建评论数据集,该数据集中每一条评论包括图片、文本、方面词和该方面词所对应的情感类别,并将数据集划分为不相交的训练集和测试集;

4、步骤2:构建深度学习模型,将训练集中图片和文本的集合作为深度学习模型的输入数据;所述方面词所对应的情感类别集合用于计算深度学习模型的损失函数,具体过程如下:

5、将所述文本和图片转换为包含有先验知识的词向量,顺序拼接形成特征矩阵,构建初始化特征;

6、将文本转换为语法分析树,更新重新分词后的特征矩阵,将图片的特征向量加入语法分析树中,与方面词直接相连;得到最终的跨模态图结构;

7、利用多层类型敏感的图卷机网络更新跨模态图结构,获得融合邻居节点信息的新特征向量;得到方面词的最终特征向量表示;

8、使用全连接神经网络对融合更新后的方面词特征向量进行类别概率预测,概率较大的可能性类型作为检测结果输出;

9、步骤3:训练深度学习模型,将数据集中评论图片、文本、方面词以及对应的情感类别输入模型,计算预测结果与真实标签的损失函数,并优化模型;将训练好的模型用于图文方面级情感分析。

10、进一步地,步骤1中方面词所对应的情感类别分为消极、中立和积极,并用不同的数字表示。

11、进一步地,步骤2所述的评论图片经过随机裁切和尺寸调整,作为模型的输入数据。以增强模型的泛化能力,提高对图片的学习效果。尺寸调整是为了配合后续resnet的输入格式。

12、进一步地,步骤2所述评论中的文本sn可以看作一系列单词拼接而成的单词序列,表示为:

13、sequencen=[wordn,1,…,wordn,i,…,wordn,s]

14、其中,sequencen表示数据集中第n个评论文本中单词拼接而成的单词序列,wordn,i(i∈[1,s])表示第n个单词序列sequencen中第i个单词;

15、所述图片经由resnet预训练模型转换为的包含有先验知识的词向量为:

16、resnet(image)={rj|rj∈r2048,j=1,2,…,49}

17、himage=wvresnet(image)

18、其中,rj表示图片中第j个子区域的特征向量表示,wv∈rd×2048用来做向量的线性变换,完成视觉空间到文本空间的维度转换;

19、himage=[r1,r2,…,r49],ri∈rd

20、其中,ri表示经过空间转换后与文本向量维度统一的图片子区域特征向量表示,维度为d;

21、所述文本经由bert预训练模型转换为的包含有先验知识的词向量为:

22、bert(sequence)={wj|wj∈rd}

23、htext=[w1,w2,…,wk],wi∈rd

24、其中,wi表示分词后第i个词的特征向量表示,维度为d;

25、所述评论的初始化特征矩阵集合为h作为模型后续的输入数据,用于模型训练;

26、h=[htext,himage]

27、更进一步地,步骤2所述将文本转换为语法分析树利用biaffineparser获得依存关系矩阵er;其中er是一个二维矩阵,其中非零元素表示存在依赖关系的节点对;

28、所述文本所有可能的依赖关系表示集合为rt,添加图片-方面词跨模态关系作为新的依赖关系集合,通过嵌入层随机生成依赖关系的初始特征向量:

29、remb=embed(rt∪{ei-t})

30、所述定义的跨模态图结构为:

31、g=(v,e)

32、v=[w1,w2,…,wk,r1,r2,…,r49]

33、其中组成图的节点由语法解析出的词组节点和图片划分后的子图片节点共同组成;

34、所述新生成的边集e由基于依赖关系矩阵er更新图片节点和方面词对应节点之间的连接关系生成,具体的更新方式可以描述为:

35、对于每个图片节点和方面词节点相连的边,都设置成新的依赖关系ei-t;

36、a为er对应的领接矩阵,其中有边的位置数值都为1,其余位置都为0。

37、再进一步地,步骤2所述类型敏感的图卷积网络,具体来说,对于每一条连接两个节点xi和xj的边,都会利用上一层神经网络中这两个节点的特征表示hi和hj,并与他们之间的依赖关系表示拼接起来计算权重:

38、

39、

40、

41、所述利用类型敏感的权重更新节点表示的计算方式为:

42、对于节点i,先合并邻居节点的特征向量和两点之间的依赖关系的特征向量:

43、

44、然后利用邻居节点和对应权重更新节点i的特征向量表示:

45、

46、其中,w和b都是当前网络层的可训练参数,σ对应relu激活函数;

47、所述最终特征向量表示是经过图卷积网络更新后方面词所对应的特征向量haspect,与预训练模型最初生成的全局表示特征向量求和:

48、houtput=haspect+hcls。

49、

50、进一步地,步骤2所述使用全连接神经网络对方面词所对应的特征向量进行概率预测,计算公式如下:

51、p(y|houtput)=softmax(wout·houtput+bout)

52、其中,p(y|houtput)表示给定方面词aspect时,预测每个情感类别的概率;wout和bout是输出层的权重和偏置;houtput是最后一个图神经网络的输出特征向量;

53、softmax函数定义为:

54、

55、其中,zi是输出层线性变换的第i个元素,分母是对所有可能类别的这种变换的指数和,确保了所有输出类别概率的和为1;

56、通过这种方式,全连接神经网络能够基于方面词的特征向量houtput,为每个可能的情感类别输出一个预测概率;最终选择预测概率最大的类别作为预测的情感类别。

57、进一步地,步骤3所述的损失函数,其公式定义如下:

58、

59、其中,c是类别的总数,yc是真实标签的one-hot编码中对应于类别c的元素,如果样本属于类别c,则yc=1;否则,yc=0;pc是模型预测样本属于类别c的概率;

60、模型优化使用adamw优化器,在adam的基础上引入了权重衰减机制,通过正则化手段限制模型权重的增长,提高模型在评论数据集数量有限情况下的泛化能力。

61、基于同一发明构思,本方案还设计了一种电子设备,包括:

62、一个或多个处理器;

63、存储装置,用于存储一个或多个程序;

64、当一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现基于跨模态语法-视觉图卷积网络的方面级情感分析方法。

65、基于同一发明构思,本方案还设计了一种计算机可读介质,其上存储有计算机程序,所述程序被处理器执行时实现基于跨模态语法-视觉图卷积网络的方面级情感分析方法。

66、本发明的优点在于:

67、文本语法分析的引入:现有的跨模态方法为了实现模态间的对齐和交互,通常将文本作为序列数据处理,而忽视了文本本身的内部结构。本方法引入了文本的语法分析,将文本序列转换为了语法分析树,显式地揭示了词与词之间的结构化连接和依赖关系,增强了模型对文本内部复杂关系的理解,而且使得模型能够更精确地识别和解析文本中的细微语义差异。这种深度的文本理解为模态间的对齐和交互提供了一个更加坚实的基础,使得跨模态分析不再仅仅依赖于表层的序列匹配,而是能够深入到文本结构的核心,捕捉更细腻和复杂的语义信息。

68、一种创新性的跨模态整合策略:通过将文本的深入语法分析与图像的关键区域相结合,设计了一种“语法-视觉图”的整合式图结构。在这一结构中,图像的关键区域不再是孤立的元素,而是作为新的节点,与文本的语法分析树紧密相连,形成一个统一的、动态交互的网络。这种融合方式不仅强化了文本与图像之间的依赖关系,而且赋予了图像一个全新的角色——成为解读文本结构的一部分。此外,“语法-视觉图”的应用,为理解文本和图像之间复杂的相互作用提供了一个前所未有的框架。它使得跨模态分析能够超越传统的序列或单一模态的限制,通过这种深度整合的结构,更加精确地捕获和理解两种模态之间的细微联系和相互影响。这种方法不仅增加了模型对跨模态内容的处理能力,也为进一步探索文本与图像之间的互动提供了强有力的工具。

69、模态类型敏感的图卷积网络:设计并实现了一种创新的模态类型敏感的图卷积网络,专门用于处理融合了文本和图像特征的复杂图结构。这个网络的独特之处在于,它考虑了模态类型(文本或图像)与文本中的依赖关系类型作为图中边的不同类别,并巧妙地利用这些信息在特征更新过程中调整权重更新策略。这样的设计不仅增强了网络对多模态数据内在联系的理解能力,而且能够根据具体情境下不同模态的相对重要性动态调整权重,从而在进行情感分析时达到更高的精度和效果。通过引入模态类型敏感性,这种图卷积网络能够更细致和精准地捕捉多模态数据之间的复杂交互和依赖关系。它能识别和加强对情感分析至关重要的模态特征,同时灵活调整对次要信息的处理,确保了分析的全面性与准确性。

本文地址:https://www.jishuxx.com/zhuanli/20240730/194753.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表