一种基于深度强化学习的求解组合优化问题的方法

- 国知局

- 2024-07-31 23:20:32

本发明涉及机器学习领域,具体涉及一种基于深度强化学习的求解组合优化问题的方法。

背景技术:

1、组合优化问题(cops)在实际应用中无处不在,涉及工业、交通运输以及军事规划等领域。有效地解决这些问题对实际应用有着深远的影响。然而,由于大多数问题具备np-hard性质,使其非常难以解决。精确算法可以获得全局最优解,但对于大型问题来说难以承受。近似算法在理论上有误差保证,有时具有多项式时间复杂度,但在构建困难和实际表现弱的问题上存在困难。启发式算法速度快,实践中通常令人满意,但因缺乏理论保证并且需要针对每个具体问题进行调整而受到批评。

2、随着深度学习在计算机视觉和自然语言处理等领域的兴起,基于神经网络的组合优化问题求解器也在发展。这些求解器使用深度学习技术,并将组合优化问题求解过程视为一个学习任务。其目标是使用来自特定分布的大量问题实例训练一个更好的启发式算法,以便它能有效处理来自同一分布的新的未知实例。一旦这些神经模型训练得当,它们可以高效地应用于多次求解,解决许多与特定分布中实例相似的问题。

3、在基于神经网络的组合优化问题求解器中,s2v-dqn方法利用图嵌入和强化学习的优势,自主地学习各种组合优化问题的高效启发式算法。其有效性通过在不同问题上超过许多精心设计的方法进行性能验证。然而,s2v-dqn具有一定的局限性。它通过顺序添加节点(由学习到的q值指导)来构建解集。每个节点只被选择一次,后续不会再次访问。因此,这种策略得出的只是一个“最佳猜测”,由于组合优化问题的高复杂性,很小可能是全局最优解。

4、一种直观提高模型性能的方法是使智能体能够不断回访节点,并将其添加或从解集中移除,直到无法再进行改进为止。这种不断改善的调整可以通过诸如模拟退火和遗传算法这样的启发式方法轻松实现,这些方法依赖于采样和迭代优化。然而,对于s2v-dqn和类似的有限时域马尔可夫决策过程(mdp)强化学习(rl)模型来说,进行类似的调整是具有挑战性的。因为这样的rl算法总是从相同的初态开始,并且以相同的终态结束,使得智能体始终在有限步骤内完成mdp,无法进行充分探索,从而难以获得全局最优解。

5、在实现本发明过程中,申请人发现现有技术中至少存在如下问题:

6、采用强化学习方法求解组合问题最优解时,测试阶段,探索不充分,难以得到全局最优解。

技术实现思路

1、本发明实施例提供一种基于深度强化学习的求解组合优化问题的方法以解决现有技术中采用强化学习方法求解组合问题最优解时,难以得到全局最优解的问题。

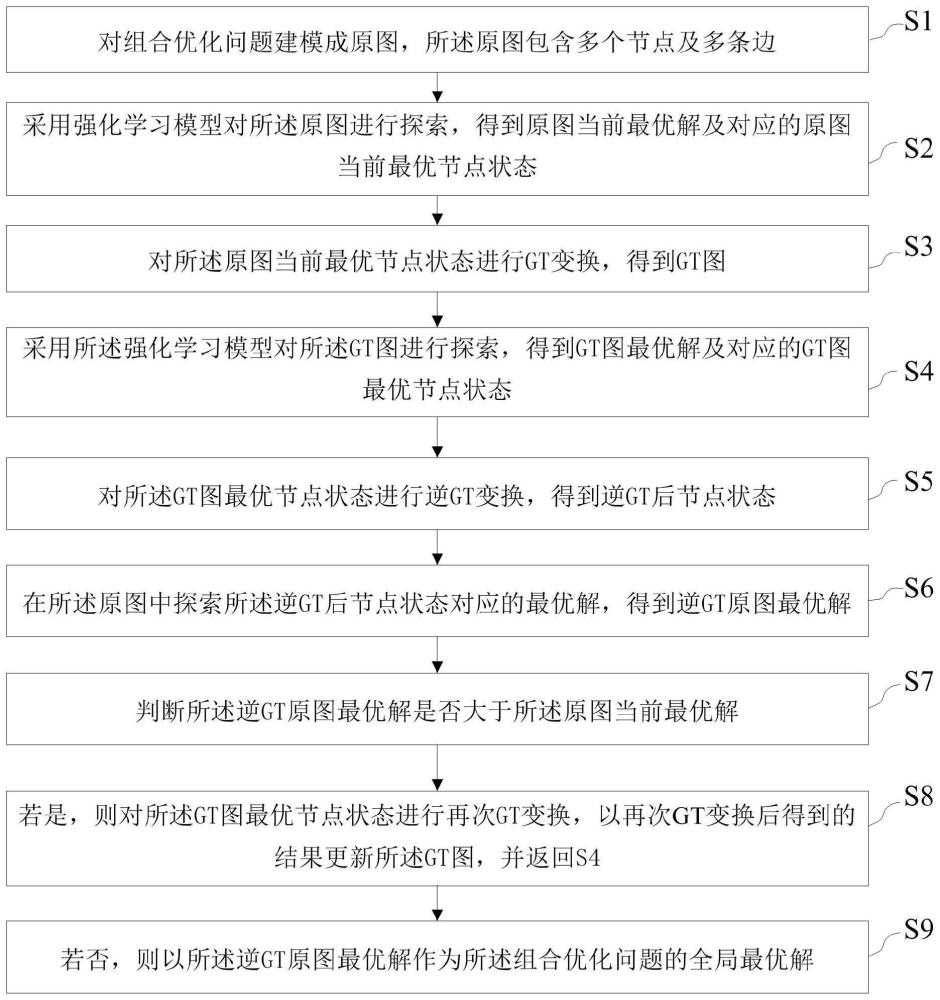

2、一方面,本发明实施例提供一种基于深度强化学习的求解组合优化问题的方法,包括:

3、s1、对组合优化问题建模成原图,所述原图包含多个节点及多条边;

4、s2、采用强化学习模型对所述原图进行探索,得到原图当前最优解及对应的原图当前最优节点状态;

5、s3、对所述原图当前最优节点状态进行gt变换,得到gt图;

6、s4、采用所述强化学习模型对所述gt图进行探索,得到gt图最优解及对应的gt图最优节点状态;

7、s5、对所述gt图最优节点状态进行逆gt变换,得到逆gt后节点状态;

8、s6、在所述原图中探索所述逆gt后节点状态对应的最优解,得到逆gt原图最优解;

9、s7、判断所述逆gt原图最优解是否大于所述原图当前最优解;

10、s8、若是,则对所述gt图最优节点状态进行再次gt变换,以再次gt变换后得到的结果更新所述gt图,并返回s4;

11、s9、若否,则以所述逆gt原图最优解作为所述组合优化问题的全局最优解。

12、上述技术方案具有如下有益效果:因为在采用强化学习模型解决组合优化问题的测试阶段进行gt变换,将当前状态重置为一种初始状态,从而使强化学习方法能够不断寻找探索的技术手段,所以达到了求解组合优化问题时,扩大了强化学习模型探索的范围,能够有效获得全局最优解的技术效果。

技术特征:1.一种基于深度强化学习的求解组合优化问题的方法,其特征在于,包括:

2.如权利要求1所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述原图的形式为g(v,e,w),所述gt变换图的形式为g(v,s,e,w),其中v表示节点集合,e表示边的集合,w表示边权重的集合,s表示节点的自旋状态。

3.如权利要求2所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述对组合优化问题建模成原图,包括:生成所述节点的初始状态。

4.如权利要求3所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述生成所述节点的初始状态包括采用搜索算法生成随机初始状态,其中,所述搜索算法包括蒙特卡洛树搜索。

5.如权利要求2所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述gt变换包括将所述组合优化问题中的节点状态全部转换为+1。

6.如权利要求5所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述将所述组合优化问题中的节点状态全部转换为+1,具体包括:

7.如权利要求6所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,

8.如权利要求1所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述节点的数量范围在50到100之间。

9.如权利要求6所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述边的权重采用均匀分布、或正态分布、或离散分布进行分布。

10.如权利要求1所述的基于深度强化学习的求解组合优化问题的方法,其特征在于,所述组合优化问题,包括:网络中心战问题;

技术总结本发明实施例提供一种基于深度强化学习的求解组合优化问题的方法,包括:对组合优化问题建模成原图;采用强化学习模型对原图进行探索,得到原图当前最优解及原图当前最优节点状态;对原图当前最优节点状态进行GT,得到GT图;采用强化学习模型对GT图进行探索,得到GT图最优解及GT图最优节点状态;对GT图最优节点状态进行逆GT,得到逆GT后节点状态;在原图中探索逆GT后节点状态对应的最优解,得到逆GT原图最优解;判断逆GT原图最优解是否大于原图当前最优解;若是,则对GT图最优节点状态进行再次GT,以再次GT后得到的结果更新GT图,继续进行GT;若否,则以逆GT原图最优解作为组合优化问题的全局最优解。从而解决当前RL难以得到组合优化问题的全局最优解的问题。技术研发人员:范长俊,蒲天乐,陈超,黄魁华,刘忠,黄金才,杜航,吴克宇受保护的技术使用者:中国人民解放军国防科技大学技术研发日:技术公布日:2024/7/29本文地址:https://www.jishuxx.com/zhuanli/20240730/197088.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表