一种基于深度强化学习的气囊隔振装置控制方法

- 国知局

- 2024-07-31 23:30:32

本发明涉及工业控制,尤其是涉及基于深度强化学习的气囊隔振装置控制方法。

背景技术:

1、近年来,隔振装置在船舶领域得到了广泛的使用,在降低机械噪声方面发挥了重要作用,形成了一系列的隔振技术,比如单层隔振装置技术、双层隔振装置技术、浮筏隔振装置技术、智能气囊隔振装置技术等。特别是,智能气囊隔振装置可以大幅降低机械噪声的同时具备高精度姿态控制能力,有效解决了船舶主机隔振中难以兼顾轴系对中的难题。在此过程中,隔振装置集成化水平逐步提高,从单机隔振到整舱隔振,隔振对象类型多样化、隔振装置激励源也呈现复杂化,对隔振装置的智能化水平提出更高的要求。

2、然而,随着气囊隔振装置集成化水平的提升,隔振装置中存在筏架变形、承载设备多工况变化、承载设备老化等因素,使得系统呈现非线性和时变的特点,传统的控制方法难以适应当前的发展需要。一方面,现有的控制模型依赖于刚体假设,基于被控对象的动力学模型等方法构建。且这些数学模型一般需要了解承载设备的质心位置、重量等信息,而这些信息往往不能准确获取。另一方面,现有的控制方法基于预先设定的规则开展控制,当运行工况或者环境发生较大变化时,既定规则由于无法适应动态变化的环境,控制效果也会随之变差。

技术实现思路

1、为了克服上述技术缺陷,本发明提供了一种基于深度强化学习的气囊隔振装置控制方法,不需要建立针对控制对象的机理模型,依据采集的系统状态信息直接映射出控制策略,可适应复杂动态变化的多工况运行环境。

2、本发明提供的基于深度强化学习的气囊隔振装置控制方法,包括如下步骤:

3、s0)将气囊隔振装置的控制过程建模为马尔可夫决策过程,确定状态空间s、动作空间a和控制目标γ;

4、s1)获取气囊隔振装置当前时刻t的状态空间信息s(t)和控制目标信息γ(t);

5、s2)判断隔振装置当前系统状态下是否已经达到最优控制目标γt,若为最优控制目标γt则跳转步骤s1,否则跳转步骤s3;

6、s3)使用基于深度强化学习的控制网络生成当前状态下对应的控制策略,并依据安全约束执行该控制策略;

7、s4)采集环境反馈信息并计算奖励值;

8、s5)将经验数据存储到经验池h中;

9、s6)使用经验池h中的数据训练控制网络的参数,并定期的将训练后的参数更新到目标网络中。

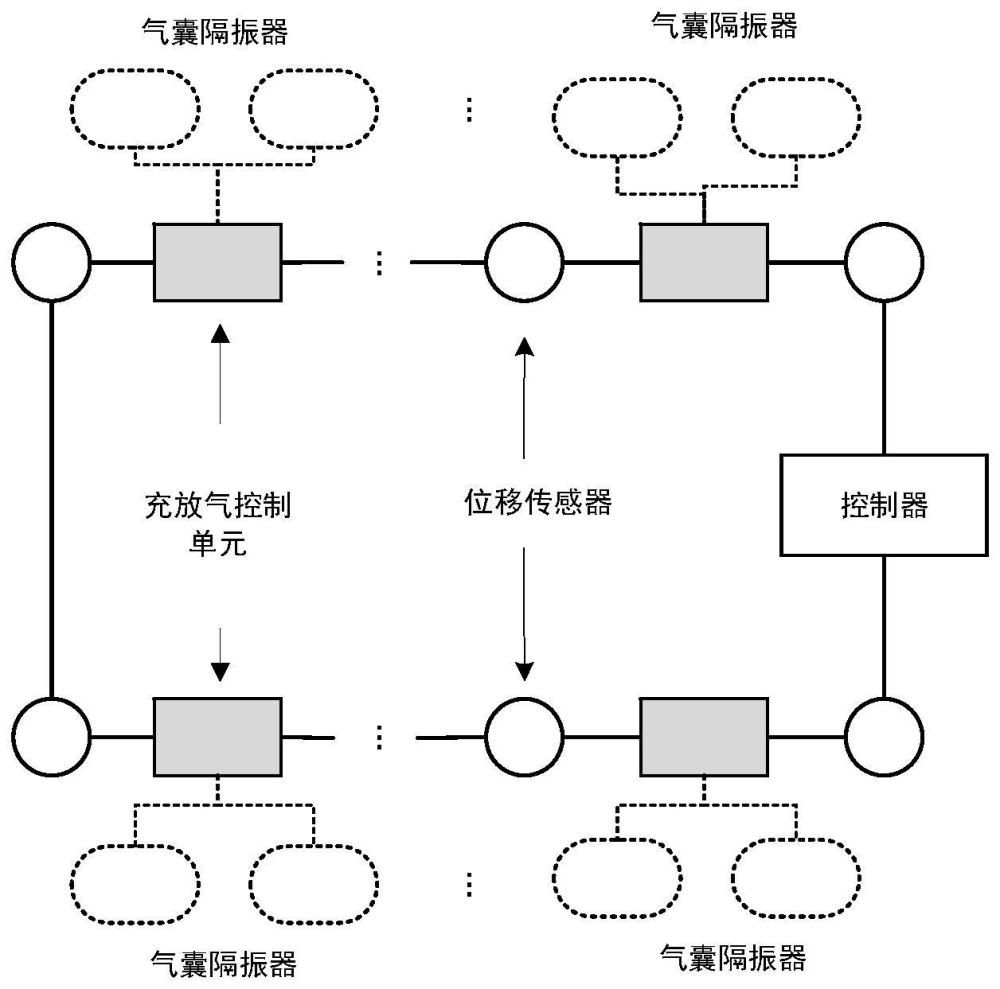

10、进一步地,所述步骤s0)中,设一种气囊隔振装置包括n个气囊隔振器支撑承载设备,2×n个电磁阀分别对n个气囊隔振器进行充气和放气控制,m个位移传感器监测气囊隔振装置m个位置的高度值,1个倾角传感器;

11、气囊隔振装置的状态空间s表示为:

12、s=(p,d);

13、其中,p=(p1,...,pn)表示一组压力值的组合,pi表示气囊隔振器i的压力值,表示一组角度值,表示气囊隔振装置横向倾斜角度,φ表示气囊隔振装置纵向倾斜角度;对于状态空间s,设定状态安全约束,倾角信息为工况信息,只对气囊隔振器压力值给出安全约束,即压力值的上限和下限分别为pl={p1l,…,pnl}、pu={p1u,…,pnu};

14、气囊隔振装置的动作空间a表示为:

15、

16、其中,表示给气囊隔振器i充气,表示给气囊隔振器i放气;

17、气囊隔振装置的控制目标γ表示为:

18、γ={τ1,…,τm};

19、其中,τi表示位置i处监测到的高度值,且最优控制目标γt表示为:γt={τ1t,…,τmt}。

20、进一步地,所述步骤s2)中,达到最优控制目标的条件表示为:

21、

22、即控制目标中的每个变量都应该满足精度约束,其中ξi常量。

23、进一步地,所述步骤s3)的具体过程为:

24、s31)使用ε-greedy算法生成控制策略

25、以ε的概率从动作空间随机选择一个控制动作,使用控制网络根据当前的系统状态计算得到动作空间每个控制动作对应的q值,并以1-ε的概率选择具有最大q值的控制动作,记为a(t);

26、s32)根据系统状态的安全约束执行控制策略

27、设定安全约束的控制规则:气囊压力应保持在安全约束的范围内,如果控制动作不满足安全约束的控制规则,则不执行控制动作,且设置安全约束标志位sc_flag=0,否则,设置安全约束标志位sc_flag=1,并执行控制动作。

28、进一步地,所述步骤s4)中,环境反馈信息包括隔振装置执行控制策略后的系统状态信息和控制目标信息;

29、将执行控制策略之前的当前系统状态记为s(t),该当前系统状态对应的控制目标值为γ(t),得到该当前系统状态下距离最优控制目标的距离为:

30、

31、其中wi(1≤i≤m)为平衡不同目标之间的权重值,为常量;记执行控制策略之后的系统状态为s(t+1),该系统状态对应的控制目标为γ(t+1),同理,得到该系统状态下距离最优控制目标的距离为:

32、

33、则,在未达到最优控制目标时,奖励值使用执行控制策略前后距离控制目标的距离变化表示;在达到最优控制目标时,奖励值使用常量表示,此时,奖励值表示为:

34、

35、其中c0,c1均为常量,且c0为正数,c1为负数,在设置该常量时应满足c0>max(|d(s(t+1),γ(t+1))-d(s(t),γ(t))|)。

36、进一步地,所述步骤s5)中,经验数据为e(t)=(s(t),a(t),r(t),s(t+1))。

37、本发明引入强化学习方法,使用神经网络直接将系统状态映射出控制策略,通过与运行环境交互过程中实时采集测量不同控制策略的综合表现,并反馈给优化算法进行实时调整,可自适应地计算得到最佳的控制策略。

38、本申请具有如下技术效果:

39、1)本发明提供的基于深度强化学习的气囊隔振装置控制方法不需要建立针对控制对象的机理模型,可通过实时监测系统状态和设备响应数据直接映射得到最佳控制策略;

40、2)本发明引入强化学习方法,可实时开展控制策略优化,可适应复杂多变的运行环境;

41、3)本发明提供的控制方法,具有结构简单,便于实施,可取的较好的控制效果。

技术特征:1.一种基于深度强化学习的气囊隔振装置控制方法,其特征在于:所述控制方法包括如下步骤:

2.根据权利要求1所述基于深度强化学习的气囊隔振装置控制方法,其特征在于:所述步骤s0)中,设一种气囊隔振装置包括n个气囊隔振器支撑承载设备,2×n个电磁阀分别对n个气囊隔振器进行充气和放气控制,m个位移传感器监测气囊隔振装置m个位置的高度值,1个倾角传感器;

3.根据权利要求2所述基于深度强化学习的气囊隔振装置控制方法,其特征在于:所述步骤s2)中,达到最优控制目标的条件表示为:

4.根据权利要求3所述基于深度强化学习的气囊隔振装置控制方法,其特征在于:所述步骤s3)的具体过程为:

5.根据权利要求4所述基于深度强化学习的气囊隔振装置控制方法,其特征在于:所述步骤s4)中,环境反馈信息包括隔振装置执行控制策略后的系统状态信息和控制目标信息;

6.根据权利要求5所述基于深度强化学习的气囊隔振装置控制方法,其特征在于:所述步骤s5)中,经验数据为e(t)=(s(t),a(t),r(t),s(t+1))。

技术总结本发明公开的基于深度强化学习的气囊隔振装置控制方法,将气囊隔振装置的控制过程建模为马尔可夫决策过程,确定状态空间S、动作空间A和控制目标Γ;获取气囊隔振装置当前时刻t的状态空间信息S(t)和控制目标信息Γ(t);判断隔振装置当前系统状态下是否已经达到最优控制目标Γ<supgt;T</supgt;;使用基于深度强化学习的控制网络生成当前状态下对应的控制策略,并依据安全约束执行该控制策略;采集环境反馈信息并计算奖励值;将经验数据存储到经验池H中;使用经验池H中的数据训练控制网络的参数,并定期的将训练后的参数更新到目标网络中。不需要建立针对控制对象的机理模型,依据采集的系统状态信息直接映射出控制策略,可适应复杂动态变化的多工况运行环境。技术研发人员:刘松,施亮,胡泽超,徐伟,卜文俊受保护的技术使用者:中国人民解放军海军工程大学技术研发日:技术公布日:2024/6/13本文地址:https://www.jishuxx.com/zhuanli/20240730/197820.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。