一种微重力环境下跳跃式探测器的路径规划方法

- 国知局

- 2024-08-01 00:17:43

本发明涉及行星探测器控制领域,具体涉及一种微重力环境下跳跃式探测器的路径规划方法。

背景技术:

1、由于小行星体积较小,形状不规则,其重力场较弱且呈现出复杂多样的特点。在进行表面探测时,难以使用传统轮式探测器。为此,目前提出了多种表面移动探索方案,包括立方体动量轮跳跃式,双轮加动量轮跳跃式,海胆伸缩腿式等移动方案,但只有基于动量轮跳跃的封闭式探测器在实际探测任务中被使用。研究基于动量轮跳跃翻滚式探测器的控制算法和路径规划策略,保障小型探测器按照要求可靠地在小天体表面移动,可以为未来我国的小行星探测任务提供相关理论验证和方案设计基础。

2、已有的文献中,仅对探测器运动过程的一部分开展研究,仅考虑刚体模型下的跳跃动力学,落地前的姿态控制及碰撞动力学,或是视为质点的路径规划任务等。但在小范围运动控制整个流程中没有统一的控制方法,也没有考虑刚体模型的路径规划任务。或者,在微重力场的情况下开展研究。选择的研究对象也多为类球形,忽略了重力场的非规则性。在开展路径规划任务时,将运动环境抽象为二维平面,利用栅格法和a*等传统的路径规划方法进行优化,在进行跳跃轨迹规划时此类模型不再适用。

技术实现思路

1、本发明的目的在于提供一种能够在小天体表面巡视过程中,提供时间、能量约束下的自主路径规划和动作决策,解决跳跃式探测器在微重力环境下的跳跃路径规划问题。

2、本发明提供一种微重力环境下跳跃式探测器的路径规划方法,包括:

3、步骤1、按照目标小天体的局部引力场和地形信息,在bullet物理引擎中定义目标小天体的环境数据信息,建立目标小天体表面的地面模型;

4、步骤2、在bullet物理引擎中搭建跳跃式探测器的多刚体模型;并设置跳跃式探测器的初始状态向量,所述初始状态向量包含跳跃式探测器的初始位置和初始姿态;

5、步骤3、搭建dqn神经网络模型,将所述dqn神经网络模型基于探测器强化学习环境进行训练,所述探测器强化学习环境是采用gym框架建立的包括所述多刚体模型和所述地面模型的探测器强化学习环境,所述探测器强化学习环境包括包含跳跃式探测器动作的动作空间、包含跳跃式探测器状态向量的状态空间以及奖励函数,训练过程中,以跳跃式探测器初始状态向量为当前状态向量作为dqn神经网络模型的输入,所述dqn神经网络模型输出下一个动作,所述bullet物理引擎根据下一个动作和当前状态向量生成下一个状态向量,并计算当前状态向量与下一个动作对应的奖励函数,并利用奖励函数对dqn神经网络模型进行更新,随后将下一个状态向量作为更新后的dqn神经网络模型的输入,进行迭代循环训练并保存训练后的dqn神经网络模型;

6、步骤4、将保存训练后的dqn神经网络模型输出的所有动作作为最优动作决策,跳跃式探测器根据最优动作决策产生的路径作为最优规划路径。

7、与现有技术相比,本发明的有益效果是:本发明采用无模型的深度q网络强化学习方法,将跳跃式探测器的动力学建模难以与地面碰撞过程相互作用的复杂问题抽象简化,在进行路径规划任务时使跳跃式探测器具有自主性,在受到干扰的情况下根据跳跃式探测器的当前位置进行路径重新规划。

8、在一种可能的实施方式中,所述步骤1中目标小天体的环境数据信息包括目标小天体的重力加速度、弹性系数和摩擦系数。

9、在一种可能的实施方式中,所述步骤3中的状态空间为跳跃式探测器的质心三维坐标、质心三维速度、三维姿态角和三维姿态角速度组成的十二维向量,式中,表示为跳跃式探测器的三维坐标,表示为跳跃式探测器的质心三维速度,表示为跳跃式探测器的三维姿态角,表示为跳跃式探测器的三维姿态角速度;

10、所述步骤3中的动作空间为跳跃式探测器的单次跳跃或翻滚动作的封装,所述跳跃式探测器的单次跳跃或翻滚动作表现为三个动量飞轮设定步长的输出转矩序列,当三个动量飞轮的输出转矩为零时,跳跃式探测器表现为等待动作,而每个动量飞轮的输出转矩序列分别表现为4个选择动作,4个选择动作包括跳跃式探测器的向前翻滚动作、向后翻滚动作、向前跳跃动作、向后跳跃动作,因此,所述动作空间包括三个动量飞轮的12个选择动作和1个等待动作,所述动作空间表示为:;

11、所述奖励函数包括到达目标位置的目标位置奖励函数、时间最优约束函数和能量最优约束函数,其中,所述目标位置为预先定义的,所述目标位置奖励函数表达式为:

12、;

13、其中,;

14、;

15、式中,为当前时间步,为前一时间步,表示为跳跃式探测器的目标位置的三维坐标;表示为跳跃式探测器当前时间步的质心三维坐标,表示为跳跃式探测器前一时间步的质心三维坐标;

16、所述时间最优约束函数的表达式为:

17、;

18、所述能量最优约束函数基于跳跃式探测器消耗的能量比值,所述跳跃式探测器消耗的能量计算公式为,式中,表示为跳跃式探测器的动量飞轮施加的转矩参数,表示为跳跃式探测器的角速度;表示为平均时间步长;

19、所述能量最优约束函数的表达式为:

20、;

21、式中,为奖励的缩放因子,为动作空间中跳跃式探测器的翻滚动作、跳跃动作和等待动作;为翻滚动作和跳跃动作中消耗能量的比值;

22、在dqn神经网络模型训练的过程中,根据探测任务需求的侧重点将目标位置奖励函数、时间最优约束函数和能量最优约束函数进行组合,,式中,为目标位置奖励函数的缩放权重,为时间最优约束函数的缩放权重,为能量最优约束函数的缩放权重。

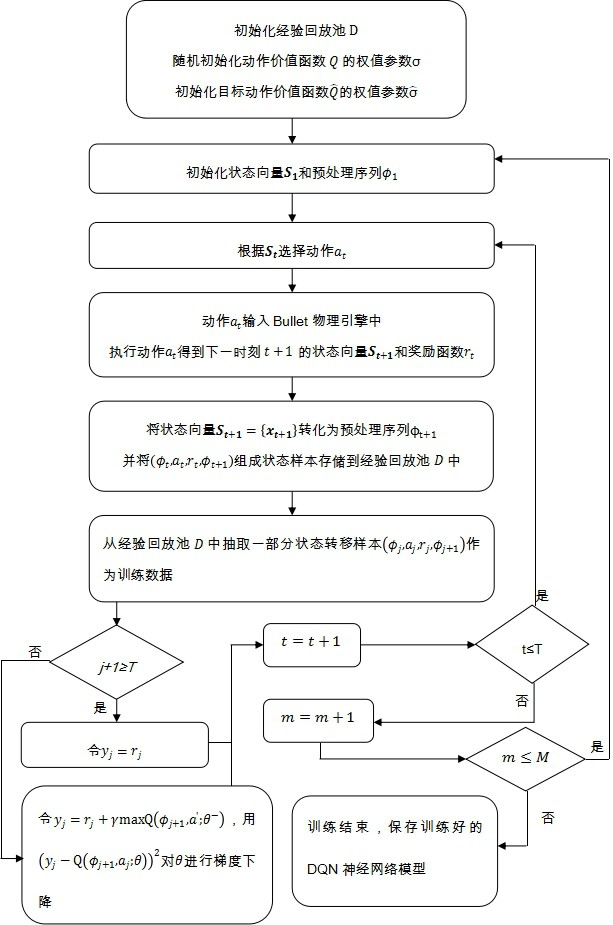

23、在一种可能的实施方式中,所述步骤3中以跳跃式探测器初始状态向量为当前状态向量作为dqn神经网络模型的输入,所述dqn神经网络模型输出下一个动作,所述bullet物理引擎根据下一个动作和当前状态向量生成下一个状态向量,并计算当前状态向量与下一个动作对应的奖励函数,并利用奖励函数对dqn神经网络模型进行更新,随后将下一个状态向量作为更新后的dqn神经网络模型的输入,进行迭代循环训练,具体包括:

24、步骤301、初始化容量为的经验回放池;随机初始化动作价值函数的权值参数;初始化目标动作价值函数的权值参数;

25、步骤302、对于每个回合,初始化状态向量和具有状态特征的预处理序列;

26、步骤303、对于回合中的每一步,根据当前的状态向量,按照ε-greedy策略选择动作;

27、步骤304、将动作输入bullet物理引擎中执行,bullet物理引擎基于当前的状态向量,使用贪婪策略选择动作,选择在状态下动作价值函数最大的动作,再执行动作得到下一时刻的状态向量和奖励函数;

28、步骤305、将下一时刻的状态向量转化为预处理序列,即,并将组成状态样本存储到经验回放池中;

29、步骤306、采用minibatch策略从经验回放池中抽取一部分状态转移样本作为训练数据;

30、步骤307、判断是否满足,式中为每个回合单训练样本最大限制步长,若是,则令,若否,则令,使用对进行梯度下降,为dqn神经网络模型权重;为到第步的奖励函数累计值;

31、步骤308、,判断是否满足,若是,则返回步骤303,若否,则,判断是否满足,为总训练时间步长,若是,则返回步骤302,否则,训练结束,保存训练好的dqn神经网络模型,进入步骤4。

本文地址:https://www.jishuxx.com/zhuanli/20240730/200483.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。