一种用于T-CPS智慧交通场景下的实时车辆流量统计方法

- 国知局

- 2024-07-31 21:02:11

本发明涉及智能交通,尤其是涉及一种用于t-cps智慧交通场景下的实时车辆流量统计方法。

背景技术:

1、随着城市化进程的不断推进,机动车的保有量不断增加,城市交通拥堵问题日益严重。与此同时,交通路口常出现某个方向车辆等待时间长等问题,为了缓解交通拥堵,提高交通运行效率,动态地调节交通的运行方式十分必要,为此,就需要对交通数据进行准确、高效的统计分析。其中,就需要对交通数据中的车辆流量进行统计分析,以提升交通的智能化。

2、但是,目前应用于智能交通的车辆流量统计方法中仍存在如下缺陷:

3、1、以前的车辆目标检测模型的数据集数据规模较小,拍摄角度单一,车辆类别标注同一,导致了训练出的模型泛化性较弱的缺陷,部署其他拍摄角度的终端设备时准确率会有所降低,并且无法区分车辆更为细致的类别。

4、2、以前的车辆目标检测模型特征提取和特征融合能力较差,推理速度较慢,将不同的车辆类型都分类为同一类,导致存在车辆位置和车辆类别检测不准确的缺陷;

5、3、同时由于车辆检测位置和类别不准确,在目标跟踪过程中,将所有的检测目标与预测结果一起进行,需要依赖多种目标信息特征,导致匹配跟踪的结果不准确,运行速度的较慢的缺陷。

技术实现思路

1、本发明的目的在于克服现有技术中的上述缺陷,提供一种用于t-cps智慧交通场景下的实时车辆流量统计方法,解决了如下问题:

2、第一:具有融合了具有代表性的多角度多类别的车辆图片数据集,实现在终端摄像头上对多角度的多类别车辆进行检测(即终端摄像头无论部署于哪个位置,都适配于该bytetracker模型中,均能保持较好的准确率),解决了车辆位置和车辆框检测不准确的问题,使得车辆流量统计更精确;

3、第二:采用了改进的pp-yoloe模型,将改进的sk模块融入到pp-yoloe网络中,采用空间注意力机制的特征融合网络,解决了目标检测网络检测能力不够的问题,提高了车辆目标检测的准确度和检测速度,从而提升了车辆流量统计速度。

4、第三:采用了bytetracker目标跟踪模型,结合更高精度的多分类模型pp-yoloe模型,通过将检测结果根据置信度划分为高分框和低分框,分别跟卡尔曼滤波所预测的结果相匹配,提升了目标跟踪的精确度与稳定性;同时由于这种高精度的匹配,使得匹配过程不需要添加额外的车辆特征信息,提升了推理速度;同时由于没有采用深度学习的方法,不需要额外的重新训练过程。

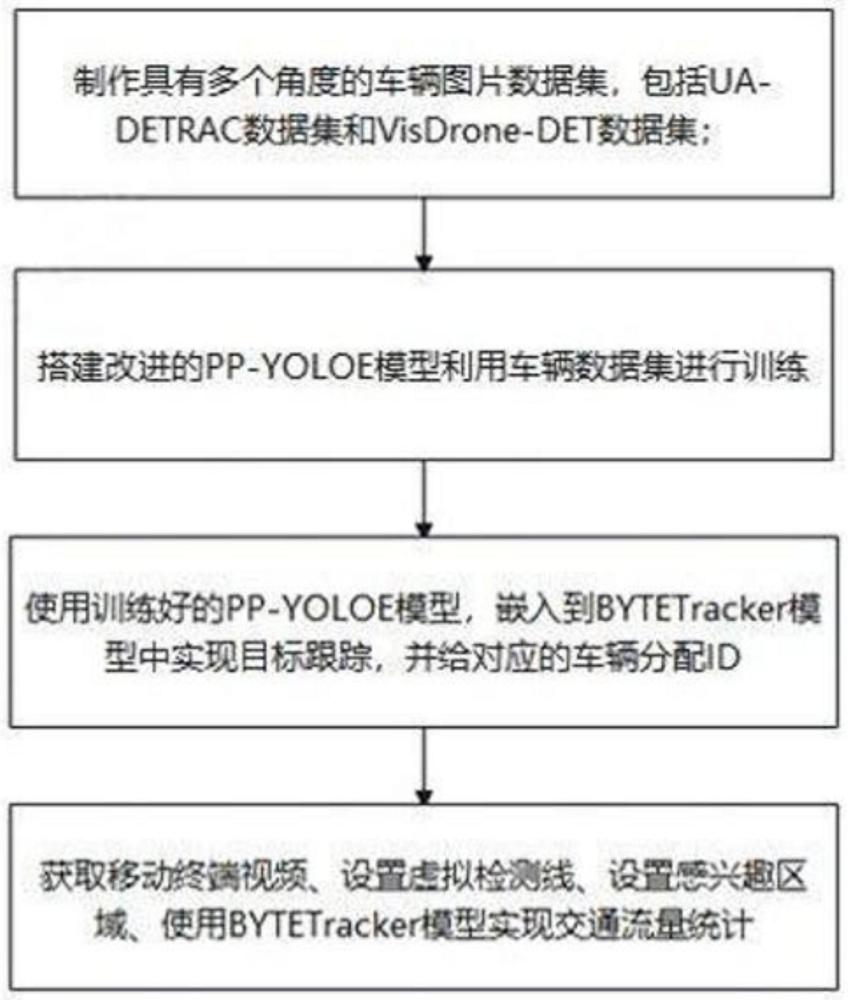

5、为实现上述目的,本发明提供了一种用于t-cps智慧交通场景下的实时车辆流量统计方法,包括如下步骤:

6、s1:制作具有多个角度的车辆图片数据集,该车辆图片数据集包括ua-detrac数据集和visdrone-det数据集;

7、s2:搭建pp-yoloe模型,将sk模块融入到pp-yoloe模型的特征融合网络中,并采用步骤s1的车辆图片数据集进行训练;

8、s3:将步骤s2的已训练的pp-yoloe模型嵌入到bytetracker模型中,实现对目标车辆进行跟踪,并对对应的目标车辆进行编号;

9、s4:获取移动终端视频、设置感兴趣区域、设置虚拟检测线、使用步骤s3的bytetracker模型实现车辆流量统计。

10、作为优选的,所述步骤s1的具体步骤如下:

11、s11:将visdrone-det数据集图片进行切分;

12、s12:将切分后的数据集与ua-detrac数据集融合一起并按一定比例分为训练集和验证集;

13、s13:将s12融合一起的数据集的xml格式转成coco数据集格式,最后合并重复的标签,完成数据集格式转换,得到用于训练的多个角度的车辆图片数据集。

14、作为优选的,所述步骤s11的具体步骤如下:以尺寸为640*640、步长为200的滑动窗口,将visdrone-det数据集图片进行切分,并依次按照0.5:1、1:1、1:1.5的比值缩放切分后的visdrone-det数据集图片,其中,当目标框与切分的visdrone-det数据集图片重合交并比大于0.8时,则将该目标框添加至该切分图片标注中。

15、作为优选的,步骤s2中的将sk模块融入到pp-yoloe模型的特征融合网络中步骤为:将pp-yoloe模型中的fpn-pan结构中的相加融合操作替换为sk模块操作。

16、作为优选的,所述步骤s2的具体步骤如下:

17、s21:pp-yoloe模型的fpn-pan网络对输入的640*640尺寸的车辆图片数据集的图片进行特征提取,得到160*160、80*80和40*40尺寸的特征图;

18、s22:pp-yoloe模型的fpn网络将高维度特征图进行插值上采样操作,并与低维度的特征图进行相加融合,使语义信息从高维度向低维度传递,生成融合多个尺度的车辆目标语义信息的特征图;

19、s23:pp-yoloe模型的pan网络将语义信息从低维度向高维度再传递一次,进行多次下采样和相加融合再次生成融合多个尺度的车辆目标位置信息的特征图。

20、作为优选的,分别在所述步骤s22和步骤s23中,采用sk模块代替了pp-yoloe模型中的fpn-pan结构中的相加融合操作,sk模块的具体操作为:将高维度与低维度的特征图拼接起来,采用最大值池化和均值池化提取出不同的位置注意力特征图,经过卷积层和激活函数映射,得到归一化的位置注意力特征图;

21、作为优选的,s31:使用已训练的pp-yoloe模块作为bytetracker模型的目标车辆检测模块,bytetracker模型还包括车辆位置预测模块和车辆特征匹配模块;

22、s32:目标车辆检测模块使用已训练的pp-yoloe模型对移动终端视频的视频帧图像进行检测,推理出的当前时刻视频帧中每辆车的位置信息以及置信度,将检测框按置信度大小划分为高分框和低分框;

23、s33:车辆位置预测模块采用卡尔曼滤波算法预测车辆下一时刻的位置信息,其中,当车辆移动时,根据车辆在上一帧的速度和位置信息,预测出车辆在当前帧的速度和位置信息,车辆的位置坐标(x',y')为:x'=x+w/2,y'=y+h/2,其中,(x,y,w,h)为目标车辆检测模块识别出的车辆框图信息,(x,y)为车辆框图左上角坐标,(w,h)分别为车辆框图的宽和高;

24、s34:车辆特征匹配模块的目标车辆特征匹配,先将已训练的pp-yoloe模型推理出的当前时刻视频帧中每辆车的位置信息以及置信度,将检测框按置信度大小划分为高分框和低分框,然后使用卡尔曼滤波算法通过之前30帧的跟踪轨迹车辆位置信息预测当前帧的车辆位置信息,分别将检测出的车辆位置信息与卡尔曼滤波算法预测追踪所得到的车辆位置信息利用匈牙利匹配算法进行特征匹配。

25、作为优选的,所述步骤s34的目标车辆特征匹配的具体步骤如下:先处理高分的检测框,将高分框与之前的跟踪轨迹进行匹配;再使用低分框和没有匹配上高分框的跟踪轨迹进行匹配;最后将剩下的没有匹配上跟踪轨迹的高分框赋予一个新的跟踪轨迹以及跟踪标识,以及将没有匹配上任何检测框的跟踪轨迹,会继续使用卡尔曼滤波预测其位置,并为其保留30帧,在其匹配上目标时继续保留。

26、作为优选的,所述步骤s4的具体步骤如下:

27、s41:获取通过移动终端拍摄的实时视频帧图像;

28、s42:通过目标车辆检测模块,检测出在视频帧图像中的车辆;

29、s43:获取通过移动终端拍摄的实时视频后一帧图像;

30、s44:通过车辆特征匹配模块,关联相似的检测框获得跟踪轨迹,为每个目标分配相应的标识;

31、s45:设置感兴趣区域和虚拟检测线,对一段连续帧图像内经过检测线的车辆目标计数,

32、s46:循环上述步骤s41-s45,实现流量统计。

33、作为优选的,还包括如下步骤:

34、s5:通过车辆流量统计可视化系统,将bytetracker模型实现车辆流量统计结果进行可视化。

35、与现有技术相比,本发明的有益效果在于:

36、1、具有融合的多角度多类别的车辆图片数据集,实现在终端摄像头上对多角度的多类别车辆进行检测(即终端摄像头无论部署于哪个位置,都适配于该bytetracker模型中,均能保持较好的准确率),从而减少车辆位置和车辆框信息检测误差,从而提高车辆流量检测精确度。

37、2、摄像头视角图像通过采用改进的pp-yoloe网络(即将sk模块融入到pp-yoloe模型的特征融合网络fpn-pan结构中)进行处理,使得本发明的车辆流量统计方法适用于多角度的车辆目标采集、空间位置计算处理,从而有效提高车辆目标检测的准确度和检测速度,使得车辆流量统计速度提高。

38、3、改进的sk模块通过引入空间注意力机制,使得pp-yoloe模型的特征融合网络能够动态地根据不同的车辆类别获取不同大小的感受野,提高了对车辆的检测准确率。

39、4、由于pp-yoloe模型已经完成训练,已训练的pp-yoloe模型嵌入到bytetracker模型后,不需要对车辆目标跟踪进行额外训练;同时,由于省略了reid特征的计算,车辆目标跟踪的推理速度得到提高;另外,由于将检测目标按照高分框和低分框进行分别处理,减少了低分框生成表示和轨迹的误检率,所以增加了车流量统计的可靠性。

本文地址:https://www.jishuxx.com/zhuanli/20240731/188056.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。