一种针对信息抽取任务的大语言模型对齐方法及系统

- 国知局

- 2024-08-19 14:22:55

本发明涉及人工智能,尤其涉及一种针对信息抽取任务的大语言模型对齐方法及系统。

背景技术:

1、随着人工智能(artificial intelligence,ai)技术的飞速发展,大语言模型(large language model,llm)在文本生成上表现出色,其能力和未来的潜力受到了各界的广泛的重视。然而,大语言模型在信息抽取任务(information extraction,ie)上仍然存在不足,特别是在封闭式信息抽取任务上,大语言模型通常难以理解和遵循信息抽取任务的复杂指令。

2、为了提升大语言模型在信息抽取任务上的性能,现有技术采用提示工程、代码形式或多任务微调的方法,虽然可以提高大语言模型在信息提取任务上的能力,但是由于现有技术缺乏多样化的对齐数据,大语言模型的泛化能力有限,而且在模型微调过程中很可能会出现过拟合的情况,影响大语言模型的通用性能。

技术实现思路

1、本发明提供一种针对信息抽取任务的大语言模型对齐方法及系统,用以解决现有技术中大语言模型的泛化能力有限且影响通用性能的缺陷。本发明为信息抽取任务确定了高质量的对齐数据,并基于对齐数据对预设大语言模型进行监督微调训练,使监督微调大语言模型在信息抽取任务上具有较好的泛化能力,且不影响大语言模型的通用性能。

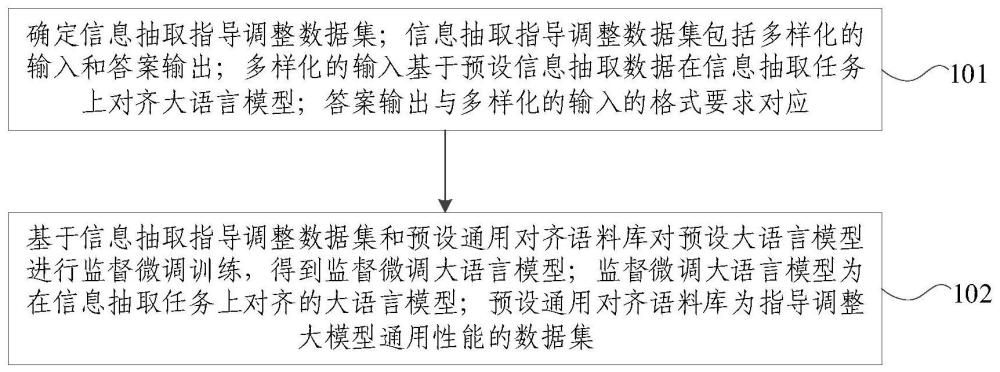

2、本发明提供一种针对信息抽取任务的大语言模型对齐方法,包括:确定信息抽取指导调整数据集;所述信息抽取指导调整数据集包括多样化的输入和答案输出;所述多样化的输入基于预设信息抽取数据在信息抽取任务上对齐大语言模型;所述答案输出与所述多样化的输入的格式要求对应;基于所述信息抽取指导调整数据集和预设通用对齐语料库对预设大语言模型进行监督微调训练,得到监督微调大语言模型;所述监督微调大语言模型为在信息抽取任务上对齐的大语言模型;所述预设通用对齐语料库为指导调整大模型通用性能的数据集。

3、根据本发明提供的一种针对信息抽取任务的大语言模型对齐方法,所述预设信息抽取数据包括封闭式信息抽取数据、开放式信息抽取数据和按需信息抽取数据;所述预设信息抽取数据采用例子比例混合策略设置数据量阈值。

4、根据本发明提供的一种针对信息抽取任务的大语言模型对齐方法,所述多样化的输入包括指导书和输入文本;所述指导书包括任务描述部分、模式描述部分和输出格式描述部分;所述输入文本为所述预设大语言模型对于信息抽取任务的文本;所述任务描述部分用于确定指导任务描述;所述指导任务描述为结合人工任务描述和生成任务描述迭代生成新的任务描述且所述新的任务描述需通过任务描述验证的描述;所述生成任务描述为采用预设生成式转换器根据所述人工任务描述自动生成的任务描述;所述模式描述部分用于确定指导模式描述;所述指导模式描述为经模式描述增强处理后的描述;所述模式描述增强处理为模式洗牌、模式抽样、融入指导方针和符号替换类别中的一种或多种处理的组合;所述输出格式描述部分用于确定指导输出格式描述;所述指导输出格式描述包括三元组格式描述、json格式描述和自然语言格式描述。

5、根据本发明提供的一种针对信息抽取任务的大语言模型对齐方法,所述指导书还包括分步解释要求和/或样本示例;所述分步解释要求为要求所述预设大语言模型在输出所述输入文本的答案之前进行分步解释;所述样本示例包括输入文本示例、分步解释示例和输出答案示例;所述分步解释示例与所述分步解释要求对应。

6、根据本发明提供的一种针对信息抽取任务的大语言模型对齐方法,所述答案输出包括与所述输出格式描述部分对应的输出格式;所述答案输出还包括与所述分步解释要求对应的分步解释输出。

7、根据本发明提供的一种针对信息抽取任务的大语言模型对齐方法,所述基于所述信息抽取指导调整数据集和预设通用对齐语料库对预设大语言模型进行监督微调训练,得到监督微调大语言模型之后,还包括:基于所述信息抽取指导调整数据集和所述监督微调大语言模型确定直接偏好优化数据集;所述直接偏好优化数据集包括在线数据偏好对和离线数据偏好对;基于所述直接偏好优化数据集对所述监督微调大语言模型进行直接偏好优化训练,得到直接偏好优化大语言模型。

8、根据本发明提供的一种针对信息抽取任务的大语言模型对齐方法,所述信息抽取指导调整数据集包括标准答案的数据标签;所述基于所述信息抽取指导调整数据集和所述监督微调大语言模型确定直接偏好优化数据集,包括:将所述监督微调大语言模型进行输出采样设置;所述输出采样设置包括采样次数设置和采样温度设置;基于所述信息抽取指导调整数据集,将所述监督微调大语言模型的输出答案偏好对作为所述在线数据偏好对;所述输出答案偏好对包括偏好答案和不偏好答案;所述偏好答案为所述监督微调大语言模型的输出答案中bleu分数最高的答案;所述不偏好答案为所述监督微调大语言模型的输出答案中bleu分数最低的答案;根据所述输出答案偏好对确定所述离线数据偏好对;所述离线数据偏好对包括所述标准答案和所述不偏好答案。

9、本发明还提供一种针对信息抽取任务的大语言模型对齐系统,包括:数据集确定模块,用于确定信息抽取指导调整数据集;所述信息抽取指导调整数据集包括多样化的输入和答案输出;所述多样化的输入基于预设信息抽取数据在信息抽取任务上对齐大语言模型;所述答案输出与所述多样化的输入的格式要求对应;模型训练模块,用于基于所述信息抽取指导调整数据集和预设通用对齐语料库对预设大语言模型进行监督微调训练,得到监督微调大语言模型;所述监督微调大语言模型为在信息抽取任务上对齐的大语言模型;所述预设通用对齐语料库为指导调整大模型通用性能的数据集。

10、本发明还提供一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现如上述任一种所述针对信息抽取任务的大语言模型对齐方法。

11、本发明还提供一种非暂态计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现如上述任一种所述针对信息抽取任务的大语言模型对齐方法。

12、本发明提供的一种针对信息抽取任务的大语言模型对齐方法及系统,该方法包括:确定信息抽取指导调整数据集;信息抽取指导调整数据集包括多样化的输入和答案输出;多样化的输入基于预设信息抽取数据在信息抽取任务上对齐大语言模型;答案输出与多样化的输入的格式要求对应;基于信息抽取指导调整数据集和预设通用对齐语料库对预设大语言模型进行监督微调训练,得到监督微调大语言模型。本发明为信息抽取任务确定了高质量的对齐数据,并基于对齐数据对预设大语言模型进行监督微调训练,使监督微调大语言模型在信息抽取任务上具有较好的泛化能力,且不影响大语言模型的通用性能。

技术特征:1.一种针对信息抽取任务的大语言模型对齐方法,其特征在于,包括:

2.根据权利要求1所述的针对信息抽取任务的大语言模型对齐方法,其特征在于,所述预设信息抽取数据包括封闭式信息抽取数据、开放式信息抽取数据和按需信息抽取数据;所述预设信息抽取数据采用例子比例混合策略设置数据量阈值。

3.根据权利要求1所述的针对信息抽取任务的大语言模型对齐方法,其特征在于,所述多样化的输入包括指导书和输入文本;所述指导书包括任务描述部分、模式描述部分和输出格式描述部分;所述输入文本为所述预设大语言模型对于信息抽取任务的文本;

4.根据权利要求3所述的针对信息抽取任务的大语言模型对齐方法,其特征在于,所述指导书还包括分步解释要求和/或样本示例;

5.根据权利要求4所述的针对信息抽取任务的大语言模型对齐方法,其特征在于,所述答案输出包括与所述输出格式描述部分对应的输出格式;

6.根据权利要求1至5任一项所述的针对信息抽取任务的大语言模型对齐方法,其特征在于,所述基于所述信息抽取指导调整数据集和预设通用对齐语料库对预设大语言模型进行监督微调训练,得到监督微调大语言模型之后,还包括:

7.根据权利要求6所述的针对信息抽取任务的大语言模型对齐方法,其特征在于,所述信息抽取指导调整数据集包括标准答案的数据标签;

8.一种针对信息抽取任务的大语言模型对齐系统,其特征在于,包括:

9.一种电子设备,包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,其特征在于,所述处理器执行所述程序时实现如权利要求1至7任一项所述针对信息抽取任务的大语言模型对齐方法。

10.一种非暂态计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现如权利要求1至7任一项所述针对信息抽取任务的大语言模型对齐方法。

技术总结本发明提供一种针对信息抽取任务的大语言模型对齐方法及系统,该方法包括:确定信息抽取指导调整数据集;信息抽取指导调整数据集包括多样化的输入和答案输出;多样化的输入基于预设信息抽取数据在信息抽取任务上对齐大语言模型;答案输出与多样化的输入的格式要求对应;基于信息抽取指导调整数据集和预设通用对齐语料库对预设大语言模型进行监督微调训练,得到监督微调大语言模型。本发明为信息抽取任务确定了高质量的对齐数据,并基于对齐数据对预设大语言模型进行监督微调训练,使监督微调大语言模型在信息抽取任务上具有较好的泛化能力,且不影响大语言模型的通用性能。技术研发人员:许斌,齐韵嘉,彭皓,王晓智,李涓子,侯磊受保护的技术使用者:清华大学技术研发日:技术公布日:2024/8/16本文地址:https://www.jishuxx.com/zhuanli/20240819/274980.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。