基于联邦学习和知识蒸馏的异常检测方法及系统

- 国知局

- 2024-08-30 14:31:13

本发明涉及机器学习异常检测领域,具体涉及基于联邦学习和知识蒸馏的异常检测方法及系统。

背景技术:

1、由于涉及大量交易数据和用户信息,金融机构容易成为金融犯罪的潜在目标。因此,训练一个能够检测金融机构异常数据和行为的机器学习模型至关重要。然而,随着经济和技术的发展,用户产生的海量数据广泛地分布在各个金融机构中,多家金融机构联合实现异常检测成为新的挑战。为了解决多机构联合进行机器学习时的数据安全和隐私问题,联邦学习应运而生。例如公布号为的现有发明专利申请文献《cn115907003a基于度量学习的联邦学习恶意模型更新的检测方法及系统》,该现有方法包括:采集本地更新数据,并对本地更新数据进行预处理,得到特征向量;将特征向量输入度量学习模块,进行训练和测试,得到训练好的度量学习网络并通过其获得特征向量的低维表示;将低维表示输入异常检测模块,筛选符合要求的低维表示并找到对应的模型更新;将模型更新输入安全聚合模块,进行安全聚合,得到客户端平均准确率并将其输入提前终止模块,计算差值,若差值大于阈值则继续联邦学习,反之则终止联邦学习。利用公布号为cn117828343a的现有发明专利申请文献《异常样本生成方法、图异常检测方法及电子设备》,该现有方法包括:基于本地编码器,对第一正常图数据进行编码,得到第一编码数据;然后应用第一编码数据生成异常编码数据;最后基于本地解码器,对异常编码数据进行解码,得到异常图数据。其中,本地编码器和本地解码器是与对端编码器和对端解码器基于第二正常图数据进行联邦学习得到的,对端编码器和对端解码器设置在对端。该方法可以在联邦学习场景下,通过本地编码器、本地解码器以及对端编码器、对端解码器构建的联邦自编码器模型实现单分类学习任务,生成异常样本。联邦学习目前已经广泛地应用在各个领域,但是降低通信损耗仍然是联邦学习的一个重要的挑战。同时也很少有研究人员在使用联邦学习架构的同时考虑异常检测数据不平衡问题。所以,对于联邦学习仍需要更深入和更广泛的研究。

2、现有技术存在原始样本不平衡、通信损耗高以及数据安全与隐私保护程度不高的技术问题。

技术实现思路

1、本发明所要解决的技术问题在于:如何解决现有技术中原始样本不平衡、通信损耗高以及数据安全与隐私保护程度不高的技术问题。

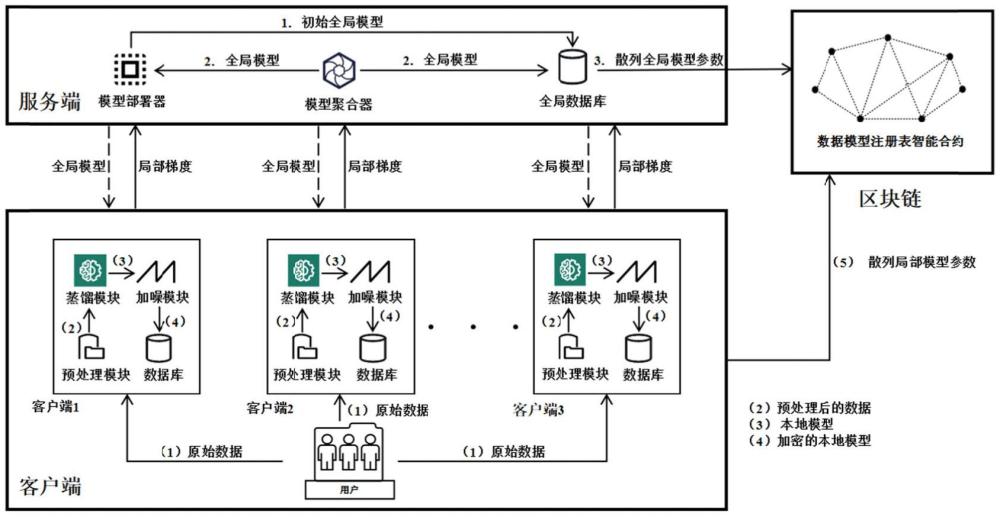

2、本发明是采用以下技术方案解决上述技术问题的:基于联邦学习和知识蒸馏的异常检测方法包括:

3、s1、进行不少于2轮的联邦学习训练,以生成全局模型,在服务端利用模型聚合器聚合全局模型,利用模型部署器下发全局模型至客户端;

4、s2、获取原始数据,利用idw-smote算法,进行数据预处理操作,以得到平衡样本数据,在客户端对本地模型添加噪声,得到加密局部模型;

5、s3、建立基于知识蒸馏的机器学习模型实现异常检测,将平衡样本数据作为机器学习神经网络的输入,使用基于知识蒸馏的机器学习模型进行异常检测,压缩生成本地模型,其中,本地模型包括:本地教师网络、本地学生网络以及本地蒸馏网络;

6、s4、对本地模型添加零均值拉普拉斯噪声,执行本地差分隐私算法,以得到加密本地模型;

7、s5、上传加密本地模型至服务端。

8、本发明的异常检测机器学习方法具有高效、安全、低损耗的特点,应用于多家机构联合检测异常数据中。本发明基于联邦学习框架,提出了idw-smote数据预处理算法以解决原始样本数据不平衡问题,使用了知识蒸馏算法以压缩模型并降低通信损耗,引入了区块链和差分隐私算法以保护数据安全与隐私。

9、在更具体的技术方案中,s1包括:

10、s11、在第一轮联邦学习训练,利用服务端的模型部署器,生成初始全局模型,将初始全局模型存储于全局数据库中;在联邦学习训练的过程中,利用模型聚合器,聚合局部模型,以生成全局模型;

11、s12、利用模型部署器,向所有客户端下发全局模型;

12、s13、客户端上传全局模型的哈希值至服务端,存储哈希值于预置区块链中;

13、s14在服务端接收到所有的客户端上传的本地模型参数时,利用模型聚合器将进行聚合操作;

14、s15、模型聚合器将更新后的全局模型存储至全局数据库中,并将全局模型传递至模型部署器,供下一轮的联邦学习训练。

15、在更具体的技术方案中,s2包括:

16、s21、利用客户端收集用户生成的原始数据,在预处理模块利idw-smote算法,对原始数据进行数据预处理操作,以得到平衡样本数据,其中,预处理模块包括:反距离加权模块、蒸馏模块以及加噪模块;

17、s22、将均衡数据传输至蒸馏模块,进行知识蒸馏操作,利用服务端下的全局模型,进行异常检测操作、模型压缩操作,以检测得到异常数据,并获取适用学生模型,以得到适用本地模型;蒸馏模块包括:神经网络、softmax层、软标签、硬标签以及真实标签;神经网络包括:教师网络以及学生网络;

18、s23、将适用本地模型,传递至加噪模块,对适用本地模型添加噪声,完成加密操作,得到加密局部模型;其中,在基于区块链的联邦学习架构中,利用本地差分隐私算法,在梯度中添加适用零均值拉普拉斯噪声,以进行梯度调优,完成加密操作。其中,利用下述逻辑,进行梯度调优:

19、gnew=clip(g,δ)+laplace(0,λ)

20、式中,clip(g,δ)用于确定噪声的阈值,于δ的梯度g需要添加噪声。g表示不添加噪声的梯度,δ表示阈值,laplace(0,λ)表示零均值拉普拉斯噪声,λ为噪声标度。加噪后的梯度将被上传到服务端用于聚合;

21、s24、客户端将加密局部模型,上传至服务端并存储至全局数据库。

22、本发明采用知识蒸馏算法,用蒸馏的方式保护从原始模型中学习到的知识,然后将知识转移到压缩模型中。虽然压缩后的模型比原始模型小得多,但可以学到相同的知识。因此知识蒸馏可以应用到联邦学习压缩客户端的本地模型中,以此来克服传输模型过大而造成的通信损耗问题。

23、在更具体的技术方案中,s21包括:

24、s211、利用idw-smote算法在预置少数类中随机选取初始样本,在预置少数类与初始样本的相邻点中,选取不少于2个邻居样本;

25、s212、根据邻居样本到初始样本的欧氏距离,通过反距离加权操作,求取每个邻居样本的邻居权值;

26、s213、根据初始样本、邻居样本以及邻居权值,生成并加入新样本点至预置少数类,其中,通过反距离加权操作idw,计算邻居权值:

27、

28、式中,wj表示邻居j的权重;

29、s214、循环执行前述操作,直至预置少数类的样本数量与预置多数类的样本数量相同。

30、本发明首先通过联邦学习、区块链和差分隐私算法保证客户端的数据安全和隐私,接着利用idw-smote数据预处理算法解决异常检测原始样本数据不平衡的问题,最后结合知识蒸馏算法压缩本地模型,以此减低服务端和客户端模型交换过程中的通信损耗。本发明提出的基于联邦学习的异常检测框架利用以上算法达到高效、安全、低损耗的检测跨机构异常数据的目的。

31、在更具体的技术方案中,s213中,利用下述逻辑,生成新样本点x new,并新样本点添加至预置少数类a中:

32、

33、式中,randam(100)表示在(1,100)的范围中随机选取一个整数。

34、在更具体的技术方案中,s22中,利用教师网络预训练并蒸馏得到输出知识数据,学生网络学习输出知识数据,以获取分类结果;利用softmax层,用于将分类结果映射至预置区间,以转化得到相应概率;利用软标签,根据相应概率处理得到概率分布,利用硬标签处理相应概率,以得到布尔数据,以利用真实标签处理得到实际分类结果。

35、在更具体的技术方案中,s22中,知识蒸馏操作包括:

36、s221、将均衡数据输入至教师网络进行预训练,通过softmax层获取教师网络的软标签,在softmax层中,当两个未进入softmax层的概率logits的差值大于预置阈值时,利用温度t维持输出间差值,以保存输出知识数据,其中,利用下述逻辑,将教师网络转换处理softmax层:

37、

38、式中,q代表教师网络的概率输出,t代表温度,z i是参与分类的每个类别的原始值,z j是项目j的分类原始值;

39、s222、将平衡样本数据,输入至学生网络进行训练,在温度t满足预置条件时,结合处理硬标签、软标签以及真实标签,以得到学生网络损失;

40、s223、根据教师网络的知识输出数据,控制学生网络进行教师网络贴合输出操作,以得到适用学生模型。

41、在更具体的技术方案中,步骤s223中,利用下述逻辑,在相同的温度t下,确定教师网络的softmax层输出的软标签,与学生网络的softmax层输出的软标签的交叉熵:

42、l=αlsoft+(1-α)lhard

43、式中,α为权重,l soft为蒸馏损失。l hard是学生网络在t=1时的损失。

44、利用下述逻辑,确定蒸馏损失l soft:

45、lsoft=ce(q,p)·t2

46、式中,ce为交叉熵,p为学生网络的预测值,q为教师网络的概率输出值;

47、利用下述逻辑,在温度t=1时,确定学生网络的softmax层输出的硬标签与真实标签的交叉熵l hard:

48、lhard=ce(y,p)

49、式中,ce是交叉熵,y是真实标签,p是学生网络的预测值。

50、在更具体的技术方案中,s5包括:

51、s51、将加密本地模型上传至服务端,服务端在完成聚合时,开始下一轮的联邦学习训练;

52、s52、将加密本地模型的哈希值上传并存储至区块链中。

53、在更具体的技术方案中,基于联邦学习和知识蒸馏的异常检测系统包括:

54、聚合部署模块,用以进行不少于2轮的联邦学习训练,以生成全局模型,在服务端利用模型聚合器聚合全局模型,利用模型部署器下发全局模型至客户端;

55、预处理模块,用以获取原始数据,利用idw-smote算法,进行数据预处理操作,以得到平衡样本数据,在客户端对本地模型添加噪声,得到加密局部模型,预处理模块与聚合部署模块连接;

56、知识蒸馏及异常检测模块,用以建立基于知识蒸馏的机器学习模型实现异常检测,将平衡样本数据作为机器学习神经网络的输入,使用基于知识蒸馏的机器学习模型进行异常检测,压缩生成本地模型,其中,本地模型包括:本地教师网络、、本地学生网络以及本地蒸馏网络,知识蒸馏模块与预处理模块连接;

57、本地模型加密模块,用以对本地模型添加零均值拉普拉斯噪声,执行本地差分隐私算法,以得到加密本地模型,本地模型加密模块与知识蒸馏模块连接;

58、本地模型上传模块,用以上传加密本地模型至服务端,本地模型上传模块与本地模型加密模块连接。

59、本发明相比现有技术具有以下优点:

60、本发明的异常检测机器学习方法具有高效、安全、低损耗的特点,应用于多家机构联合检测异常数据中。本发明基于联邦学习框架,提出了idw-smote数据预处理算法以解决原始样本数据不平衡问题,使用了知识蒸馏算法以压缩模型并降低通信损耗,引入了区块链和差分隐私算法以保护数据安全与隐私。

61、本发明采用知识蒸馏算法,用蒸馏的方式保护从原始模型中学习到的知识,然后将知识转移到压缩模型中。虽然压缩后的模型比原始模型小得多,但可以学到相同的知识。因此知识蒸馏可以应用到联邦学习压缩客户端的本地模型中,以此来克服传输模型过大而造成的通信损耗问题。

62、本发明首先通过联邦学习、区块链和差分隐私算法保证客户端的数据安全和隐私,接着利用idw-smote数据预处理算法解决异常检测原始样本数据不平衡的问题,最后结合知识蒸馏算法压缩本地模型,以此减低服务端和客户端模型交换过程中的通信损耗。本发明提出的基于联邦学习的异常检测框架利用以上算法达到高效、安全、低损耗的检测跨机构异常数据的目的。

63、本发明解决了现有技术中存在的原始样本不平衡、通信损耗高以及数据安全与隐私保护程度不高的技术问题。

本文地址:https://www.jishuxx.com/zhuanli/20240830/282444.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表