一种适用于动态视觉传感器的多相机协同标定方法及应用与流程

- 国知局

- 2024-09-05 14:38:52

本发明属于相机标定,具体涉及一种适用于动态视觉传感器的多相机高效协同标定方法及应用。

背景技术:

1、随着互联网的发展,视觉传感器因其能快速采集并传输数据的优点被广泛的应用于机器人视觉、自动驾驶汽车、虚拟现实和增强现实、医疗影像、安防监控等领域。传统摄像技术在捕捉快速运动或高动态范围场景时存在困难,因为它们以固定的帧率捕捉整个画面且帧率限制在100帧以内。为了解决这些问题,研究人员开始探索使用事件驱动传感器来实现高速、高灵敏度和低延迟的图像捕捉。这种技术的发展得益于事件传感器技术的进步,动态视觉传感器能够以微秒级的时间粒度捕捉光强度的变化,而不是以固定帧率捕捉整个画面。相对于传统的视觉传感器,动态视觉传感器具有超高速、异步运行、动态范围高等特点。

2、随着动态视觉传感器技术的发展,相关的事件处理算法也得到了广泛研究和应用。这些算法通常基于机器学习和人工智能技术,能够实时处理事件数据并提供对场景的高效描述。这一发展为事件相机技术在计算机视觉、机器人技术、自动驾驶汽车、虚拟现实和增强现实等领域的应用提供了强大的支持。因此,动态视觉传感器的兴起不仅源于对传统技术的挑战,也得益于事件传感器技术和事件处理算法的进步。这种技术的发展为各种领域带来了新的可能性,尤其是在需要高速、高灵敏度和低延迟传感器的应用中。随着相关技术的不断进步,动态视觉传感器有望在未来发挥越来越重要的作用。

3、在2016年以前,事件相机由于无法独立完成某一特定任务,常常与传统相机共同完成任务,之后事件相机的研究工作不断完善,逐渐抛弃了其他传感器的辅助,能够独立完成特征跟踪、建图、光流估计以及目标检测等任务。由于事件相机数据形式具有信息不完整等局限性,与传统相机的融合仍然非常重要。

4、2016年8月11日,基于帧和事件的组合检测和跟踪,公开在[c/ol]//2016 ieeeinternational symposiumon circuits and systems (iscas). 2016: 2511-2514. 在一帧图像中检测出目标物体后,通过事件相机的数据预测目标物体的运动方向,从而在下一帧图像到来时在预测区域进行目标检测,提高检测的速度与准确度。为了有效预测目标物体在下一帧中的位置,需要帧摄像机和事件摄像机之间精确的空间对齐和时间同步。如果标定不足,可能导致帧与事件数据在时间和空间上的不一致,进而影响目标检测和跟踪的准确性。

5、2019年5月20日,混合帧/事件驱动的快速行人检测,公开在2019 internationalconference on robotics and automation (icra)may 2019 pages 8332 – 8338,训练了两个目标检测网络,分别在传统图像和事件帧中对行人进行检测,生成置信图后融合得到最终的行人检测结果,提高了在昏暗环境下行人检测的准确率。此方法中,传统图像与事件数据的精确空间对齐对行人检测的准确性至关重要。如果相机标定不精确,会引起数据对齐偏差,从而影响融合后置信图的准确性和可靠性。这种对齐问题在实际应用中可能导致行人检测系统出现误检或漏检的情况。

6、2021年7月26日,用于特征跟踪的标准和事件相机融合,公开在2021 年机器视觉与应用国际会议 (icmva 2021),使用传统相机的图像提取特征,之后通过事件流进行跟踪,并在新的图像到来时进行修正,充分利用了传统图像,与纯事件流的跟踪相比取得了一定的优势。为了有效地融合这两种数据,必须精确地对齐传统图像与事件数据。如果标定不够精确,会导致特征位置出现错位,这对于使用事件数据进行跟踪并对新图像进行调整至关重要。空间对齐的准确性直接影响到跟踪的连续性和精确度。

7、2020年8月5日,神经形态相机引导的高动态范围成像, 公开在2020 ieee/cvfconference on computer vision and pattern recognition (cvpr),采用u-net结构网络融合了事件相机数据流和传统图像,获得了hdr图像,解决传统相机拍摄图像动态范围低的问题,融合后车身反光部分的图像细节得到了补充。然而,视频图像合成过程中要确保传统图像与事件数据的有效结合,精确的空间对齐是必不可少的。标定的任何误差都会影响对齐的准确性,进而不仅降低图像融合的质量,还可能损害其真实感。特别是在处理动态场景时,对齐的精度变得尤为关键。

8、在某些需要事件相机和传统帧相机rgb多相机系统的联合工作场景下,需要首先对事件相机和传统帧相机进行联合标定,确保采集的数据在空间上具有同步性,从而为后续的数据处理和分析提供准确的基础。联合标定的质量直接影响了后续数据处理和分析的准确性和可靠性。

9、目前,适用于事件相机的标定方法相对复杂,步骤繁琐,需要消耗大量的计算资源;在实施难度上,对高精度的硬件装置或高精度的复杂标定板依赖性强;标定过程中,相机和标定板之间的相对运动间接引入了误差,影响最终的标定结果精度。

10、因此,如何解决事件相机标定的高复杂度、高依赖性及误差引入问题,提供一种实现标定结果的高稳定性和高精度,并高效完成事件相机多相机系统的联合标定方法,是本领域技术人员亟待解决的技术问题。

技术实现思路

1、本发明的第一个目的在于,针对现有技术中事件相机与帧相机的多相机标定精度较低的问题,提供一种适用于动态视觉传感器的多相机协同标定方法。

2、为此,本发明的上述目的通过以下技术方案实现:

3、一种适用于动态视觉传感器的多相机协同标定方法,其特征在于:包括以下步骤:

4、s1,获取亚像素角点集合信息,根据帧相机拍摄的帧图像和事件重构的图像,将其输送到神经网络,得到的亚像素角点集合信息,

5、s2,优化相机参数,以最小化重投影误差,进而提高相机模型的准确性:计算适应度函数,衡量标定后的图像点与实际世界坐标点之间的重投影误差,通过交叉和变异操作,采用进化算法迭代求解,保留适应度高的参数配置,并逐步优化这些参数,以使重投影误差最小化,计算得到相机的内参矩阵和畸变参数,用于去除相机畸变;

6、s3,根据亚像素角点集合信息,采用随机抽样一致算法计算得到第一变换矩阵和第二变换矩阵,其中第一矩阵是帧相机相对于参考坐标系原点的变换矩阵,第二矩阵是事件相机相对于参考坐标系原点的变换矩阵;

7、s4,根据得到的第一变换矩阵和第二变换矩阵,求解事件相机像素空间到帧相机像素空间的变换矩阵。

8、在采用上述技术方案的同时,本发明还可以采用或者组合采用如下技术方案:

9、作为本发明的优选技术方案:步骤s1中,获取亚像素角点集合信息,包括以下步骤:

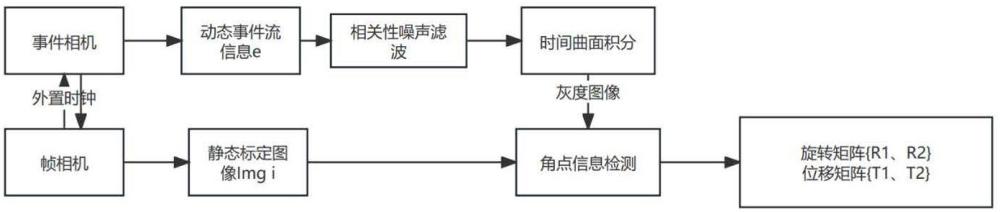

10、s1.1,使用时间同步后的帧相机和事件相机拍摄恒定频率闪烁的光源照射下的标定板,获取静态标定图像和动态事件流信息;

11、s1.2,对所述动态事件流信息进行相关性噪声滤波和时间曲面积分得到灰度图像;

12、s1.3,对所述静态标定图像和灰度图像,进行角点信息检测。

13、作为本发明的优选技术方案:步骤s1.2中,对所述动态事件流信息进行相关性噪声滤波,包括:

14、在微小邻域内,选择事件构成事件集合,根据集合内事件的位置信息、时间戳信息和极性信息,计算事件集合内事件的相似度;

15、根据所述事件集合内事件的相似度对事件进行噪声判断,剔除噪声事件。

16、作为本发明的优选技术方案:步骤s1.2中,对所述剔除噪声后的事件集合信息进行时间积分得到重构积分图像;

17、根据滤波后的事件时间戳、事件像素坐标和事件极性信息,进行积分得到重构图像。

18、作为本发明的优选技术方案:步骤s1.3中,所述角点检测方法,包括:

19、将输入帧图像和重构积分图像进行预处理,转换为单通道灰度图像;

20、利用预训练的resnet-50模型提取图像特征,生成代表角点位置概率的热图,其中每个通道对应棋盘格上的一个角点;

21、将热图输出送入一个定制的多层卷积网络中,加强角点的局部特征表示;

22、通过网络优化,增强角点在热图上的显著性,使得角点的位置更为突出;

23、最终,通过在处理后的热图上分别沿x和y维度应用全局最大池化来定位角点,得到角点信息集合。

24、作为本发明的优选技术方案:步骤s2中,重投影误差检测包括以下步骤:

25、定义重投影误差函数,即适应度函数为检测的角点位置和经过投影模型m投影后的角点位置间的二维欧氏距离:,

26、计算适应度函数,衡量标定后的图像点与实际世界坐标点之间的重投影误差,包括以下步骤:

27、s2.1,对于每个相机标定参数配置,计算所有标定图像中角点的重投影误差;

28、s2.2,将所有重投影误差进行累加或取平均,得到该相机标定参数配置的总体重投影误差;

29、s2.3,通过遗传算法中的交叉和变异操作,保留适应度高的参数配置,并逐步优化这些参数,以使重投影误差最小化;

30、s2.4,通过遗传算法的迭代优化过程,计算得到相机的内参矩阵和畸变参数,用于去除相机畸变,从而确保相机采集的图像数据准确可靠。

31、作为本发明的优选技术方案:步骤s3中,帧相机和事件相机的联合标定,需要提前对两种相机进行内参和畸变矩阵标定。

32、首先使用外部时钟连接事件相机和帧相机,对两个相机进行时间同步,使用同步后的事件相机和帧相机拍摄闪烁光源照射下的标定板,分别获取静态标定图像img i和动态事件流信息e,静态标定图像经过去除畸变后,进行角点检测,根据角点集合求解相机相对于世界坐标系姿态,即第一变换矩阵r1、和第二变换矩阵r2,采用随机抽样方法迭代求解第一变换矩阵和第二变换矩阵参数以提高计算结果精度,利用第一变换矩阵和第二变换矩阵得到事件相机到帧相机像素空间的变换矩阵。

33、作为本发明的优选技术方案:步骤s3中,相机第一变换矩阵和第二变换矩阵求解:

34、s 3.1计算世界坐标原点:根据检测的角点信息集合,计算世界坐标原点信息;

35、s 3.2 选择标定点:选择矫正畸变后的角点为角点集合,从集合中随机抽取一定数量的点坐标作为标定点;

36、s 3.3 坐标归一化:对于每个标定点,将图像中的像素坐标,利用相机内参转化为归一化平面坐标(x,y),,其中fx,fy是相机焦距,cx,cy是主点坐标;

37、s 3.4求解第一/第二变换矩阵:使用世界坐标点和归一化平面坐标,使用非线性最小二乘法求解、奇异值分解方法计算得到第一/第二变换矩阵;

38、s 3.5 对于剩余的数据点,检验是否与模型匹配,计算符合模型的数据点数量,用于评估模型;

39、s 3.6 重复3.2-3.5步骤多次,选择评估效果最好的模型参数作为最终结果。

40、作为本发明的优选技术方案:步骤s4中,求解事件相机映射到帧相机空间的变换矩阵:

41、帧相机的内参矩阵k1、事件相机的内参矩阵k2、帧相机的和畸变矩阵d1和事件相机的和畸变矩阵d2,以及第一变换矩阵r1、第二变换矩阵r2,其中u, v为事件相机数据在帧相机图像中的像素坐标,即转换后的坐标,变换矩阵t即为:,随后对变换矩阵t进行微调,选择梯度下降方法对矩阵内部参数进行优化,

42、。

43、本发明的第二个目的在于,针对现有技术中的问题,提供一种适用于动态视觉传感器的多相机协同标定方法的应用

44、为此,本发明的上述目的通过以下技术方案实现:

45、所述的适用于动态视觉传感器的多相机协同标定方法的应用,其特征在于:应用于虚拟现实、增强现实与混合现实的多相机系统标定,应用于三维空间同步定位与视角生成、三维空间的新视角生成或应用于眼动追踪人眼在3d空间的运动姿态建模中。

46、本发明涉及相机标定技术,适用于三维重建与测量、增强现实ar和虚拟现实vr、相机校正与图像处理等领域。

47、与现有技术相比,本发明的一种适用于动态视觉传感器的多相机协同标定方法及应用,提出的一种适用于动态视觉传感器的多相机高效协同标定方法,利用本发明的角点检测方法可以达到亚像素级别的角点检测精度,为相机内外参提供可靠的结果,能够更准确地捕捉相机参数和场景信息,从而为后续的视觉任务提供更可靠的基础。这种高精度的标定方法在各种应用领域中都具有重要意义,可适用于帧相机和事件相机间的空间标定,可以应用于1-多个事件相机和1-多个帧相机、不同角度和位置的相机之间的标定,使多相机系统能够在三维空间进行多视角的传感器标定,从而提高多相机系统整体的数据融合精度和鲁棒性,在在虚拟现实、增强现实与混合现实的多相机系统标定,三维空间同步定位与视角生成,三维空间的新视角生成,眼动追踪人眼在3d空间的运动姿态建模中极具应用前景。具体地,

48、1.通过帧相机拍摄的帧图像和基于事件相机数据重构的图像来获取初始的像素级角点信息,并通过神经网络将角点的定位精确到亚像素级别,从而为后续的视觉任务提供更可靠的基础;

49、2.结合神经网络和遗传算法的方法,神经网络用于从两种图像源中提取和优化亚像素角点的位置信息,为遗传算法提供了精确的初始数据;遗传算法进行全局搜索,通过多轮迭代,遗传算法逐步淘汰适应度低的参数配置,保留和优化适应度高的配置,以找到最优的相机参数;本发明充分利用深度学习在特征提取上的强大能力和遗传算法在全局优化搜索中的效率,从而实现高精度的相机标定和图像校正,通过调整和优化相机的内参矩阵及畸变参数来最小化重投影误差,确保图像数据的准确性和可靠性,在相机组内参和畸变参数确定后,被用于去除或校正图像中的畸变,处理后的图像更能准确地反映实际场景;

50、3. 在通过角点进行相机标定时,通过随机抽样一致方法能够有效筛选出正确的角点,忽略错误的检测,提高标定速度,准确拟合出的相机内参和畸变参数直接用于图像校正,消除畸变,提高后续图像处理步骤的准确性,减少数据量并确保样本的代表性,从而提高了计算效率。同时,通过迭代过程,能够不断优化模型,提高姿态矩阵的精度。组合采用梯度下降方法对变换矩阵内部参数进行微调,通过不断迭代寻找最优参数,使得目标函数达到最小化,进一步优化了变换矩阵的精度,使得最终的结果更加可靠;

51、4.本技术的标定方法不依赖复杂的标定图像,与传统标定方法相比,不需要特定的标定板或特殊的标定环境,减少在实际应用中可以遇到的限制和困难,使标定过程更为顺利。

本文地址:https://www.jishuxx.com/zhuanli/20240905/287478.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。