一种线性时延的神经电路注意力机制仿真方法

- 国知局

- 2024-09-11 14:18:22

本技术涉及机器学习领域,尤其涉及一种线性时延的神经电路注意力机制仿真方法。

背景技术:

1、在当今信息化时代,人工智能和机器学习技术的快速发展使得处理大规模数据和解决复杂任务成为可能。在这个背景下,注意力机制作为一种模拟人类信息处理方式的方法,引起了广泛的关注和研究。注意力机制通过模拟人类的注意力分配过程,可以有效地提高神经网络的性能和效率。它能够使神经网络在处理输入数据时,自动地选择和关注与当前任务相关的重要信息,从而提高模型的准确性和鲁棒性。近年来,transformer模型作为一种基于自注意力机制的深度学习模型,在自然语言处理、机器翻译和语音识别等领域取得了领先水平的性能。通过引入自注意力机制,transformer能够同时考虑输入序列中的所有位置信息,从而捕捉到全局关联性。这种机制使得transformer模型能够更好地处理长距离依赖和上下文信息,大大提升了模型的表达能力。

2、神经电路模拟生物神经系统的工作原理,由大量神经元及其突触组成,以脉冲为信号载体,具备良好的生物可解释性以及高量化、高稀疏、事件驱动、可并行等低功耗特性。然而,传统的神经电路设计并未考虑注意力机制,在应对大规模数据和复杂任务时表现出性能短板,因此,将注意力机制引入神经电路设计具有一定的应用价值。一方面,通过自动选择和关注与当前任务相关的重要信息,注意力机制可以提高神经电路的计算效率和精度;另一方面,神经电路中脉冲的稀疏性和二值特征,能够帮助降低信息处理系统的能耗开销。

3、目前,在注意力机制和神经电路设计的结合工作上已经有一定的进展,但由于注意力机制中的变量乘法与传统脉冲神经元的发放机制并不兼容,这些工作均需要根据特定任务样本进行突触权重训练,破坏了智能模型的泛化性与通用性。

技术实现思路

1、本技术旨在至少在一定程度上解决相关技术中的技术问题之一。

2、为此,本技术的第一个目的在于提出一种线性时延的神经电路注意力机制仿真方法,以便将自注意力模型以高精度、低能耗的方式迁移至神经形态硬件中。

3、本技术的第二个目的在于提出一种线性时延的神经电路注意力机制仿真装置。

4、本技术的第三个目的在于提出一种电子设备。

5、本技术的第四个目的在于提出一种计算机可读存储介质。

6、本技术的第五个目的在于提出一种计算机程序产品。

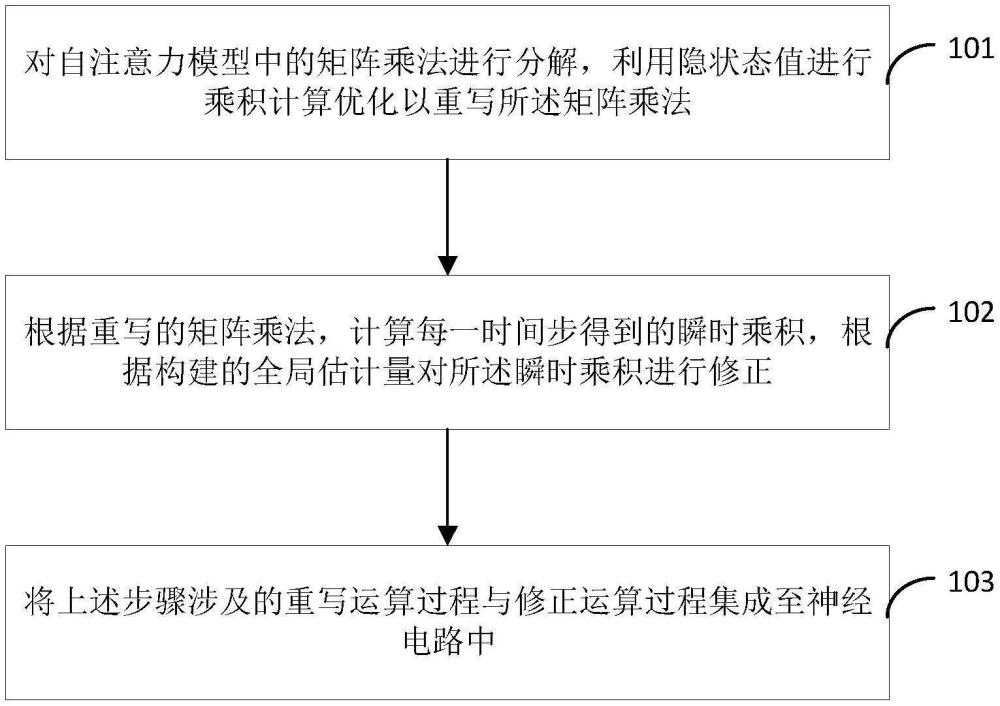

7、为达上述目的,本技术第一方面实施例提出了一种线性时延的神经电路注意力机制仿真方法,包括:

8、对自注意力模型中的矩阵乘法进行分解,利用隐状态值进行乘积计算优化以重写所述矩阵乘法;

9、根据重写的矩阵乘法,计算每一时间步得到的瞬时乘积,根据构建的全局估计量对所述瞬时乘积进行修正;

10、将上述步骤涉及的重写运算过程与修正运算过程集成至神经电路中。

11、可选的,所述对自注意力模型中的矩阵乘法进行分解,利用隐状态值进行乘积计算优化以重写所述矩阵乘法,包括:

12、对于自注意力模型中形如p=a×b的矩阵乘法,在引入时间维度的神经电路中,脉冲矩阵在每个时间步依次输入,构成脉冲序列{at|t=1,2,…,t},且满足即浮点输入值等于所有时间步上的脉冲输入均值,分解后的矩阵乘法的表达形式为:

13、

14、其中,a与b表示矩阵乘法p中给定的两个矩阵,at表示时间步t上的矩阵,bt与at类似,t表示脉冲序列的长度;

15、利用隐状态值进行乘积计算优化以重写所述矩阵乘法,表达形式为:

16、

17、其中,表示当前乘积项中矩阵at的累加项隐状态值表示矩阵bt的累加项隐状态值与能够通过上一步的计算结果递推得到,表达式为:

18、

19、

20、可选的,所述根据重写的矩阵乘法,计算每一时间步的得到的瞬时乘积,根据全局估计量对所述瞬时乘积进行修正,包括:

21、假设输入矩阵均匀,满足at≈a,bt≈b,根据重写的矩阵乘法,计算每一时间步得到的瞬时乘积,表达式为:

22、

23、其中,pt为时间步t得到的瞬时乘积;

24、构造实时的全局估计量ψt,表达式为:

25、

26、根据当前输出量级一致与当前所有时间步输出均值数值一致的目标,将瞬时乘积pt修改为表达式为:

27、

28、其中,表示矩阵pt的累加隐状态值,表达式为:

29、

30、修正后,所有时间步上的均值为即数值一致,且修改后的瞬时乘积输出即量级一致。

31、为达上述目的,本技术第二方面实施例提出了一种线性时延的神经电路注意力机制仿真装置,包括:

32、重写模块,用于对自注意力模型中的矩阵乘法进行分解,利用隐状态值进行乘积计算优化以重写所述矩阵乘法;

33、修正模块,用于根据重写的矩阵乘法,计算每一时间步得到的瞬时乘积,根据构建的全局估计量对所述瞬时乘积进行修正;

34、迁移模块,用于将上述步骤涉及的重写运算过程与修正运算过程集成至神经电路中。

35、可选的,所述重写模块,用于:

36、对于自注意力模型中形如p=a×b的矩阵乘法,在引入时间维度的神经电路中,脉冲矩阵在每个时间步依次输入,构成脉冲序列{at|t=1,2,…,t},且满足即浮点输入值等于所有时间步上的脉冲输入均值,分解后的矩阵乘法的表达形式为:

37、

38、其中,a与b表示矩阵乘法p中给定的两个矩阵,at表示时间步t上的矩阵,bt与at类似,t表示脉冲序列的长度;

39、利用隐状态值进行乘积计算优化以重写所述矩阵乘法,表达形式为:

40、

41、其中,表示当前乘积项中矩阵at的累加项隐状态值表示矩阵bt的累加项隐状态值与能够通过上一步的计算结果递推得到,表达式为:

42、

43、可选的,所述修正模块,用于:

44、假设输入矩阵均匀,满足at≈a,bt≈b,根据重写的矩阵乘法,计算每一时间步得到的瞬时乘积,表达式为:

45、

46、其中,pt为时间步t得到的瞬时乘积;

47、构造实时的全局估计量ψt,表达式为:

48、

49、根据当前输出量级一致与当前所有时间步输出均值数值一致的目标,将瞬时乘积pt修改为表达式为:

50、

51、其中,表示矩阵pt的累加隐状态值,表达式为:

52、

53、修正后,所有时间步上的均值为即数值一致,且修改后的瞬时乘积输出即量级一致。

54、为达上述目的,本技术第三方面实施例提出了一种电子设备,包括:处理器,以及与所述处理器通信连接的存储器;

55、所述存储器存储计算机执行指令;

56、所述处理器执行所述存储器存储的计算机执行指令,以实现如上述第一方面中任一项所述的方法。

57、为达上述目的,本技术第四方面实施例提出了一种计算机可读存储介质,所述计算机可读存储介质中存储有计算机执行指令,所述计算机执行指令被处理器执行时用于实现如上述第一方面中任一项所述的方法。

58、为达上述目的,本技术第五方面实施例提出了一种计算机程序产品,包括计算机程序,该计算机程序被处理器执行时实现如上述第一方面中任一项所述的方法。

59、本技术的实施例提供的技术方案至少带来以下有益效果:

60、在神经电路中完成了注意力机制的等效建模,有助于将复杂的大型注意力网络直接迁移至低功耗的神经电路中;对注意力机制中变量间乘法的拆分与校正处理,在保证数值等价性的前提下,考虑了脉冲发放的均匀性,为神经电路的稳定表示提供保障;通过提取变量的累加隐状态值以递推形式优化乘法运算,有效地将时空注意力机制的推断时延由平方级复杂度压缩至线性复杂度;并且,对注意力机制的仿真方案能够复用并推广到其他涉及变量间乘法运算的模块,进一步为主流智能模型的神经电路实现提供可能。

61、本技术附加的方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本技术的实践了解到。

本文地址:https://www.jishuxx.com/zhuanli/20240911/290126.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表