基于AIGC的机器人情感识别方法、系统及存储介质与流程

- 国知局

- 2024-09-14 15:15:58

本技术涉及数据处理,尤其涉及一种基于aigc的机器人情感识别方法、系统及存储介质。

背景技术:

1、现有的机器人情感识别技术通常依赖于单一或有限的模态数据,如面部表情识别或语音情感分析。这些方法在受控环境下可以达到一定的识别准确率,但在复杂的实际应用场景中往往表现不佳。此外,传统的情感识别算法通常采用预定义的特征提取和分类方法,缺乏对个体差异和情境因素的考虑,导致识别结果缺乏灵活性和个性化。

2、然而,这些现有技术存在一些显著的不足。首先,单一模态的情感识别无法全面捕捉人类情感的复杂性和多样性。其次,预定义的特征和分类方法难以适应不同个体的情感表达差异和不同情境下的情感变化。再者,现有技术往往缺乏对识别结果的可解释性,使得用户难以理解和信任机器人的情感判断。最后,现有的情感识别系统通常是静态的,缺乏持续学习和适应的能力,无法随着与用户的交互而不断改进。

技术实现思路

1、本技术提供了一种基于aigc的机器人情感识别方法、系统及存储介质,用于提升基于aigc的机器人情感识别的效率及准确率。

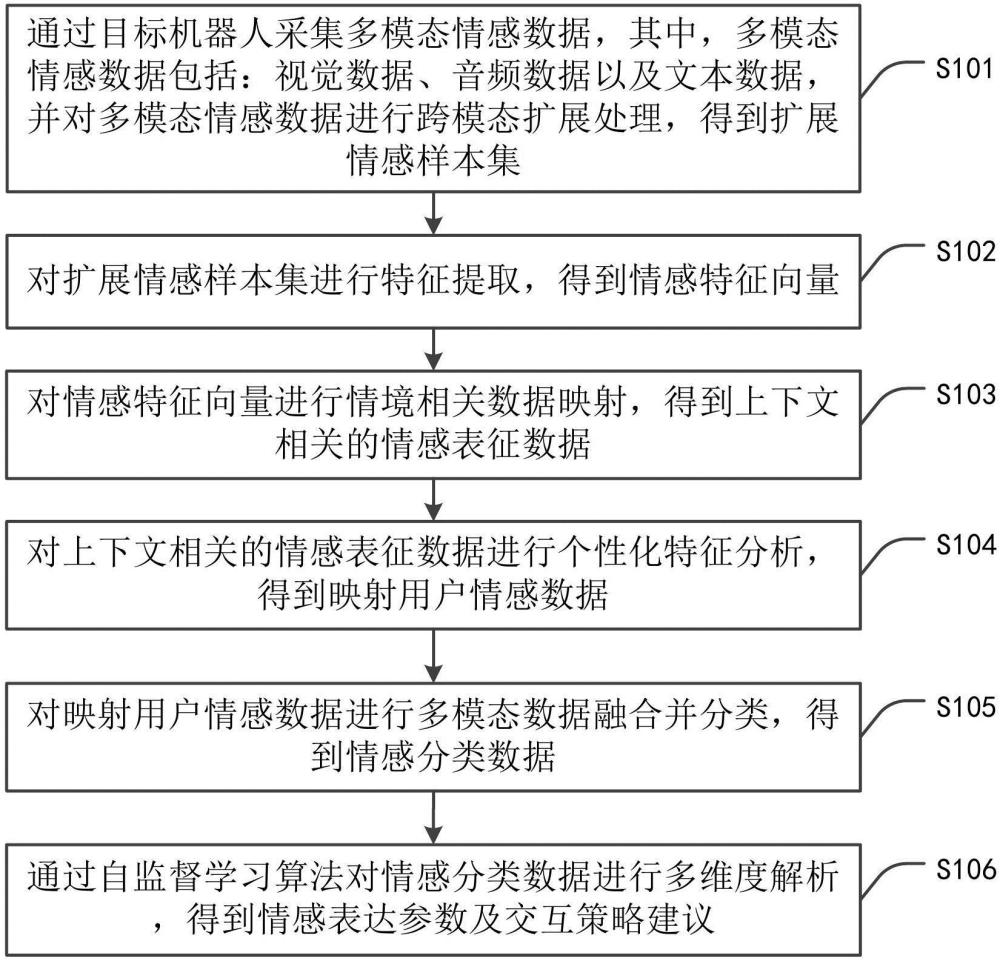

2、第一方面,本技术提供了一种基于aigc的机器人情感识别方法,所述基于aigc的机器人情感识别方法包括:通过目标机器人采集多模态情感数据,其中,所述多模态情感数据包括:视觉数据、音频数据以及文本数据,并对所述多模态情感数据进行跨模态扩展处理,得到扩展情感样本集;对所述扩展情感样本集进行特征提取,得到情感特征向量;对所述情感特征向量进行情境相关数据映射,得到上下文相关的情感表征数据;对所述上下文相关的情感表征数据进行个性化特征分析,得到映射用户情感数据;对所述映射用户情感数据进行多模态数据融合并分类,得到情感分类数据;通过自监督学习算法对所述情感分类数据进行多维度解析,得到情感表达参数及交互策略建议。

3、结合第一方面,在本技术第一方面的第一种实现方式中,所述通过目标机器人采集多模态情感数据,其中,所述多模态情感数据包括:视觉数据、音频数据以及文本数据,并对所述多模态情感数据进行跨模态扩展处理,得到扩展情感样本集,包括:通过目标机器人采集多模态情感数据,其中,所述多模态情感数据包括:视觉数据、音频数据以及文本数据,并对所述视觉数据进行情感语义分割,得到情感区域特征图;对所述情感区域特征图进行动态表情序列提取,得到时序情感特征数据; 对所述音频数据进行谱域特征分解,得到声学特征,并对所述声学特征进行韵律模式分析,得到情感韵律特征向量;对所述文本数据进行情感词汇识别,得到情感词嵌入矩阵,并对所述情感词嵌入矩阵进行上下文语义增强,得到扩充情感文本表示; 对所述时序情感特征数据、所述情感韵律特征向量和所述扩充情感文本表示进行跨模态对齐,得到目标情感特征空间;通过生成对抗网络对所述目标情感特征空间进行数据增广,得到扩展情感样本集,并对所述扩展情感样本集进行情感强度梯度化处理,得到连续变化的情感样本;对所述连续变化的情感样本进行边缘情感案例合成,得到所述扩展情感样本集。

4、结合第一方面,在本技术第一方面的第二种实现方式中,所述对所述扩展情感样本集进行特征提取,得到情感特征向量,包括:对所述扩展情感样本集进行多模态情感特征映射,得到初始情感高维特征空间,并对所述初始情感高维特征空间进行情感语义信息提取,得到情感语义增强特征矩阵;对所述情感语义增强特征矩阵进行情感虚拟特征生成,得到情感补充特征集,并对所述情感补充特征集进行情感特征融合,得到融合情感特征表示;对所述融合情感特征表示进行情感自监督重构,得到情感重构特征数据,并对所述情感重构特征数据以及所述扩展情感样本集进行数据对比分析,得到关键情感特征集;对所述关键情感特征集进行跨模态情感特征对齐,得到情感一致性特征映射数据;对所述情感一致性特征映射数据进行动态情感维度调整,得到自适应情感特征向量;对所述自适应情感特征向量进行情感信息压缩,得到高效情感特征编码; 通过对比学习算法对所述高效情感特征编码进行情感特征增强,得到所述情感特征向量。

5、结合第一方面,在本技术第一方面的第三种实现方式中,所述对所述情感特征向量进行情境相关数据映射,得到上下文相关的情感表征数据,包括:对所述情感特征向量进行语义分解,得到多维情感语义数据,并对所述多维情感语义数据进行情境关联分析,得到初步情境-情感对应关系;对所述初步情境-情感对应关系进行知识图谱映射,得到结构化情境情感网络;对所述结构化情境情感网络进行动态扩展,得到情境知识库,并对所述情境知识库进行情感反应谱生成,得到多元化情感响应模式;对所述多元化情感响应模式进行时序预测,得到情感变化趋势图,并对所述情感变化趋势图进行场景衍生,得到多路径情感发展矩阵;对所述多路径情感发展矩阵进行相似度计算,得到情感-情境关联模式集,并对所述情感-情境关联模式集进行对比样本构造,得到细粒度情境-情感映射数据;通过图注意力网络算法对所述细粒度情境-情感映射数据和所述情感特征向量进行融合处理,得到上下文相关的情感表征数据。

6、结合第一方面,在本技术第一方面的第四种实现方式中,所述对所述上下文相关的情感表征数据进行个性化特征分析,得到映射用户情感数据,包括:对所述上下文相关的情感表征数据进行用户特征提取,得到初始用户情感特征集,并对所述初始用户情感特征集进行样本合成,得到扩展用户情感表达数据; 对所述扩展用户情感表达数据进行表情-语音-文本联合分析,得到多模态个性化特征矩阵,并对所述多模态个性化特征矩阵进行风格转换,得到用户特定情感表达样本;对所述用户特定情感表达样本进行情境关联性分析,得到个性化情感反应模式,并对所述个性化情感反应模式进行序列预测,得到用户情感反应趋势图; 对所述用户情感反应趋势图进行语义映射,得到个性化情感词汇表,并对所述个性化情感词汇表进行频率-语境分析,得到用户情感表达习惯库;对所述用户情感表达习惯库进行差异性对比,得到个性化情感特征偏差矩阵;通过迁移学习算法对所述个性化情感特征偏差矩阵和所述上下文相关的情感表征数据进行整合,得到所述映射用户情感数据。

7、结合第一方面,在本技术第一方面的第五种实现方式中,所述对所述映射用户情感数据进行多模态数据融合并分类,得到情感分类数据,包括:对所述映射用户情感数据进行模态完整性检测,得到模态缺失标记矩阵,并根据所述模态缺失标记矩阵对所述映射用户情感数据进行数据补全处理,得到目标多模态情感数据集;对所述目标多模态情感数据集进行跨模态一致性评估,得到模态一致性得分向量,并对所述模态一致性得分向量进行阈值筛选,得到高可信度多模态数据子集;对所述高可信度多模态数据子集进行动态权重分配,得到模态融合权重矩阵;对所述模态融合权重矩阵和所述高可信度多模态数据子集进行加权融合,得到初步融合特征向量,并对所述初步融合特征向量进行情境约束处理,得到情境敏感融合特征; 对所述情境敏感融合特征进行反事实分析,得到模态重要性评估报告,并对所述模态重要性评估报告进行决策规则生成,得到动态决策树结构; 通过集成学习算法对所述动态决策树结构进行多维情感空间映射,得到情感分类数据。

8、结合第一方面,在本技术第一方面的第六种实现方式中,所述通过自监督学习算法对所述情感分类数据进行多维度解析,得到情感表达参数及交互策略建议,包括:对所述情感分类数据进行多粒度解释生成,得到层级化情感解释结构,并对所述层级化情感解释结构进行语义分解,得到情感成因要素集;对所述情感成因要素集进行权重计算,得到情感贡献度矩阵,并对所述情感贡献度矩阵进行阈值分析,得到关键情感触发因素;对所述关键情感触发因素进行反例构建,得到情感边界案例集,并对所述情感边界案例集进行相似度计算,得到情感差异空间图;对所述情感差异空间图进行轨迹预测,得到情感发展脚本库,并对所述情感发展脚本库进行语境映射,得到情感-环境关联网络;对所述情感-环境关联网络进行交互问题生成,得到深度解释问答对;通过自监督学习算法对所述深度解释问答对进行特征提取和聚类,得到情感表达参数及交互策略建议。

9、第二方面,本技术提供了一种基于aigc的机器人情感识别系统,所述基于aigc的机器人情感识别系统包括:

10、采集模块,用于通过目标机器人采集多模态情感数据,其中,所述多模态情感数据包括:视觉数据、音频数据以及文本数据,并对所述多模态情感数据进行跨模态扩展处理,得到扩展情感样本集;

11、提取模块,用于对所述扩展情感样本集进行特征提取,得到情感特征向量;

12、映射模块,用于对所述情感特征向量进行情境相关数据映射,得到上下文相关的情感表征数据;

13、分析模块,用于对所述上下文相关的情感表征数据进行个性化特征分析,得到映射用户情感数据;

14、融合模块,用于对所述映射用户情感数据进行多模态数据融合并分类,得到情感分类数据;

15、解析模块,用于通过自监督学习算法对所述情感分类数据进行多维度解析,得到情感表达参数及交互策略建议。

16、本技术的第三方面提供了一种计算机可读存储介质,所述计算机可读存储介质中存储有指令,当其在计算机上运行时,使得计算机执行上述的基于aigc的机器人情感识别方法。

17、本技术提供的技术方案中,通过采集和处理多模态情感数据,包括视觉、音频和文本数据,扩展了情感识别的信息源,使得识别结果更加全面和准确,跨模态扩展处理进一步丰富了样本集,增强了模型的泛化能力。其次,本方法采用的特征提取技术,特别是情感语义信息提取和情感虚拟特征生成,显著提高了情感特征的表达能力和丰富度。通过情感自监督重构和跨模态特征对齐,确保了提取的特征能够准确捕捉关键的情感信息。再者,本方法引入了情境相关的数据映射,这使得情感识别能够考虑到具体的上下文环境,大大提升了识别的准确性和适用性。通过构建情境知识库和生成多元化情感响应模式,能够更好地理解和预测在不同情境下的情感表现。此外,本方法的个性化特征分析环节允许系统适应不同用户的独特情感表达方式,通过用户特定的情感表达样本和个性化情感反应模式,实现了高度个性化的情感识别。在多模态数据融合和分类阶段,本方法采用了模态完整性检测和跨模态一致性评估,有效处理了实际应用中可能出现的数据缺失或不一致问题。动态权重分配和情境敏感融合特征的引入,进一步提高了融合过程的灵活性和鲁棒性。最后,本方法通过自监督学习算法进行多维度解析,不仅能够得到准确的情感分类结果,还能生成详细的情感表达参数和交互策略建议。这种多层次的解释生成和反例构建机制,大大增强了系统的可解释性,使用户能够更好地理解和信任机器人的情感判断。同时,情感发展脚本库和情感-环境关联网络的构建,提供了预测和适应复杂情感变化的能力,提升了基于aigc的机器人情感识别的效率及准确率。

本文地址:https://www.jishuxx.com/zhuanli/20240914/297576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表