一种基于眼动信号监督的青光眼分类方法、设备和介质

- 国知局

- 2024-10-09 14:46:04

本发明属于图像信息处理领域,特别涉及一种基于眼动信号监督的青光眼分类方法、设备和介质。

背景技术:

1、医学图像分析在现代医学实践中发挥着至关重要的作用,该领域的趋势是将深度学习技术应用于计算机辅助诊断(computer-aided diagnosis,cad)。cad取得巨大成功不仅依赖于新颖的深度学习技术,同时也依赖大量精心标注的数据。然而,标注大量的医学图像成本昂贵,且需要花费大量时间,有时甚至需要咨询更多的专家。

2、在基于眼底图像的青光眼诊断领域,带有精心标注的数据量通常较少,且大多数的图像标注仅包含图像级注释(例如受试者是否患有青光眼)。仅使用图像级的标注,一方面对模型进行训练容易产生过拟合现象,另一方面模型通常难以实现异常定位,从而削弱了cad模型的可解释性。除了图像级的标注外,还有更具细粒度的标注。常见的标注方法为框标注与像素标注,框标注是将病变区域置于一个图像框内。像素标注是将图像中每个像素点进行标注,像素值代表了专家认为该像素是否属于病变区域或属于病变区域的概率。

3、近年来,整合多层次监督信号的研究已成为研究热点。除了通过图像级的注释监督之外,深度网络还可以从更具细粒度的标注中获得信息增益。例如,li等人提出了一种引导注意力推理网络,该网络在自然图像上同时利用图像级和像素级注释,提升了模型的诊断性能。ouyang等人提出了一种胸部x射线诊断框架,使用边界框对异常进行粗略标注,同时提高了诊断和异常定位。这些工作证明,引入额外的精细标注数据的监督不仅可以提高cad的准确性,还可以提升经过充分训练的深度学习模型的可解释性和鲁棒性。

4、尽管收集少量的精细注释相对容易,但是这个过程仍然具有高额成本。更重要的是,对于每个临床中心,其所使用的成像设备往往不同,注释标准也不尽相同。因此,需要使用精细注释反复微调深度网络,而进行精细标注又会影响日常工作流程。

技术实现思路

1、本发明提供一种基于眼动信号监督的青光眼分类方法、设备和介质,将眼动信息作为专家领域知识注入青光眼分类网络,有效提高青光眼判别的准确性,还可一定程度上解决精细标注成本高昂且需要花费大量时间的问题。

2、一种基于眼动信号监督的青光眼分类方法,包括:

3、获取专业医生在阅读眼底图像训练样本时的眼动信号和给出的青光眼分类类别;

4、通过对眼动信号进行处理,获得针对青光眼病变区域的专家凝视注意力图像;

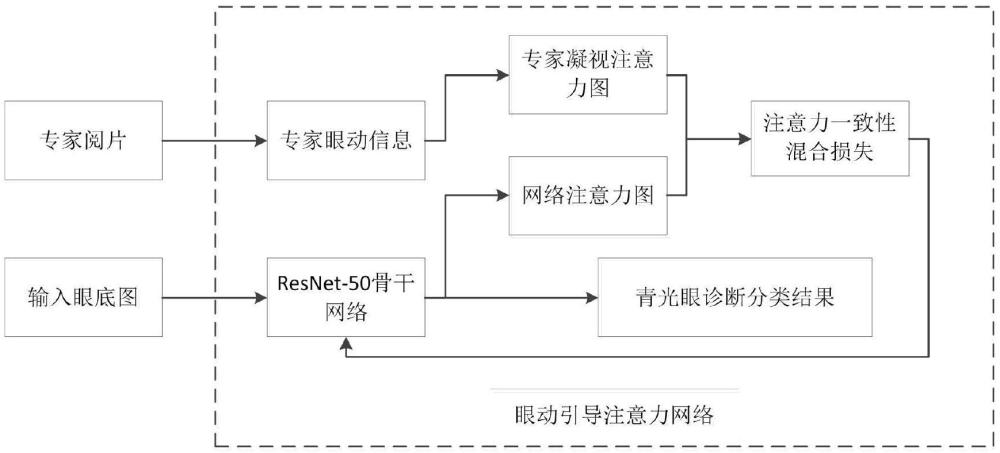

5、以眼底图像作为输入,以青光眼分类类别及其注意力图作为输出,搭建青光眼分类网络,并使用眼底图像训练样本训练青光眼分类网络;其中,训练青光眼分类网络的损失,采用专家凝视注意力图像和青光眼分类类别作为监督信号构建得到;

6、将眼底图像待检测样本输入至训练好的青光眼分类网络,输出得到待检测样本对应是否患有青光眼。

7、进一步地,通过眼动仪采集获得专业医生在阅读眼底图像训练样本时的眼动信号,具体采集到的眼动信号包括专业医生的眼球专注于眼底图像上的一系列凝视点的位置和时间戳。

8、进一步地,对眼动信号进行处理以获得专家凝视注意力图像,具体为:

9、根据眼动信号一系列凝视点的位置和时间戳,计算每相邻两个凝视点之间的位移和步长;

10、根据滑动时间窗内每相邻两个凝视点之间的位移和步长,通过拟合计算滑动时间窗内的步长分布扩散因子γ;其中相邻凝视点的步长s服从以下重尾分布:

11、p(s)=γs-2

12、式中,s为相邻两个凝视点之间的步长,p为相邻两个凝视点之间的位移,γ为当前滑动时间窗内的步长分布扩散因子;

13、使用各滑动时间窗内的步长分布扩散因子作为注意力水平的度量因子,将步长分布扩散因子与注意力水平阈值γth比较:若某滑动时间窗内的步长分布扩散因子γ>γth,则判定该滑动时间窗内的凝视点为注视点,否则判定为扫视点;

14、舍弃所有凝视点中的扫视点,保留注视点,所有注视点构成专家凝视注意力图像。

15、进一步地,在保留所有注视点后,还进一步采用预设半径的核,对当前所有注视点构成的图像进行高斯滤波处理,得到最终的专家凝视注意力图像。

16、进一步地,搭建的青光眼分类网络,采用resnet网络作为骨干网络提取输入眼底图像的特征,接着使用全局平均池化层执行全局平均化操作,再接入一个全连接层以产生对应于所需类别的输出,最后经过softmax运算得到各类别c的分类概率sc;另外搭建的青光眼分类网络还设置类激活图模块,即cam模块,通过共享全连接层的权重来生成网络注意力图,用于与专家凝视注意力图像结合构建损失函数以训练青光眼分类网络。

17、进一步地,在resnet网络的最后一个卷积层中采用空洞卷积,并将步长设置为1。

18、进一步地,青光眼分类网络的所述全连接层对每个类别c的预测输出sc,表示为:

19、

20、其中,x,y为输入眼底图像的尺寸,fk(x,y)为resnet网络输出的第k个特征图对输入眼底图像上空间位置(x,y)的映射激活,是类别c对应的全连接层的权重值,表示第k个特征图的全局平均池化操作;

21、所述cam模块通过将全连接层的权重传播到最后一个卷积层的特征映射,输出各类别c的网络注意力图ac,表示为:

22、

23、进一步地,训练青光眼分类网络的损失由分类损失和注意力一致性混合损失构成,采用青光眼分类类别作为监督信号构建分类损失,采用专家凝视注意力图像作为监督信号构建注意力一致性混合损失;其中,分类损失采用交叉熵,注意力一致性混合损失具体表示为:

24、

25、式中,lac代表注意力一致性混合损失;σ是一个学习参数,用于减轻专家凝视注意力图g中隐藏的不确定性;x,y为输入眼底图像的尺寸,(x,y)为输入眼底图像的像素点空间位置;a表示青光眼分类网络预测类别的注意力图,g表示专家凝视注意力图。

26、一种电子设备,包括存储器及处理器,所述存储器中存储有计算机程序,所述计算机程序被所述处理器执行时,使得所述处理器实现上述任一项所述的基于眼动信号监督的青光眼诊断方法。

27、一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现上述任一项所述的基于眼动信号监督的青光眼诊断方法。

28、有益效果

29、本发明基于眼动信号监督的青光眼诊断方法,从专业医生阅片时的眼动信号中提取专家凝视注意力图像,作专家领域知识以辅助基于深度网络的青光眼分类网络训练,解决了已有青光眼诊断医学图像仅使用图像级的标注对模型进行训练非常容易产生过拟合现象,以及精细标注成本高昂且需要花费大量时间的问题,能有效地帮助基于深度网络的青光眼分类模型快速并准确地定位图像中的异常区域,从而提升cad模型的诊断性能及可解释性。具体而言,本发明的有益效果如下:

30、1、本发明引入了专家眼动信息作为深度模型的监督信号,这些眼动信息在一定程度上反映了专家的领域知识,可以在不影响临床工作者正常工作流程的前提下,有效地帮助深度模型快速并准确地定位图像中的异常区域,以提升cad模型的诊断性能及可解释性。

31、2、本发明所设计的眼动信息后处理算法对视觉步长进行了建模,可以根据视觉轨迹计算任意两个凝视点之间的步长,通过设置注意力水平阈值,进而区分注视点与扫视点,并保留滑动窗口内的所有注视点,同时舍弃所有扫视点,从而识别出真正专注于图像病变的眼球运动片段。

32、3、本发明通过对仅保留注视点构成的图像进行高斯滤波处理,滤除了眼动仪原始数据序列中包含的一些无关的噪声信息(例如对于图像边缘的凝视等)。实验结果表明:经过后处理的注意力图包含的噪声较少,且经过后处理算法得到的注意力图可以有效提升诊断关键区域的定位性能。

33、4、本发明的青光眼分类网络(眼动引导注意力网络)由专家凝视注意力图、输入图像、在imagenet上训练的resnet骨干结构、全局平均池化层、全连接层、relu激活层、cam模块、网络注意力图、注意力一致性混合损失组成。采用在imagaenet数据集上预训练过的经典的resnet网络作为骨干来构建基于眼底图像的青光眼cad系统。在resnet的最后一个stage中采用空洞卷积,并将步长设置为1,由此可以有效保证注意力图的细粒度。随后,执行全局平均池化操作,并接入一个全连接层,以产生对应于所需类别的输出。使用cam模块来生成深度网络的注意力图,cam通过将全连接层的权重传播到最后一个卷积层的特征映射,来达到以激活图的方式揭示深度学习模型决策的重要区域的目的。将cam作为在线可训练模块,cam通过共享全连接层的权重来聚合特征图,可较好地达到眼动监督的目的。

34、5、本发明在骨干网络中增加了注意力一致性模块来确保深度神经网络的注意力与专家的眼动视觉注意力一致,并将其与分类的骨干网络集成。增强注意力一致性的简单方法是最小化两注意力图之间的均方误差。为此,设计了两个参数g和a。其中g用来表示专家凝视注意力图,a用来表示深度神经网络预测类别的注意力图。基于mse的约束严格要求模型与专家注视注意力图之间的一致性,但是在现实环境中,经过后处理的专家注视注意力图也是存在扭曲与畸变的。为此,本发明方法使用均方差不确定性来模拟视觉注意力并排除由于受试者的不同而产生的差异。对于深度模型的优化训练,可最大化注意力图的对数似然。结合这一优化目标,提出了注意力一致性混合损失lac。实验结果表明:所提出的注意力一致性混合损可有效提升青光眼分类网络的性能。

本文地址:https://www.jishuxx.com/zhuanli/20241009/306426.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表