融合动态异构超图神经网络与Transformer的视觉文本问答学习方法

- 国知局

- 2024-11-21 11:30:14

本发明涉及深度学习及其在多模态数据处理中的应用,特别是一种用于视觉文本问答任务的深度学习处理方法,该方法通过结合超图(hypergraph)生成及其使用和transformer注意力机制,有效提升模型处理多模态数据(如图像和文本)的能力。

背景技术:

1、视觉文本问答(visual questionanswering,vqa)是计算机视觉和自然语言处理领域的一个重要研究方向,旨在使计算机系统能够理解图像内容并回答关于这些图像的自然语言问题。现有技术中,虽然已有基于深度学习的方法用于处理vqa任务,但这些方法往往在处理复杂的、具有高阶结构的数据关系时存在局限性,尤其是在理解图像与文本之间复杂的关系及其内在结构。

2、起初,研究人员通过组合处理单模态任务的神经网络模型来处理多模态任务,如用于处理图像模态的卷积网络和用于处理文本模态的循环神经网络融合处理多模态任务。然而,由于不同模态之间错综复杂的相互作用,这些方法效果不佳。为了解决该问题,出现了两种主要策略来融合各模态特征:双线性池化和注意力机制,前者在图像识别领域取得了一定效果并且可以有效降低计算量,后者在各个领域的成功获得了更多关注。然而vqa任务中大多问题较为简短,所以很少有模型在vqa中将注意力纳入文本表征。除此之外注意力机制还难以推广到图结构数据中,它很难捕获对象之间复杂且相互交织的结构信息——这是利用注意力机制处理多模态任务的一个重要瓶颈。

3、进一步,为了处理无法直接在图结构数据上学习注意力权值的问题,学者们设计了图神经网络,用于将复杂的图结构数据表示为可以使用注意力机制的张量形式,并取得了不错的效果。与传统图的边连接一对节点不同,超图神经网络(hgnns)中超图的超边可以连接多个节点,使它们擅长模拟现实世界数据中复杂的相关性而不是简单的成对关联。正因如此,超图神经网络更加适用于多模态任务。然而,目前大多数基于超图的方法在构建超图和处理特征时将多个模态投影到一个共同空间中,进而忽略了一个事实,模态具有多样性,每个模态具有独特的特征,各模态中的对象之间同样存在着微妙的关系。

技术实现思路

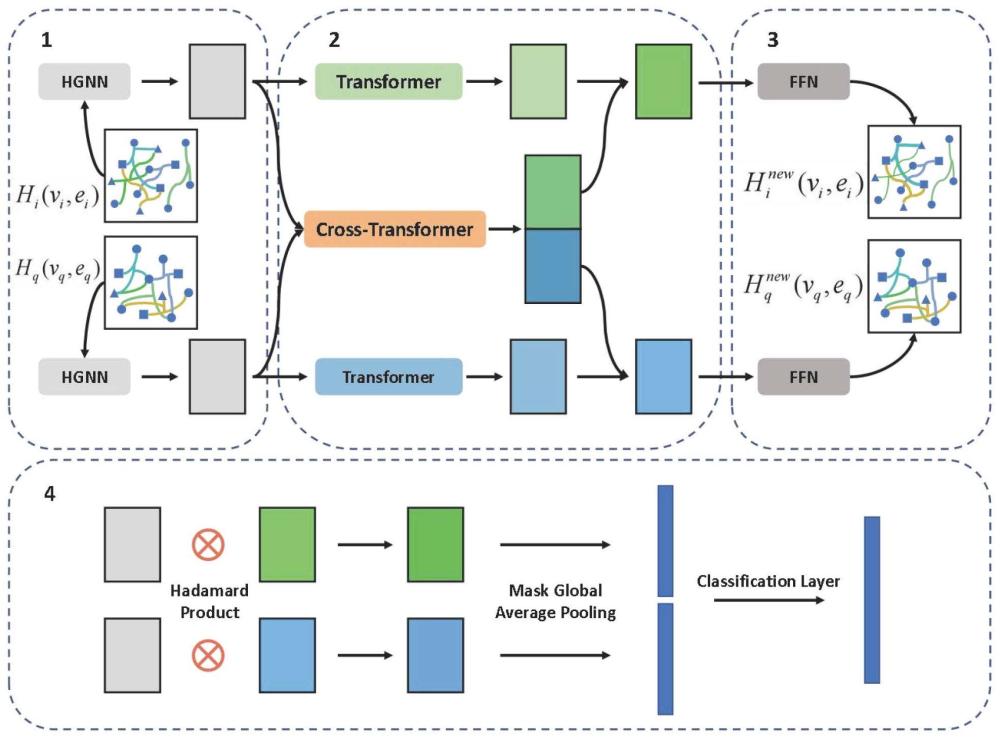

1、vqa任务需要理解多个对象之间的微妙关系,组合模态间的复杂信息,并专注于与答案相关的特定区域。因此,为了更好地处理多模态任务,我们发明了一种基于transformer组合注意力机制的动态异构超图神经网络模型(dhhg-tac),用于改善视觉文本问答任务的处理。

2、该模型由四个主要环节组成:超图神经网络环节(hgnn)、基于transformer的组合注意力环节、超图动态更新环节和多模态特征融合分类环节。

3、具体步骤如下:

4、步骤一:将图像的场景图信息和文本问题通过图结构化处理将数据预处理

5、a)对于图像模态,基于场景图信息构建图像的异构图表示,将场景图中的对象、属性和对象之间的关系定义为异构图的三种节点,而边的类型只有一种,表示是否连接,即属性->对象,对象->关系->对象,其中a->b表示节点a通过有向边连接节点b。

6、b)对于文本模态,使用已有的依赖树句法分析(spacy库),将问题句子解析成结构化信息,并根据句子的依赖关系构建图结构表示。

7、步骤二:基于随机游走生成超图的方式,将原始数据预处理成超图对

8、a)将使用预训练好的glove向量作为词嵌入,用来表示图中的每一个节点。

9、b)根据节点的词嵌入表示计算节点与节点之间的相似性,归一化后作为后续图上随机游走时节点转移的初始概率。

10、c)通过随机游走的路径不同,分别构建出两个模态的多条超边,并提取所包含的节点及其glove表示,作为超图的节点和节点特征。

11、至此,异构超图搭建完成。

12、步骤三:根据超边上的节点特征赋予初始超边权值,通过超图神经网络得到包含复杂结构关系的各模态特征。

13、a)对于超图卷积层具体的公式定义如下:

14、x(l+1)=σ(lx(l)θ(l)) (1)

15、

16、其中:为超图与节点v∈n和超边e∈e的关联矩阵。

17、

18、为对角矩阵表示节点度数,第ith对角元素为为表示超边度的对角矩阵,第jth对角元素为为表示超边权重的对角矩阵,第jth对角元素为第jth超边的权重。为超图的节点特征,c为特征维数。为网络模型中每个卷积层可学习的权重矩阵。

19、b)在所提出的模型中有两个超图神经网络,分别负责处理图像模态的超图和文本模态的超图。输入均为超图的入射矩阵h、超边权重矩阵b和超图节点特征矩阵x,得到的输出为超图卷积后的节点特征它们携带着对象之间复杂且交织的高阶结构特征,并且充分地捕获了各模态独特的特征。

20、步骤四:基于transformer的自注意力和交叉注意力机制,关注不同模态的各自特性及模态间的重要交互信息。

21、a)自注意力模块

22、hgnn卷积后的超图节点特征会被拆分成n个节点特征向量,并复制成三份即查询q、键k和值v,经过多头自注意力模块和前馈神经网络得到与节点特征相同维度的注意力权重输出。

23、自注意力模块可以描述为将查询q和一组键值对k、v映射到输出,输出计算为值v的加权和,其中分配给每个值的权重由查询与相应键的相似性计算得到,整体计算公式如下:

24、

25、其中dk是输入k的维度。

26、对于每个注意力头有:

27、

28、其中,wi为输入信息通过线性变换时的可学习的参数。此时的输出张量中已经得到了各模态的所需要关注的注意力信息。

29、b)交叉注意力模块

30、使用交叉注意力来权衡和挖掘模态之间的交互信息,将与答案相关的两个模态的特定区域相关联。其计算与自注意力权值类似,只不过查询和键值对不是同一个模态的,分别得到图像查询在文本键值对下的注意力和文本查询在图像键值对下的注意力,便可以得到两个模态的交叉注意力权值了。

31、最后分别将两个模态的交叉注意力与对应模态的自注意力相加,便得到了权衡了图像和文本模态间不同特征的重要性且保留了各模态独有的重要特征。

32、步骤五:通过对两种注意力的组合,找到答案区域内的相关结构信息

33、通过超图神经网络得到单模态的特征输出,通过组合注意力层得到模态之间交互的特征权重,将二者组合,携带着单模态中对象之间的高阶结构特征以及单模态特有的信息,并且具有多模态之间的交互信息,能够很好的关注到与回答问题相关的重要信息。

34、由于训练批次中每个样本的节点数不一样,所以使用全局平均池化处理结合后的输出,最后合并起来通过分类层得到答案。

35、步骤六:通过得到的注意力权值,动态更新超图对的超边权重

36、组合后的注意力权重通过前馈神经网络(ffn)的线性转换,得到与超边数一致的维度。根据对应超边所包含的节点计算超边的新权重,最后与更新前的超边权重矩阵做点乘,得到更新后的超边权重矩阵,并作为下次训练时的输入。

37、本发明的有益效果为:

38、(1)通过动态异构超图结构,模型能够更精确地捕捉和利用图像与文本之间的复杂关系,提升问题理解和答案生成的准确性。

39、(2)利用transformer框架的自注意力和交叉注意力机制,动态调整模型对不同模态特征的关注度,以及模态间的交互信息,提升对答案相关信息的准确捕捉。

40、(3)通过前馈神经网络根据注意力机制得到的权重动态更新超图的超边权重,进一步细化模型对关键信息的识别和处理能力。

41、(4)在两个公认的vqa数据集上对dhhg-tac模型进行了测试,实验结果证明了模型在处理复杂多模态数据时的优越性能。

本文地址:https://www.jishuxx.com/zhuanli/20241120/331491.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表