基于扩散模型的视频生成方法、装置以及设备与流程

- 国知局

- 2024-11-25 15:18:30

本发明涉及视频预测领域,尤其涉及基于扩散模型的视频生成方法、装置以及设备。

背景技术:

1、实现视频预测通常需要依赖于深度学习和人工智能技术,特别是卷积神经网络(cnns)、循环神经网络(rnns)及其变种(如lstm、gru、transformer等),上述模型能够从大量的视频数据中学习到模式和规律,进而做出准确的预测。随着技术的进步,视频预测的应用范围将会越来越广泛,精度也会不断提高。

2、扩散模型(diffusion models)是一种强大的生成模型,最初主要用于图像生成任务,但近年来也被应用于视频预测等领域。但视频不仅仅是多个静态图像的简单组合,更重要的是帧与帧之间存在时间上的连贯性和动态变化。如何确保生成的视频帧之间保持自然流畅的过渡对扩散模型而言是一个难题。

技术实现思路

1、本发明实施例通过提供基于扩散模型的视频生成方法、装置以及设备,解决了现有技术中基于扩散模型预测得到的视频能时间一致性不高的技术问题,实现了基于训练完成的扩散模型预测得到的视频能保持时间一致性的技术效果。

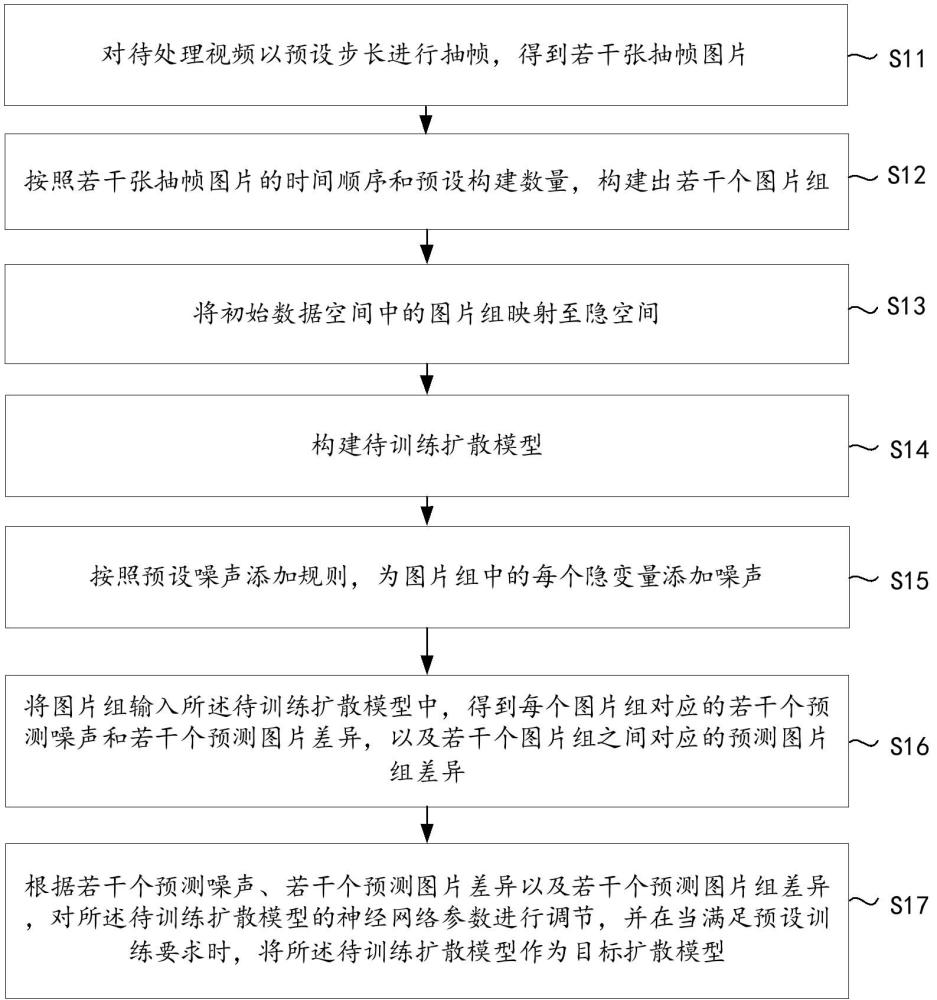

2、第一方面,本发明提供了基于扩散模型的视频生成方法,方法包括:

3、对待处理视频以预设步长进行抽帧,得到若干张抽帧图片;

4、按照若干张抽帧图片的时间顺序和预设构建数量,构建出若干个图片组,其中,预设构建数量至少为3张,并且除第一个图片组外,每个图片组依次包含上一个图片组中的第一张抽帧图片和最后一张抽帧图片;

5、将初始数据空间中的图片组映射至隐空间,其中,图片组中的每张抽帧图片对应一个隐变量;

6、构建待训练扩散模型,待训练扩散模型的输入为图片组,待训练扩散模型的输出为预测噪声、预测图片组差异与预测图片差异;

7、按照预设噪声添加规则,为图片组中的每个隐变量添加噪声;

8、将图片组输入待训练扩散模型中,得到每个图片组对应的若干个预测噪声和若干个预测图片差异,以及若干个图片组之间对应的预测图片组差异;

9、根据若干个预测噪声、若干个预测图片差异以及若干个预测图片组差异,对待训练扩散模型的神经网络参数进行调节,并在当满足预设训练要求时,将待训练扩散模型作为目标扩散模型。

10、进一步地,根据若干个预测噪声、若干个预测图片差异以及若干个预测图片组差异,对待训练扩散模型的神经网络参数进行调节,包括:

11、根据每个图片组中各个隐变量对应的预测噪声以及实际添加噪声,得到各个隐变量对应的预测噪声差异;

12、根据图片组中任意两个隐变量之间的预测图片差异以及该两个隐变量之间的实际图片差异,得到该两个隐变量之间对应的第一预测差异;

13、根据任意两个图片组之间的预测图片组差异以及该两个图片组之间的实际图片组差异,得到该两个隐变量之间对应的第二预测差异;

14、根据若干预测噪声差异、若干第一预测差异以及若干第二预测差异,对待训练扩散模型的神经网络参数进行调节。

15、进一步地,将初始数据空间中的图片组映射至隐空间,其中,图片组中的每张抽帧图片对应一个隐变量,包括:

16、对图片组中的每张抽帧图片进行编码,提取语言特征和空间位置特征;

17、将初始数据空间中的图片组映射至隐空间,并根据每张抽帧图片的语言特征和空间位置特征,得到每张抽帧图片对应的隐变量。

18、进一步地,待训练扩散模型的损失函数,包括:

19、

20、其中,为总差异,为预测噪声差异,为第一预测差异,为第二预测差异,a和b均为预设权重。

21、进一步地,关于第二预测差异,包括:

22、

23、其中,为像素差异的期望值,为第n个图片组与第m个图片组之间的预测像素差异,为第n个图片组与第m个图片组之间的实际像素差异,为光流差异的期望值,为第n个图片组与第m个图片组之间的预测光流差异,为第n个图片组与第m个图片组之间的实际光流差异,为循环差异的期望值,为从第m图片组循环回第n图片组的预测循环差异,为从第m组图片循环回第n组的实际循环差异,、以及均为预设权重。

24、进一步地,关于预测噪声差异,包括

25、

26、其中,为预测噪声的期望值,为第n个图片组中,隐变量q的预测噪声与实际添加噪声的预测噪声差异。

27、进一步地,图片组中的抽帧图片的顺序,包括:

28、除第一个图片组外,其余的图片组中的第一张抽帧图片为该图片组的上一个图片组中的第一张抽帧图片;

29、该图片组的第二张抽帧图片为该图片组的上一个图片组中的最后一张抽帧图片;

30、该图片组的第三张抽帧图片为按照抽帧顺序排列在该图片组的第二张抽帧图片之后的抽帧图片。

31、进一步地,方法还包括:

32、将去噪后的隐变量输出,并按照时间顺序,在隐空间内得到第一视频;

33、将第一视频映射回初始数据空间,并将第一视频作为目标视频。

34、第二方面,本发明提供了基于扩散模型的视频生成装置,装置包括:

35、抽帧模块,用于对待处理视频以预设步长进行抽帧,得到若干张抽帧图片;

36、分组模块,用于按照若干张抽帧图片的时间顺序和预设构建数量,构建出若干个图片组,其中,预设构建数量至少为3张,并且除第一个图片组外,每个图片组依次包含上一个图片组中的第一张抽帧图片和最后一张抽帧图片;

37、映射模块,用于将初始数据空间中的图片组映射至隐空间,其中,图片组中的每张抽帧图片对应一个隐变量;

38、构建模块,用于构建待训练扩散模型,待训练扩散模型的输入为图片组,待训练扩散模型的输出为预测噪声、预测图片组差异与预测图片差异;

39、添加模块,用于按照预设噪声添加规则,为图片组中的每个隐变量添加噪声;

40、差异获取模块,用于将图片组输入待训练扩散模型中,得到每个图片组对应的若干个预测噪声和若干个预测图片差异,以及若干个图片组之间对应的预测图片组差异;

41、训练调节模块,用于根据若干个预测噪声、若干个预测图片差异以及若干个预测图片组差异,对待训练扩散模型的神经网络参数进行调节,并在当满足预设训练要求时,将待训练扩散模型作为目标扩散模型。

42、第三方面,本发明提供了一种电子设备,包括:

43、处理器;

44、用于存储处理器可执行指令的存储器;

45、其中,处理器被配置为执行以实现如第一方面提供的基于扩散模型的视频生成方法。

46、本发明实施例中提供的一个或多个技术方案,至少具有如下技术效果或优点:

47、本发明提供了基于扩散模型的视频生成方法,方法包括:

48、对待处理视频以预设步长进行抽帧,得到若干张抽帧图片;按照若干张抽帧图片的时间顺序和预设构建数量,构建出若干个图片组,其中,预设构建数量至少为3张,并且除第一个图片组外,每个图片组依次包含上一个图片组中的第一张抽帧图片和最后一张抽帧图片;将初始数据空间中的图片组映射至隐空间,其中,图片组中的每张抽帧图片对应一个隐变量;构建待训练扩散模型,待训练扩散模型的输入为图片组,待训练扩散模型的输出为预测噪声、预测图片组差异与预测图片差异;按照预设噪声添加规则,为图片组中的每个隐变量添加噪声;将图片组输入待训练扩散模型中,得到每个图片组对应的若干个预测噪声和若干个预测图片差异,以及若干个图片组之间对应的预测图片组差异;根据若干个预测噪声、若干个预测图片差异以及若干个预测图片组差异,对待训练扩散模型的神经网络参数进行调节,并在当满足预设训练要求时,将待训练扩散模型作为目标扩散模型。本发明的每个图片组的第一张抽帧图片都是前一个图片组的第一张抽帧图片,确保了每个图片组的起点与前一个图片组的起点一致,增强了时间上的连贯性;每个图片组的第二张抽帧图片是前一个图片组的最后一张抽帧图片,进一步确保了每个图片组的起点和终点之间的连续性,使得待训练扩散模型能够更好地捕捉帧间的过渡,通过按照上述方式进行分组,使得相邻图片组之间的变化更加平滑,减少了突变和不连续性,由于相邻图片组之间的变化更加平滑,待训练扩散模型可以更快地收敛以及训练过程中更好地泛化,减少过拟合的风险。更进一步讲,为了使训练完成的扩散模型在时间和空间上都具有自然的动态,通过上述方式进行分组,可使得待训练扩散模型更好地学习如何在生成过程中保留重要的特征和细节,从而提高生成视频的质量,使得生成的视频在时间上更加连贯和平滑。

49、本发明通过对图片组中的每张抽帧图片进行编码,提取语言特征和空间位置特征,并将语言特征和空间位置特征映射到隐空间,可以使高维数据转化为低维数据,并且在基于上述抽帧图片的分组的前提下,隐变量不仅保留了语言特征和空间位置特征,同时还保留了图片组中每张图片的顺序,也保留了图片组的顺序,换而言之,通过分组——映射过程,在保留时间一致性的前提下,减少了计算复杂度,提高了计算效率。

50、本发明若按照【方式1】进行调节,可以使得在相同输入条件下,增加计算样本,以增强待训练扩散模型的训练效果,实现使训练得到扩散模型实现一致性的目的;若按照【方式2】进行调节,有助于待训练扩散模型更好理解图片组之间的时间关系,抽帧图片之间的时间关系,更利于完成时间一致性的训练,使得训练完成的扩散模型预测得到的视频的保持时间一致性。

51、本发明在确定图片组差异时,不仅考虑了像素差异,还考虑了总的光流差异和总的循环差异,相较于仅考虑图片之间的差异,本发明将图片组进行循环对比、像素对比以及光流对比,使得预测得到的视频连续性更好,时间的一致性更好。

本文地址:https://www.jishuxx.com/zhuanli/20241125/337276.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表