一种利用噪声图像实现新视图合成的方法

- 国知局

- 2024-12-06 12:51:56

本发明属于三维重建,涉及一种新视图合成方法。

背景技术:

1、三维重建是计算机视觉和图形学领域的一个重要研究方向,其目的是通过对二维图像数据的处理和分析,重建物体或场景的三维模型。目前,三维重建已经广泛应用于医学影像、文物保护、自动驾驶和智慧城市等多个领域。传统的重建算法主要依赖于显式的表达方式,例如体素、网格、点云等。然而,这些方法在重建过程中常常出现“孔洞”和伪影,难以连续的重建场景中的细节和纹理。相比之下,基于神经辐射场(nerf)的重建技术通过神经网络的隐式表达,显著提高了重建的细节和逼真度,并且具备从新颖视角生成高质量图像的能力。然而,由于大量的使用多层感知机(mlp)以及对空白区域的不必要采样,场景重建的效率显著降低。3d gaussian splatting (3d gs)使用各向异性的3d高斯以及基于tile的光栅化技术,不仅保证了视图的合成质量的,而且加速了训练和渲染时间。

2、尽管最近的新视图合成技术已经在理想化的数据下展现出了极高的潜力与令人瞩目的成效,但在实际应用中仍面临着挑战。例如在低光照条件下,由于环境光线的不足,相机往往需要采用高iso(感光度)设置并延长曝光时间来捕捉足够的图像信息。虽然这些措施能在一定程度上缓解光线不足的问题,但是也不可避免地导致图像的噪声增加。这些噪声不仅降低了图像的清晰度,还对后续的场景重建和视图合成构成了严重的阻碍,如图1所示。

3、目前的新视图合成技术主要依赖于高质量的图像输入以及精确的初始化点云,而带噪声的输入图像很难满足重建所需要的理想条件容易导致重建失败。为了解决这个问题,一个直观的解决办法就是先对含噪声的图像进行去噪处理,然后使用处理后的图像对场景进行重建,合成新视角视图。虽然这种方法能够在一定程度上提高重建的质量,但是对不同视图独立去噪会产生细节处理的差异,导致视图间的不一致对应,如图2所示。

4、nan基于ibrnet的方法,在多个场景中进行训练,利用nerf的固有能力在多个视图之间整合信息,展示了nerf技术在突发去噪方向上的优势。然而,这种基于多帧去噪的方法仅在相邻帧间差异较小的情况下有效,一旦输入视图的位姿差异较大时则会导致视图合成失败。

技术实现思路

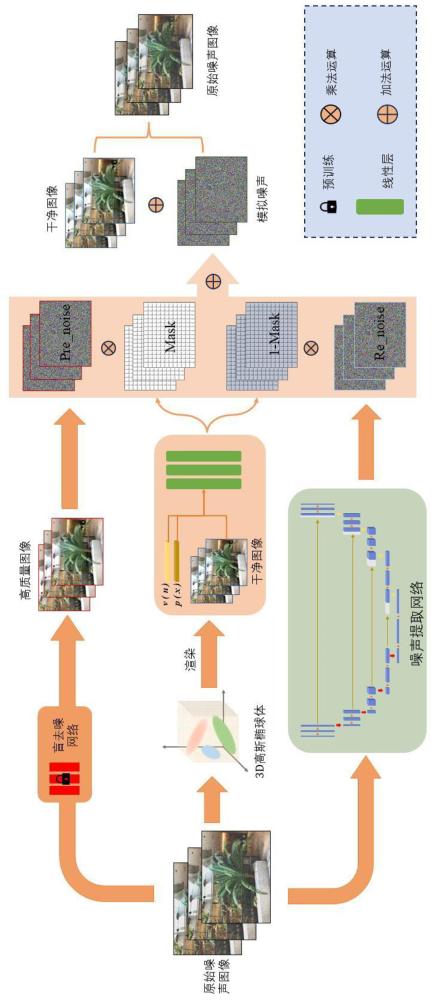

1、为了解决传统新视图合成方法在噪声输入条件下难以进行新视图合成的问题,确保视角几何一致性,本发明提供了一种利用噪声图像实现新视图合成的方法。该方法能够利用一系列带噪声的图像重建出清晰场景并合成任意视角下的清晰视图。

2、本发明的目的是通过以下技术方案实现的:

3、一种利用噪声图像实现新视图合成的方法,包括如下步骤:

4、步骤(1)利用colmap方法从多视角的噪声图像中得到初始位姿并初始化3d高斯椭球体;

5、步骤(2)利用预训练的盲图像去噪网络从输入的噪声图像中获取高质量图像并提取初始的噪声分布,具体步骤如下:

6、将噪声图像输入到一个预训练的盲图像去噪网络中进行去噪处理,得到去噪后的高质量图像,然后将原始的噪声图像与其相减,得到初始的噪声分布:

7、

8、步骤(3)利用基于u-net的噪声提取网络从原始噪声图像中进一步提取精细的噪声分布:

9、

10、步骤(4)将步骤(1)生成的3d高斯椭球体从场景中渲染得到预测的图像,设计网络联合图像、视角与位置信息,学习每像素的噪声掩码,利用噪声掩码将提取的噪声分布加权,模拟真实噪声,具体步骤如下:

11、步骤(41)空间中每个高斯椭球体的3d高斯分布由以下公式表示:

12、

13、其中,σ是协方差矩阵,表示高斯分布的形状和方向,μ是均值,表示高斯分布的中心位置;

14、步骤(42)将表示椭球体的3d高斯分布投影到2d高斯分布,投影后的协方差矩阵σ′由下式给出:

15、

16、其中,是视图变换矩阵,j是仿射变换的雅可比矩阵;高斯椭球体在2d空间中的位置可由步骤(1)初始化的位姿进行投影得到;

17、步骤(43)在渲染过程中,使用快速的gpu排序算法和基于tile的光栅化技术渲染图像,具体方法如下:

18、二维图像空间中每个tile被视为一个单元,对其基于深度进行排序并使用α-混合的方式进行渲染,经过渲染得到任意视角下的图像中每个像素的颜色:

19、(4)

20、其中,表示与该像素重叠的所有高斯分布集合,是2d高斯分布的颜色,是密度;

21、步骤(44)设计残差网络和多层感知机相结合的网络,该网络通过学习逐像素的掩码控制步骤(2)和步骤(3)提取的噪声分布的权重,以适应不同视图及视图内部像素间噪声的异质性,具体步骤如下:

22、首先,利用卷积神经网络从步骤(43)渲染的图像中提取rgb特征;

23、然后,将提取的rgb特征与可学习的视角嵌入和位置嵌入作为特征输入网络,其中为视图索引,为像素坐标

24、最后,通过sigmoid函数,将学习到的掩码特征映射到0和1之间,得到最终的掩码,公式如下:

25、

26、

27、步骤(5)利用模拟的噪声分布与3d高斯椭球体渲染的图像结合,预测噪声图像,具体步骤如下:

28、步骤(51)利用步骤(4)学习到的掩码,将步骤(2)和步骤(3)中提取的噪声进行融合:

29、

30、步骤(52)将融合后的噪声与3d高斯渲染得到的图像相加,得到预测的带噪声图像:

31、

32、步骤(6)将预测的噪声图像与输入的原始噪声图像建立颜色损失,联合结构相似性损失、掩码损失约束整个重建过程,优化特征提取网络和3d高斯椭球体的属性。

33、相比于现有技术,本发明具有如下优点:

34、本发明通过从噪声图像中训练生成清晰场景模型,并从新视角渲染高质量视图,有效解决了传统新视图合成依赖清晰图像输入,但在低光环境下,图像容易受噪声影响,导致质量下降的问题。

技术特征:1.一种利用噪声图像实现新视图合成的方法,其特征在于所述方法包括如下步骤:

2.根据权利要求1所述的利用噪声图像实现新视图合成的方法,其特征在于所述步骤(4)的具体步骤如下:

3.根据权利要求2所述的利用噪声图像实现新视图合成的方法,其特征在于所述步骤(43)的具体方法如下:

4.根据权利要求2所述的利用噪声图像实现新视图合成的方法,其特征在于所述步骤(44)的具体步骤如下:

5.根据权利要求1所述的利用噪声图像实现新视图合成的方法,其特征在于所述步骤(5)的具体步骤如下:

6.根据权利要求1所述的利用噪声图像实现新视图合成的方法,其特征在于所述颜色损失定义如下:

技术总结本发明公开了一种利用噪声图像实现新视图合成的方法,所述方法如下:(1)从噪声图像中得到初始位姿并初始化3D高斯椭球体;(2)利用盲图像去噪网络从噪声图像中获取高质量图像并提取初始的噪声分布;(3)利用噪声提取网络从原始噪声图像中提取精细的噪声分布;(4)将3D高斯椭球体从场景中渲染得到预测的图像,设计RM网络联合图像、视角与位置信息,学习每像素的噪声掩码,利用噪声掩码将提取的噪声分布加权,模拟真实噪声;(5)利用模拟的噪声分布与3D高斯椭球体渲染的图像结合,预测噪声图像;(6)优化特征提取网络和3D高斯椭球体的属性。该方法能够利用一系列带噪声的图像重建出清晰场景并合成任意视角下的清晰视图。技术研发人员:高长波,孙秋成,王春艳,霍佳奇,黄孝严,杨晨,袁云,张清源受保护的技术使用者:长春师范大学技术研发日:技术公布日:2024/12/2本文地址:https://www.jishuxx.com/zhuanli/20241204/342858.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。