一种基于深度学习的动态自适应3D模型生成方法

- 国知局

- 2024-12-06 13:08:33

本技术涉及图像处理领域,尤其涉及一种基于深度学习的动态自适应3d模型生成方法。

背景技术:

1、传统的3d模型生成方法通常依赖于手动建模、激光扫描、结构光测量等技术。这些方法不仅对硬件要求高,且在处理不同类型的数据时缺乏灵活性,往往需要手动调整参数。即使是基于计算机视觉和深度学习的3d重建方法,仍存在处理复杂场景时细节丢失和模型生成不稳定的问题。

2、因此,亟需一种更加自动化且具有高鲁棒性的3d模型生成方法,能够自适应地处理不同类型的数据,在模型生成过程中保持精度以及保留细节。

技术实现思路

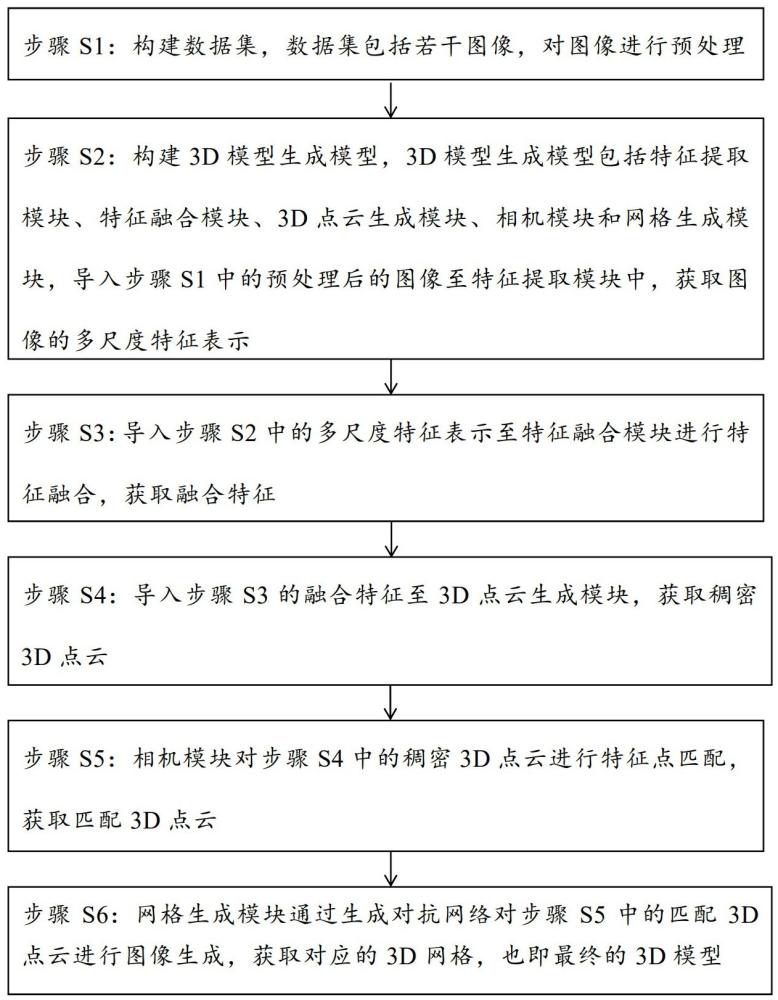

1、针对现有3d模型生成方案中存在的缺陷,本发明提供一种基于深度学习的动态自适应3d模型生成方法,包括以下步骤:

2、步骤s1:构建数据集,数据集包括若干图像,对图像进行预处理;

3、步骤s2:构建3d模型生成模型,3d模型生成模型包括特征提取模块、特征融合模块、3d点云生成模块、相机模块和网格生成模块,导入步骤s1中的预处理后的图像至特征提取模块中,获取图像的多尺度特征表示;

4、步骤s3:导入步骤s2中的多尺度特征表示至特征融合模块进行特征融合,获取融合特征;

5、步骤s4:导入步骤s3的融合特征至3d点云生成模块,获取多视角图像特征,通过三角化方法对多视角图像特征进行处理,获取初步3d点云,基于初步3d点云进一步引入几何约束和边缘保留机制并融合深度信息来生成稠密3d点云;

6、步骤s5:相机模块对步骤s4中的稠密3d点云进行特征点匹配,获取匹配3d点云,在此过程中,获取动态调整的相机模块的位置和姿态;

7、步骤s6:网格生成模块通过生成对抗网络对步骤s5中的匹配3d点云进行图像生成,获取对应的3d网格,也即最终的3d模型。

8、进一步的,步骤s1中的对图像进行预处理,具体为:

9、步骤s11:获取图像的最优参数组合;最优参数组合包括最优亮度调整参数、最优降噪系数、最优边缘增强系数和最优对比度参数;

10、步骤s12:图像标准化,使用最优亮度调整参数对图像进行标准化,确保在不同光照条件下图像亮度的一致性;

11、步骤s13:自适应降噪,通过最优降噪系数对图像中的噪声进行自适应降噪,减少噪声对3d重建的干扰;

12、步骤s14:边缘增强,根据最优边缘增强系数对图像中的边缘进行增强,确保在3d模型生成时边缘特征的清晰度;

13、步骤s15:对比度调整,利用最优对比度参数对图像的对比度进行调整,增强图像的细节表现力。

14、进一步的,步骤s2中的导入步骤s1中的预处理后的图像至特征提取模块中,获取图像的多尺度特征表示;具体为:

15、特征提取模块通过构建多尺度卷积神经网络在多个不同的尺度上同时提取输入的图像的特征;表示为:

16、;

17、其中,表示图像在第个尺度上提取的特征,也即图像的多尺度特征表示,表示多尺度卷积神经网络,表示输入的图像;多尺度卷积神经网络的每个尺度的卷积层具有不同的感受野,用于捕捉不同层次的图像信息。

18、进一步的,步骤s3具体为:

19、对图像的多尺度特征表示进行加权组合,获取融合特征,表示为:

20、;

21、其中,表示不同尺度的数量,代表第个尺度的权重。

22、进一步的,步骤s4具体为:

23、步骤s41:引入视角参数以对应实际场景中的多视角,生成第个视角下的融合特征对应的视角融合特征;表示为:

24、;

25、其中,表示特征提取操作,采用卷积神经网络实现;表示第个视角下的视角融合特征;

26、对每个视角下的视角融合特征进行加权融合,形成融合视角特征表示,表示为:

27、;

28、其中,表示动态的权重参数,表示视角的总数;

29、步骤s42:通过三角化方法将融合视角特征表示映射到3d空间中,生成初步的3d点云;

30、三角化方法具体为:

31、获取融合视角特征表示的特征点在第个视角下的2d点,通过相机投影矩阵将2d点与3d点关联起来,形成投影方程,表示为:

32、;

33、;

34、其中,表示第个视角的相机投影矩阵,表示特征点在3d空间中的齐次坐标;

35、使用多个视角的投影方程获取3d点,通过最小化重投影误差来求解3d点的坐标,表示为:

36、;

37、其中,表示最小化函数,表示重投影误差;

38、步骤s42具体为:

39、通过对每个融合视角特征表示对应的特征点执行三角化方法,生成包含多个3d点的初步3d点云;表示为:

40、;

41、其中,且,分别表示通过三角化方法得到的每个特征点的3d坐标的横坐标、纵坐标和竖坐标,表示初步3d点云中的3d点的数量;

42、步骤s43:引入几何约束和边缘保留机制;具体为:

43、定义优化目标,表示为:

44、;

45、其中,和分别表示初步3d点云中相邻的3d点,表示连接3d点和3d点的权重;

46、步骤s44:融合深度信息从而优化初步3d点云的精度,将深度信息与融合特征进一步融合,生成的稠密3d点云;表示为:

47、;

48、其中,表示稠密3d点云,表示从第张图像的多尺度特征表示中生成具有深度信息的3d点云,表示图像的总数,表示深度信息的权重。

49、进一步的,步骤s5具体为:

50、步骤s51:相机模块对稠密3d点云中每个特征点对应的各帧图像进行特征提取,并通过flann算法获取匹配点,表示为:

51、;

52、其中,表示匹配得到的特征点,表示flann算法;表示在第帧图像数据中提取的特征点集合;表示在第帧图像数据中提取的特征点集合;

53、步骤s52:相机模块利用klt光流算法对特征点对图像在后续帧中进行跟踪,确保特征点的动态一致性,表示为:

54、;

55、其中,表示klt光流算法跟踪得到的特征点轨迹,也即匹配3d点云,表示klt光流算法;

56、步骤s53:对相机模块进行参数优化,表示为:

57、;

58、其中,表示最优的相机参数集合,表示误差损失函数,用于衡量得到的匹配3d点云与真实场景数据之间的差异;表示在第帧图像数据上,使用当前参数估计得到的3d点云结果;表示将相机参数应用于图像数据,生成与真实场景匹配的3d点云;表示第帧的真实场景数据;

59、引入自适应学习机制,实时调整各参数的权重,表示为:

60、;

61、其中,表示基于场景复杂度的自适应权重,表示图像帧的总数;

62、步骤s54:对相机模块在各帧中的位置和姿态进行精确估计,利用最优的相机参数集合,结合匹配3d点云计算每一帧的相机模块姿态,确保相机模块在动态场景中的准确定位;表示为:

63、;

64、其中,表示第帧的旋转矩阵,也即相机模块的在各帧中的位置,表示第帧的平移向量,也即相机模块在各帧中的姿态,表示姿态估计函数。

65、进一步的,步骤s6表示为:

66、通过生成对抗网络的生成器对匹配3d点云进行图像生成,获取3d网格,表示为:

67、;

68、其中,表示3d网格,表示生成器在第个尺度上生成的网格,表示第个尺度上的融合权重,表示输入的匹配3d点云。

69、与现有技术相比,本发明具有如下优点:

70、1)本发明通过引入自适应加权融合机制,能够在全局结构和细节特征之间取得良好平衡,确保在各种场景下生成高精度的3d模型。此外,通过引入视角参数和结合深度信息结合,进一步提升了3d生成的精度和一致性。

71、2)本发明通过结合flann算法和klt光流跟踪算法,能够实现高效且稳定的特征点匹配与跟踪,适用于动态变化场景中的3d生成任务,在处理快速变化的场景时表现出更高的稳定性和抗噪能力。

72、3)本发明不仅能够实时调整相机参数,还通过自适应权重机制,在处理复杂场景时表现出更高的精度和鲁棒性;本发明进一步通过结合多帧的姿态数据进行全局优化,能够进一步提升3d点云的生成质量。

本文地址:https://www.jishuxx.com/zhuanli/20241204/343275.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表