基于多模态的话者分离方法、装置、设备及存储介质与流程

- 国知局

- 2024-06-21 10:40:16

本申请属于音像识别,尤其涉及基于多模态的话者分离方法、装置、设备及存储介质。

背景技术:

1、说话人分离(speaker diarization),也叫话者分离,是指将语音按照说话人id分类,解决“who spoke when”的问题。现有技术中解决话者分离的问题,主要有以下几种方法:通过集成麦克风阵列的拾音麦克风进行话者分离和通过手拉手的鹅颈麦会议系统进行话者分离。

2、其中,通过集成麦克风阵列的拾音麦克风进行话者分离,是通过麦克风阵列拾取音频,麦克风阵列的音频算法对原始音频进行信号处理后,送给语音识别和话者分离引擎做音频处理,语音识别引擎输出语音转文字的结果,话者分离引擎对并给每段文字标记出说话人的信息。

3、通过手拉手的鹅颈麦会议系统进行话者分离,是通过每位参会人,面前有一个专用的鹅颈麦,通过不同的物理设备,可以区分出音频来源,不同来源的音频分别送识别引擎,从而实现说话人区分。

4、但是现有技术中的话者分离方法存在着不同的缺陷,

5、其中,通过集成麦克风阵列的拾音麦克风进行话者分离,只通过声音的声纹特征做说话人区分,区分准确率偏低,相似嗓音的说话人,区分准确率偏低。

6、通过手拉手的鹅颈麦会议系统进行话者分离,是通过物理设备区分说话人,虽然准确率较高,但是要求说话人与鹅颈麦一一对应,不能出现多人使用同一鹅颈麦或交换座位的情况。

7、除此之外,话者分离还具有以下几个难点:事先不知道有多少个说话人;不清楚说话人的id;多人同时说话;不同语音的音频条件都不同。

技术实现思路

1、本申请的目的,在于提供一种基于多模态的话者分离方法、装置、设备及存储介质,通过获取图像数据和音频数据,基于图像识别技术对图像数据进行处理,基于语音活动检测技术和波达方向定位技术对音频数据进行处理,得到多模态数据,基于多模态数据实现话者分离。

2、为了达成上述目的,本申请的解决方案是:

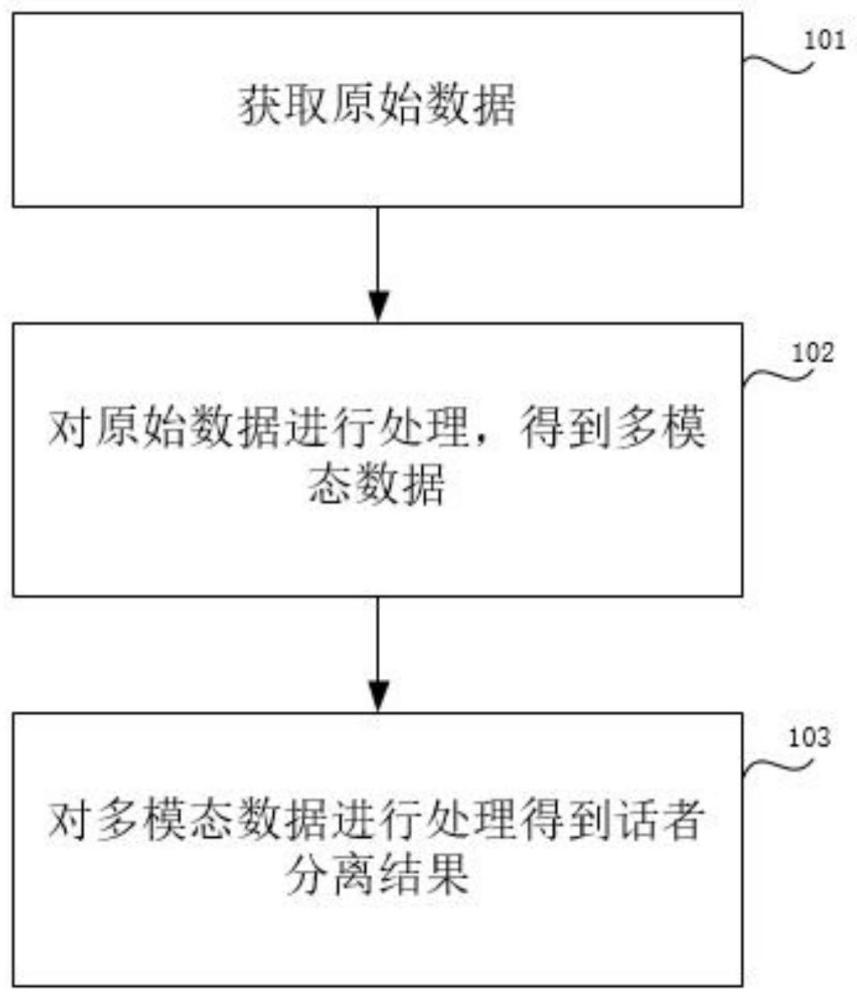

3、第一方面,本申请实施例提供了一种基于多模态的话者分离方法,包括:

4、获取原始数据,原始数据包括图像数据和音频数据;

5、对原始数据进行处理,得到多模态数据,多模态数据包括:对图像数据进行处理得到话者数量、话者位置坐标、每个话者对应的faceid;对音频数据进行处理得到话者声纹特征、话者doa角度和doa事件的开始时间和结束时间;

6、对多模态数据进行处理得到话者分离结果,处理方法包括:基于话者位置坐标和话者doa角度,判断在话者doa角度上是否存在说话人,若存在则根据doa事件的开始时间和结束时间对每个话者对应的faceid进行时间标记,结合话者数量和话者声纹特征得到话者分离结果。

7、根据本申请实施例的上述方法,还可以具有以下附加技术特征:

8、进一步的,对图像数据进行处理还得到话者唇部运动特征,

9、对多模态数据进行处理得到话者分离结果,处理方法还包括:

10、基于话者位置坐标和话者doa角度,判断在话者doa角度上是否存在说话人,若存在则根据话者唇部运动特征得到说话人说话的开始时间和结束时间,与doa事件的开始时间和结束时间进行对比,判断说话人说话的开始时间和结束时间与doa事件的开始时间和结束时间是否相同,若相同则对每个话者对应的faceid进行时间标记,结合话者数量和话者声纹特征得到话者分离结果。

11、进一步的,对音频数据进行处理得到话者doa角度和doa事件的开始时间和结束时间之前,还包括对音频数据进行降噪处理。

12、进一步的,图像数据和音频数据在时域上对齐,对齐方法包括:在获取原始数据时,保持图像数据和音频数据的同步获取。

13、进一步的,对齐方法还包括:在对原始数据进行处理时,分别减去图像数据对应的处理延时和音频数据对应的处理延时。

14、进一步的,其特征在于,通过图像识别技术对图像数据进行处理,得到话者数量、话者位置坐标、每个话者对应的faceid和话者唇部运动特征。

15、进一步的,其特征在于,通过语音活动检测技术vad和波达方向定位技术doa对音频数据进行处理,得到话者doa角度和doa事件的开始时间和结束时间。

16、第二方面,本申请实施例提供了一种基于多模态的话者分离装置,装置包括:

17、数据获取模块,被配置为用于获取原始数据,原始数据包括图像数据和音频数据;

18、数据处理模块,被配置为用于对原始数据进行处理,得到多模态数据,多模态数据包括:对图像数据进行处理得到话者数量、话者位置坐标、每个话者对应的faceid和话者唇部运动特征;对音频数据进行处理得到话者doa角度和doa事件的开始时间和结束时间;

19、话者分离模块,被配置为用于对多模态数据进行处理得到话者分离结果,处理方法包括:基于话者位置坐标和话者doa角度,判断在话者doa角度上是否存在说话人,若存在则根据doa事件的开始时间和结束时间对每个话者对应的faceid进行时间标记,结合话者数量和话者声纹特征得到话者分离结果。

20、第三方面,本申请实施例提供了一种基于多模态的话者分离系统,系统包括处理器和存储器,存储器中存储有计算机程序,计算机程序由处理器加载并执行,以实现本申请实施例第一方面提供的一种基于多模态的话者分离方法。

21、第四方面,本申请实施例提供了一种计算机可读存储介质,存储介质中存储有计算机程序,计算机程序被处理器执行时,用于实现本申请实施例第一方面提供的一种基于多模态的话者分离方法。

22、本申请实施例,通过图像识别技术对图像数据进行处理得到话者数量、话者位置坐标、每个话者对应的faceid和话者唇部运动特征;通过语音活动检测技术和波达方向定位技术对音频数据进行处理得到话者声纹特征、话者doa角度和doa事件的开始时间和结束时间;基于上述多模态数据实现话者分离,和现有技术相比,采用本申请实施例的话者分离方法,相比仅通过单模态的纯音频进行话者分离,可以提高分离准确率,通过语音活动检测技术可以得到说话人的角度,结合图像数据中的话者位置坐标,可以有效区分相似嗓音的说话人,提高区分的准确率;通过图像数据可以得到话者数量,解决了事先不知道有多少个说话人的问题,结合每个话者对应的faceid,可以在多人同时说话的情况下,根据每个话者对应的faceid有效区分出具体的说话人;根据图像数据中的话者唇部运动特征可以得到说话人说话的开始时间和结束时间,结合音频数据中的doa事件的开始时间和结束时间,可以准确地捕捉到当前的说话人,并记录说话人说话的开始时间和结束时间,提高话者分离的准确度。

技术特征:1.一种基于多模态的话者分离方法,其特征在于,所述方法包括:

2.如权利要求1所述的话者分离方法,其特征在于,对所述图像数据进行处理还得到话者唇部运动特征,

3.如权利要求1所述的话者分离方法,其特征在于,对所述音频数据进行处理得到话者doa角度和doa事件的开始时间和结束时间之前,还包括对所述音频数据进行降噪处理。

4.如权利要求1所述的话者分离方法,其特征在于,所述图像数据和所述音频数据在时域上对齐,所述对齐方法包括:在获取所述原始数据时,保持所述图像数据和所述音频数据的同步获取。

5.如权利要求4所述的话者分离方法,其特征在于,所述对齐方法还包括:在对所述原始数据进行处理时,分别减去所述图像数据对应的处理延时和所述音频数据对应的处理延时。

6.如权利要求1所述的话者分离方法,其特征在于,通过图像识别技术对所述图像数据进行处理,得到所述话者数量、所述话者位置坐标、所述每个话者对应的faceid和所述话者唇部运动特征。

7.如权利要求1所述的话者分离方法,其特征在于,通过语音活动检测技术vad和波达方向定位技术doa对所述音频数据进行处理,得到所述话者doa角度和doa事件的开始时间和结束时间。

8.一种基于多模态的话者分离装置,其特征在于,所述装置包括:

9.一种基于多模态的话者分离系统,所述系统包括处理器和存储器,所述存储器中存储有计算机程序,其特征在于,所述计算机程序由所述处理器加载并执行,以实现如权利要求1至7任一项所述的基于多模态的话者分离方法。

10.一种计算机可读存储介质,所述存储介质中存储有计算机程序,其特征在于,所述计算机程序被处理器执行时,用于实现如权利要求1至7任一项所述的基于多模态的话者分离方法。

技术总结本申请公开一种基于多模态的话者分离方法、装置、设备及存储介质,涉及音像识别技术领域。该方法包括:获取原始数据,对所述原始数据进行处理,得到多模态数据,对所述多模态数据进行处理得到话者分离结果。处理方法包括:基于所述话者位置坐标和所述话者DOA角度,判断在所述话者DOA角度上是否存在说话人,若存在则根据所述DOA事件的开始时间和结束时间对所述每个话者对应的FaceID进行时间标记,结合话者数量和话者声纹特征得到话者分离结果。本申请实施例和现有技术相比,可以有效区分相似嗓音的说话人,提高区分的准确率;可以在多人同时说话的情况下,准确地捕捉到当前的说话人,并记录说话人说话的开始时间和结束时间,提高话者分离的准确度。技术研发人员:宋洪博,王艳龙,陈永波,沈峥嵘,储磊受保护的技术使用者:思必驰科技股份有限公司技术研发日:技术公布日:2024/1/22本文地址:https://www.jishuxx.com/zhuanli/20240618/21077.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表