基于视觉跟踪的唇语图像识别方法和装置

- 国知局

- 2024-06-21 10:39:37

本发明属于图像,特别涉及一种基于视觉跟踪的唇语图像识别方法和装置。

背景技术:

1、唇语识别(lip reading,lr),是一种在没有声音时通过分析用户唇部图像序列,依靠口型特征和特定语音之间的对应关系,判断用户的语言内容的技术,是人工智能的新方向。唇语识别涉及模式识别、计算机视觉、图像处理和自然语言处理等技术,多应用于信息安全、语音识别、驾驶辅助等领域。

2、基于视觉跟踪的唇读方法用于在无声或噪声干扰严重的环境下,或对于存在听觉障碍的人群,如何利用通过嘴唇运动进行语言识别至关重要。基于视觉跟踪的唇读方法可以通过观察和分析人说话时唇部运动的特征变化,识别出人所说话的内容,具有广阔的应用前景:在医疗健康领域,可以借助唇语识别辅助患有听力障碍的病人沟通交流;在安防领域,人脸识别同时通过唇语识别以提高活体识别的安全性。

3、早期的唇语识别大多基于隐马尔可夫模型(hidden markov model,hmm),离散余弦变换(discrete cosine transform,dct)等传统特征提取方法提取唇部图像的浅层特征(纹理特征、形状特征、颜色特征、拓扑特征),这些方法能够解决一定数据规模下识别精度不高的问题,但其实现时需要具备丰富唇读知识作为基础。此外,传统方法还存在泛化性不高的缺点。

4、近年来,随着大规模数据集的出现,基于深度学习的方法可以自动抽取深层特征,逐渐成为唇语识别研究的主流方法。基于深度学习的唇语识别方法将一系列的唇部图像送入前端以提取特征,然后传递给后端以进行分类预测,并以端到端的形式进行训练。由于卷积神经网络(cnn)具有强大的特征抽取能力,近年来逐渐成为唇语识别时空特征提取阶段的主流方法。

5、对于基于深度学习的唇语识别方法而言,如何获取有效的唇语图像,是该方法成功应用的关键。在有效唇语图像获取过程中,主要面临以下问题:一是人脸表情变化很大,真实环境光照复杂,而且现实中大量存在人脸局部被遮挡的情况等;二是人脸是3d的,位姿变化多样,另外因拍摄设备和环境影响,成像质量也有好有坏;三是现有训练样本各个类别存在不平衡的问题;四是在计算受限的设备比如手机终端,必须要考虑计算速度和模型文件大小问题。

技术实现思路

1、针对目前唇语图像获取过程中面临的突出问题,本发明公开了一种基于视觉跟踪的唇语图像识别方法和装置,通过实现模态协同表征共性内容,弥补单模态独立存在的表征残缺问题,建立模态信息深度融合机制下的唇语视频合成解决方案,优化高光照干扰模式下唇语识别效果,以此提升复杂场景下唇语识别的鲁棒性,从而扩展唇语识别的可实现性。

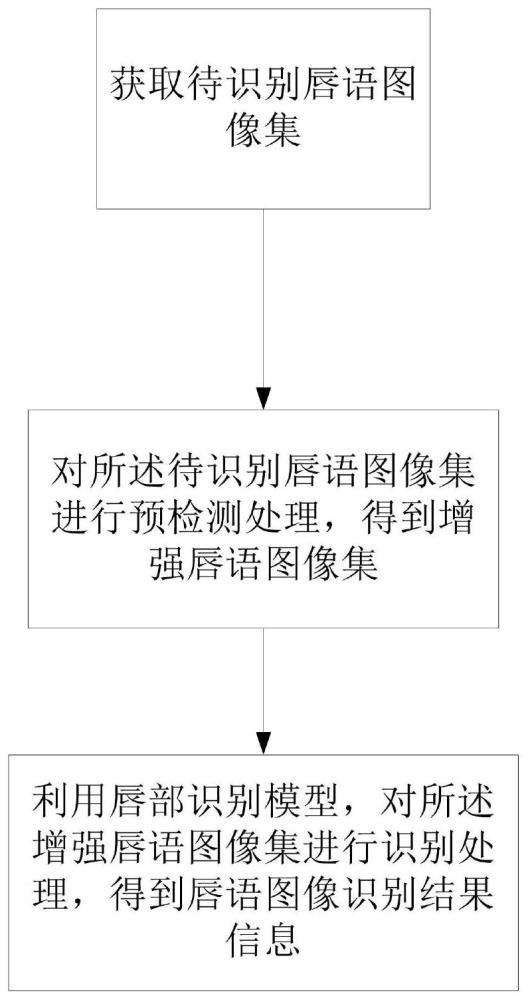

2、本发明公开了一种基于视觉跟踪的唇语图像识别方法,包括:

3、s1,获取待识别唇语图像集;所述待识别唇语图像集,包括若干个人脸图像;

4、s2,对所述待识别唇语图像集进行预检测处理,得到增强唇语图像集;

5、s3,利用唇部识别模型,对所述增强唇语图像集进行识别处理,得到唇语图像识别结果信息;所述唇语图像识别结果信息,用于表示所述唇语图像的唇部位置信息。

6、所述对所述待识别唇语图像集进行预检测处理,得到增强唇语图像集,包括:

7、s21,对所述待识别唇语图像集进行坐标变换处理,得到二维待识别唇语图像集;所述二维待识别唇语图像集,包括二维平面坐标下的人脸图像数据和特征点标注信息;所述特征点,包括人脸中的左眼、右眼、鼻子、嘴巴和眉毛;

8、s22,对所述二维待识别唇语图像集进行图像数据增强处理,得到增强唇语图像集。

9、所述唇部识别模型,包括第一识别网络和第二识别网络;所述第一识别网络,用于对所述人脸图像数据进行处理,得到唇部位置信息;所述第二识别网络,用于对人脸图像数据进行姿态预测处理,得到人脸姿态类别信息和人脸姿态角度信息;

10、所述第一识别网络,包括第一输入模块、第一卷积模块、深度可分离卷积模块、第一升维卷积模块、第二升维卷积模块、第三升维卷积模块、第四升维卷积模块、第二卷积模块、第一池化模块、第三卷积模块和第一全连接模块;

11、所述第一识别网络的第一输入模块的输入端,用于接收所述增强唇语图像集;所述第一识别网络的第一输入模块的输出端,与所述第一识别网络的第一卷积模块的输入端相连接;所述第一识别网络的第一卷积模块的输出端,与所述第一识别网络的深度可分离卷积模块的输入端相连接;所述第一识别网络的深度可分离卷积模块的输出端,与所述第一识别网络的第一升维卷积模块的输入端相连接;所述第一识别网络的第一升维卷积模块的输出端,与所述第一识别网络的第二升维卷积模块的输入端相连接;所述第一识别网络的第二升维卷积模块的输出端,与所述第一识别网络的第三升维卷积模块的输入端相连接;所述第一识别网络的第三升维卷积模块的输出端,与所述第一识别网络的第四升维卷积模块的输入端相连接;所述第一识别网络的第四升维卷积模块的输出端,与所述第一识别网络的第二卷积模块的输入端相连接;所述第一识别网络的第二卷积模块的输出端,与所述第一识别网络的第一池化模块的输入端相连接;所述第一识别网络的第一池化模块的输出端,与所述第一识别网络的第三卷积模块的输入端相连接;所述第一识别网络的第三卷积模块的输出端,与所述第一识别网络的第一全连接模块的输入端相连接;

12、所述第二识别网络,包括第二输入模块、第四卷积模块、第五卷积模块、第六卷积模块、第二池化模块、第七卷积模块、第二全连接模块和第三全连接模块;

13、所述第二识别网络的第二输入模块的输入端,与所述第一识别网络的第二升维卷积模块的输出端相连接;所述第二识别网络的第二输入模块的输出端,与所述第二识别网络的第四卷积模块的输入端相连接;所述第二识别网络的第四卷积模块的输出端,与所述第二识别网络的第五卷积模块的输入端相连接;所述第二识别网络的第五卷积模块的输出端,与所述第二识别网络的第六卷积模块的输入端相连接;所述第二识别网络的第六卷积模块的输出端,与所述第二识别网络的第二池化模块的输入端相连接;所述第二识别网络的第二池化模块的输出端,与所述第二识别网络的第七卷积模块的输入端相连接;所述第二识别网络的第七卷积模块的输出端,与所述第二识别网络的第二全连接模块的输入端相连接;所述第二识别网络的第二全连接模块的输出端,与所述第二识别网络的第三全连接模块的输入端相连接;

14、所述第一识别网络的第一全连接模块的输出端,用于输出所述唇部识别模型的唇语图像识别结果信息。

15、在利用唇部识别模型,对所述增强唇语图像集进行识别处理,得到唇语图像识别结果信息之前,还包括:

16、s301,获取训练样本集;所述训练样本集,包括若干个人体图片训练样本;所述人体图片训练样本,包括人体图像数据和人体标注信息;所述人体标注信息,包括人体目标在人体图片的位置信息;

17、s302,对所述训练样本集进行坐标变换处理,得到二维训练样本集;所述二维训练样本集,包括二维平面坐标下的人体图像数据和人体标注信息;

18、s303,利用图像特征检测模型,对所述二维训练样本集进行特征检测,得到第一特征点图像集;所述第一特征点图像集,包括对齐后的人脸的特征点图像数据和人脸特征点信息;所述人脸特征点信息,包括对齐后的人脸图像数据中的特征点的类别信息和位置信息、对齐后的人脸姿态类别信息和对齐后的人脸姿态角度信息;所述人脸姿态类别包括侧脸、正脸、抬头、低头、表情、遮挡;所述人脸姿态角度信息,包括人脸的第一姿态角、第二姿态角和第三姿态角;所述第一姿态角,是人脸所在平面的法线,相对于水平面上的矢状向的偏转角度;所述第二姿态角,是人脸所在平面的法线,相对于水平面上的矢状向的垂线的偏转角度;所述第三姿态角,是人脸所在平面的法线,相对于大地垂直方向的偏转角度;

19、s304,利用第一特征点图像集对所述唇部识别模型进行训练处理,得到训练完毕的唇部识别模型。

20、所述利用第一特征点图像集对所述唇部识别模型进行训练处理,得到训练完毕的唇部识别模型,包括:

21、s3041,对第一特征点图像集进行分割处理,得到训练特征点集合和测试特征点集合;所述训练特征点集合,包括若干个特征点训练样本;所述特征点训练样本,包括特征点图像数据和特征点标注信息;所述测试特征点集合,包括若干个特征点测试样本;所述特征点测试样本,包括测试特征点图像数据和测试特征点标注信息;所述特征点标注信息和测试特征点标注信息,均包括对特征点的类型信息、特征点的位置信息、特征点所在人脸的人脸姿态类别信息和人脸姿态角度信息的标注结果;

22、s3042,将所述训练特征点集合的特征点图像数据,输入唇部识别模型,得到识别训练结果集合;所述识别训练结果集合,包括若干个特征点识别训练结果;所述特征点识别训练结果,包括识别得到的特征点图像数据和特征点估计信息;所述特征点估计信息,包括特征点的类型信息、特征点的位置信息、特征点所在人脸的人脸姿态类别信息和人脸姿态角度信息的估计结果;

23、s3043,利用唇部识别模型的损失函数,对所述识别训练结果集合和训练特征点集合进行计算处理,得到损失函数值信息;

24、s3044,判断所述损失函数值信息的损失函数值是否满足收敛条件,得到第一判断结果;

25、当所述第一判断结果为否时,判断所述损失函数值信息的迭代次数是否等于训练次数阈值,得到第二判断结果;

26、当所述第二判断结果为否时,确定模型训练状态为不满足终止训练条件;

27、当所述第二判断结果为是时,确定所述模型训练状态为满足终止训练条件;

28、当所述第一判断结果为是时,确定所述模型训练状态为满足终止训练条件;

29、当所述模型训练状态为不满足终止训练条件时,利用参数更新模型对所述第一识别网络的第一卷积模块、深度可分离卷积模块、第一升维卷积模块、第二升维卷积模块、第三升维卷积模块、第四升维卷积模块、第二卷积模块和第三卷积模块进行参数更新,执行s3041;

30、所述参数更新模型为:

31、

32、θ←θ+v;

33、式中,x(i)为训练特征点集合中的第i个特征点训练样本,y(i)为训练特征点集合中的第i个特征点训练样本对应的特征点标注信息,v为参数更新值,θ为所述第一识别网络的第一卷积模块、深度可分离卷积模块、第一升维卷积模块、第二升维卷积模块、第三升维卷积模块、第四升维卷积模块、第二卷积模块和第三卷积模块的参数,η为初始参数学习率,α为动量角度参数,0≤α≤π/4,表示针对变量θ求偏导数,f(x(i);θ)表示唇部识别模型对训练特征点集合中的第i个特征点训练样本得到的特征点估计信息,f(·)为唇部识别模型对应的计算函数;

34、当所述模型训练状态为满足终止训练条件时,将所述测试特征点集合输入唇部识别模型,得到识别测试结果集合;对所述识别测试结果集合中的特征点估计信息与所述测试特征点集合中的测试特征点标注信息进行比对处理,得到所述测试特征点集合的识别准确率值;

35、判断所述识别准确率值是否大于预设准确率阈值,得到第三判断结果;

36、若所述第三判断结果为不大于预设准确率阈值,执行s3041;

37、若所述第三判断结果为大于预设准确率阈值,完成对所述唇部识别模型的训练处理过程,得到训练完毕的唇部识别模型。

38、所述第一识别网络,其损失函数的表达式为:

39、

40、其中,m0表示所述训练特征点集合中的特征点训练样本数量,n表示人脸图像所包含的特征点总数,c0为人脸姿态类别数,为第c个人脸姿态类别下的第n个特征点的权重值,c表示人脸姿态类别的序号,n表示特征点序号,表示特征点估计信息中的对第m个特征点训练样本的第n个特征点所在人脸的第k姿态角的估计结果,与所述特征点标注信息中的第m个特征点训练样本的第n个特征点所在人脸的第k姿态角的标注结果之间的差值,k表示人脸姿态角度信息所包括的姿态角类型数,k=3;表示特征点估计信息中的对第m个特征点训练样本的第n个特征点位置信息的估计结果,与所述特征点标注信息中的第m个特征点训练样本的第n个特征点位置信息的标注结果之间的欧氏距离。

41、所述图像特征检测模型,包括:第一特征标注网络、第二特征标注网络和特征输出网络;

42、所述第一特征标注网络,包括输入层、第一卷积层、第二卷积层、第一池化层、第三卷积层和第一全连接层;

43、所述第一特征标注网络的输入层,接收所述二维训练样本集;所述第一特征标注网络的输入层的输出端,与所述第一特征标注网络的第一卷积层的输入端相连;所述第一特征标注网络的第一卷积层的输出端,与所述第一特征标注网络的第二卷积层的输入端相连;所述第一特征标注网络的第二卷积层的输出端,与所述第一特征标注网络的第一池化层的输入端相连;所述第一特征标注网络的第一池化层的输出端,与所述第一特征标注网络的第三卷积层的输入端相连;所述第一特征标注网络的第三卷积层的输出端,与所述第一特征标注网络的第一全连接层的输入端相连;

44、所述第二特征标注网络,包括输入层、第四卷积层、第五卷积层、第二池化层、第六卷积层和第二全连接层;

45、所述第二特征标注网络的输入层的输入端,与所述第一特征标注网络的第一全连接层的输出端相连接,也与所述第一特征标注网络的输入层的输出端相连;所述第二特征标注网络的输入层的输出端,与所述第二特征标注网络的第四卷积层的输入端相连;所述第二特征标注网络的第四卷积层的输出端,与所述第二特征标注网络的第五卷积层的输入端相连;所述第二特征标注网络的第五卷积层的输出端,与所述第二特征标注网络的第二池化层的输入端相连;所述第二特征标注网络的第二池化层的输出端,与所述第二特征标注网络的第六卷积层的输入端相连;所述第二特征标注网络的第六卷积层的输出端,与所述第二特征标注网络的第二全连接层的输入端相连;

46、所述特征输出网络,包括输入层、第七卷积层、第八卷积层、第三池化层、第九卷积层、第十卷积层和第三全连接层;

47、所述特征输出网络的输入层的输入端,与所述第二特征标注网络的第二全连接层的输出端相连接,也与所述第一特征标注网络的输入层的输出端相连;所述特征输出网络的输入层的输出端,与所述特征输出网络的第七卷积层的输入端相连;所述特征输出网络的第七卷积层的输出端,与所述特征输出网络的第八卷积层的输入端相连;所述特征输出网络的第八卷积层的输出端,与所述特征输出网络的第三池化层的输入端相连;所述特征输出网络的第三池化层的输出端,与所述特征输出网络的第九卷积层的输入端相连;所述特征输出网络的第九卷积层的输出端,与所述特征输出网络的第十卷积层的输入端相连;所述特征输出网络的第十卷积层的输出端,与所述特征输出网络的第三全连接层的输入端相连。

48、本发明还公开了一种基于视觉跟踪的唇语图像识别装置,所述装置包括:

49、存储有可执行程序代码的存储器;

50、与所述存储器耦合的处理器;

51、所述处理器调用所述存储器中存储的所述可执行程序代码,执行所述的基于视觉跟踪的唇语图像识别方法。

52、本发明还公开了一种计算机可存储介质,所述计算机存储介质存储有计算机指令,所述计算机指令被调用时,用于执行所述的基于视觉跟踪的唇语图像识别方法。

53、本发明还公开了一种信息数据处理终端,所述信息数据处理终端用于实现所述的基于视觉跟踪的唇语图像识别方法。

54、本发明的有益效果为:

55、本发明所构建的模型结构简单,硬件实现成本低,在移动端训练模型后能够对视频中的整脸进行唇部特征点标注以及切割。通过获得的特征点信息。可以对数据进行其他处理:如激活帧检测,唇部区域切割。以及通过唇部运动情况控制采集硬件运动装置。从而可以合理的调整耳机采集摄像头与唇部的位置;

56、本发明采用第二识别网络辅助监督第一识别网络训练后,可以使得模型的鲁棒性更好;

57、本发明使用轻量化网络对图片数据集进行训练,使得整个模型的容量在10mb以下。部署在移动端后可以极大的减轻移动端的算力负担。空出的计算资源可以用于数据处理以及识别。

本文地址:https://www.jishuxx.com/zhuanli/20240618/21020.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。