基于GPT神经网络的语音合成方法和装置与流程

- 国知局

- 2024-06-21 10:41:07

本技术涉及计算机,更具体地,涉及一种基于gpt神经网络的语音合成方法和装置。

背景技术:

1、随着人工智能(ai)技术的迅速发展,作为人机交互的一种方式,语音合成技术也随之受到了广泛的关注。

2、现有的语音合成技术(如基于卷积神经网络的语音合成)中,往往需要耗费大量时间长,如需要录制几分钟甚至几十分钟来训练以实现语音复刻。此外,语音合成的质量欠佳,如声音生硬或机械感格外强。因此,用户体验差。

技术实现思路

1、本技术实施例提供了一种基于生成式预训练变换器(generative pre-trainedtransformer,gpt)神经网络的语音合成方法和装置,能够快速实现语音复刻并有效地提高语音合成的质量,从而提高用户的体验。

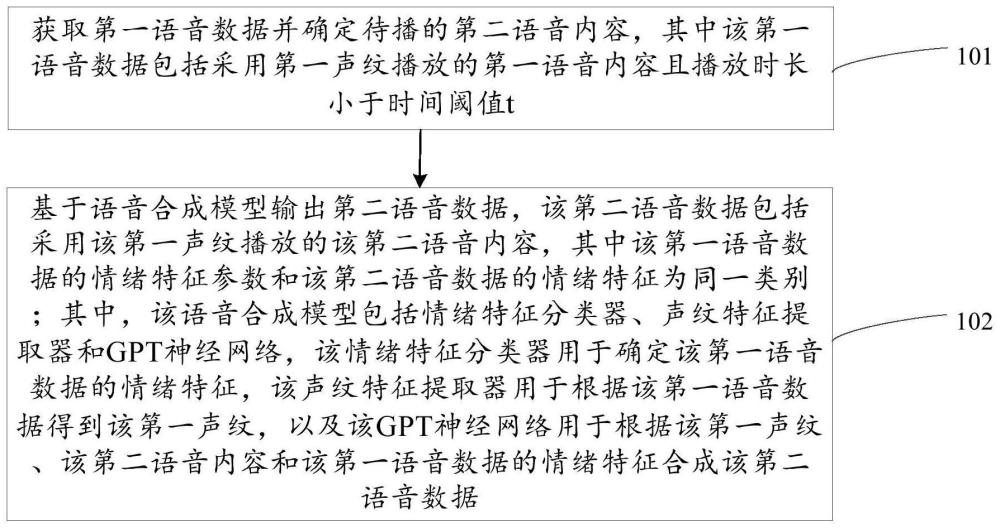

2、第一方面,提供了一种基于gpt神经网络的语音合成方法,该方法包括:获取第一语音数据并确定待播的第二语音内容,其中该第一语音数据包括采用第一声纹播放的第一语音内容且播放时长小于时间阈值t(如t小于或等于60秒);以及基于语音合成模型输出第二语音数据,该第二语音数据包括采用该第一声纹播放的该第二语音内容,其中该第一语音数据的情绪特征参数和该第二语音数据的情绪特征为同一类别;其中,该语音合成模型包括情绪特征分类器、声纹特征提取器和gpt神经网络,该情绪特征分类器用于确定该第一语音数据的情绪特征,该声纹特征提取器用于根据该第一语音数据得到该第一声纹,以及该gpt神经网络用于根据该第一声纹、该第二语音内容和该第一语音数据的情绪特征合成该第二语音数据,其中该gpt神经网络包括依次连接的嵌入层、n个解码模块和输出层,其中该n个解码模块中每个解码模块包括依次连接的掩码注意力层、第一归一化层、前向反馈层和第二归一化层,该n为大于1的整数。

3、结合第一方面,在第一方面的一种可能的实现方式中,在该基于语音合成模型输出第二语音数据的步骤中,可以将情绪特征和/或声纹特征作为该gpt神经网络的n个解码模块中任一解码模块的输入的一部分,或者也可以将情绪特征和/或声纹特征作为该gpt神经网络的输出层输入的一部分。

4、可选地,该情绪特征分类器输出的情绪特征作为该gpt神经网络的n个解码模块中任一解码模块的输入的一部分或者作为该gpt神经网络的输出层的输入的一部分,以及该声纹特征提取器输出的声纹特征作为该gpt神经网络的输出层的输入的一部分。

5、可选地,该声纹特征提取器输出的声纹特征作为该gpt神经网络的n个解码模块中任一解码模块的输入的一部分或者作为该gpt神经网络的输出层的输入的一部分,以及该情绪特征分类器输出的情绪特征作为该gpt神经网络的输出层的输入的一部分。

6、可选地,该情绪特征分类器输出的情绪特征作为该gpt神经网络的n个解码模块中第i个解码模块的输入的一部分,将声纹特征提取器输出的声纹特征均作为该gpt神经网络的n个解码模块中第j个解码模块的输入的一部分,其中,i为正整数且i≤n,j为正整数且j≤n,i和j可以相同或不同。

7、可选地,该情绪特征分类器输出的情绪特征输入该gpt神经网络的位置与声纹特征提取器输出的声纹特征输入该gpt神经网络的位置不同。进一步地,该情绪特征分类器输出的情绪特征输入该gpt神经网络的位置较前于声纹特征提取器输出的声纹特征输入该gpt神经网络的位置。

8、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该情绪特征分类器得到情绪特征、将该位置向量、该嵌入向量和该情绪特征叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块后的输出与该第一声纹叠加输入到该输出层,在该输出层输出该第二语音数据。

9、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该声纹特征提取器得到该第一声纹、将该位置向量、该嵌入向量和该第一声纹叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块后的输出与该情绪特征叠加后输入到该输出层,在该输出层输出该第二语音数据。

10、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该情绪特征分类器得到情绪特征、将该第一语音数据输入该声纹特征提取器得到该第一声纹,将该位置向量、该嵌入向量、该情绪特征和该第一声纹输入该n个解码模块中第一个解码模块的掩码注意力层,以及经过该n个解码模块后在该输出层输出该第二语音数据。

11、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该位置向量和该嵌入向量输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块后的输出与该第一声纹和该情绪特征叠加后输入到该输出层,在该输出层输出该第二语音数据。

12、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该情绪特征分类器得到情绪特征、将该位置向量、该嵌入向量和该情绪特征叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m1个解码模块后与该第一声纹叠加输入到第m1+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m1)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m1为小于n的正整数。

13、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该声纹特征提取器得到该第一声纹、将该位置向量、该嵌入向量和该第一声纹叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m2个解码模块后与该第一声纹叠加输入到第m2+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m2)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m2为小于n的正整数。

14、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该位置向量和该嵌入向叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m3个解码模块后与该情绪特征和该第一声纹叠加输入到第m3+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m3)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m3为小于n的正整数。

15、可选地,将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该位置向量和该嵌入向叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m4个解码模块后与该情绪特征/该第一声纹特征叠加输入到第m4+1个解码模块的掩码注意力层,经过该n个解码模块中剩余的解码模块中的前m5个解码模块后与该第一声纹/该情绪特征叠加后输入到第(m4+m5)+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m4-m5)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m4和m5为小于n的正整数且m4+m5<n。

16、结合第一方面和上述任一种可能的实现方式中,可选地,该每个解码模块采用残差结构,该残差结构包括将该每个解码模块的掩码注意力层的输入和输出作为该第一归一化层的输入、以及将该前向反馈层的输入和输出作为该第二归一化层的输入。可选地,每个特征提取模块采用残差结构,该残差结构包括将该每个特征提取模块的自注意力层的输入和输出作为其归一化层的输入。可选地,该输出层包括第三归一化层。

17、结合第一方面和上述任一种可能的实现方式中,在一种可能的实现方式中,情绪特征可以分为包括至少两种类别。例如,正性情绪特征和负性情绪特征两种,或者积极情绪特征、平稳情绪特征和消极情绪特征三种类别,或者“快乐”、“愤怒”、“悲哀”和“恐惧”四种类别,或者“愤怒”、“厌恶”、“恐惧”、“幸福”、“悲伤”和“惊讶”六种类别。

18、可选地,该第一语音数据输入该情绪特征分类器;以及将该情绪特征分类器中输出的概率值最高或输出为1所对应的情绪特征的类别确定为所述第一语音数据的情绪特征。

19、结合第一方面和上述任一种可能的实现方式中,在一种可能的实现方式中,该第一语音数据可以为即时录入的语音数据或者可以为已存储的语音数据。

20、第二方面,提供了一种基于gpt神经网络的语音合成装置,该装置包括处理单元和存储单元,该处理单元用于获取第一语音数据并确定待播的第二语音内容和用于基于该存储单元存储的语音合成模型输出第二语音数据,其中该第一语音数据包括采用第一声纹播放的第一语音内容且播放时长小于时间阈值t(如t小于或等于60秒),该第二语音数据包括采用该第一声纹播放的该第二语音内容,其中该第一语音数据的情绪特征参数和该第二语音数据的情绪特征为同一类别;其中,该语音合成模型包括情绪特征分类器、声纹特征提取器和gpt神经网络,该情绪特征分类器用于确定该第一语音数据的情绪特征,该声纹特征提取器用于根据该第一语音数据得到该第一声纹,以及该gpt神经网络用于根据该第一声纹、该第二语音内容和该第一语音数据的情绪特征合成该第二语音数据,其中该gpt神经网络包括依次连接的嵌入层、n个解码模块和输出层,其中该n个解码模块中每个解码模块包括依次连接的掩码注意力层、第一归一化层、前向反馈层和第二归一化层,该n为大于1的整数。

21、结合第二方面,在第二方面的一种可能的实现方式中,该处理单元可以用于将情绪特征和/或声纹特征作为该gpt神经网络的n个解码模块中任一解码模块的输入的一部分,或者也可以将情绪特征和/或声纹特征作为该gpt神经网络的输出层输入的一部分。

22、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该情绪特征分类器得到情绪特征、将该位置向量、该嵌入向量和该情绪特征叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块后的输出与该第一声纹叠加输入到该输出层,在该输出层输出该第二语音数据。

23、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该声纹特征提取器得到该第一声纹、将该位置向量、该嵌入向量和该第一声纹叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块后的输出与该情绪特征叠加后输入到该输出层,在该输出层输出该第二语音数据。

24、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该情绪特征分类器得到情绪特征、将该第一语音数据输入该声纹特征提取器得到该第一声纹,将该位置向量、该嵌入向量、该情绪特征和该第一声纹输入该n个解码模块中第一个解码模块的掩码注意力层,以及经过该n个解码模块后在该输出层输出该第二语音数据。

25、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该位置向量和该嵌入向量输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块后的输出与该第一声纹和该情绪特征叠加后输入到该输出层,在该输出层输出该第二语音数据。

26、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该情绪特征分类器得到情绪特征、将该位置向量、该嵌入向量和该情绪特征叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m1个解码模块后与该第一声纹叠加输入到第m1+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m1)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m1为小于n的正整数。

27、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该第一语音数据输入该声纹特征提取器得到该第一声纹、将该位置向量、该嵌入向量和该第一声纹叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m2个解码模块后与该第一声纹叠加输入到第m2+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m2)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m2为小于n的正整数。

28、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该位置向量和该嵌入向叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m3个解码模块后与该情绪特征和该第一声纹叠加输入到第m3+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m3)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m3为小于n的正整数。

29、可选地,该处理单元可以用于将该第二语音内容进行位置编码得到位置向量且将该第二语音内容输入该嵌入层得到嵌入向量、将该位置向量和该嵌入向叠加后输入该n个解码模块中第一个解码模块的掩码注意力层,经过该n个解码模块的前m4个解码模块后与该情绪特征/该第一声纹特征叠加输入到第m4+1个解码模块的掩码注意力层,经过该n个解码模块中剩余的解码模块中的前m5个解码模块后与该第一声纹/该情绪特征叠加后输入到第(m4+m5)+1个解码模块的掩码注意力层,经过该n个解码模块中的剩余的(n-m4-m5)个解码模块后输入到输出层,在该输出层输出该第二语音数据,其中m4和m5为小于n的正整数且m4+m5<n。

30、结合第二方面和上述任一种可能的实现方式中,可选地,该每个解码模块采用残差结构,该残差结构包括将该每个解码模块的掩码注意力层的输入和输出作为该第一归一化层的输入、以及将该前向反馈层的输入和输出作为该第二归一化层的输入。可选地,每个特征提取模块采用残差结构,该残差结构包括将该每个特征提取模块的自注意力层的输入和输出作为其归一化层的输入。可选地,该输出层包括第三归一化层。

31、结合第二方面和上述任一种可能的实现方式中,在一种可能的实现方式中,情绪特征可以包括至少两种类别。例如,正性情绪和负性情绪两种,或者积极情绪、平稳情绪和消极情绪三种类别,或者“快乐”、“愤怒”、“悲哀”和“恐惧”四种类别,或者“愤怒”、“厌恶”、“恐惧”、“幸福”、“悲伤”和“惊讶”六种类别。

32、可选地,该处理单元可以用于将该第一语音数据分别输入该情绪特征分类器;以及将该情绪特征分类器中输出概率值最高或输出为1所对应的情绪特征的类别确定为该第一语音数据的情绪特征。

33、结合第二方面和上述任一种可能的实现方式中,在一种可能的实现方式中,该第一语音数据可以为用户即时录入的语音数据或者可以为用户设备已存储的语音数据。

34、第三方面,提供了一种基于神经网络的语音合成装置,该装置包括处理器和存储器,该处理器与该存储器耦合,该处理器用于读取并执行该存储器中的指令,以实现上述第一方面中的任一种可能实现方式中的方法。

35、第四方面,提供了一种计算机程序产品,该计算机程序产品包括计算机程序代码,当该计算机程序代码被执行时,实现上述第一方面中的任一种可能实现方式中的方法。

36、在本技术实施例中,将第一语音数据和待播的第二语音内容输入基于gpt神经网络构建的语音合成模型,基于该语音合成模型生成具有与第一语音数据相同类别的情绪特征的第二语音数据。本技术基于gpt神经网络结合情绪特征分类器和声纹特征提取器训练得到的语音合成模型能够快速(如录制时间不超过1分钟)实现语音复刻,并且能更复刻语音的情绪,从而提高语音合成的质量,从而提高用户的体验。

本文地址:https://www.jishuxx.com/zhuanli/20240618/21193.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表