基于人工智能的数字人驱动方法及装置

- 国知局

- 2024-06-21 11:49:53

本发明涉及人工智能,特别涉及一种基于人工智能的数字人驱动方法及装置。

背景技术:

1、现如今,虚拟数字人的理论和技术日益成熟,逐渐在相关服务行业得到一定的推广应用。其中数字人驱动技术是数字人关键技术之一,是数字人交互的基础,决定了其应用上限。

2、目前,屏幕数字人需要深度学习进行数字人的表情、手势以及情绪上的驱动。因为深度学习需要大量的数据进行训练,对于在不同场景、不同用户和不同动作等情况下的数据收集和标注是一项艰巨的任务,并且深度学习模型通常是复杂的神经网络包含了大量的参数和层级结构。这导致了在训练和推断时需要较高的计算资源和时间。对于移动设备等资源受限的环境来说,可能会面临效率和性能方面的限制,从而导致实现数字人的驱动较为繁杂。

技术实现思路

1、有鉴于此,本发明的目的在于提供一种基于人工智能的数字人驱动方法及装置,旨在解决现有技术中通过深度学习进行数字人的表情、手势以及情绪上的驱动时智能化繁杂的问题。

2、本发明实施例是这样实现的:

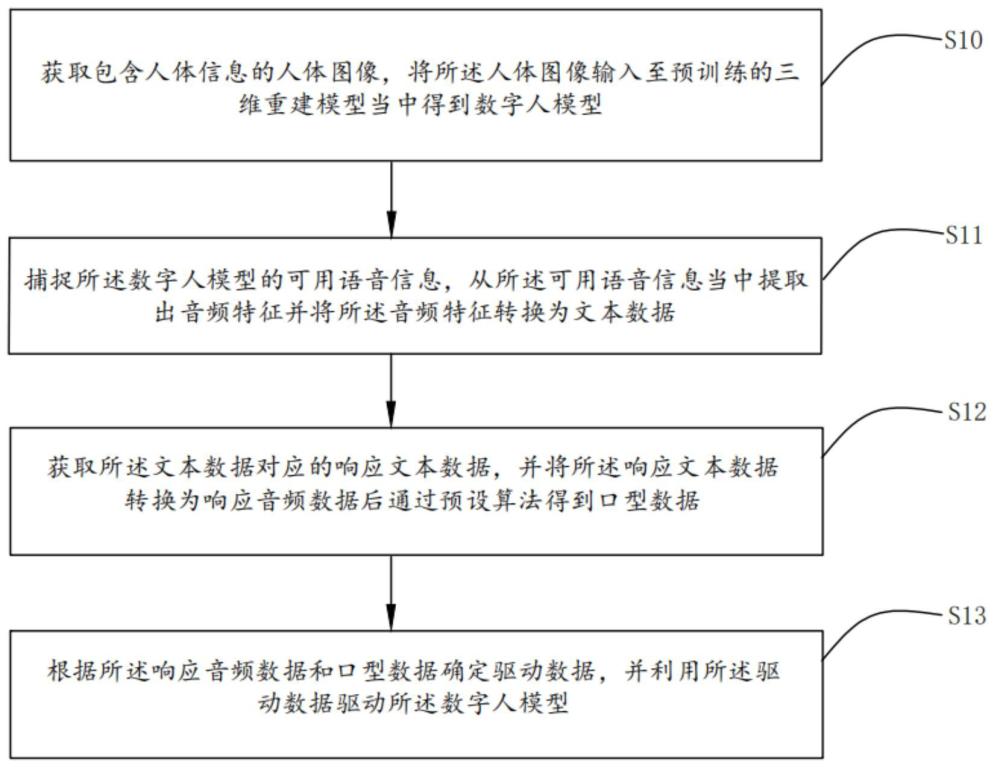

3、一种基于人工智能的数字人驱动方法,所述方法包括:

4、获取包含人体信息的人体图像,将所述人体图像输入至预训练的三维重建模型当中得到数字人模型;

5、捕捉所述数字人模型的可用语音信息,从所述可用语音信息当中提取出音频特征并将所述音频特征转换为文本数据;

6、获取所述文本数据对应的响应文本数据,并将所述响应文本数据转换为响应音频数据后通过预设算法得到口型数据;

7、根据所述响应音频数据和口型数据确定驱动数据,并利用所述驱动数据驱动所述数字人模型。

8、进一步的,上述基于人工智能的数字人驱动方法,其中,所述将所述人体图像输入至预训练的三维重建模型当中得到数字人模型的步骤包括:

9、获取所述人体图像当中的三维点的位置以及视角方向,根据所述三维点的位置以及视角方向通过所述预训练的三维重建模型得到所述三维点的颜色和体积密度;

10、根据所述三维点的颜色和体积密度得到所述人体图像的三维场景表示;

11、对所述三维场景表示进行光线追踪,计算沿着光线方向的场景颜色和透明度以对所述三维场景表示进行渲染得到所述数字人模型。

12、进一步的,上述基于人工智能的数字人驱动方法,其中,所述三维重建模型的训练步骤包括:

13、建立训练数据集,所述训练数据集包括多张历史人体图像以及对应的三维数字人模型;

14、将所述训练数据集输入至预设神经网络当中进行深度学习训练,直至所述预设神经网络的参数满足预设条件,以得到所述三维重建模型。

15、进一步的,上述基于人工智能的数字人驱动方法,其中,所述捕捉所述数字人模型的可用语音信息,从所述可用语音信息当中提取出音频特征并将所述音频特征转换为文本数据的步骤包括:

16、获取包含所述可用语音信息的语音信号,对所述语音信号进行分帧处理并分别在每一帧所述语音信号的开头和结尾加上窗函数;

17、将加窗后的所述语音信号进行归一化处理,以消除不同所述语音信号之间的幅度差异;

18、将归一化处理后的所述语音信号再次进行分帧和加窗处理后进行快速傅里叶变换得到对应的频域信号;

19、根据所述频域信号得到所述可用语音信息的所述音频特征,所述音频特征至少包括梅尔滤波器输出、线性预测系数、倒谱系数。

20、进一步的,上述基于人工智能的数字人驱动方法,其中,所述根据所述频域信号得到所述可用语音信息的所述音频特征的步骤包括:

21、使用梅尔滤波器组对所述频域信号进行滤波得到所述梅尔滤波器输出;

22、分别通过lpc分析以及倒谱分析,提取所述语音信号的线性预测系数以及倒谱系数。

23、进一步的,上述基于人工智能的数字人驱动方法,其中,所述将所述响应文本数据转换为响应音频数据的步骤包括:

24、将所述响应文本数据转换为音素序列,并将所述音素序列映射到声学特征以根据所述声学特征生成所述响应音频数据;

25、进一步的,上述基于人工智能的数字人驱动方法,其中,所述并将所述响应文本数据转换为响应音频数据后通过预设算法得到口型数据的步骤包括:

26、通过阈值分割算法对所述响应音频数据进行分割,并根据分割后的所述响应音频数据确定所述口型数据。

27、本发明的另一个在于提供一种基于人工智能的数字人驱动装置,所述装置包括:

28、获取模块,用于获取包含人体信息的人体图像,将所述人体图像输入至预训练的三维重建模型当中得到数字人模型;

29、捕捉模块,用于捕捉所述数字人模型的可用语音信息,从所述可用语音信息当中提取出音频特征并将所述音频特征转换为文本数据;

30、转换模块,用于获取所述文本数据对应的响应文本数据,并将所述响应文本数据转换为响应音频数据后通过预设算法得到口型数据;

31、驱动模块,用于根据所述响应音频数据和口型数据确定驱动数据,并利用所述驱动数据驱动所述数字人模型。

32、本发明的另一个目的在于提供一种可读存储介质,其上存储有计算机程序,所述程序被处理器执行时实现上述任意一项所述的方法的步骤。

33、本发明的另一个目的是提供一种电子设备,包括存储器、处理器以及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现上述的方法的步骤。

34、本发明通过获取包含人体信息的人体图像,将人体图像输入至预训练的三维重建模型当中得到数字人模型;捕捉数字人模型的可用语音信息,从可用语音信息当中提取出音频特征并将音频特征转换为文本数据;获取文本数据对应的响应文本数据,并将响应文本数据转换为响应音频数据后通过预设算法得到口型数据;根据响应音频数据和口型数据确定驱动数据,并利用驱动数据驱动数字人模型,只需依次语音捕捉和处理、文本分析和生成、面部表情和肢体动作控制,不需要复杂的神经网络深度学习驱动数字人,实现相对简单,并且利用语音数据将参与者的表达直接转换为数字人的表情和动作,使得交互更加自然和直观,不利用深度学习进行数字人的表情、手势以及情绪上的驱动。解决了现有技术中在通过深度学习进行数字人的表情、手势以及情绪上的驱动时智能化繁杂的问题。

技术特征:1.一种基于人工智能的数字人驱动方法,其特征在于,所述方法包括:

2.根据权利要求1所述的基于人工智能的数字人驱动方法,其特征在于,所述将所述人体图像输入至预训练的三维重建模型当中得到数字人模型的步骤包括:

3.根据权利要求1所述的基于人工智能的数字人驱动方法,其特征在于,所述三维重建模型的训练步骤包括:

4.根据权利要求1所述的基于人工智能的数字人驱动方法,其特征在于,所述根据所述频域信号得到所述可用语音信息的所述音频特征的步骤包括:

5.根据权利要求1所述的基于人工智能的数字人驱动方法,其特征在于,所述将所述响应文本数据转换为响应音频数据的步骤包括:

6.根据权利要求1所述的基于人工智能的数字人驱动方法,其特征在于,所述并将所述响应文本数据转换为响应音频数据后通过预设算法得到口型数据的步骤包括:

7.一种基于人工智能的数字人驱动装置,其特征在于,用于实现权利要求1至6中任意一项所述的基于人工智能的数字人驱动方法,所述装置包括:

8.一种可读存储介质,其上存储有计算机程序,其特征在于,所述程序被处理器执行时实现如权利要求1至6中任意一项所述的方法的步骤。

9.一种电子设备,其特征在于,包括存储器、处理器以及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现如权利要求1至6任一所述的方法的步骤。

技术总结本发明公开了一种基于人工智能的数字人驱动方法及装置,该方法包括:获取包含人体信息的人体图像,将所述人体图像输入至预训练的三维重建模型当中得到数字人模型;捕捉所述数字人模型的可用语音信息,从所述可用语音信息当中提取出音频特征并将所述音频特征转换为文本数据;获取所述文本数据对应的响应文本数据,并将所述响应文本数据转换为响应音频数据后通过预设算法得到口型数据;根据所述响应音频数据和口型数据确定驱动数据,并利用所述驱动数据驱动所述数字人模型。本发明解决了现有技术中在通过深度学习进行数字人的表情、手势以及情绪上的驱动时智能化繁杂的问题。技术研发人员:王琪璇,徐志贤,练佳仪,龚芸婧,朱杨熔,付庆庆,朱志亮受保护的技术使用者:华东交通大学技术研发日:技术公布日:2024/5/8本文地址:https://www.jishuxx.com/zhuanli/20240618/23833.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。