基于时间感知位置编码的语音合成方法及其模型训练方法与流程

- 国知局

- 2024-06-21 11:55:29

本发明涉及语音合成,具体而言,涉及基于时间感知位置编码的语音合成方法及其模型训练方法。

背景技术:

1、目前的零样本语音合成方案主要分为以建模梅尔频谱作为中间表示的非自回归模型和以建模音频编码为基础的自回归模型。其中基于梅尔频谱的非自回归模型输出的声音较为稳定,但是缺少对说话人的风格捕捉,声音较为平坦。而基于音频编码为基础的自回归模型虽然可以有效的捕获说话人的感情,但是训练效率低下,且模型无法很好捕捉每个字的发音时长。

2、其存在以下缺陷:1、风格捕捉不足:非自回归模型在生成个性化语音方面表现有限,无法充分模拟说话人的风格和情感。2、训练效率低下:自回归模型的训练过程耗时且资源密集,这限制了模型的可扩展性和实用性。3、发音时长捕捉不准确:自回归模型在模拟每个字的发音时长时存在困难,这影响了语音的自然流畅度。

3、有鉴于此,申请人在研究了现有的技术后特提出本技术。

技术实现思路

1、本发明提供了一种基于时间感知位置编码的语音合成方法及其模型训练方法,以改善上述技术问题中的至少一个。

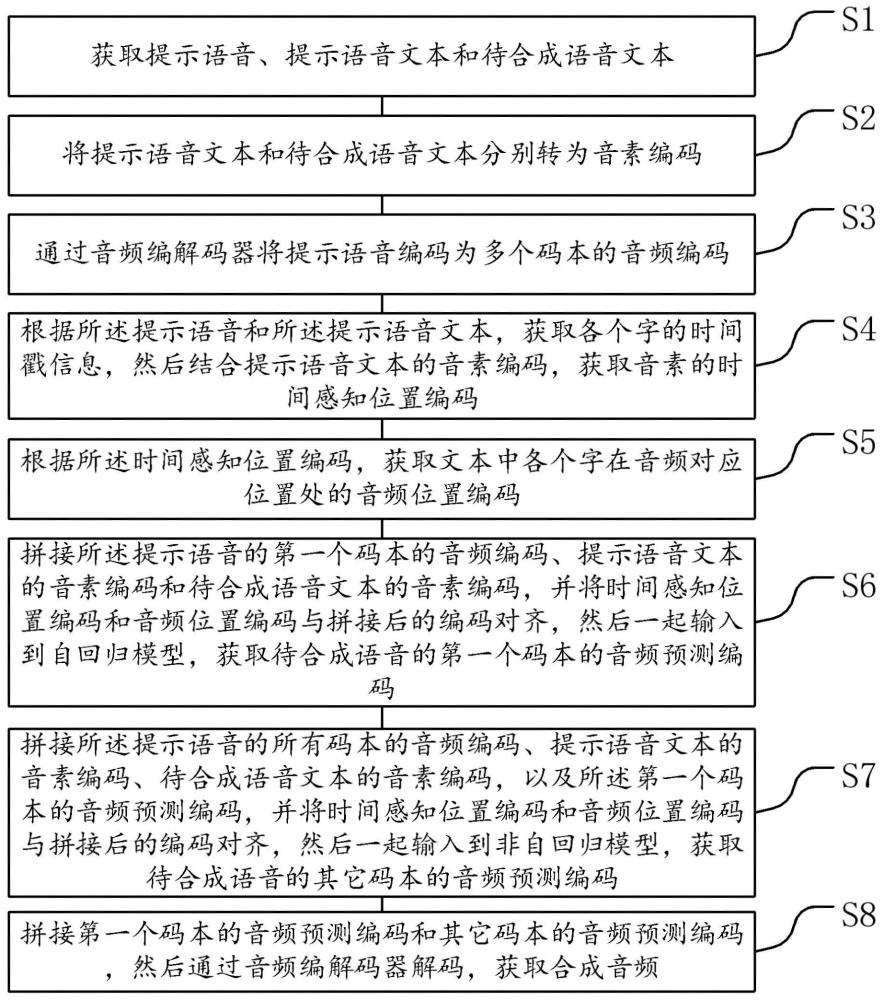

2、第一方面、本发明提供了一种基于时间感知位置编码的语音合成方法,其包含步骤s1至步骤s8。

3、s1、获取提示语音、提示语音文本和待合成语音文本。

4、s2、将提示语音文本和待合成语音文本分别转为音素编码。

5、s3、通过音频编解码器将提示语音编码为多个码本的音频编码。

6、s4、根据所述提示语音和所述提示语音文本,获取各个字的时间戳信息,然后结合提示语音文本的音素编码,获取音素的时间感知位置编码。

7、s5、根据所述时间感知位置编码,获取文本中各个字在音频对应位置处的音频位置编码。

8、s6、拼接所述提示语音的第一个码本的音频编码、提示语音文本的音素编码和待合成语音文本的音素编码,并将时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到自回归模型,获取待合成语音的第一个码本的音频预测编码。

9、s7、拼接所述提示语音的所有码本的音频编码、提示语音文本的音素编码、待合成语音文本的音素编码,以及所述第一个码本的音频预测编码,并将时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到非自回归模型,获取待合成语音的其它码本的音频预测编码。

10、s8、拼接第一个码本的音频预测编码和其它码本的音频预测编码,然后通过音频编解码器解码,获取合成音频。

11、在一个可选的实施例中,步骤s2具体包括步骤s21至步骤s23。

12、s21、通过分词工具分别对所述提示语音文本和所述待合成语音文本进行分词。

13、s22、通过音素转化模型分别将提示语音文本和所述待合成语音文本的分词转化为音素。

14、s23、通过映射词典分别将提示语音文本和所述待合成语音文本的音素转化为音素编码。其中,映射词典包含音素对应的离散编码。

15、在一个可选的实施例中,步骤s4中获取文本中各个字的时间戳信息,具体包括步骤s41。s41、获取文本中各个字在语音音频中的时间戳范围。其中,所述时间戳范围包括各个字在音频中的起始时间戳和结束时间戳。

16、在一个可选的实施例中,步骤s4中获取文本中每个字的时间感知位置编码,具体包括步骤s42至步骤s44。

17、s42、根据文本中各个字的音素编码,通过等差数列为音素编码中的各个音素进行编号,获取各个字的音素编号范围。其中,,为第个音素的编号、为文字的音素总数。

18、s43、根据时间戳范围和音素编号范围,分别计算各个字的音素位置编码。其中,音素位置编码的计算模型为:式中,为音素位置编码、为第个音素的位置编码、为文字的音素的总数、为第个音素的位置编码、为第个音素的编号、为归一化后等差数列的差值、为第个字的结束时间戳、为第个字的起始时间戳。

19、s44、将文本中各个字的音素位置编码进行拼接,然后将拼接后的音素位置编码的编码尺度和音频编解码器的编码尺度统一,获取音素的时间感知位置编码。

20、在一个可选的实施例中,步骤s5具体包括步骤s51。s51、根据所述文本中各个字的时间感知位置编码向下取整,获取文本中各个字的音频位置编码。

21、在一个可选的实施例中,自回归模型为:式中,表示概率、表示待合成语音的第一个码本的音频预测编码、表示音素编码、表示提示语音的第一个码本的音频编码、表示自回归模型的参数、为音频编码位置、为音频编码位置的数量、为待合成语音的第一个码本的第个位置的音频编码、为待合成语音的第一个码本的小于第个位置的音频编码。

22、在一个可选的实施例中,非自回归模型为:式中,表示概率、表示待合成语音的第2到8个码本的音频预测编码、表示音素编码、表示提示语音的音频编码、表示非自回归模型的参数、为码本的序号、表示待合成语音的第个码本的音频预测编码、表示待合成语音的小于第个码本的音频预测编码。

23、第二方面、本发明提供了一种基于时间感知位置编码的语音合成模型的训练方法,其包含步骤m1至步骤m10。

24、m1、获取提示语音、提示语音文本、待合成语音和待合成语音文本。

25、m2、将所述提示语音文本和所述待合成语音文本分别转为音素编码。

26、m3、通过音频编解码器将所述提示语音和所述待合成语音分别编码为多个码本的音频编码。

27、m4、根据语音和文本内容上的对应关系,分别获取提示语音文本和待合成语音文本中每个字的时间戳信息,然后结合音素编码,获取音素的时间感知位置编码。

28、m5、根据所述时间感知位置编码,获取文本中各个字在音频对应位置处的音频位置编码。

29、m6、拼接所述提示语音的第一个码本的音频编码、提示语音文本的音素编码和待合成语音文本的音素编码,并将对应的时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到自回归模型,获取待合成语音的第一个码本的音频预测编码。

30、m7、获取待合成语音的第一个码本的真实音频编码,然后和所述第一个码本的音频预测编码计算自回归损失以训练所述自回归模型。

31、m8、拼接提示语音的所有码本的音频编码、提示语音文本的音素编码、待合成语音的第j个码本的音频编码,以及待合成语音文本的音素编码,并将对应的时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到非自回归模型,获取待合成语音的第j+1个码本的音频预测编码,直至生成除第一个码本外的其它码本的音频预测编码。

32、m9、获取待合成语音的第j+1个码本的真实音频编码,然后和所述第j+1个码本的音频预测编码计算非自回归损失以训练所述非自回归模型。

33、m10、自回归模型和非自回归模型训练好后得到基于时间感知位置编码的语音合成模型。

34、第三方面、本发明提供了一种基于时间感知位置编码的语音合成装置,其包含初始数据获取模块、音素编码模块、音频编码模块、时间感知位置编码获取模块、音频位置编码模块、第一预测模块、第二预测模块和拼接模块。

35、初始数据获取模块,用于获取提示语音、提示语音文本和待合成语音文本。

36、音素编码模块,用于将提示语音文本和待合成语音文本分别转为音素编码。

37、音频编码模块,用于通过音频编解码器将提示语音编码为多个码本的音频编码。

38、时间感知位置编码获取模块,用于根据所述提示语音和所述提示语音文本,获取各个字的时间戳信息,然后结合提示语音文本的音素编码,获取音素的时间感知位置编码。

39、音频位置编码模块,用于根据所述时间感知位置编码,获取文本中各个字在音频对应位置处的音频位置编码。

40、第一预测模块,用于拼接所述提示语音的第一个码本的音频编码、提示语音文本的音素编码和待合成语音文本的音素编码,并将时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到自回归模型,获取待合成语音的第一个码本的音频预测编码。

41、第二预测模块,用于拼接所述提示语音的所有码本的音频编码、提示语音文本的音素编码、待合成语音文本的音素编码,以及所述第一个码本的音频预测编码,并将时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到非自回归模型,获取待合成语音的其它码本的音频预测编码。

42、拼接模块,用于拼接第一个码本的音频预测编码和其它码本的音频预测编码,然后通过音频编解码器解码,获取合成音频。

43、第四方面、本发明提供了一种基于时间感知位置编码的语音合成模型的训练装置,其包含训练数据获取模块、音素编码模块、音频编码模块、时间感知位置编码获取模块、音频位置编码模块、第一预测模块、第一训练模块、第二预测模块、第二训练模块和模型获取模块。

44、训练数据获取模块,用于获取提示语音、提示语音文本、待合成语音和待合成语音文本。

45、音素编码模块,用于将所述提示语音文本和所述待合成语音文本分别转为音素编码。

46、音频编码模块,用于通过音频编解码器将所述提示语音和所述待合成语音分别编码为多个码本的音频编码。

47、时间感知位置编码获取模块,用于根据语音和文本内容上的对应关系,分别获取提示语音文本和待合成语音文本中每个字的时间戳信息,然后结合音素编码,获取音素的时间感知位置编码。

48、音频位置编码模块,用于根据所述时间感知位置编码,获取文本中各个字在音频对应位置处的音频位置编码。

49、第一预测模块,用于拼接所述提示语音的第一个码本的音频编码、提示语音文本的音素编码和待合成语音文本的音素编码,并将对应的时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到自回归模型,获取待合成语音的第一个码本的音频预测编码。

50、第一训练模块,用于获取待合成语音的第一个码本的真实音频编码,然后和所述第一个码本的音频预测编码计算自回归损失以训练所述自回归模型。

51、第二预测模块,用于拼接提示语音的所有码本的音频编码、提示语音文本的音素编码、待合成语音的第j个码本的音频编码,以及待合成语音文本的音素编码,并将对应的时间感知位置编码和音频位置编码与拼接后的编码对齐,然后一起输入到非自回归模型,获取待合成语音的第j+1个码本的音频预测编码,直至生成除第一个码本外的其它码本的音频预测编码。

52、第二训练模块,用于获取待合成语音的第j+1个码本的真实音频编码,然后和所述第j+1个码本的音频预测编码计算非自回归损失以训练所述非自回归模型。

53、模型获取模块,用于自回归模型和非自回归模型训练好后得到基于时间感知位置编码的语音合成模型。

54、通过采用上述技术方案,本发明可以取得以下技术效果:

55、本发明实施例的基于时间感知位置编码的语音合成方法引入时间感知位置编码代替传统的正余弦编码,有效提高模型的收敛速度,将训练时长从3w次迭代降低到1w次迭代即可收敛,并且生成的音频质量更高。并且通过时间感知位置编码使得推理阶段可以有效控制每个字的发音,支持音频的变速,具有很好的实际意义。

本文地址:https://www.jishuxx.com/zhuanli/20240618/24495.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表