基于自注意力的视觉惯性里程计三维场景定位方法和装置

- 国知局

- 2024-07-30 11:22:26

本发明属于三维场景定位,特别是涉及一种基于自注意力的视觉惯性里程计三维场景定位方法和装置。

背景技术:

1、目前视觉惯性里程计方法主要分为两种方法,第一种是基于传统的视觉惯性里程计方法,其依赖人工设计的特征提取方法和数据融合方法,实施困难,鲁棒性比较差;第二种是基于深度学习的视觉惯性里程计方法,该方法可通过深度学习方法去学习数据特征表示和跨模态数据融合机制,鲁棒性更高。因此,基于深度学习的视觉惯性里程计方法在工业智能感知方面获得了大量应用。

2、现有基于深度学习的视觉惯性里程计方法,将imu数据当做一个整体进行特征提取,imu数据分为加速度部分与角速度部分,加速度计可以准确地测量移动智能设备的加速度大小,但是加速度计会受到外界振动和加速度的影响,在长时间运动中会出现累积误差;陀螺仪可以测量移动智能设备的角速度大小,它不受外界线性加速度的影响,在旋转运动中能够提供更加准确和稳定的测量结果,然而,陀螺仪也存在漂移问题,随着时间的推移,测量值会逐渐偏离真实值;它们本身都具有一定的特点以及局限性,但两者之间又存在一定的互补性,即加速度计测量的重力方向可以用来校准陀螺仪的漂移,陀螺仪可以帮助补偿加速度计在快速运动或震动环境下的误差;而单纯的将imu数据当做一个整体进行特征提取忽略了这种关系,未完全的利用这两模态中隐含的信息导致定位精度不够高;

3、同时在现有基于深度学习的视觉惯性里程计研究(作者是mingyu yang等人。论文名称:efficient deep visual and inertial odometry with adaptive visualmodality selection)中发现,并非所有的视觉信息对于姿态估计都是有帮助的,因此其在具体实现的时候,大量视觉信息的计算都是无用的,而且计算视觉图像所占用的计算资源要远高于计算imu数据的计算资源,导致大量计算资源浪费。

技术实现思路

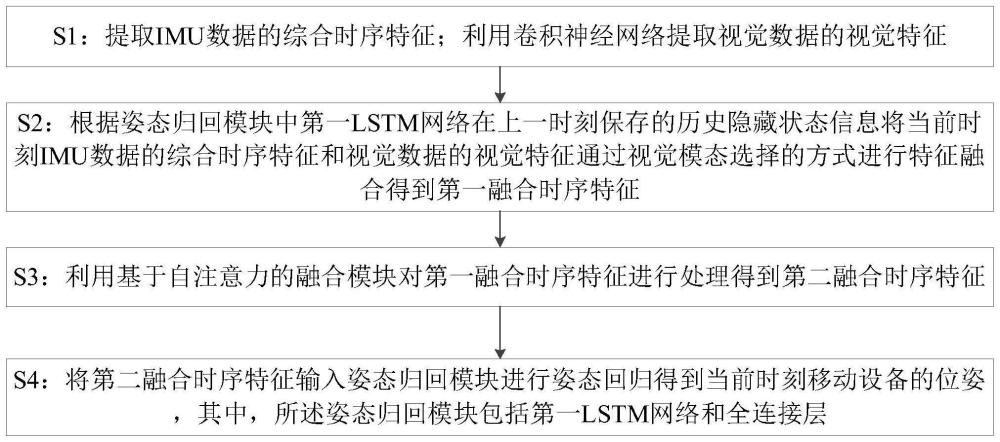

1、为了解决背景技术中存在的问题,本发明的一方面提供一种基于自注意力的视觉惯性里程计三维场景定位方法,包括:获取移动设备的imu数据和视觉数据;将移动设备的imu数据和视觉数据输入训练好的姿态预测模型预测移动设备的位姿信息,其中,所述预测移动设备的位姿信息的过程包括:

2、s1:提取imu数据的综合时序特征;利用卷积神经网络提取视觉数据的视觉特征;其中,imu数据包括惯性测量单元imu采集的移动设备在上一时刻到当前时刻之间的角速度时序数据和加速度时序数据;所述视觉数据包括图像采集设备采集的移动设备在上一时刻和当前时刻的视觉图像;

3、s2:根据姿态归回模块中第一lstm网络在上一时刻保存的历史隐藏状态信息将当前时刻imu数据的综合时序特征和视觉数据的视觉特征通过视觉模态选择的方式进行特征融合得到第一融合时序特征;

4、s3:利用基于自注意力的融合模块对第一融合时序特征进行处理得到第二融合时序特征;

5、s4:将第二融合时序特征输入姿态归回模块进行姿态回归得到当前时刻移动设备的位姿,其中,所述姿态归回模块包括第一lstm网络和全连接层。

6、优选地,所述提取imu数据的综合时序特征包括:

7、将imu采集的角速度时序数据输入第二lstm网络进行特征提取得到imu数据的角速度时序特征;将imu采集的加速度时序数据输入第三lstm网络进行特征提取得到imu数据的加速度时序特征;将imu采集的角速度时序数据和imu采集的加速度时序数据拼接后输入第四lstm网络进行特征提取得到imu数据的整体时序特征;将imu数据的角速度时序特征、imu数据的加速度时序特征和imu数据的整体时序特征进行融合得到imu数据的综合时序特征。

8、优选地,所述imu数据的综合时序特征包括:

9、

10、f=re_weights(fcat,foverall)

11、其中,faccel表示imu数据的加速度时序特征,fgyro表示imu数据的角速度时序特征,foverall表示imu数据的整体时序特征,re_weights()表示重赋权函数,f表示imu数据的综合时序特征。

12、优选地,所述利用卷积神经网络提取视觉数据的视觉特征包括:

13、将上一时刻和当前时刻的视觉图像进行拼接,将拼接后的图像输入2d cnn卷积神经网络进行特征提取得到视觉数据的视觉特征。

14、优选地,所述将当前时刻imu数据的综合时序特征和视觉数据的视觉特征通过视觉模态选择的方式进行特征融合包括:

15、

16、

17、其中,x表示第一融合时序特征,fv表示视觉数据的视觉特征;f表示imu数据的综合时序特征;φ表示策略网络;gumbel-softmax()表示服从伯努利分布的采样函数;表示姿态归回模块中第一lstm网络在上一时刻最后一个记忆单元保留的历史隐藏状态信息。

18、优选地,所述融合模块包括串联的mdta模块和gdfn模块。

19、优选地,训练姿态预测模型时采用的损失函数包括:

20、

21、

22、

23、其中,t表示训练序列的长度,xt和φt代表移动设备的真实位姿标签;和表示模型预测的移动设备的位姿;‖‖2表示l2范数;α是平衡平移损失和旋转损失的权重,λ表示惩罚因子,st∈{0,1}表示视觉选择模块的输出在t时刻对应的第一融合时序特征xt是否融合了视觉特征。

24、本发明的另一方面提供一种基于自注意力的视觉惯性里程计三维场景定位装置,包括处理器和存储器;所述存储器用于存储计算机程序;所述处理器与所述存储器相连,用于执行所述存储器存储的计算机程序,以使所述一种基于自注意力的视觉惯性里程计三维场景定位执行所述的一种基于自注意力的视觉惯性里程计三维场景定位方法。

25、本发明的再一方面提供一种计算机可读存储介质,存储有程序,所述程序被处理器执行时,实现所述的一种基于自注意力的视觉惯性里程计三维场景定位方法。

26、本发明至少具有以下有益效果

27、本发明考虑了imu数据中加速度部分和角速度部分之间的互补关系,提取imu数据的综合时序特征,相较于将imu数据当做一个整体进行特征提取,增强了信息的丰富度;同时加速度部分和角速度部分之间的互补关系可以弥补各自的局限性,提高模型在各种情况下的适应性和鲁棒性,从而提高了姿态估计的精度。

28、本发明通过视觉模态选择的方式对视觉特征进行选择性融合,可以减少模型需要处理的图像数据的维度和复杂度,从而降低了计算资源的消耗,同时通过选择对姿态估计有用的视觉信息,可以减少不必要的干扰和噪声,提高模型对关键信息的关注度,从而增强了模型的鲁棒性和稳定性。

技术特征:1.一种基于自注意力的视觉惯性里程计三维场景定位方法,其特征在于,包括:获取移动设备的imu数据和视觉数据;将移动设备的imu数据和视觉数据输入训练好的姿态预测模型预测移动设备的位姿信息,其中,所述预测移动设备的位姿信息的过程包括:

2.根据权利要求1所述的一种基于自注意力的视觉惯性里程计三维场景定位方法,其特征在于,所述提取imu数据的综合时序特征包括:

3.根据权利要求2所述的一种基于自注意力的视觉惯性里程计三维场景定位方法,其特征在于,所述imu数据的综合时序特征包括:

4.根据权利要求1所述的一种基于自注意力的视觉惯性里程计三维场景定位方法,其特征在于,所述利用卷积神经网络提取视觉数据的视觉特征包括:

5.根据权利要求1所述的一种基于自注意力的视觉惯性里程计三维场景定位方法,其特征在于,所述将当前时刻imu数据的综合时序特征和视觉数据的视觉特征通过视觉模态选择的方式进行特征融合包括:

6.根据权利要求1所述的一种基于自注意力的视觉惯性里程计三维场景定位方法,其特征在于,所述融合模块包括串联的mdta模块和gdfn模块。

7.根据权利要求1所述的一种基于自注意力的视觉惯性里程计三维场景定位方法,其特征在于,训练姿态预测模型时采用的损失函数包括:

8.一种基于自注意力的视觉惯性里程计三维场景定位装置,其特征在于,包括处理器和存储器;所述存储器用于存储计算机程序;所述处理器与所述存储器相连,用于执行所述存储器存储的计算机程序,以使所述一种基于自注意力的视觉惯性里程计三维场景定位执行权利要求1至7中任一项所述的一种基于自注意力的视觉惯性里程计三维场景定位方法。

9.一种计算机可读存储介质,存储有程序,其特征在于,所述程序被处理器执行时,实现权利要求1-7任一项所述的一种基于自注意力的视觉惯性里程计三维场景定位方法。

技术总结本发明提供一种基于自注意力的视觉惯性里程计三维场景定位方法和装置,包括:提取IMU数据的综合时序特征;利用卷积神经网络提取视觉数据的视觉特征;根据姿态归回模块中第一LSTM网络在上一时刻保存的历史隐藏状态信息将当前时刻IMU数据的综合时序特征和视觉数据的视觉特征通过视觉模态选择的方式进行特征融合得到第一融合时序特征;利用基于自注意力的融合模块对第一融合时序特征进行处理得到第二融合时序特征;将第二融合时序特征输入姿态归回模块进行姿态回归得到当前时刻移动设备的位姿,其中,所述姿态归回模块包括第一LSTM网络和全连接层;本发明通过学习IMU内部数据间的关系,有效提高了移动设备的三维定位精度。技术研发人员:古长军,王理科,高新波,杨璟轩,林培灿,谢昊飞,魏旻受保护的技术使用者:重庆邮电大学技术研发日:技术公布日:2024/7/25本文地址:https://www.jishuxx.com/zhuanli/20240730/156438.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表