一种无信号右转交叉口人车博弈的行人行为预测方法

- 国知局

- 2024-07-31 20:25:57

本发明设计智能驾驶辅助技术及环境感知,尤其涉及一种无信号右转交叉口人车博弈的行人行为预测方法。

背景技术:

1、混合交通是城市交通的一大特点,行人和车辆是道路交通的主要使用者。随着汽车保有量的增加,人车冲突也逐渐频繁。在所有交通事故中,行人、自行车驾驶者、摩托车驾驶者等“弱势交通参与者”占比超过50%。行人作为交通环境中的重要参与者,虽然他们的速度比车辆低很多,但是行人的过街行为具有很强的灵活性和不确定性。而行人又是交通参与者中的弱势群体,一旦发生事故,往往会受到更为严重的伤害。在有信号的交叉路口,交通信号灯对车辆和行人的行为起到了约束作用,所以人车冲突的概率很低。而对于没有信号灯的右转路口,行人和车辆之间的关系变得复杂起来,由于没有明确的道路归属权,双方的行为既有一定的联系又都充满不确定性。无信号交叉口下的人车交互场景是典型的交通场景之一,如何模拟无信号交叉口下的人车交互测试场景值得研究。

2、行人和车辆在交互的过程中存在着以下三个特点:交互场景的复杂性和多样性、双方交互意图传递的不确定性以及在交互过程中行为的差异性。在现有的仿真测试场景中,行人往往被当作是一个障碍物或者以人为规定的速度运动,并不能体现行人作为一个智能体的灵活性,因此怎样逼真模拟场景中行人和车辆的动态交互与博弈成为一个关键问题。

3、国内外研究人员采用多种方法对行人过街交通场景进行仿真模拟,主要包括机理模型仿真和数据驱动仿真方法。基于机理模型仿真方法主要包括社会力模型和元胞自动机模型。社会力模型以牛顿动力学为基础,假设道路使用者作为粒子受到与其他道路使用者相互作用的影响。在元胞自动机模型中,假设道路使用者是沿着离散网格移动的粒子,它们的运动遵循先验定义的规则集。然而,由于没有考虑道路交通参与者的智能性和交通参与者的意图,基于机理模型的仿真方法用于自动驾驶交通安全测试和评估具有较多缺点。例如,社会力模型以牛顿动力学为基础,假设道路使用者作为粒子受到与其他道路使用者相互作用的影响,这种假设与现实差距较大。在元胞自动机模型中,道路使用者的移动通常受到特定的单元格大小的限制,这很难描述道路交通参与者行为的连续二维特征。

4、近年来,基于人工智能技术的数据驱动方法越来越多的应用到智能汽车场景建模的研究,与机理建模方法相比,数据驱动方法在模拟道路用户交互方面表现出了优越的性能。例如,最大熵逆强化学习基于最大熵原理的概率方法来解释固有噪声和次优轨迹,消除奖励函数多样性的可能。使得在专家数据中观察到的轨迹概率与轨迹发生概率和轨迹奖励的指数呈正比。当对一个随机事件的概率分布进行估计时,应当满足全部已知条件,且不能对未知状态进行任何主观假设。在这种条件下的概率分布最为均匀,信息熵最大。通过这种方法处理观察到的轨迹的不确定性和噪声可能会获得一个鲁棒性更强的奖励函数。

5、综上,如何才能保证无信号右转交叉口的行人行为的预测准确性,从而准确的进行行人行为的虚拟模拟,用以逼真模拟场景中行人和车辆的动态交互与博弈状态,成为了目前行业中一项亟待解决的问题。

技术实现思路

1、针对上述现有技术的不足,本发明提供了一种无信号右转交叉口人车博弈的行人行为预测方法,以进一步保证对无信号右转交叉口的行人轨迹的预测准确性,从而用以更准确的进行行人行为虚拟模拟。

2、为了解决上述技术问题,本发明采用了如下的技术方案:

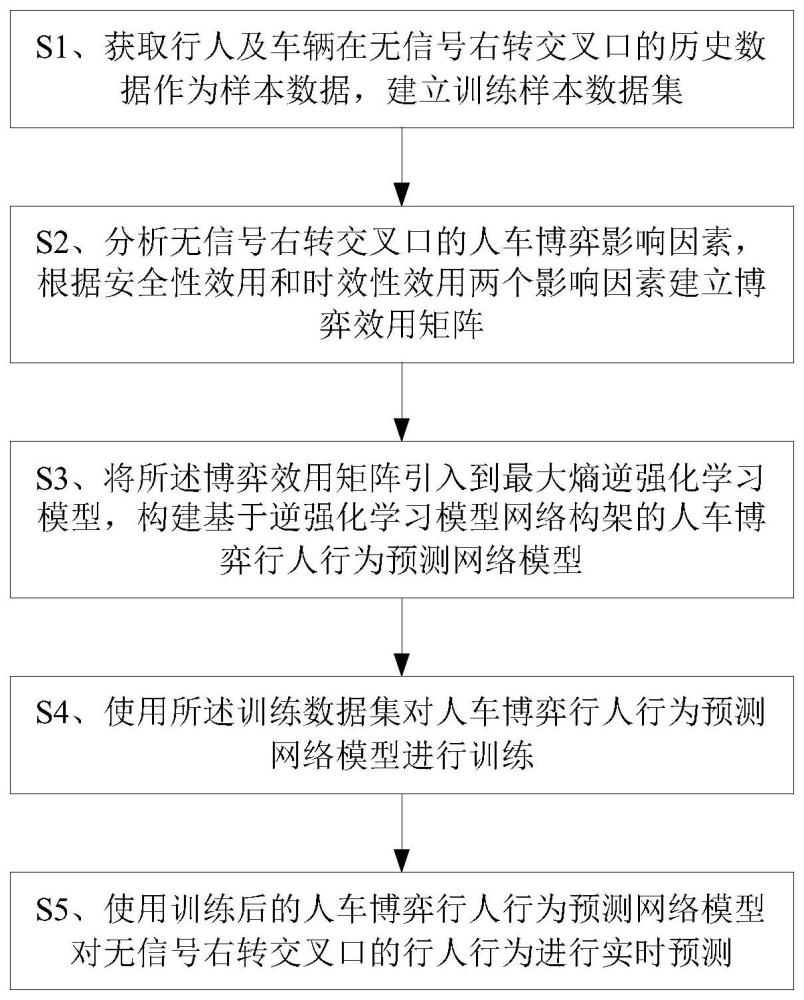

3、一种无信号右转交叉口人车博弈的行人行为预测方法,包括以下步骤:

4、s1、获取行人及车辆在无信号右转交叉口的历史数据作为样本数据,建立训练样本数据集;

5、s2、分析无信号右转交叉口的人车博弈影响因素,根据安全性效用和时效性效用两个影响因素建立博弈效用矩阵;

6、s3、将所述博弈效用矩阵引入到最大熵逆强化学习模型,构建基于逆强化学习模型网络构架的人车博弈行人行为预测网络模型;

7、s4、使用所述训练数据集对人车博弈行人行为预测网络模型进行训练;

8、s5、使用训练后的人车博弈行人行为预测网络模型对无信号右转交叉口的行人行为进行实时预测。

9、作为优选方案,所述步骤s2具体包括:

10、s21、划分博弈阶段,设计观察区域和冲突区域,行人与车辆一旦进入观察区域则认定博弈开始;并利用后侵入时间来表征人车冲突的危险程度,所述后侵入时间为判定行人及车辆进入冲突区域的时间差,后侵入时间越短则危险程度越高;

11、s22、根据人车博弈的安全性效用和时效性效用两个影响因素,为人车博弈通行的交通参与者制定行为策略,并建立行为策略的安全性评估公式和时效性评估公式;所述安全性评估公式用于评估行为策略的安全性,所述时效性评估公式用于评估行为策略的时效性;

12、s23、基于所述行为策略的安全性评估公式和时效性评估公式,构建博弈效用矩阵;

13、s24、根据所述博弈效用矩阵,确定不同交通参与者行为策略的期望收益函数,进而确定不同交通参与者行为策略的出现概率,完成博弈效用矩阵的构建。

14、作为优选方案,所述步骤s22中,行为策略的安全性评估公式包括:

15、

16、

17、其中,表示车辆的安全性效用,表示行人的安全性效用;vv表示车辆的通过速度,av表示车辆的加速度,vp表示行人的通过速度,ap表示行人的加速度,θ1表示车辆的安全影响权重,θ2表示行人的安全影响权重;σv为车辆的碰撞危险程度因子,σp为行人的碰撞危险程度因子,且:

18、

19、

20、其中,pet表示后侵入时间。

21、作为优选方案,所述步骤s22中,行为策略的时效性评估公式包括:

22、

23、

24、

25、

26、其中,和分别为车辆的高效性效用和时效性效用,和分别为行人的高效性效用和时效性效用;θ3为过街影响权重因子,θ4为等待影响权重因子,vv表示车辆的通过速度,vp表示行人的通过速度,tv表示车辆的等待时间,tp表示行人的等待时间。

27、作为优选方案,所述步骤s22中,交通参与者的行为策略包括行人车辆同时通行、行人等待车辆通行、行人通行车辆等待以及行人车辆同时等待;

28、当行人通行车辆等待时,双方效用如下式所示:

29、

30、

31、其中,为行人通行效用,为车辆等待效用,ω为车辆启动所消耗时间权重;

32、当行人等待车辆通行时,双方效用如下式所示:

33、

34、

35、其中,为车辆通行效用,为行人等待效用;

36、当行人车辆同时通行时,双方效用如下式所示:

37、

38、

39、其中,为行人冲突效用,为车辆冲突效用;

40、当行人车辆同时等待时,双方效用如下式所示:

41、

42、

43、其中,为行人通行失败效用,为车辆通行失败效用,θ1为行人等待后悔因子,θ2为车辆等待后悔因子;表示车辆的安全性效用,表示行人的安全性效用;和分别为车辆的高效性效用和时效性效用,和分别为行人的高效性效用和时效性效用。

44、作为优选方案,所述步骤s23中,构建的博弈效用矩阵为:

45、

46、作为优选方案,所述步骤s24中,所述期望收益函数为车辆通过行人选择等待及行人通过车辆选择等待的混合优势策略的纳什均衡点时,车辆与行人双方的混合期望收益;其中包括:

47、车辆选择通过时的期望收益为:

48、

49、车辆选择等待时的期望收益为:

50、

51、行人选择通过时的期望收益为:

52、

53、行人选择等待时的期望收益为:

54、

55、当车辆选择通过时的期望收益与车辆选择等待时的期望收益相同时,即产生纳什均衡;当行人选择通过时的期望收益与行人选择等待时的期望收益相同时产生纳什均衡;由此得到

56、

57、

58、

59、

60、其中,和分别为行人通行概率和行人等待概率,和分别为车辆通行概率和车辆等待概率;vv表示车辆的通过速度,av表示车辆的加速度,vp表示行人的通过速度,ap表示行人的加速度,θ1表示车辆的安全影响权重,θ2表示行人的安全影响权重;σv为车辆的碰撞危险程度因子,σp为行人的碰撞危险程度因子;θ3为过街影响权重因子,θ4为等待影响权重因子。

61、作为优选方案,所述步骤s3具体为:

62、首先,确定逆强化学习的归类类别:对人车博弈下的四种决策组合进行具体区分,将{人车横向相对距离,纵向相对距离,行人速度,人车相对速度}4个特征来描述行人与车辆在每个时间步下的状态,行人的每个时间步的动作由2个变量定义:行人加速度与博弈决策组合;将每个状态特征划分为5个级别,每个级别遵守等频率观察,使人车博弈的状态空间离散化;将行人动作的2个变量也分别划分为5个级别,即,行人加速度按照等频率观察划分为5个级别,博弈动作划分为{观察,冲突,同时等待,车赢,人赢}5个状态,从而经过离散化处理形成54=625个状态,52=25个动作,把人车博弈下各状态与动作划分了等级间隔,形成逆强化学习的归类类别;

63、其次,以所述逆强化学习的归类类别作为识别目标,将所述博弈效用矩阵引入到最大熵逆强化学习模型,构建基于逆强化学习模型网络构架的人车博弈行人行为预测网络模型:

64、r(s)=σ2(w2*σ1(w1*f(s))*φped(s));

65、其中,r(s)表示行人在状态s下的人车博弈行人行为预测网络模型输出;f(s)是行人在状态s下的特征函数,表示从行人状态到行人行为预测值的映射;σ1(·),σ2(·)分别表示人车博弈行人行为预测网络模型中的两个神经网络层,w1,w2分别为人车博弈行人行为预测网络模型中的两个神经网络层权重系数,φped(s)为行人在状态s下的博弈决策效用。

66、作为优选方案,所述步骤s4中,对人车博弈行人行为预测网络模型进行训练的方式为:

67、对训练样本数据集中各样本数据按照确定的逆强化学习的归类类别进行行为类别标签的标记处理,输入所述人车博弈行人行为预测网络模型,并构建包含有用以评估模型识别性能的梯度下降算法,以最小化损失函数为目标对人车博弈行人行为预测网络模型的模型参数进行优化更新,进而对人车博弈行人行为预测网络模型进行训练;

68、所述梯度下降算法为:

69、

70、

71、其中,θi,θi+1分别表示第i次迭代和第i+1次迭代中奖励函数的参数;α表示学习率,为损失函数关于参数θi的梯度,μ为轨迹的期望值,e[μ]为智能体学习到的期望值,为奖励函数关于参数θ的梯度;梯度下降算法通过不断迭代地计算梯度和更新参数,使损失函数逐渐减小,直到达到收敛的条件。

72、作为优选方案,所述步骤s5之后,还包括:

73、s6、基于马尔可夫模型理论开发出行人行为模拟模型,根据人车博弈行人行为预测网络模型对无信号右转交叉口的行人行为的预测结果,对行人的动作与轨迹进行模拟。

74、本发明与现有技术相比,具有如下有益效果:

75、1、本发明建立了人车博弈场景的训练样本数据集,为提出的博弈—深度最大熵逆强化学习模型训练提供了数据支撑,包括危险的人车冲突场景。接着,建立了人车博弈状态下的双方效用矩阵,将博弈论应用至真实场景当中,通过分析双方安全性与时效性的博弈得失从而建立博弈效用矩阵。在此基础上,提出了一种基于最大熵逆强化学习的人车博弈行人行为预测网络模型,在深度最大熵逆强化学习的神经网络框架中引入了人车博弈效用矩阵,以真实状态下的博弈得失来推动行人在不同决策下的奖励函数恢复,揭示了行人行为背后的潜在动机与偏好;最后,使用训练数据集对人车博弈行人行为预测网络模型进行训练,从而使用训练后的人车博弈行人行为预测网络模型对无信号右转交叉口的行人行为进行实时预测,并在实验中借助mdp理论框架开发出行人行为模拟模型,在不同决策下的行人奖励函数基础上对行人的动作与轨迹进行了模拟,结果表明提出的模拟方法在离散区间的误差内能够准确模拟出行人的运动轨迹。

76、综上,本发明可以进一步保证对无信号右转交叉口的行人轨迹的预测准确性,从而用以更准确的进行行人行为虚拟模拟。

77、2、本发明方法中提出的人车博弈行人行为预测网络模型,结合了博弈论和深度最大熵逆强化学习,通过建立人车博弈状态下的双方效用矩阵,并在神经网络框架中引入了人车博弈效用矩阵,从而推动行人在不同决策下的奖励函数恢复,揭示了行人行为背后的潜在动机与偏好。

78、3、本发明通过引入博弈论,将行人与车辆视为基于效用的理性智能体,对行人-车辆交互状态定义为双方的博弈过程,从而建立了博弈效用矩阵,这为分析双方安全性与时效性的博弈得失提供了新的视角和方法。

本文地址:https://www.jishuxx.com/zhuanli/20240731/186170.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。