基于MEC传输网络不可靠场景下的部分卸载优化方法

- 国知局

- 2024-08-02 14:05:16

本发明涉及移动边缘计算领域,尤其涉及一种基于mec传输网络不可靠场景下的部分卸载优化方法。

背景技术:

1、对于目前移动终端在新型场景中的应用,例如图像处理、ar游戏等大规模数据应用,传统的云计算技术已无法满足终端侧“大连接,低时延,大带宽”的需求。移动边缘计算mec(mobile edge computing,mec)将部分云计算能力“下沉”到更靠近终端的边缘侧,为用户提供更强的计算、存储能力和低延时的网络体验。在日益复杂的无线网络环境中,计算任务通过无线链路上传到mec服务器时容易造成数据传输错误或丢包。对于无模型的深度强化学习算法而言,错误的环境信息会使其做出不合理的动作,且在训练过程中不能学习到正确的策略,无法保证更低的系统总成本。

2、由于移动设备在计算性能方面天然的缺陷,目前对于计算密集型任务的处理方式还是以云计算为主,移动设备将任务上传至远程云服务器上运行,再将结果下回至本地。mec技术作为对云计算技术的延伸,其核心之一是计算卸载问题。目前对mec环境下计算卸载的研究还是以基于启发式算法的传统方法和基于在线学习的智能方法为主。基于启发式算法的传统方法主要是先确定一个优化目标,再设计出对应的解决方案,通过不断迭代来逼近最优解。基于在线学习的智能算法不以单一的优化作为目标,而是综合考虑智能卸载的性能,且该算法可以根据环境变化调整策略,更能适应时变的系统。基于启发式算法的卸载方案,通过自学习、迭代计算来寻找近似最优解。但是该方法的卸载决策缺乏全局性,通常无法获得全局最优解;适应性较差,难以适应动态的网络环境;计算复杂度高,需要进行大量的搜索和迭代计算。基于在线学习的智能算法卸载方案,通过与动态环境进行交互学习最优策略。不足在于:适应性有待提高,虽然在线学习算法可以动态地调整卸载策略,但此方案过于依赖环境交互数据,难以应对一些突发情况,如数据丢失。

技术实现思路

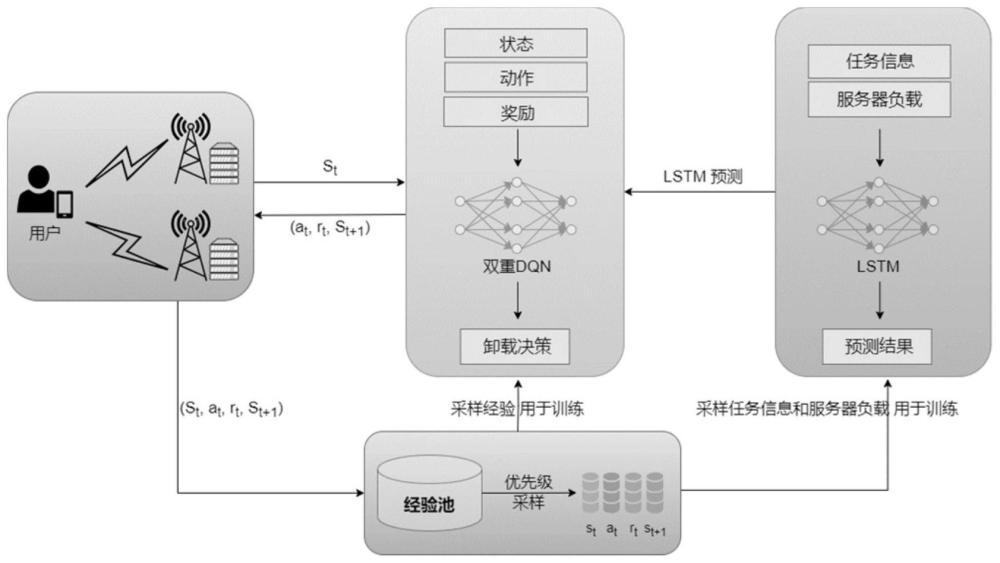

1、针对现有技术之不足,本发明提出一种基于mec传输网络不可靠场景下的部分卸载优化方法,所述卸载优化方法基于传输网络不可靠场景,实现对丢失数据的自动补全,并通过优先级经验重放和预测系统状态加快模型的收敛速度,所述方法具体包括:

2、步骤1:根据优化目标搭建mec传输网络不可靠仿真环境,在不可靠仿真环境中,移动终端上传的任务特征以一定的概率丢失;

3、步骤2:基于双重深度q网路搭建用于卸载决策的深度强化学习模型,所述学习模型包括一个主网络和一个目标网络,两个网络具有相同的网络结构,包括至少三层的全连接网络和一个随机丢弃层,所述主网络与不可靠仿真环境进行交互,选择动作,优化学习模型参数,所述目标网络计算目标q值,主网络每隔预设的步数将网络参数传递给目标网络,即延时更新,提高模型的稳定性;

4、步骤3:将双重深度q网络的随机经验重放机制改进为优先级经验重放机制,并以sum-tree的数据结构存放经验的优先级;优先级根据经验的时序差分误差得到,高优先级的经验具有大的概率被抽样,使得智能体重视对重要经验的学习,提高学习效率;

5、步骤4:搭建长短时记忆lstm预测模型,所述预测模型包含至少三层,每层由至少两个长短时记忆单元lstm组成,每层在训练阶段有随机丢弃dropout操作,所述长短时记忆预测模型用于从抽取的训练样本中学习历史任务特征和每个mec服务器负载信息;

6、步骤5:搭建完强化学习模型后,将系统状态作为模型输入对模型进行训练,系统状态包括:任务数据量dt,任务所需计算资源ct,任务类别ft,不同的任务类别代表时延与能耗在成本中不同的权重;

7、各个mec服务器与移动设备之间的距离信息其中,表示t时刻移动设备与第一个mec服务器之间的距离,各个mec服务器的可用计算资源表示为:其中,表示t时刻第一个mec服务器的可用计算资源,系统输入的状态空间表示为st={dt,ct,ft,dist,ft},模型输出的卸载决策包括任务划分和节点选择,将智能体在t时刻做出的卸载动作表示为:at={αt,pt},其中,αt表示当前节点选择,pt表示当前任务卸载比例,训练过程具体包括:

8、步骤51:初始化主网络参数θ和目标网络参数θ′,初始化经验缓存;

9、步骤52:获取初始状态s1;

10、步骤53:以ε的概率输出动作at=argmaxaq(st,at;θ),以1-ε的概率选择随机动作或者长短时记忆预测模型的预测动作,随机动作和预测动作由生成随机数η和ε比值进行选择;

11、步骤54:执行动作at,获得奖励rt,转移到新状态st+1,计算经验{st,at,rt,st+1}的优先级并存入sum-tree;

12、步骤55:根据优先级采样策略从sum-tree中抽取n个样本,并计算各样本的重要性抽样权重ωj;

13、通过优先级经验重放机制,使得智能体在训练时更注重对重要经验的学习,提高了模型在高维度的环境中的学习效率,能够更好地适应动态环境;

14、步骤56:计算目标q值,数学表达式为:

15、

16、其中,rj表示样本j在当前状态下采取动作aj后获得的即时奖励;γ表示折扣因子,q(s′,a;θ′)表示目标q网络在状态s′下采取动作a的q值,θ′表示目标q网络的参数,argmaxq(s′,a;θ)表示状态s′下选择使得q值最大的动作a,θ表示估计q网络的参数,yj表示样本j的目标q值;

17、步骤57:根据目标q值计算损失值:来更新主网络的参数,数学表达式如下:

18、loss(θ)=ωj(yj-q(sj,aj;θ))2

19、其中,ωj表示重要性采样权重,yj-q(sj,aj;θ)表示目标q值与预测q值之间的差异;

20、步骤58:更新各抽取样本的优先级;

21、步骤59:每隔预设步数后更新目标网络参数θ′=θ;

22、在模型训练阶段,将随机动作以设定的概率随机选择动作,否则使用长短时记忆预测模型选择动作;

23、在模型的决策阶段,通过长短时记忆预测模型来预测未来任务特征,并为任务确定卸载决策;

24、当实际任务到达时,将从移动终端上传的任务特征与长短时记忆预测模型预测的任务特征进行比较,若误差在设定的阈值范围内,直接卸载任务,否则使用预测结果进行决策;

25、步骤6:使用训练好的模型在不可靠仿真环境中根据mec系统环境,动态地决定目标任务如何卸载到mec服务器。

26、相比现有技术,本发明的有益效果在于:

27、1、本发明在mec网络不可靠的场景下具有良好的卸载性能,能有效应对信息缺失对决策带来的负面影响,相比于其它算法具有收敛速度更快,鲁棒性更强的优点,更适应复杂多变的动态mec环境。

28、2、本发明在移动边缘计算场景的计算卸载问题研究中,针对通信过程中复杂的无线环境导致计算任务在通过无线链路上传到mec服务器时容易造成数据传输错误或丢包,无法保证更低的系统总能耗和更短的总时延的问题,设计了一种在不可靠网络环境下的部分卸载优化算法,可以实现对丢失信息的自动补全,并通过优先级经验重放和预测系统状态加快模型的收敛速度。

29、3、本发明在训练阶段,lstm预测下一时刻mec负载并选出最优卸载节点,模型以一定的概率选择lstm预测结果,在提高经验可用性的同时保证了动作的探索空间,结合优先级经验重放,进一步提升了模型的学习效率。在决策阶段,将实际任务特征与lstm预测结果进行比较,当到达的任务信息发生错误时,直接由lstm预测结果进行决策,避免决策模型学习到错误的经验导致无法收敛。与传统的卸载方案相比,本发明具有更快的收敛速度、更低的系统总成本以及更强的鲁棒性。

本文地址:https://www.jishuxx.com/zhuanli/20240801/241689.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表