一种基于时空频谱特征与软标签纠正的语音情感识别方法

- 国知局

- 2024-08-08 16:53:22

本发明属于语音情感识别领域,涉及一种基于时空频谱特征与软标签纠正的语音情感识别方法。

背景技术:

1、随着计算机技术和人工智能的飞速发展,语音情感识别已经成为人机交互领域的热门话题。语音作为人类自然交流的核心媒介,不仅仅传递信息,更承载着说话者的情感、情绪和沟通背景。语音信号蕴含着丰富的信息,包括说话者的身份、情感以及语言强调的线索。语音中的情感信息在人类的决策、交流和认知过程中起着至关重要的作用。为更好通过语音服务人类,目前市面上已经诞生了一系列基于语音的智能应用。比如智能客服系统和语音助手、对话系统等,这极大地促进了人机交互发展。

2、然而,目前拥有语音识别能力的智能应用并不具备识别语音中丰富情感信息的能力,对于复杂的情感表达和语境理解仍存在局限性。实际上,语音是人类交流主要媒介,理解语音中情感是良好社会互动的关键。在人机互动中,机器不仅需要理解说话人的目的,还需要识别并响应说话人的情感。因此,将语音情感识别作为语音科研项目内容有助于人机交流的智能化以及个性化。现阶段,随着人机交互、自动驾驶等领域的发展,语音情感识别逐渐成为各国语音研究者重要的关注方向。语音情感识别的兴起不仅反映了人们对于更加智能化交流方式的需求,也彰显了在科研领域中,情感智能在语音领域的关键地位。

3、在过去的十年中,深度学习(deep learning,dl)作为一种更有吸引力的机器学习ml算法而出现。深度学习具有多层线性和非线性运算能力,有很强的数据表征能力。现如今,利用深度神经网络自动提取语音中鲁棒的情感特征已经成为语音情感识别的主要发展方向。本研究采用卷积神经网络(convolutional neural network,cnn)、变压器(transformer),注意力机制(attention mechanism,am)等深度学习工具来对语音情感进行研究和识别,并拟提出一些用于模糊语音情感识别的网络。

4、多数研究在单标签的基础上进行语音情感识别研究,但并没有注意到语音情感表达存在模糊性,不同评估者因背景、性别、年龄等差异对语音的情感认知并不统一,即情感认知具有主观性。考虑这一问题,部分研究指出,传统的确定性单标签无法完全表达模糊的情感数据,因此重新设定了目标,提出了多种自定义标签方法,以模拟语音表达的情感混合和人类对情感的感知差异。尽管先前的研究在利用模糊语音数据方面取得了成功,但没有考虑到这些模糊语音的软标签可能包含错误的标签,这可能会对模型学习产生负面影响。

5、针对上述问题,目前在语音情感识别中,基于时空频谱的方法能有效缓解错误标签带来的语音情感识别误导。但是现有方法并没有充分考虑到情感表达存在的模糊性、情感认知存在的主观性。因此,有必要考虑如何在利用情感模糊的语音样本下,还能缓解错误标签对情感识别模型产生的误导。

技术实现思路

1、有鉴于此,本发明的目的在于提供一种基于时空频谱特征与软标签纠正的语音情感识别方法。

2、为达到上述目的,本发明提供如下技术方案:

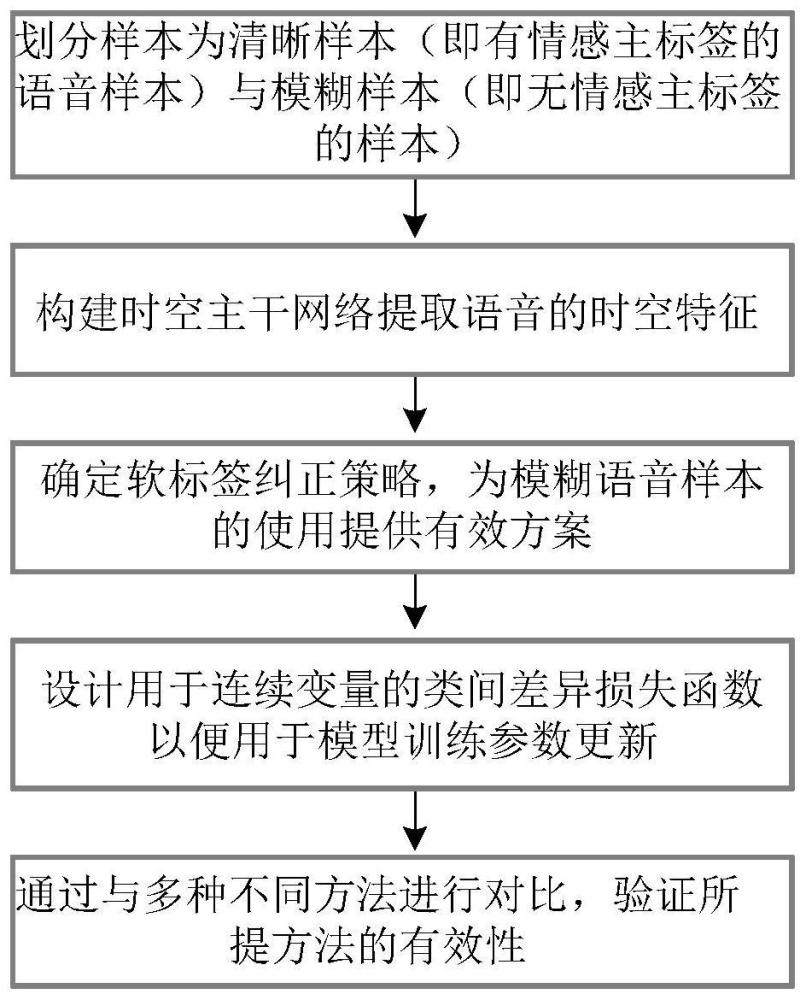

3、一种基于时空频谱特征与软标签纠正的语音情感识别方法,包括以下步骤:

4、步骤一:划分样本为清晰样本(即有情感主标签的语音样本)与模糊样本(即无情感主标签的样本);

5、步骤二:构建时空主干网络提取语音的时空特征;

6、步骤三:确定软标签纠正策略,为模糊语音样本的使用提供有效方案;

7、步骤四:设计用于连续变量的类间差异损失函数以便用于模型训练参数更新;

8、步骤五:通过与多种不同方法进行对比,验证所提方法的有效性。

9、可选的,所述步骤一具体过程包括:考虑到确定标签样本,具有清晰的情感倾向,并不会为标注者带来认知偏差。而无确定标签的样本,情感表达模糊,这使得标注者们对同一个语音有不同的看法。为此,我们对数据集中样本进行划分,以便区这两类数据样本。首先,根据每个语音样本的标签,可将数据集中所有样本归纳为两种类型的并集:设语音数据集合为s,具有确定标签(单标签)的样本为清晰样本sa,无确定标签(多标签)的样本为模糊样本sb,其中n1为清晰样本sa大小,n2为模糊样本sb大小,n为样本s大小。

10、可选的,所述步骤二具体过程包括:时域模块:首先语音时域波形xi经过连续的一维卷积层得到特征t随着输入语音长度的变化而变化,d1表示特征维度。g还将经过一次线性层linear(·)进行维度变换,得到d2表示线性变换后的特征维度。经过掩码层得到f1:

11、

12、式中,mask(·)表示掩码操作。然后,经过wav2vec的核心网络transformer得到f2:

13、

14、接着,f2进行linear(·)变换后再与f2进行矩阵乘法运算得到语音时域特征f3:

15、

16、式中,f′2=linear(f2),表示矩阵乘法运算。空域模块:首先根据二维卷积层的输入规则,语音的fbank特征应为f表示帧数,m表示梅尔滤波器数量。同时,考虑到fbank特征是由连续帧对应的频谱特征组成的特征图,因此本文设计了并行的三层卷积用于关注fbank时间与频率特征,其输出为:

17、

18、式中,conv1a(·)、conv1b(·)和conv1c(·)分别表示对fbank特征时间维度、空间维度以及同时考虑时间与空间维度的卷积,concat(·)表示特征拼接。然后,将xc经过5次卷积核大小为3×3卷积池化处理(最后一次卷积后不进行下采样操作),其输出xd为:

19、

20、式中,conv5(·)表示连续五次卷积操作。最后使用全局平均池化得到空域模块的输出xs:

21、

22、式中,gp(·)表示全局平均池化。

23、可选的,所述步骤三具体过程包括:在一个有监督的k分类任务中,清晰样本集合sa所对应的标签为单标签,被定义为多数注释者认为的情感类别,表示为:

24、

25、式中,xi表示第i条语音,描述多数情感注释者认为语音xi具有(不具有)第j类情感,描述语音xi在k个情感类型中只有一种情感类型。考虑到注释者人数是有限的且情感认识存在主观性,因此模糊样本sb的情感标签存在模糊性。其情感标签被定义为多标签,表示注释者对语音的情感认知不统一,公式表示为:

26、

27、式中,z+表示正整数,n2为清晰样本sb大小。为便于模型训练,一般使用多标签:

28、

29、式中,xi表示第i条语音,用于描述有注释者认为语音xi具有(不具有)第j类情感。然而,模糊样本的多标签忽略了情感所占比例。于是,在多标签的基础上,将情感比例纳入语音的标签中,表示为:

30、

31、

32、式中,用于表示语音xi为第j类情感类型的概率。然而,注释者不会过多,这类软标签不能反映真实情感比例且还可能存在错误标注的情况。于是,为了缓解这个问题,本专利利用软标签纠正策略,表示为:

33、

34、式中,xi表示第i条语音,表示语音xi的纠正标签,表示语音xi的原始软标签,表示语音xi输入模型所得的生成标签,α表示纠正系数。

35、软标签的动态纠正演示算法。首先,清晰样本微调模型m1(xi|θ),保证网络m1p具有正确的情感倾向,以减少同时利用模糊语音对网络训练的误导;然后将样本xi∈s输入模型mp中;接着,如果xi∈sb,则采用标签纠正策略ω(·)动态纠正xi的观测标签,否则不进行标签动态纠正。最后,输出语音xi的动态纠正标签

36、

37、可选的,所述步骤四中,在监督学习中,损失函数用于计算网络预测值与真实值间的误差。交叉熵损失函数用于描述模型预测的概率损失,因此常与softmax激活函数连用,其表达式为:

38、

39、

40、式中,n表示总样本s中元素个数,xi表示第i条语音,为语音xi的j类情感比例,为语音第j类的模型输出,表示语音xi的j类情感预测。

41、对模糊语音样本进行动态软标签纠正时,我们采用同模型的输出作为生成多标签,然而当模糊语音样本在总样本中占比较多时,这种方式会导致网络训练的过拟合。同时,考虑到样本观测软标签是符合样本大致情感倾向的,因此样本的真实标签应在观测标签附近。结合上述讨论,我们采用改进的类间差异损失函数对生成软标签进行限制,使其在样本观测标签附近变化。相较于类间差异损失函数,我们通过生成纠正的软标签,将扩展为改进后的类间差异损失函数可表示为:

42、

43、式中,为纠正软标签,n2表示模糊样本的数量,β为与间边距的控制系数。因此最终模型损失函数为:

44、l=lcor+lic

45、可选的,所述步骤五中,通过与多种不同方法进行对比,验证所提方法的有效性,软标签纠正的最优超参数。同时我们在iemocap数据集上进行所提方法的实验,通过与目前先进方法验证其有效性。

46、本发明的有益效果在于:提出一种基于时空频谱特征与软标签纠正的语音情感识别方法,包括:1)划分样本为清晰样本(即有情感主标签的语音样本)与模糊样本(即无情感主标签的样本);2)构建时空主干网络提取语音的时空特征;3)确定软标签纠正策略,为模糊语音样本的使用提供有效方案;4)设计用于连续变量的类间差异损失函数以便用于模型训练参数更新。

47、本发明的其他优点、目标和特征在某种程度上将在随后的说明书中进行阐述,并且在某种程度上,基于对下文的考察研究对本领域技术人员而言将是显而易见的,或者可以从本发明的实践中得到教导。本发明的目标和其他优点可以通过下面的说明书来实现和获得。

本文地址:https://www.jishuxx.com/zhuanli/20240808/271010.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。