一种考虑多系统交互作用的盾构推力矢量智能决策方法

- 国知局

- 2024-08-19 14:17:14

本发明涉及盾构施工工程领域,具体涉及一种考虑多系统交互作用的盾构推力矢量智能决策方法。

背景技术:

1、盾构机是用于隧道施工的光机电液一体化大型复杂工程装备。通过多个子系统的协同运作,盾构机可在钢制护盾的掩护下完成自动化的隧道开挖、排渣、衬砌作业。盾构推进系统可通过控制自身的液压缸压力,以调控盾构姿态以保证盾构沿隧道设计轴线掘进。而目前,盾构推进系统控制基本完全依赖盾构司机的主观操作,由于其在实际施工中是无法直接观测到前方施工的地质条件,极易出现操作误判,导致压力决策不合理。此外,盾构司机往往只关注如何调控推进系统推力矢量以减小掘进轴线,而忽略了刀盘、泥水压力平衡等系统状态稳定性对推力矢量的约束。在非稳定地质阶段,该决策值极易对刀盘及泥水平衡系统状态造成较大干扰,进而导致其状态失稳。随着盾构同步推拼技术在业内的全面推广,由于局部液压缸缺位的固有特征,以及同步推拼盾构施工距离更长、稳定性要求更高,盾构司机主导的盾构掘进轨迹调控方式更难以做出掘进参数和掘进策略的及时有效调整,所引发的盾构掘进方向“失准”、刀盘、泥水压力平衡等系统状态失稳等工程难题将进一步加剧。

技术实现思路

1、一种考虑多系统交互作用的盾构推力矢量智能决策方法,包括以下步骤:

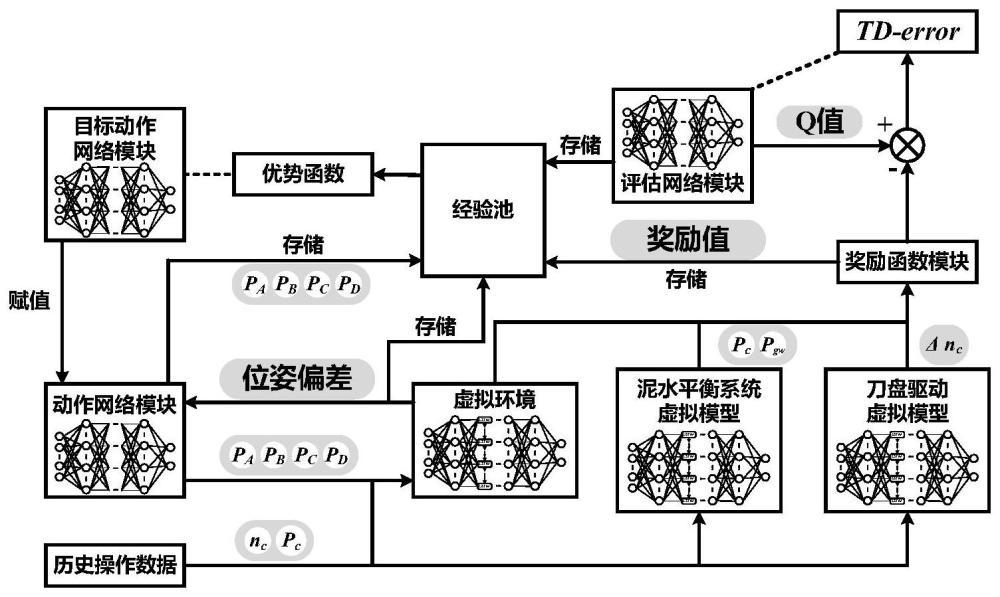

2、步骤1:建立考虑多系统交互作用的盾构推力矢量智能决策模型,所述盾构推力矢量智能决策模型包括强化学习智能体、推力动态重分配模块以及系统控制模块;所述强化学习智能体基于近端策略优化算法构建;强化学习智能体包括评估网络模块、动作网络模块和奖励函数模块;所述评估网络模块用于对盾构姿态进行评估;所述动作网络模块用于在多系统交互作用下生成用于盾构分区的动作;奖励函数模块用于根据盾构姿态输出奖励值;所述多系统包括盾构推进系统、泥水平衡系统和刀盘驱动系统;

3、步骤2:根据盾构机现场施工数据、地质数据搭建虚拟环境,根据当前盾构的分区压力以及当前盾构机的姿态参数对智能体进行训练,获得训练好的强化学习智能体;所述虚拟环境包括泥水平衡系统虚拟模块、刀盘驱动虚拟模块和盾构姿态虚拟模块,所述泥水平衡系统虚拟模块用于模拟泥水舱中心点处的泥水压力以及开挖地层水土总压力,所述刀盘驱动虚拟模块用于模拟刀盘转速的变化,所述盾构姿态虚拟模块用于模拟盾构机的盾构姿态;

4、步骤3:将盾构机的当前盾构姿态输入到盾构推力矢量智能决策模型训练好的强化学习智能体中,训练好的强化学习智能体输出决策的推力矢量值;

5、步骤4:将步骤3中决策的推力矢量值输入到推力动态重分配模块转化为考虑多系统交互作用的可用于同步推拼盾构局部回撤的分区压力值;

6、步骤5:将步骤4中用于同步推拼盾构局部回撤的分区压力值输入到系统控制模块,通过系统控制模块完成分区压力的执行。

7、作为本发明的优选方案,所述强化学习智能体用于根据盾构姿态信息输出决策的推力矢量决策值;所述推力动态重分配模块将强化学习智能体输出的推力矢量决策值转化为可用于同步推拼盾构局部回撤的分区压力值;所述系统控制模块用于根据推力动态重分配模块转化的可用于同步推拼盾构局部回撤的分区压力值完成分区压力的执行。

8、作为本发明的优选方案,步骤1中所述的现场施工数据包括盾尾水平偏差、盾首水平偏差、盾尾垂直偏差、盾首垂直偏差、泥水舱中心点处的泥水压力、开挖地层水土总压力和刀盘转速;所述地质数据包括土体内摩擦角和土体当量体积。

9、作为本发明的优选方案,步骤1中所述的强化学习智能体所需的奖励函数模块具体为:

10、r=α·rnow+β·rdelta+γ·runiformity

11、

12、

13、rsubgoal=sigmoid(|pc-pgw|)+sigmoid(δnc)

14、其中rnow表示当前状态奖励,rdelta表示状态变化奖励,rsubgoal表示子目标奖励;α、β、γ分别表示前状态奖励、状态变化奖励和分区均匀性奖励的系数;hdstn、hdshn、vdstn、vdshn表示n时刻的四个盾构姿态信息,分别为盾尾水平偏差、盾首水平偏差、盾尾垂直偏差、盾首垂直偏差;|s|max表示四个姿态信息中的最大值,表示四个姿态信息的平均值;pc表示泥水舱中心点处的泥水压力;pgw表示开挖地层水土总压力;δnc表示刀盘转速的变化;sigmoid()为激活函数。

15、作为本发明的优选方案,所述步骤2中输入当前盾构的分区压力以及当前盾构机的姿态参数对智能体进行训练具体为:输入当前盾构的分区压力以及当前盾构机的姿态参数,动作a不仅被输入到虚拟环境中会返回一个新的盾构姿态s,并根据当前盾构的分区压力模拟对泥水舱压力和刀盘转速变化的影响得出相应的影响参数;新的盾构姿态s和泥水舱压力和刀盘转速变化的影响参数输入到奖励函数模块中实时的获取到动作的奖励值r;接下来动作网络模块产生新的动作a1,动作a1被输入到虚拟环境中再次返回盾构姿态s1,如此往复进行交互;所述训练过程中产生的数据都会被保存在经验池中,当前盾构姿态和下一次的盾构姿态都会被送到评价网络模块分别得出评估值q和评估值q1;通过qtarge=r+γ'q1,得到目标评估值qtarget,其中γ'为折扣因子,r为采取动作a时获取到的奖励值;然后通过最小化qtarget和q的差值还不断更新评估网络模块的参数;并通过梯度下降方法,以将评估值q最大化为目标不断更新动作网络模块参数,使得动作网络模块决策的动作每次都能取到尽可能大的奖励值。

16、作为本发明的优选方案,通过梯度下降方法,对动作网络模块产生的动作进行评价不断更新动作网络模块参数θ,使得动作网络模块决策的动作每次都能取到尽可能大的奖励值具体实施过程如下:

17、

18、

19、θ←θ+lr·▽j(θ)

20、θ′←θ

21、其中,pθ(τ)表示动作网络采用动作网络模块参数θ执行每一次动作的概率;pθ′(τ)表示动作网络采用θ′执行每一次动作的概率;r(τ)表示各个动作的奖励值;j(θ)表示对于轨迹序列τ,能够获得的奖励期望;▽j(θ)表示奖励期望的梯度;θ为动作网络的网络参数,θ′为上一次更新的动作网络模块参数。

22、与现有技术相比,本发明具有以下有益效果:

23、本发明采用深度强化学习技术,建立了一种盾构分区压力智能决策方法,可以减少盾构司机的工作量,而且建立的虚拟环境可以定量的映射盾构环境与盾构参数决策值的关系,为盾构参数的决策提供一定的理论基础。

24、本发明在深度强化学习的同时引入了其他系统的响应指标到训练智能体的奖励函数,建立包含轴线偏差、刀盘转速、泥水中心压力等多评价指标的掘进奖励函数,使得决策的推力矢量可以兼顾其他子系统的影响,避免推进过程中由于推力矢量的变化,对刀盘和泥水压力平衡系统造成较强干扰,在一定程度上保持整体盾构的稳定性。

25、本发明在完全实现自主决策的基础上,通过推力重分配的方式完成决策方式的迁移,使得推拼交替产生的数据也可以作为同步推拼盾构训练的数据,较大的减少了数据采集的难度。

26、本发明引入的刀盘系统转速指标可以在一定程度上影响深度强化学习智能体的决策,在决策推力矢量的同时考虑推力矢量对刀盘转速的影响,尽可能避免在稳定掘进段因为推力矢量的变化而引起刀盘转速的变化。

27、本发明引入的泥水平衡系统泥水舱中心处泥水压力使得智能体在决策时受泥水平衡系统的影响,可以有效防止泥水平衡系统在掘进过程中失衡。

28、本发明所提出的分布式框架既能在智能体决策之后直接输出作用于推进系统,完成推拼交替的盾构分区压力决策;也能决策后输入至推力动态重分配模块完成同步推拼盾构的分区压力决策,使得推拼交替盾构决策的推力矢量在不需要额外成本的情况下可直接运用于同步推拼盾构中。

29、本发明所采用的智能决策思路兼顾了盾构中的其他子系统,在框架搭建中所用到的其余子系统的虚拟模型同样适用于盾构的其他子系统的决策,不仅可以在决策过程中起预警效果,同时也可以辅助盾构司机完成其他系统操作参数的决策。

本文地址:https://www.jishuxx.com/zhuanli/20240819/274593.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。