基于视听信息融合的多类别声音事件定位与检测方法

- 国知局

- 2024-08-19 14:20:20

背景技术:

1、声音事件定位和检测(sound event localization and detection,seld)的目标是在特定时间内检测声音事件的发生,并准确确定其开始和结束时间,同时追踪这些事件在活动时段内的空间位置或到达方向(即声源定位,doa)。声音事件定位和检测系统提供的时空信息在各种机器认知任务中得到广泛应用,例如:环境类型推断、自定位、遮挡目标导航、跟踪特定类型的声源、智能家居应用、场景可视化系统和音频监控等。现存的技术中融合音频和视频信息的声音事件定位和检测方案非常有限,一是音视频数据量远远小于现有的音频数据量导致模型泛化性能差的问题;二是视频带来的大量信息冗余和模态间的信息差使得模型检测和定位准确率低的问题,此外,现有的视听技术往往只能给出声音事件在视频画面内的定位,而无法定位其空间位置。

2、声音事件定位和检测由声音事件检测(sed)和声源定位(ssl)两个子任务组成。当前针对这些任务的建模方案包括联合活动概率的笛卡尔声源定位(accdoa)、联合多活动概率的笛卡尔声源定位(multi-accdoa)、声音事件联合检测与定位(sed-doa)等。同时,一些研究提出将声音事件检测和声源定位两个子任务分开建模以解决声音事件定位和检测问题。

3、在现有声音事件检测任务中,通常采用各种分类方法,如高斯混合模型(gmm)、隐马尔可夫模型(hmm)、递归神经网络(rnn)和卷积神经网络(cnn),以识别每个声音事件的时间出现。现有声源定位估计方法涵盖基于参数的方法和基于深度学习的方法,其中传统的基于参数的方法包括基于子空间的方法、到达时间差的方法、基于信号同步的方法等。基于深度学习的方法则通常利用cnn、rnn等神经网络进行分类或回归学习,以预测声源定位。然而,在复杂的多源场景中,传统信号处理技术受到严格的理想环境假设的限制,导致定位精度较低。基于深度学习的单模态声音事件定位和检测方法在多源情况下存在网络输出与真实声源之间的标签排列问题,引入误差。

4、面对高噪声、强混响和高混叠率的场景,仅依靠音频进行多个移动声源的检测和定位表现不足。随着多模态技术的快速发展,一些研究建议将音频和视频模态相结合,以更有效应对声源检测和定位问题。然而,目前大多数视听检测和定位任务主要集中在视频画面内的声源定位。在典型的公开大规模视听事件定位(ave)数据集和相应的研究中,视听事件定位主要关注视频片段内的声源,而在现有的视听技术中尚不能在空间上准确确定声音事件的位置。

5、有鉴于此,特提出本发明。

技术实现思路

1、本发明的目的是提供了一种基于视听信息融合的多类别声音事件定位与检测方法,能对多种类别声音事件的检测和定位进行联合建模,实现以较低资源的基于跨模态师生学习的声音事件定位和检测,进而解决现有技术中存在的上述技术问题。

2、本发明的目的是通过以下技术方案实现的:

3、一种基于视听信息融合的多类别声音事件定位与检测方法,包括:

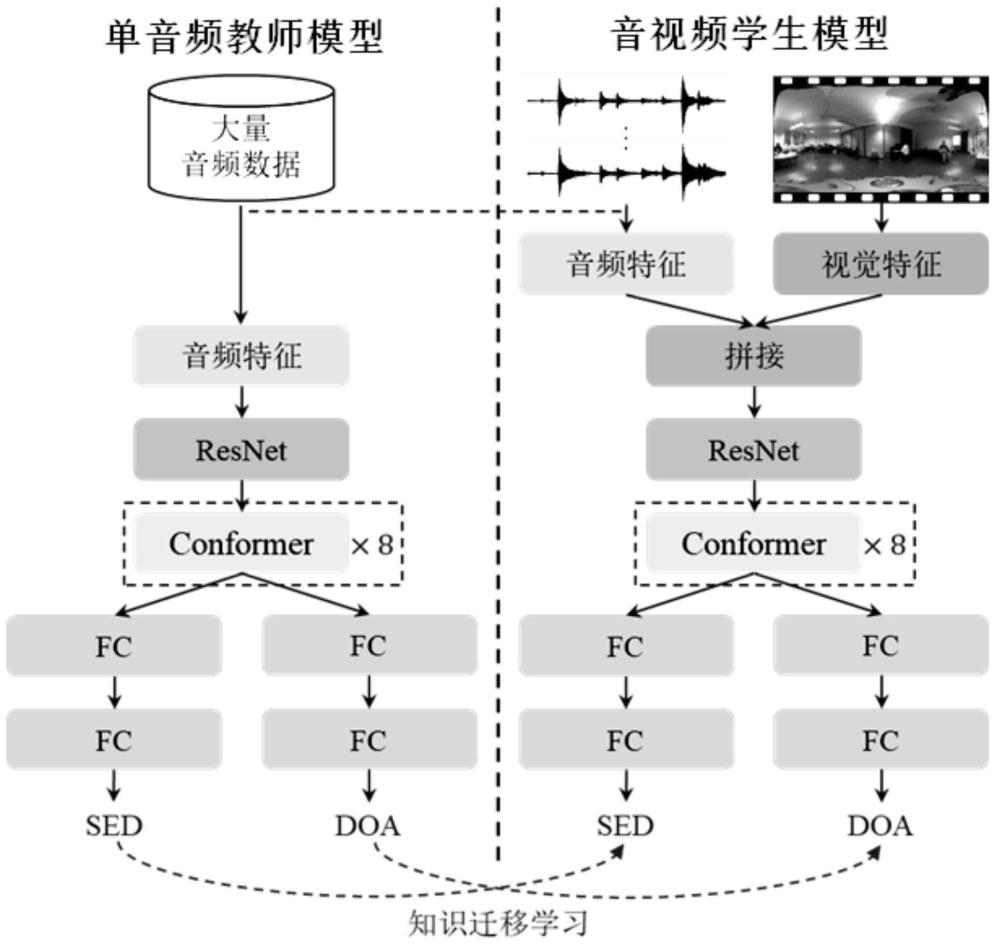

4、步骤1,利用增强数据得到的音频训练数据集对单音频教师模型进行预训练得到训练好的所述单音频教师模型;

5、步骤2,利用教师-学生跨模态学习结合利用多模态联合数据增强得到的视听数据对音视频学生模型进行迁移学习,通过跨模态师生损失函数将已训练好的所述单音频教师模型中的知识蒸馏到所述音视频学生模型中得到训练好的音视频学生模型;

6、步骤3,通过视频引导决策融合模块对步骤2训练好的所述音视频学生模型的预测结果和视频检测结果进行决策融合,得出最终的声音事件定位与检测结果。

7、与现有技术相比,本发明所提供的基于视听信息融合的多类别声音事件定位与检测系统、方法、设备及介质,其有益效果包括:

8、通过预训练单音频教师模型,再利用跨模态师生学习将单音频教师模型中的知识迁移学习至音视频学生模型中,并利用视频引导决策融合模块基于视频引导的决策融合方法和音视频联合数据增强技术,解决低资源真实音视频数据场景下,音视频声音事件定位与检测模型检测和定位不准的问题。具体来说,一是通过设计一种基于kullback-leibler(kl)散度的跨模态师生学习(tsl)方法,利用从丰富的外部音频数据中获得的知识进行跨模态迁移学习,提升了音视频声音事件定位与检测模型的泛化性能;二是提出视频像素交换(vps)方法,以联合扩展多模态音视频数据量,丰富了训练数据的时空多样性;三是提出了多模态早期特征融合和晚期视频引导的决策融合来充分利用视频信息,以实现模态间信息的深入交互和互相促进。本发明方法的优点是能够有效扩充用于训练的音视频数据量,丰富数据的时空多样性,有效实现了多种模态之间的耦合交互,同时能够提高声音事件定位与检测模型的泛化性能和鲁棒性,提升了模型对多种类别声音事件的定位和检测准确率和精度。

技术特征:1.一种基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,所述步骤1中的单音频教师模型由依次连接的18层resnet网络和8层conformer网络,以及连接在8层conformer网络后并行设置能分别执行声音事件检测估计和声源定位估计的两个分支全连接网络组成,能以拼接后的七通道音频特征序列为输入,学习并得出输入的七通道音频特征序列中的全局和局部依赖关系后,对得出的全局和局部依赖关系分别进行声音事件检测估计与声源定位估计,输出声音事件检测估计值与声源定位估计值;

3.根据权利要求2所述的基于视听信息融合的多类别声音事件定位与检测系统,其特征在于,所述单音频教师模型的两个分支全连接网络由依次连接的两层全连接层组成;

4.根据权利要求1-3任一项所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,所述步骤1中,按以下方式利用增强数据得到的音频训练数据集并对所述单音频教师模型进行预训练,包括:

5.根据权利要求1-3任一项所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,所述步骤2中,按以下方式对所述音视频学生模型进行训练,包括:

6.根据权利要求5所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,在将提取的视觉特征与音频特征进行串联,得到19维通道的时空表示的融合后多模态视听数据特征前,还包括:

7.根据权利要求6所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,所述方法中,按以下方式通过视频像素交换方法将视频数据与音频通道交换增强的音频数据成对匹配进行视听数据增强,包括:

8.根据权利要求5所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,所述步骤2中,所述教师-学生跨模态学习中的基于教师指导的声音事件检测的损失函数采用由单音频教师模型和音视频学生模型的声音事件检测输出计算得出的kl散度,作为原始音视频学生模型声音事件检测的损失函数的正则化项,其计算方法为:

9.根据权利要求1-3任一项所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,所述视频引导决策融合模块,能以视频检测引导方式对所述音视频学生模型输出的声源定位估计值进行判断并得出更准确的声源定位估计值。

10.根据权利要求9所述的基于视听信息融合的多类别声音事件定位与检测方法,其特征在于,所述方法中,视频引导决策融合模块按以下方式以视频检测引导方式对所述音视频学生模型输出的声源定位估计值进行判断并得出更准确的声源定位估计值,包括:

技术总结本发明公开了一种基于视听信息融合的多类别声音事件定位与检测方法,方法包括:步骤1,利用增强数据得到的音频训练数据集对单音频教师模型预训练;步骤2,利用教师‑学生跨模态学习结合数据增强得到的多模态视听数据对音视频学生模型进行迁移学习,通过跨模态师生损失函数将已训练好的单音频教师模型中的知识蒸馏到音视频学生模型中得到训练好的音视频学生模型;步骤3,通过视频引导决策融合模块对步骤2训练好的音视频学生模型的预测结果和视频检测结果进行决策融合,得出最终的声音事件定位与检测结果。该方法能对多种类别声音事件的检测和定位进行联合建模,以较低资源的基于跨模态师生学习的声音事件定位和检测。技术研发人员:姜娅,杜俊,王青,赵江江,任玉玲,李青龙,柳瑞波,代晓康受保护的技术使用者:中国科学技术大学技术研发日:技术公布日:2024/8/16本文地址:https://www.jishuxx.com/zhuanli/20240819/274769.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。