基于Transformer模块化分解模型方法与流程

- 国知局

- 2024-08-22 14:23:19

本发明涉及图像处理和计算机视觉,特别涉及基于transformer模块化分解模型方法。

背景技术:

1、近年来,深度神经网络越来越多地被应用到图像分类等计算机视觉任务之中。随着业务场景的复杂化和数据规模的海量化,构建和训练高性能神经网络模型成为一项非常具有挑战的任务,同时网络模型设计严重依赖专家知识,这是一项耗时且易出错的工作。因此,作为自动化机器学习(automl)的重要子领域之一,神经结构搜索(nas)受到越来越多的关注,其旨在以自动化的方式设计表现优异的深度神经网络模型。nas的研究重点之一就在于如何构造一个高效的搜索空间。最初的搜索空间的构造方法是将不同的操作单元组合在一起形成全局搜索空间,但巨大的搜索空间使得很多优化算法都无法快速解决此问题,带来了十分昂贵的计算代价。面对计算资源的为了尽量减少计算消耗,需要减小搜索空间。现在主流的研究方法主要集中在模块化网络结构领域,为了实现模块化网络结构,需要神经网络模块化分解模型这一关键技术。

技术实现思路

1、本发明的目的在于至少解决现有技术中存在的技术问题之一,提供基于transformer模块化分解模型方法,能够解决上述背景技术的问题。

2、为实现上述目的,本发明提供如下技术方案:基于transformer模块化分解模型方法,包括以下步骤:

3、步骤1:神经网络模型等效改造;

4、步骤2:重新训练改造后的transformer网络模型

5、步骤3:梯度重置;

6、步骤4:设置二进制掩码;

7、步骤5:模块化transformer;

8、步骤6:等效转化获得目标模块。

9、优选的,根据所述步骤1:给定一个训练好的transformer网络模型v,定义注意力层权重矩阵为w。结构改造后的transformer网络模型为在多头注意力层的每个注意力头hi后添加一个权重值初始化为1的模型层li作为分解器,该模型层进行哈达玛积运算。

10、优选的,根据所述步骤3:模型重训练过程采用梯度惩罚动态作用于分解器上,目的是减去对目标类无用的注意力头。重置从目标函数导出的梯度来实现高修剪性和轻微的惩罚。引入一个二进制掩码m∈{0,1},0表示将f归零,1表示不将f归零。为了便于实现,不在目标函数中添加惩罚函数,只是像往常一样推导梯度,然后手动应用掩码,添加惩罚梯度并使用结果梯度进行sgd更新。

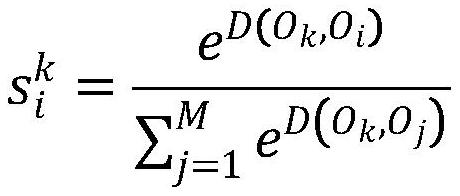

11、优选的,根据所述步骤4:经过几次迭代训练后,计算每个多头注意力层中,不同多头注意力对目标类的c的重要性度量值i。

12、优选的,根据所述步骤5:修剪模型:模型训练结束后获得结构化稀疏的模块化分解器q,根据q最终获得第l层修剪注意力头的索引集幸存集模块化修剪操作保留注意力层l的中的注意力头,令h=concat(h eadi)=[h ead1,…,h eadh],修剪后的注意力头为

13、优选的,根据所述步骤6:改造后多头注意层结构表示为attention-compactor,经过迭代训练和修剪后的多注意力层参数组表示为w,模块化分解器权重表示为q。

14、与现有技术相比,本发明的有益效果是:

15、(1)、该基于transformer模块化分解模型方法,事先训练好的transformer模型分解为一组更小且可重用的模块,通过这一独特的分解过程,生成的模块能够被灵活地重用,以构建全新的、甚至更加精准的transformer模型,而无需从头开始进行昂贵的训练。这种模块化分解方法不仅提高了模型的灵活性和可重用性,同时降低了模型开发的成本和时间,为深度学习模型的定制和优化提供了一种高效而创新的途径。

技术特征:1.基于transformer模块化分解模型方法,其特征在于:包括以下步骤:

2.根据权利要求1所述的基于transformer模块化分解模型方法,其特征在于:根据所述步骤1:给定一个训练好的transformer网络模型v,定义注意力层权重矩阵为w。结构改造后的transformer网络模型为在多头注意力层的每个注意力头hi后添加一个权重值初始化为1的模型层li作为分解器,该模型层进行哈达玛积运算。

3.根据权利要求2所述的基于transformer模块化分解模型方法,其特征在于:根据所述步骤3:模型重训练过程采用梯度惩罚动态作用于分解器上,目的是减去对目标类无用的注意力头。重置从目标函数导出的梯度来实现高修剪性和轻微的惩罚。引入一个二进制掩码m∈{0,1},0表示将f归零,1表示不将f归零。为了便于实现,不在目标函数中添加惩罚函数,只是像往常一样推导梯度,然后手动应用掩码,添加惩罚梯度并使用结果梯度进行sgd更新。

4.根据权利要求3所述的基于transformer模块化分解模型方法,其特征在于:根据所述步骤4:经过几次迭代训练后,计算每个多头注意力层中,不同多头注意力对目标类的c的重要性度量值i。

5.根据权利要求4所述的基于transformer模块化分解模型方法,其特征在于:根据所述步骤5:修剪模型:模型训练结束后获得结构化稀疏的模块化分解器q,根据q最终获得第l层修剪注意力头的索引集幸存集模块化修剪操作保留注意力层l的中的注意力头,令h=concat(headi)=[head1,…,headh],修剪后的注意力头为h'=hf(l)。

6.根据权利要求5所述的基于transformer模块化分解模型方法,其特征在于:根据所述步骤6:改造后多头注意层结构表示为attention-compactor,经过迭代训练和修剪后的多注意力层参数组表示为w,模块化分解器权重表示为q。

技术总结本发明公开了基于Transformer模块化分解模型方法,涉及图像处理和计算机视觉技术领域,该基于Transformer模块化分解模型方法,包括以下步骤:步骤1:神经网络模型等效改造;步骤2:重新训练改造后的Transformer网络模型步骤3:梯度重置;步骤4:设置二进制掩码;步骤5:模块化Transformer;步骤6:等效转化获得目标模块,事先训练好的Transformer模型分解为一组更小且可重用的模块,通过这一独特的分解过程,生成的模块能够被灵活地重用,以构建全新的、甚至更加精准的Transformer模型,而无需从头开始进行昂贵的训练。这种模块化分解方法不仅提高了模型的灵活性和可重用性,同时降低了模型开发的成本和时间,为深度学习模型的定制和优化提供了一种高效而创新的途径。技术研发人员:李宏鹏,纪树梅,郑士良,徐瑛琦,张麟,魏晓飞,张丛灿,魏强受保护的技术使用者:河钢数字技术股份有限公司技术研发日:技术公布日:2024/8/20本文地址:https://www.jishuxx.com/zhuanli/20240822/278494.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表