基于差分隐私的联邦分层学习方法

- 国知局

- 2024-08-22 14:22:59

本发明属于机器学习,具体涉及基于差分隐私的联邦分层学习方法。

背景技术:

1、近年来,计算机视觉在人脸识别、医疗保健、交通运输系统等方面有着广泛的应用。这些应用程序依赖于收集大量数据进行机器学习(ml)模型训练。在物联网(iot)时代,数据通常是从分布式设备生成和捕获的。通常,必须将所有原始数据传输到云服务器以进行进一步处理。这种方法引起了相关的关注,特别是在数据隐私和通信成本上升的领域。

2、解决这些问题的一个前瞻性解决方案是采用联邦学习(fl)。这种新兴技术允许客户端在本地训练机器学习模型,只交换模型参数,从而消除了原始数据传输的必要性,并解决了分布式学习中的隐私问题。然而,最近的研究表明,这种方法可能无法提供足够的数据隐私保障。存在通过分析从客户端训练和上传的参数的差异来推断敏感信息的风险,并且在最终训练的模型中可以追溯到信息的来源。

3、为了加强隐私保护,可以在联邦学习中采用差分隐私(dp)保护技术。通过将人工噪声添加到数据中来实现,以进一步保护数据隐私。近年来出现了多种相关优化策略,如dp-fl、apfl、lldp等,均以精细化精度为目标。然而,现有的基于dp的fl研究一般集中在整个模型参数中加入噪声。在涉及高维向量的场景中,需要在客户端设备上训练整个模型并加入噪声,这不仅对设备资源有严格的要求,而且会增加通信成本。

技术实现思路

1、本发明的目的是提供基于差分隐私的联邦分层学习方法,能够在通信资源和数据隐私保护方面优于现有方法,并证明了分层方法在隐私保护fl场景中的鲁棒性和效率。

2、本发明采取的技术方案具体如下:

3、基于差分隐私的联邦分层学习方法,包括通用的fl系统、服务器和k集合个客户端,dk表示第k个客户端的本地数据集,其中k∈{1,2,...,k};

4、所述学习方法采用以下步骤:

5、s1:客户端k基于数据样本集合训练自己的本地模型;

6、所述s1中,用j表示第j个训练样本,包括特征xj和标签yj,f(ω,xj,yj)表示损失函数,其中ω是模型参数;数据集dk上的损失函数为:

7、

8、其中,|dk|为客户端k的样本数;客户端k的学习问题是通过最小化损失函数fk(ω)找到最优模型参数ω:

9、

10、服务器的目标是从k个客户端学习全局模型;服务器将从k客户端接收到的权重添加为:

11、

12、式中,其中,为所有数据样本的总大小;优化问题可以表示为:

13、

14、k客户端协同学习由服务器协调的ml模型,迭代执行上述过程,直到优化问题得到解决。

15、s2:采用dp的数学框架,为分布式数据处理系统的差分隐私保护提供准则;

16、所述s2中,dp数学框架分为以下两种形式:

17、s21:(ε,δ)-dp:具有域三和值域p的随机机制满足(ε,δ)-dp:若所有可测集且任何两个相邻数据库

18、

19、函数m满足(ε,δ)-dp,其中,δ是一个松弛因子;若δ=0,则随机函数m给出纯微分隐私;若δ>0,则m表示同意差分隐私;利用该算法平衡隐私保护和数据效用,ε越小,隐私保护越高,数据效用越低;

20、s22:灵敏度:对于任意查询函数,将函数s的全局灵敏度定义为:

21、

22、确保给定的噪声分布n~n(0,σ2)保留(ε,δ)-dp;其中,n表示高斯分布,选择的噪声尺度为:

23、

24、s3:对每个客户端进行分层dnn训练;

25、所述s3中,每个客户端可以逐层训练模型,而不是在每一轮通信中训练完整的dnn模型;

26、dnn网络最初被划分为多个层或块,从训练一个层/块l开始,直到其参数(ωl)收敛;对于训练层/块,模型开发人员在其上附加一个新的分类器c(.),以输出预测并计算训练损失;在收敛模型上再附加一个层/块,只训练这个层/块,而先前收敛的层/块被冻结。

27、s4:客户端使用dp机制在每轮训练一层后对参数进行扰动。

28、所述s4中,采用dp机制训练步骤如下:

29、s51:模型初始化和配置:服务器负责全局模型初始化和配置;

30、服务器配置模型体系结构和参数,在每一轮中,服务器从所有客户端中选择一个子集参加这一轮的训练,并决定训练哪一层,然后将确定的训练层l的初始参数和裁剪阈值发送到选定的客户端;

31、s52:本地训练:客户端持有包含敏感信息的培训数据;

32、每个客户端使用本地数据,并行训练且只将训练层-l的参数上传到服务器,客户端在本地数据上计算层l的梯度,并裁剪其参数ωl,每个客户端根据高斯机制的差分隐私规则添加人工噪声,作为保护措施,保护敏感信息不受潜在攻击,本地训练完成后,所有参与的客户端将训练层的参数上传到上行通信通道的服务器;

33、s53:模型聚合:服务器负责从每个客户端聚合层-l上传的参数;

34、聚合过程通常涉及这些参数的加权组合,然后对训练层的加权参数进行平均,生成一个更新的聚合层,该层反映了所有参与客户端的集体知识。

35、所述s53中,在下行通信信道中保持严格的差分隐私,即(ε,δ)-dp,服务器将高斯噪声引入聚合全局模型。

36、所述对客户端采用差分隐私的分层联邦训练;

37、通过每轮通信只更新一层来保护层的更新,并通过添加高斯噪声来保护参数;若局部训练的批大小等于训练样本的数量,客户端k只上传训练层l的参数,查询函数是负责计算层l参数的函数,可以表示为:

38、

39、式中,δk为客户端k的本地数据集,为客户端k的本地模型的层l的参数,为δk中的第j个样本;的灵敏度可表示为:

40、

41、其中,cl表示层l的裁剪阈值,δk′是与δk相邻的数据集,大小相同但只相差一个样本,是δk′中的第j个样本,由上式可以定义上行信道的全局灵敏度为:

42、

43、定义客户端间本地数据集的最小大小为m;因此,

44、若每个客户端都参与了回合训练,则隐私预算为为了确保在一次曝光中上行链路中的每个客户端都有(ε,δ)-dp,设置噪声尺度:

45、

46、从下行链路的角度,δk的聚合操作可以表示为:

47、

48、其中,1≤k≤k,ωl为待广播到客户端的服务器聚合参数,聚合之后δk的灵敏度为:

49、

50、其中,在理想的情况下,所有客户端的本地数据集具有相同的数据大小,因此为保证具有t聚集的下行信道中的(ε,δ)-dp,服务器对聚集参数ωl加高斯噪声的标准差为:

51、

52、本发明取得的技术效果为:

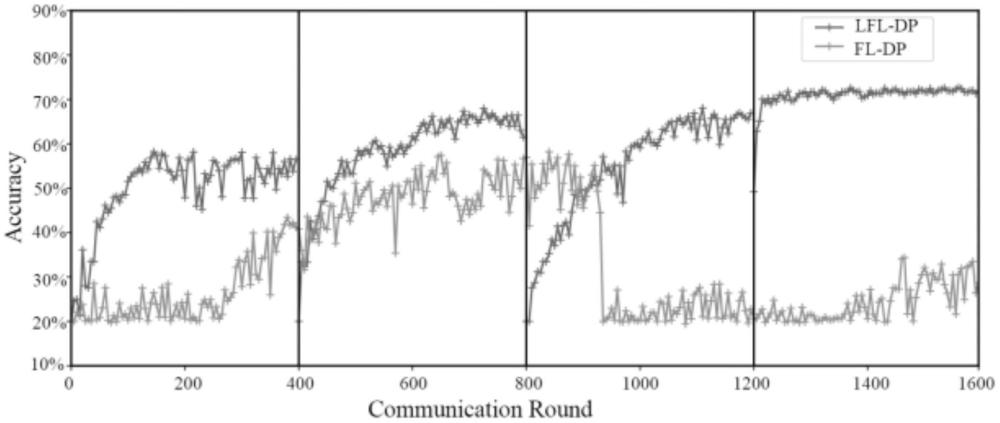

53、本发明的基于差分隐私的联邦分层学习方法在通信资源和数据隐私保护方面优于现有方法。将lfl-dp与差分隐私联邦学习(fl-dp)在精度收敛方面进行了比较,结果证明了lfl-dp在精度收敛方面优于fl-dp的性能,并证明了分层方法在隐私保护fl场景中的鲁棒性和效率。

本文地址:https://www.jishuxx.com/zhuanli/20240822/278464.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。