一种基于多级注意力机制和评论文本的推荐方法

- 国知局

- 2024-08-22 14:51:14

本发明涉及物品推荐,尤其涉及一种基于多级注意力机制和评论文本的推荐方法。

背景技术:

1、随着信息技术的飞速发展以及因特网的迅速普及,互联网上的数据呈现爆炸式增长,越来越多的信息和服务充斥着网络,人们可以方便地获取关心的各个领域中的信息,为人们生活带来便利的同时,也带来许多不便,网络中充斥的大量冗余的、无用的信息造成了信息过载现象叫,为人们选取自己想要的信息造成了阻碍。推荐系统作为减轻信息过载最常见的解决方案,能够满足用户的个性化信息需求,在各个领域得到了广泛地研究和推广,如电子商务领域、社交网络领域、教育以及电影视频推荐领域等。特别是在电子商务领域,推荐系统基于每个用户的历史数据帮助用户找到喜爱的商品,是人们进行购物、娱乐等线上活动的重要载体,也是企业获得利益的重要途径。

2、目前推荐系统可分为传统的推荐系统和基于深度学习的推荐系统方法。传统推荐算法以协同过滤算法为代表,其算法的理论核心是:从用户-物品的评分数据出发,通过用户的历史行为来对用户偏好和物品属性来进行建模,然后利用计算相似度完成目标的推荐。但是随着评分数据的稀疏性不断增大,协同过滤算法的推荐效果逐渐降低。近年来,深度学习在图像识别、机器视觉、自然语言处理等多个领域都取得了较大的实践进展。为减小数据稀疏对最终算法模型推荐效果的不利效果,研究人员尝试将用户和物品评论文本信息融入推荐算法,通过深度学习技术从用户的历史评论文本中学习用户或物品的隐藏特征信息,并取得了巨大的成功。目前,深度学习技术已被广泛应用于从评论文本中学习用户和项目的特征表示,如deepconn、d-attn、hrdr、transnets等模型,他们都是利用cnns从用户的评论中学习用户和项目的隐因子。虽然这些方法已被证明提供了良好的预测性能,但仅为每个用户和项目学习低维的隐因子特征表示还远远不够,因为它无法准确地建模来自评论中的用户-物品高阶的交互信号和提取评论中用户和物品的特征精确性偏低。然而,在个性化推荐系统的研究中,大多数基于评论的方法忽视了这一点。

技术实现思路

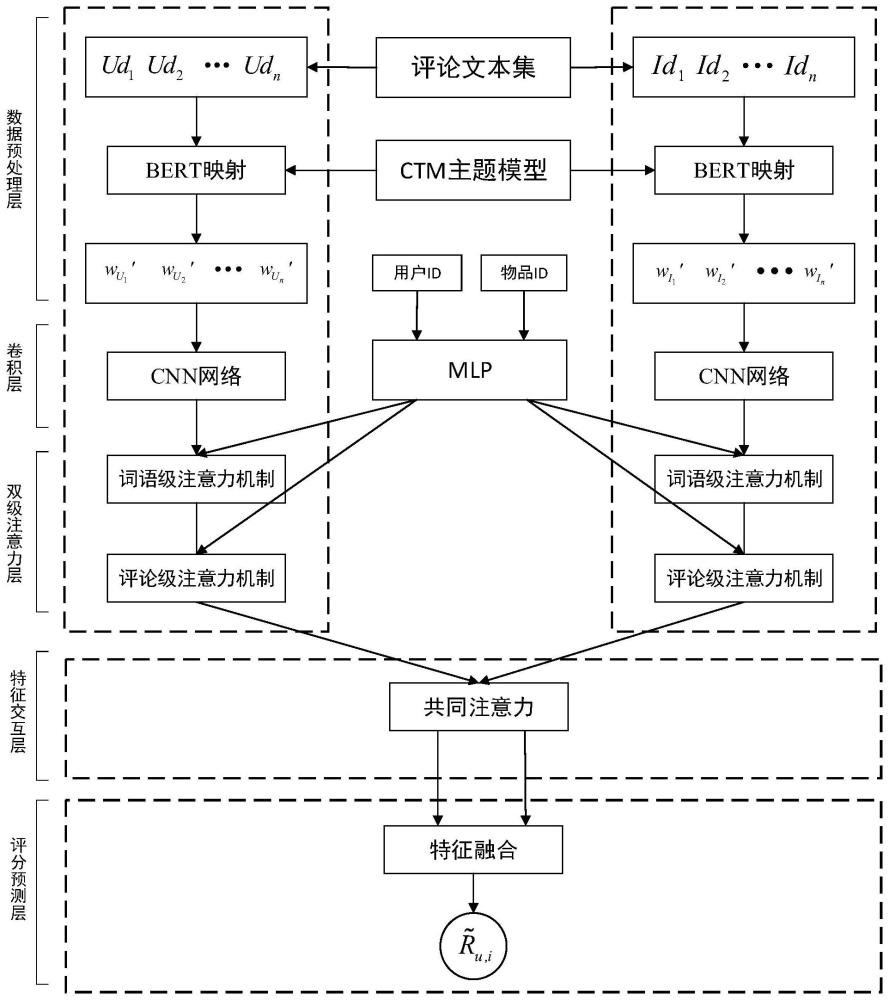

1、为了提高物品推荐的合理性和准确性,本发明提出一种基于多级注意力机制和评论文本的推荐方法,具体包括以下步骤:

2、s1、获取用户评论文本和物品评论文本,分别对用户评论文本和物品评论文本进行分词、标记和预处理,得到用户评论文本数据和物品评论文本数据;

3、s2、将用户评论文本数据和物品评论文本数据输入预训练语言模型,得到对应的词嵌入表示;

4、s3、将一个语句的所有词嵌入表示输入卷积层中获取该语句的上下文表示;

5、s4、利用多层感知机将用户id转换为用户个性化关注向量、将物品id转换为物品个性化关注向量;

6、s5、构建双层注意力层,分别将用户、物品的上下文表示及其对应的个性化关注向量输入双层注意力层中,分别获得用户、物品的个性化偏好特征;

7、s6、将用户、物品的个性化偏好特征输入共同注意力网络模拟用户与物品的交互,获取在用户影响下的物品评论的注意力权重和在物品影响下的用户评论的注意力权重;

8、s7、利用获得注意力权重分别对用户的个性化偏好特征和物品的个性化偏好特征进行加权,分别得到用户、物品的最终个性化特征表示;

9、s8、将用户、物品的最终个性化特征表示输入预测称,预测层输出用户对物品的预测评分,并将得到最高的物品推荐给用户。

10、进一步地,通过ctm主题模型获取主题向量的过程包括:利用文档中的每次词更新相似性矩阵,直到文档中单词分配到某个主题的概率以及文档的主题分布收敛,输出此时的文档中单词分配到某个主题的概率作为该文档的主题向量;文档中单词分配到某个主题的概率以及文档的主题分布的更新过程包括:

11、

12、其中,表示文档d中第n个词属于主题k的概率;a∝b表示a正比于b;为在主题k下文档d中第n个词wd,n的分布;表示在文档d中的主题k的重要性;ψ(·)为digamma函数;k为主题的个数;γd为文档d的主题分布;α为主题分布的先验参数;φd,n表示文档d中第n个词属于各个主题的概率,nd为文档d中的词的个数。

13、进一步地,将一个语句的所有词嵌入表示输入卷积层中获取该语句的上下文表示的过程表示为:

14、

15、其中,为单词wi经卷积操作而学习的上下文表示,f为激活函数;uw为卷积的参数,bw为卷积操作中的偏置项,为目标单词的上下文,kw为卷积核的宽度。

16、进一步地,双层注意力层包括级联的词语级注意力机制和评论级注意力机制,每个注意力机制均将加入对应上下文表示的个性化向量。

17、进一步地,词语级注意力机制对数据的处理过程包括:

18、使用多层感知机将用户或者物品的id信息转换为对应的个性化关注向量,转换过程包括:

19、qw=relu(w1uid+b1)

20、使用词语级注意力机制,捕捉词的重要性,该过程包括:

21、

22、将一条评论语句中所有词向量聚合在一起,形成用户的一条评论语句的表示,包括:

23、

24、其中,qw为词语级注意力机制的个性化关注向量;w1为词语级注意力机制中多层感知机可学习的权重参数,b1为词语级注意力机制中多层感知机可学习的偏置参数,relu(·)为relu激活函数,uid为用户或者物品的id信息;表示评论语句中第k个单词在词语级注意力机制中的重要性,a1为词语级注意力机制的可学习的网络参数,为评论语句中第k个单词的词向量表示,t为评论语句s中单词个数;si为评论文本中第i个评论语句的上下文表示,n为评论文本中评论语句的个数。

25、进一步地,评论级级注意力机制对数据的处理过程包括:

26、使用多层感知机将用户或者物品的id信息转换为对应的个性化关注向量,转换过程包括:

27、qd=relu(w2uid+b2)

28、使用评论级注意力机制,来捕捉同一用户对不同物品的评论、或者不同用户对同一物品不同评论的重要性,即:

29、

30、对用户或物品的每一条评论进行加权,得到用户或物品个性化偏好信息的评论表示,包括:

31、

32、其中,qd为评论级级注意力机制的个性化关注向量;w2为评论级级注意力机制中多层感知机的可学习权重参数,b2为评论级级注意力机制中多层感知机的可学习权重参数偏置参数,relu(·)为relu激活函数,uid为用户或者物品的id信息;a2为评论级级注意力机制的可学习的网络参数,sk为评论文本中第k个评论语句的上下文表示,为文档d中第k条评论的注意力权重;表示第j条评论的用户个性化偏好的评论表示。

33、进一步地,在计算重要性时,加入权重系数,权重系数的计算包括:

34、

35、其中,tdu,k表示用户u的第k条评论对用户u时间权重系数;λ表示时间衰变速度控制因子,tp表示用户u的评论集序列中的最后一条评论的行为时间,tk表示用户u的评论集序列中第k条评论的行为时间。

36、进一步地,将用户、物品的个性化偏好特征输入共同注意力网络模拟用户与物品的交互的过程包括:

37、计算用户的个性化偏好特征和物品的个性化偏好特征之间的相关性,包括:

38、

39、在计算完关联矩阵之后,将其作为一种特征来分别学习用户和物品的注意力权重,包括:

40、h=tanh(w5d1+(w6d2)c)

41、

42、其中,wc、w5、w6、w7为可学习的网络参数;d1、d2为物品或用户的个性化偏好特征,且d1和d2不能同时为物品的个性化偏好特征或者同时为用户的个性化偏好特征;v为在用户影响下的物品评论的注意力权重和在物品影响下的用户评论的注意力权重。

43、进一步地,用户、物品的最终个性化特征表示表示为:

44、

45、

46、其中,pu为用户最终的个性化特征特征,为第j条评论的在所有物品影响下的注意力权重,为第j条评论对应的用户的个性化偏好特征;pi为物品最终的个性化特征,为第j条评论的在所有用户影响下的注意力权重,为第j条评论对应的物品的个性化偏好特征。

47、进一步地,预测层获取用户对物品的预测评分的过程表示为:

48、

49、其中,ru,i表示用户对物品的预测评分;pu为用户最终的个性化特征;pi为物品最终的个性化特征;bu为用户u的评分偏置项;bi为物品i的评分偏置项;μ为用户u所有评分的均值。

50、本发明的有益效果表现在以下几个方面:

51、(1)相对于现有技术中广泛应用的词嵌入模型,本发明采用的是bert模型。bert模型利用了深层双向语境的表示能力,能够更加准确地捕捉词语间复杂的语义关系和句子结构。这种深度双向理解显著提高了文本特征的提取能力,尤其是在理解用户评论的语境和隐含意义上,相较于其他模型,bert能更好地把握语言的细微差别,从而为推荐系统提供更为丰富和精确的语义特征,显著提升推荐的相关性和准确性。

52、(2)本发明使用的双级注意力机制,包括词语级注意力机制和评论级注意力机制。通过将每个用户或物品的唯一id信息融入到注意力机制中,本发明能够更有效地区分并挖掘不同用户或物品的个性化特征。这种个性化的特征提取方式,不仅提高了特征提取的精度,还增强了模型对用户或物品独特偏好和特性的理解,从而使得推荐结果更加贴合用户的实际需求,增强了用户体验。

53、(3)通过加入特征交互注意力层,本发明进一步提升了对用户与物品之间高阶交互信号的建模能力。这一层通过精细的权重分配,能够有效捕捉评论文本中蕴含的复杂用户-物品关系,为推荐系统提供了一种更加动态和细粒度的特征表达方式。这不仅增强了模型对于用户行为和物品属性之间交云互的理解,也使得最终的推荐更加精准,提高了推荐系统的性能。

54、综上所述,本发明显著提升了推荐系统的特征提取能力和交互建模准确性,从而大幅度提高了推荐的质量和用户满意度。

本文地址:https://www.jishuxx.com/zhuanli/20240822/280128.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表