基于NPU的计算机视觉算子加速方法、系统及电子设备与流程

- 国知局

- 2024-08-22 15:11:23

本技术涉及图像处理,尤其涉及一种基于npu的计算机视觉算子加速方法、系统及电子设备。

背景技术:

1、算子处理为图像处理的环节之一。其中,算子是指的是用于执行特定图像处理任务的算法或函数,如滤波、边缘检测、形态学操作等,这些算子可应用于机器视觉、计算机视觉和图像处理等应用场景,用于在复杂的图像数据中提取出有用的信息,进而实现图像的增强、分析和识别。

2、为了进行算子处理,在软件方面可以将opencv(open source computer visionlibrary,开源计算机视觉库)移植到电子设备中,通过opencv提供的图像处理算子来执行各种图像处理任务。例如,根据电子设备的操作系统和硬件架构来编译和配置opencv库,以便于电子设备调用opencv提供的算子函数。但是,opencv主要运行在cpu或dsp上,会占用较多的计算资源,导致其他任务的性能受到影响。

3、因此,为了改善软件方面移植opencv所产生的性能下降问题,还可以设计如ive(image video engine,图像视频引擎)的硬件电路或处理器来执行算子处理,以提高图像处理任务的效率和性能。然而,由于算子的多样性,设计硬件电路或处理器会增加电子设备的复杂性和成本,如增加芯片的面积等,硬件电路或处理器未覆盖的算子则无法被执行,导致电子设备中算子处理的局限性增加。

技术实现思路

1、本技术提供一种基于npu的计算机视觉算子加速方法、系统及电子设备,以解决电子设备中算子处理局限性高的问题。

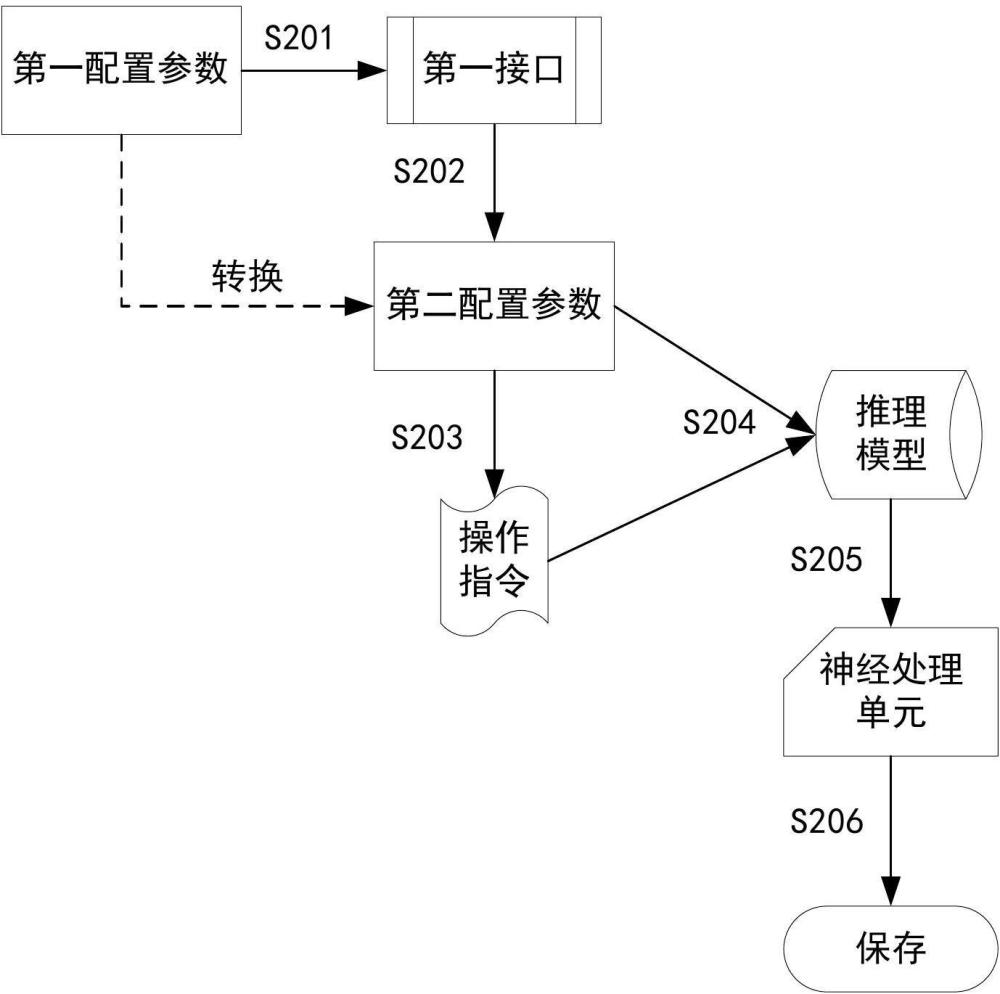

2、第一方面,本技术一些实施例提供一种基于npu的计算机视觉算子加速方法,所述方法包括以下步骤:

3、接收第一配置参数,所述第一配置参数用于设置目标图像算子的操作目标,所述目标图像算子为用于在神经处理单元中执行的变换函数,所述目标图像算子对应的第一接口与计算机视觉算子对应的第二接口对齐;

4、将所述第一配置参数转换为第二配置参数,所述第二配置参数为适用于所述神经处理单元的配置参数;

5、按照所述第二配置参数生成操作指令;

6、根据所述操作指令和所述第二配置参数构建推理模型;

7、将所述推理模型发送至所述神经处理单元,以使所述神经处理单元按照所述推理模型执行推理任务;

8、保存所述神经处理单元执行推理任务的上下文信息,以使所述目标图像算子通过所述上下文信息执行图像处理。

9、本技术一些实施例中,所述第一配置参数包括插值方式、对齐方式、缩放倍数、数据存储地址以及滤波算子的卷积核中的至少一项。

10、本技术一些实施例中,所述将所述第一配置参数转换为第二配置参数,包括:解析所述第一配置参数的数据格式;当所述数据格式与预设的模板格式相同时,通过所述第一接口修改所述第一配置参数的数据结构和/或数据类型,以生成所述第二配置参数;将所述第二配置参数传递至所述神经处理单元的算子层,以使所述算子层按照所述第二配置参数生成所述操作指令。

11、本技术一些实施例中,所述按照所述第二配置参数生成操作指令,包括:通过所述算子层调用工具链应用生成指令编码,所述工具链应用为所述神经处理单元对应工具链的应用,所述指令编码包括操作码字段、操作数字段、控制位字段中的至少一项;封装所述指令编码,以生成所述操作指令。

12、本技术一些实施例中,通过所述算子层调用工具链应用生成指令编码前,还包括:检测所述目标图像算子的算子类型;如果所述目标图像算子是组合算子,执行通过所述算子层调用工具链应用生成指令编码的步骤,并按照预设的调度逻辑生成所述目标图像算子的调度指令,以使所述算子层根据所述调度指令调度所述操作指令的顺序;所述组合算子为由多个所述神经网络单元拼接生成的图像算子。

13、本技术一些实施例中,所述根据所述操作指令和所述第二配置参数构建推理模型,包括:将所述操作指令、所述第二配置参数、所述神经处理单元中算子层的算子层参数以及关联参数打包至模型文件,所述关联参数包括激活函数参数、优化参数、所述推理模型的元信息中的至少一项;根据所述模型文件生成所述推理模型。

14、本技术一些实施例中,所述将所述推理模型发送至所述神经处理单元,包括:加载所述推理模型的模型文件;将所述模型文件传递至所述神经处理单元的推理引擎;通过所述推理引擎将所述模型文件传递至所述神经处理单元。

15、本技术一些实施例中,所述第一接口包括同步接口和异步接口,所述方法还包括:通过所述第一接口加载所述上下文信息;按照所述上下文信息执行所述推理任务,以加快所述目标图像算子的处理速度。

16、第二方面,本技术一些实施例还提供一种基于npu的计算机视觉算子加速系统,包括第一接口、算子处理单元和神经处理单元,其中:

17、所述第一接口,被配置为接收第一配置参数,所述第一配置参数用于设置目标图像算子的操作目标,所述目标图像算子为用于在神经处理单元中执行的变换函数,所述目标图像算子对应的第一接口与计算机视觉算子对应的第二接口对齐;将所述第一配置参数转换为第二配置参数,所述第二配置参数为适用于所述神经处理单元的配置参数。

18、所述算子处理单元,被配置为按照所述第二配置参数生成操作指令;根据所述操作指令和所述第二配置参数构建推理模型;将所述推理模型发送至所述神经处理单元。

19、所述神经处理单元,被配置为按照所述推理模型执行推理任务,并将所述推理任务发送至所述第一接口,以使所述第一接口保存所述神经处理单元执行推理任务的上下文信息,所述上下文信息用于执行所述目标图像算子的图像处理。

20、第三方面,本技术一些实施例还提供一种电子设备,包括处理器、存储器和总线。其中,所述处理器和存储器通过所述总线通信连接,所述存储器存储有可被所述处理器执行的计算机程序指令,所述处理器被配置为:

21、接收第一配置参数,所述第一配置参数用于设置目标图像算子的操作目标,所述目标图像算子为用于在神经处理单元中执行的变换函数,所述目标图像算子对应的第一接口与计算机视觉算子对应的第二接口对齐;

22、将所述第一配置参数转换为第二配置参数,所述第二配置参数为适用于所述神经处理单元的配置参数;

23、按照所述第二配置参数生成操作指令;

24、根据所述操作指令和所述第二配置参数构建推理模型;

25、将所述推理模型发送至所述神经处理单元,以使所述神经处理单元按照所述推理模型执行推理任务;

26、保存所述神经处理单元执行推理任务的上下文信息,以使所述目标图像算子通过所述上下文信息执行图像处理。

27、由以上技术方案可知,本技术一些实施例提供的基于npu的计算机视觉算子加速方法、系统及电子设备,所述方法可以接收第一配置参数。其中,第一配置参数用于设置目标图像算子的操作目标,目标图像算子为用于在神经处理单元中执行的变换函数,目标图像算子对应的第一接口与计算机视觉算子对应的第二接口对齐。再将第一配置参数转换为适用于所述神经处理单元的第二配置参数,并按照第二配置参数生成操作指令。根据操作指令和第二配置参数构建推理模型,并将推理模型发送至神经处理单元,以使神经处理单元按照推理模型执行推理任务。再保存神经处理单元执行推理任务的上下文信息,以使目标图像算子通过上下文信息执行图像处理。所述方法无需占用cpu或dsp的计算资源,可提升图像算子处理速度,适配于不同的图像处理场景。

本文地址:https://www.jishuxx.com/zhuanli/20240822/281554.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。