一种复杂天气下基于YOLO的目标检测方法和系统

- 国知局

- 2024-09-05 14:53:41

本发明属于计算机视觉目标检测,更具体地,涉及一种复杂天气下基于yolo的目标检测方法和系统。

背景技术:

1、目标检测作为计算机视觉领域的核心任务之一,近年来在自动驾驶、安防监控、智能交通等领域得到广泛应用。然而,复杂天气条件对目标检测的准确性和鲁棒性提出了严峻挑战。例如,在自动驾驶领域中,恶劣的天气条件如雨雪、雾霾等会导致图像质量下降,从而影响目标检测算法的性能。此外,一些伪装目标在纹理、颜色、形状等方面与背景高度相似,容易被忽略,给目标检测带来额外的困难。而且当训练数据与实际测试场景中的分布差异较大时,进一步限制了目标检测模型的性能。因此,亟待一种新的目标检测技术来提高在复杂天气下的准确性和鲁棒性,并解决训练数据与实际场景之间的分布差异问题。

2、目前,常见的目标检测方法主要有以下几种:第一种是基于区域提议的方法,如r-cnn模型等。这类方法首先从图像中生成相关区域,然后通过训练神经网络对其进行分类;第二种是基于单阶段回归的方法,如单阶段目标检测器(single shot multiboxdetector,简称ssd)模型等,这类方法通过单个卷积神经网络预测对象标签和边界框坐标;第三种是基于特征金字塔网络的方法,如faster r-cnn等,这类方法通过构建特征金字塔,实现多尺度特征融合,提高检测性能。

3、然而,上述三种方法均存在一些不可忽略的缺陷:第一,基于区域提议的方法虽然检测准确度较高,但速度较慢,导致实时检测效率低。第二,基于单阶段回归的方法具有较快的识别速度,但在面对复杂环境、伪装目标等问题时,检测性能明显下降。第三,基于特征金字塔网络的方法,由于忽略了基于天气的图像恢复过程中可以获得的潜在信息,导致模型的鲁棒性不足。

技术实现思路

1、针对现有技术的以上缺陷或改进需求,本发明提供了一种复杂天气下基于yolo的目标检测方法和系统,其目的在于,解决现有基于区域提议的方法虽然检测准确度较高,但速度较慢,导致实时检测效率低的技术问题,以及现有基于单阶段回归的方法具有较快的识别速度,但在面对复杂环境、伪装目标等问题时,检测性能明显下降的技术问题,以及现有基于特征金字塔网络的方法,由于忽略了基于天气的图像恢复过程中可以获得的潜在信息,导致模型的鲁棒性不足的技术问题。

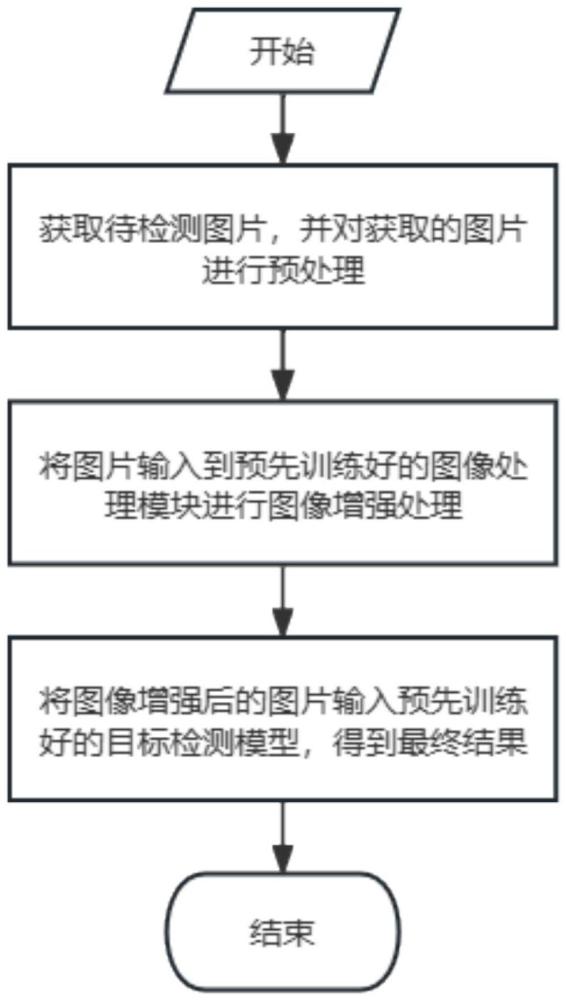

2、为实现上述目的,按照本发明的一个方面,提供了一种复杂天气下基于yolo的目标检测方法,包括以下步骤:

3、(1)获取待检测图像,并对获取的待检测图像进行预处理,以得到预处理后的图像。

4、(2)将步骤(1)预处理后的图像输入预先训练好的图像处理模型进行图像增强处理,以得到图像增强后的图像。

5、(3)将步骤(2)得到的图像增强后的图像输入预先训练好的目标检测模型,以得到最终的目标检测结果。

6、优选地,步骤(1)具体为,首先,使用512×512的分辨率大小对获取的待检测图像进行尺度调整,然后,将尺度调整后的图像的像素值从[0,255]范围归一化到[0,1]范围,从而得到预处理后的图像。

7、优选地,图像处理模型是微分图像处理dip模型,其是通过以下步骤训练得到的:

8、(2-1)获取包含正常天气条件和复杂天气条件的图像数据集,对该图像数据集进行筛选操作,以获取筛选后的图像数据集。

9、(2-2)对步骤(2-1)筛选后的图像数据集先后进行预处理和目标标注操作,以得到包含标注文件的图像数据集;

10、(2-3)将步骤(2-2)得到的包含标注文件的图像数据集按照8:2的比例划分为训练集和验证集;

11、(2-4)构建图像处理模型,其包括六个可微分滤波器,并确定该图像处理模型的输入和输出,其输入为待处理的原始图像,输出为增强后的图像。

12、(2-5)将步骤(2-3)得到的训练集中的所有去雾图像输入第一可微分滤波器中进行训练,并计算损失函数值,利用该损失函数值对第一可微分滤波器的模型参数进行更新,以得到第一可微分滤波器更新后的参数。

13、(2-6)将步骤(2-3)得到的训练集中的所有白平衡图像输入第二可微分滤波器中进行训练,并计算损失函数值,利用该损失函数值对第二可微分滤波的模型参数进行更新,以得到第二可微分滤波器更新后的参数。

14、(2-7)将步骤(2-3)得到的训练集中的所有伽马校正图像输入第三可微分滤波器中进行训练,并计算损失函数值,利用该损失函数值对第三可微分滤波的模型参数进行更新,以得到第三可微分滤波器更新后的参数。

15、(2-8)将步骤(2-3)得到的训练集中的所有对比度图像输入第四可微分滤波器中进行训练,并计算损失函数值,利用该损失函数值对第四可微分滤波的模型参数进行更新,以得到第四可微分滤波器的更新后的参数。

16、(2-9)将步骤(2-3)得到的训练集中的所有色调图像输入第五可微分滤波器中进行训练,并计算损失函数值,利用该损失函数值对第五可微分滤波的模型参数进行更新,以得到第五可微分滤波器的更新后的参数。

17、(2-10)将步骤(2-3)得到的训练集中的所有锐化图像输入第六可微分滤波器中进行训练,并计算损失函数值,利用该损失函数值对第六可微分滤波的模型参数进行更新,以得到第六可微分滤波器的更新后的参数。

18、(2-11)使用验证集对步骤(2-5)到步骤(2-10)得到的六个滤波器更新后的参数进行验证调整,从而得到训练好的图像处理模型。

19、优选地,步骤(2-1)对图像数据集进行筛选操作,具体是使用直方图分析法评估其中每张图像的清晰度,剔除模糊、低质量的图像,并采用过采样的方法确保数据集中包含多种类别的图像,并保持不同类别图像之间的数量平衡;其中共有六种类别的图像:去雾图像、白平衡图像、伽马校正图像、对比度图像、色调图像、以及锐化图像;

20、步骤(2-2)中的目标标注过程,是确定图像数据集中每个图像中待检测物体的位置边界框和所属类别,从而形成该图像对应的json格式标注文件,图像数据集中所有图像对应的json格式标注文件构成包含标注文件的图像数据集。

21、优选地,步骤(2-5)中的损失函数采用的是交叉熵损失函数;

22、第一可微分滤波器对应的模型参数的计算公式如下:

23、t(x,ω)=1―ω*minc,(miny∈ω(x)ic(y)/ac)

24、其中,ω是控制去雾程度的可学习参数,其取值范围是0到1,优选为0.75,ic(y)是去雾图像i在颜色通道c和位置y处的像素值,ac是估计的全局大气光,ω(x)是以x为中心的局部窗口,minc表示取颜色通道c的最小值。

25、步骤(2-6)中的损失函数采用的是交叉熵损失函数。

26、第二可微分滤波器对应的模型参数的计算公式如下:

27、pw=(wr*ri,wg*gi,wb*bi)

28、其中,其中wr、wg、wb分别是r、g、b通道的增益因子,其取值范围是1到2,优选为1.25,ri、gi、bi分别是白平衡图像的r、g、b通道像素值。

29、步骤(2-7)中的损失函数采用的是交叉熵损失函数。

30、第三可微分滤波器对应的模型参数的计算公式如下:

31、pg=pi^g

32、其中,g是可学习的gamma值,其取值范围是0到1,优选为0.75,pi是伽马校正图像的像素值。

33、优选地,步骤(2-8)中的损失函数采用的是交叉熵损失函数。

34、第四可微分滤波器对应的模型参数的计算公式如下:

35、pt=α*en(pi)+(1-α)*pi

36、其中,α是可学习的对比度参数,其取值范围是0到1,优选为0.75,en(pi)是输入图像pi的对比度增强版本,pi是对比度图像的像素值;

37、步骤(2-9)中的损失函数采用的是交叉熵损失函数。

38、第五可微分滤波器对应的模型参数的计算公式如下:

39、pc=1/tl*∑(clip(l*pi―j,0,1)*tk)

40、其中,tk是可学习的色调参数,tl是色调参数的个数,pi是色调图像的像素值,po是输出图像的像素值,l是线性插值间隔,j是插值索引,且有j=0,…,l-1。

41、步骤(2-10)中的损失函数采用的是交叉熵损失函数。

42、第六可微分滤波器对应的模型参数的计算公式如下:

43、f(x,λ)=i(x)+λ*(i(x)-gau(i(x)))

44、其中,λ是可学习的锐化程度参数,其取值范围是0到1,优选为0.75,i(x)是锐化图像的像素值,gau(i(x))是锐化图像i(x)的像素值的高斯模糊值。

45、优选地,目标检测模型是yolo模型,其是通过以下步骤训练得到的:

46、(3-1)通过感知传感器获取待检测图像集合,将待检测图像集合按照8:2的比例划分为训练集和测试集。

47、(3-2)对步骤(3-1)得到的训练集进行预处理,得到预处理后的训练集。

48、(3-3)针对步骤(3-2)得到的预处理后的训练集中的每一个样本而言,将其输入到卷积层,以得到该样本对应的、尺寸为256×256×32的特征图。

49、(3-4)针对步骤(3-2)得到的预处理后的训练集中的每一个样本而言,将步骤(3-3)得到的该样本对应的、尺寸为256×256×32的特征图输入到密集模块中进行特征重用和卷积操作,以得到该样本对应的、尺寸为256×256×256的特征图。

50、(3-5)针对步骤(3-2)得到的预处理后的训练集中的每一个样本而言,将步骤(3-4)得到的该样本对应的、尺寸为256×256×256的特征图输入到过渡模块中进行最大值池化处理,以得到该样本对应的、尺寸为64×64×256的特征图。

51、(3-6)针对步骤(3-2)得到的预处理后的训练集中的每一个样本而言,对步骤(3-5)得到的该样本对应的、尺寸为64×64×256的特征图进行上采样操作,并将采样操作结果与步骤(3-4)得到的该样本对应的、尺寸为256×256×256的特征图进行融合,从而得到该样本对应的、三个尺寸分别为64×64、128×128和256×256的特征层。

52、(3-7)针对步骤(3-2)得到的预处理后的训练集中的每一个样本而言,对步骤(3-6)得到的该样本对应的三个特征层进行1×1的卷积操作,并将卷积操作的结果分别输入到两个平行分支中,并将两个分支的输出结果进行堆叠,最终输出该样本对应的目标检测结果。

53、(3-8)针对步骤(3-2)得到的预处理后的训练集中的每一个样本而言,根据步骤(3-7)得到的该样本对应的目标检测结果计算损失函数,并利用该损失函数对目标检测模型进行迭代训练,直到该基于yolo的目标检测模型收敛为止,以得到初步训练好的基于yolo的目标检测模型。

54、(3-9)将步骤(3-1)得到的测试集输入步骤(3-8)初步训练好的基于yolo的目标检测模型进行验证,直到得到的检测精度达到最优为止,以得到训练好的基于yolo的目标检测模型。

55、优选地,目标检测模型的损失函数计算公式为:

56、lt=ldet+λ*ldc

57、其中,λ是grl的系数,用于平衡检测损失和分类损失,其取值范围是0到1,优选为0.75,ldet表示检测损失,ldc表示分类损失。

58、优选地,检测损失ldet使用的是focal loss损失函数,其计算公式为:

59、

60、其中,i表示该样本的第i个预测框,i∈[1,样本中预测框的总数],j表示该样本的第j个真实框,j∈[1,样本中预测框的总数],yij表示第i个预测框与第j个真实框的iou值,用于判断是否为正样本,pij表示第i个预测框属于第j个类别的概率,α表示平衡因子,取值为0.5,用于平衡正负样本的数量,γ表示聚焦参数,取值为0.25,用于聚焦于难例样本。

61、分类损失ldc使用的是二分类交叉熵损失函数,计算公式为:

62、

63、其中,x和y表示样本在步骤(3-3)得到的特征图中的位置坐标,t表示该样本的真实标签,取值为0或1,p(x,y)表示该样本在(x,y)这一位置上目标预测为真的概率。

64、按照本发明的另一方面,提供了一种复杂天气下基于yolo的目标检测系统,包括:

65、第一模块,用于获取待检测图像,并对获取的待检测图像进行预处理,以得到预处理后的图像。

66、第二模块,用于将第一模块预处理后的图像输入预先训练好的图像处理模型进行图像增强处理,以得到图像增强后的图像。

67、第三模块,用于将第二模块得到的图像增强后的图像输入预先训练好的目标检测模型,以得到最终的目标检测结果。

68、总体而言,通过本发明所构思的以上技术方案与现有技术相比,能够取得下列有益效果:

69、(1)本发明由于采用了步骤(1)和步骤(2),通过预处理和微分图像处理模型的训练,实现对待检测图像的增强处理,因此能够解决目标检测实时检测效率低的问题。

70、(2)本发明由于采用了步骤(3-8),通过结合focal loss和二分类交叉熵损失函数对目标检测模型进行训练,实现对待检测图像中复杂环境伪装目标的有效识别,因此能够解决面对复杂环境伪装目标时检测性能下降的问题。

71、(3)本发明由于采用了步骤(2-5)到(2-10),通过训练多个专门设计的可微分滤波器和目标检测模型,实现对待检测图像中目标的精确识别,因此能够解决目标检测模型的鲁棒性不足的问题。一种复杂天气下基于yolo的目标检测系统,包括:

72、第一模块,用于获取待检测图像,并对获取的待检测图像进行预处理,以得到预处理后的图像。

73、第二模块,用于将第一模块预处理后的图像输入预先训练好的图像处理模型进行图像增强处理,以得到图像增强后的图像。

74、第三模块,用于将第二模块得到的图像增强后的图像输入预先训练好的目标检测模型,以得到最终的目标检测结果。

75、总体而言,通过本发明所构思的以上技术方案与现有技术相比,能够取得下列有益效果:

76、(1)本发明由于采用了步骤(1)和步骤(2),通过预处理和微分图像处理模型的训练,实现对待检测图像的增强处理,因此能够解决目标检测实时检测效率低的问题。

77、(2)本发明由于采用了步骤(3-8),通过结合focal loss和二分类交叉熵损失函数对目标检测模型进行训练,实现对待检测图像中复杂环境伪装目标的有效识别,因此能够解决面对复杂环境伪装目标时检测性能下降的问题。

78、(3)本发明由于采用了步骤(2-5)到(2-10),通过训练多个专门设计的可微分滤波器和目标检测模型,实现对待检测图像中目标的精确识别,因此能够解决目标检测模型的鲁棒性不足的问题。

本文地址:https://www.jishuxx.com/zhuanli/20240905/288738.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。