基于蒸馏提升BERT的财经新闻情感分析方法和装置与流程

- 国知局

- 2024-09-11 15:12:03

本发明属于自然语言处理,具体涉及一种基于蒸馏提升bert的财经新闻情感分析方法和装置。

背景技术:

1、金融市场构成一个复杂且充满不确定性的体系,受到宏观经济环境、公司绩效、政策法规以及投资者情绪等多种因素的影响。其中,投资者情绪被认为是影响资产价格波动的重要因素之一,投资者的情绪和期望直接影响其对风险的态度和决策,从而影响资产的需求和定价。财经新闻是主要的金融信息传播渠道之一,在塑造投资者情绪和决策方面发挥着重要作用。新闻报道不仅传递事实信息,还赋予信息情感色彩和主观解读,因此影响投资者对信息的感知和反应。积极的新闻报道通常会提升投资者信心,而消极的报道可能引发恐慌情绪。情感分析的目标是自动识别和量化文本中的主观观点、情感倾向和情绪状态,通过对财经新闻进行情感分析,能够洞察市场情绪走向,发现被忽视的投资机会,并为量化投资模型提供情绪信号等辅助信息。

2、如公开号为cn110298403a的中国专利申请提供了一种财经新闻中企业主体的情感分析方法和系统,基于文本表示模型bert和双存储结构的记忆网络模型设计而得,用于对待分类的新闻数据中的企业主体的情感标签进行分类预测。公开号为cn112860853a的中国专利申请提供了一种基于bert和var模型的财经新闻情感分析方法,通过训练和微调bert训练模型得到财经新闻情感分类器用于提取财经新闻的情感信息,结合情感信息和个股市场表现进行相关性分析,构建计量经济学var模型,进行时间序列分析并对金融市场收益表现进行预测。但现有方法对于上下文语义信息的理解能力仍有待提升,并且存在模型较为复杂的问题。

3、与传统基于词典或机器学习的情感分析方法相比,基于大语言模型的方法已经展现出明显优势,传统方法通常依赖于预定义的情感词典或有限的标注数据,无法充分捕捉复杂的语义和上下文信息,而大语言模型能够有效捕捉长距离的上下文依赖关系,更好地理解新闻报道的全貌。然而,大语言模型通常具有庞大的参数量和复杂的网络结构,这使得它们在实际应用中存在一定的效率和部署问题。因此,迫切需要一种方法,能够将大语言模型的情感分析能力迁移到训练硬件需求较小、更易部署、计算效率较高的bert模型上。通过利用微调bert模型和使用知识蒸馏的方式学习到大语言模型在财经新闻情感分析任务上积累的丰富知识,从而能够为投资决策提供可靠的情绪信号,同时降低计算资源需求。

技术实现思路

1、鉴于上述,本发明的目的是提供一种基于蒸馏提升bert的财经新闻情感分析方法和装置,能够将大语言模型的情感分析能力迁移到训练硬件需求更小、更易部署、计算效率更高的bert模型上,提高财经新闻情感分析的效率和准确性,为用户提供更有价值的情感分析结果。

2、为实现上述发明目的,本发明提供的技术方案如下:

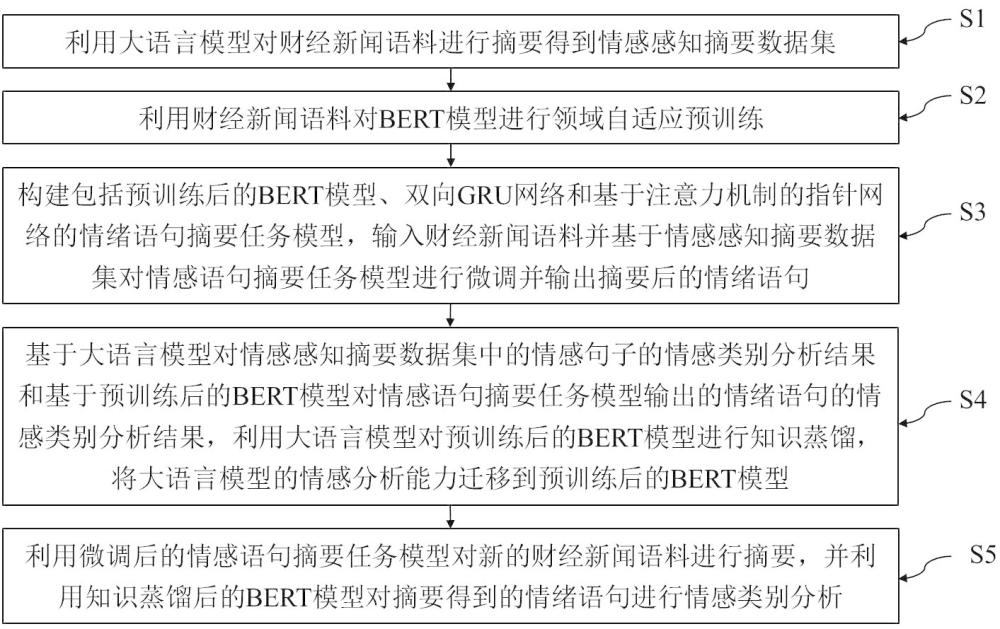

3、本发明实施例提供的一种基于蒸馏提升bert的财经新闻情感分析方法,包括以下步骤:

4、利用大语言模型对财经新闻语料进行摘要得到情感感知摘要数据集;

5、利用财经新闻语料对bert模型进行领域自适应预训练;

6、构建包括预训练后的bert模型、双向gru网络和基于注意力机制的指针网络的情绪语句摘要任务模型,输入财经新闻语料并基于情感感知摘要数据集对情感语句摘要任务模型进行微调并输出摘要后的情绪语句;

7、基于大语言模型对情感感知摘要数据集中的情感句子的情感类别分析结果和基于预训练后的bert模型对情感语句摘要任务模型输出的情绪语句的情感类别分析结果,利用大语言模型对预训练后的bert模型进行知识蒸馏,将大语言模型的情感分析能力迁移到预训练后的bert模型;

8、利用微调后的情感语句摘要任务模型对新的财经新闻语料进行摘要,并利用知识蒸馏后的bert模型对摘要得到的情绪语句进行情感类别分析。

9、优选地,所述利用大语言模型对财经新闻语料进行摘要得到情感感知摘要数据集,包括:

10、获取金融领域的财经新闻报道语料,语料中包括新闻编号、新闻标题、发布时间和新闻正文,并对新闻正文进行预处理,构建为财经新闻语料库;

11、利用大语言模型对预处理后的新闻正文进行摘要提取出情感句子,根据新闻正文和情感句子的对应关系构建情感感知摘要数据集。

12、优选地,所述利用财经新闻语料对bert模型进行领域自适应预训练,包括:

13、进行基于掩码语言模型任务的自适应预训练,包括:将财经新闻语料输入序列中的部分内容进行随机掩码处理,bert模型根据上下文学习预测这些被掩码内容;

14、进行基于下一句预测任务的自适应预训练,包括:输入财经新闻语料中的两个句子,bert模型预测这两个句子是否在原文中相邻。

15、优选地,双向gru网络包括正向gru和反向gru,预训练后的bert模型根据输入的财经新闻语料输出每个时刻的上下文向量,这些向量输入到双向gru网络中,其中正向gru按顺序读取输入的向量并生成时刻的正向隐藏状态,而反向gru按逆序读取输入的向量并生成反向隐藏状态,然后二者连接起来生成总时刻中的当前时刻的双向gru层输出隐藏状态。

16、优选地,基于注意力机制的指针网络包括gru循环神经网络、多头注意力层和复制指针层,预训练后的bert模型将每个时刻的生成词向量经gru循环神经网络得到输出时间步的隐藏状态,在多头注意力层通过计算隐藏状态和双向gru网络输出隐藏状态之间的相似度来获得注意力得分并进一步使用softmax函数将注意力得分转化为标准化的注意力权重,在复制指针层通过计算每个向量对应的注意力权重之和作为输出时间步对上下文向量中位置的关注程度的概率,选择最大概率值对应的位置所指向的词作为当前时刻的预测词用于构建初步情绪语句,生成的初步情绪语句将继续经过bert模型输出生成词向量,通过逐词生成得到摘要后的情绪语句。

17、优选地,由大语言模型对情感感知摘要数据集中的情感句子的情感类别分析,以及由预训练后的bert模型对情感语句摘要任务模型输出的情绪语句的情感类别分析,包括:

18、基于大语言模型对情感感知摘要数据集中的情感句子进行情感类别分析,得到每个情感类别的概率分布并对其进行温度参数调节后作为软标签,定义为:

19、,

20、其中,为大语言模型输出的第个情感类别的概率,为温度参数调节后的第个情感类别的概率,和均为情感类别的索引,,为情感类别总数, t为温度参数,并选取概率最大的类别作为硬标签;

21、基于预训练后的bert模型对情感语句摘要任务模型输出的情绪语句进行情感类别分析,其中在预训练后的bert模型最后增加逻辑单元和softmax激活层,由逻辑单元对预训练后的bert模型的输出进行线性分类后,再由softmax激活层输出情感分类概率分布并对其进行温度参数调节得到预测概率分布,定义为:

22、,

23、其中,为预训练后的bert模型输出的第个情感类别的概率,为逻辑单元输出的第类的逻辑单元值, t为温度参数。

24、优选地,情感类别包括消极、较消极、中性、较积极和积极。

25、优选地,在利用大语言模型对预训练后的bert模型进行知识蒸馏时,采用的知识蒸馏总损失函数包括分类任务损失和蒸馏损失;

26、计算分类任务损失如下:

27、,

28、其中,为大语言模型生成的对应第类别的硬标签的独热编码;

29、计算蒸馏损失如下:

30、,

31、最终的知识蒸馏总损失函数是分类任务损失和蒸馏损失的加权和:

32、,

33、其中,超参数用于控制蒸馏损失相对于分类任务损失的权重。

34、优选地,在利用知识蒸馏后的bert模型对摘要得到的情绪语句进行情感类别分析后,得到对每个情绪语句的情感类别的概率分布,通过对每个情感类别的概率赋予对应的权重后进行求和得到每个情绪语句情感得分,再将每个情绪语句情感得分进行求和平均得到每篇财经新闻语料的情感得分,根据一段时间内得到的财经新闻语料的情感得分绘制情绪指数曲线,能够对这段时间内财经新闻情感进行动态分析。

35、为实现上述发明目的,本发明实施例还提供了一种基于蒸馏提升bert的财经新闻情感分析装置,包括:摘要数据集构建模块、bert模型预训练模块、情感语句摘要任务模型微调模块、bert模型知识蒸馏模块和bert模型情感分析模块;

36、所述摘要数据集构建模块用于利用大语言模型对财经新闻语料进行摘要得到情感感知摘要数据集;

37、所述bert模型预训练模块用于利用财经新闻语料对bert模型进行领域自适应预训练;

38、所述情感语句摘要任务模型微调模块用于构建包括预训练后的bert模型、双向gru网络和基于注意力机制的指针网络的情绪语句摘要任务模型,输入财经新闻语料并基于情感感知摘要数据集对情感语句摘要任务模型进行微调并输出摘要后的情绪语句;

39、所述bert模型知识蒸馏模块用于基于大语言模型对情感感知摘要数据集中的情感句子的情感类别分析结果和基于预训练后的bert模型对情感语句摘要任务模型输出的情绪语句的情感类别分析结果,利用大语言模型对预训练后的bert模型进行知识蒸馏,将大语言模型的情感分析能力迁移到预训练后的bert模型;

40、所述bert模型情感分析模块用于利用微调后的情感语句摘要任务模型对新的财经新闻语料进行摘要,并利用知识蒸馏后的bert模型对摘要得到的情绪语句进行情感类别分析。

41、与现有技术相比,本发明具有的有益效果至少包括:

42、本发明中采用逐句情感判别策略,通过识别情感相关句子并剔除与情感无关的内容,来准确分析每个句子的情感表达。通过引入双向gru网络以提升对文本上下文的理解能力,并结合注意力机制的指针网络和微调预训练后的bert模型构建情绪语句摘要任务模型,确保其能够有效学习和迁移大语言模型在情感句子摘要方面的能力。同时,利用知识蒸馏技术,将大语言模型作为教师模型的情感分析能力转移到更适合部署的学生模型bert上,能够在保留高质量的情感分析能力的同时,显著减少计算资源的需求。此外,经过知识蒸馏后的bert模型对新闻正文进行情感摘要,计算每篇新闻的情感得分,以生成情绪指数曲线,能够为用户提供有价值的情感分析结果。

本文地址:https://www.jishuxx.com/zhuanli/20240911/293539.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表