一种样本图片生成方法及装置和设备与流程

- 国知局

- 2024-09-14 14:23:26

本发明涉及一种样本图片生成方法及装置和设备。

背景技术:

1、在一些场景下,由于自然真实图片很小,因此,通常需要采用技术手段生成一些与自然真实图片具有较高近似度的图片,比如,在交通领域,在进行交通标识数据收集时,对于一些不常见的交通标识其获取难度非常高。常规技术中通常使用gan神经网络来生成这些难于获取的图片。

2、gan神经网络又被称为对抗神经网络,包括生成器(generator network)和判别器(discriminator network),gan的核心逻辑就是生成器和判别器相互对抗、相互博弈。生成器generator network的任务是生成看起来自然真实和原始数据相似的实例。判别器discriminator network的任务是判断给定的实例看起来是自然真实的还是人为伪造的。在训练过程中,生成器的目标是生成尽可能多的接近真实图像的假图像来欺骗判别器,判别器的目标则是努力试图将生成器生成的假图像与真实图像区分开来。模型经过交替优化训练,两种模型都能得到提升,最终得到效果提升到很高的生成模型,理论上,最终生成模型所生成的假图像能达到真假难分的地步。

技术实现思路

1、本发明的发明人发现,现有技术中的gan神经网络在训练过程中仅使用两次判别器,生成的样本图片是偏向于目标样本图片或者参考样本图片,并不能够很好的得到混合效果的图片,使得整体的输出图片缺乏鲁棒性。基于此,发明人提出了本发明以便提供一种克服上述问题或者至少部分地解决现有技术中所存在的上述问题的一种样本图片生成方法及装置和设备。

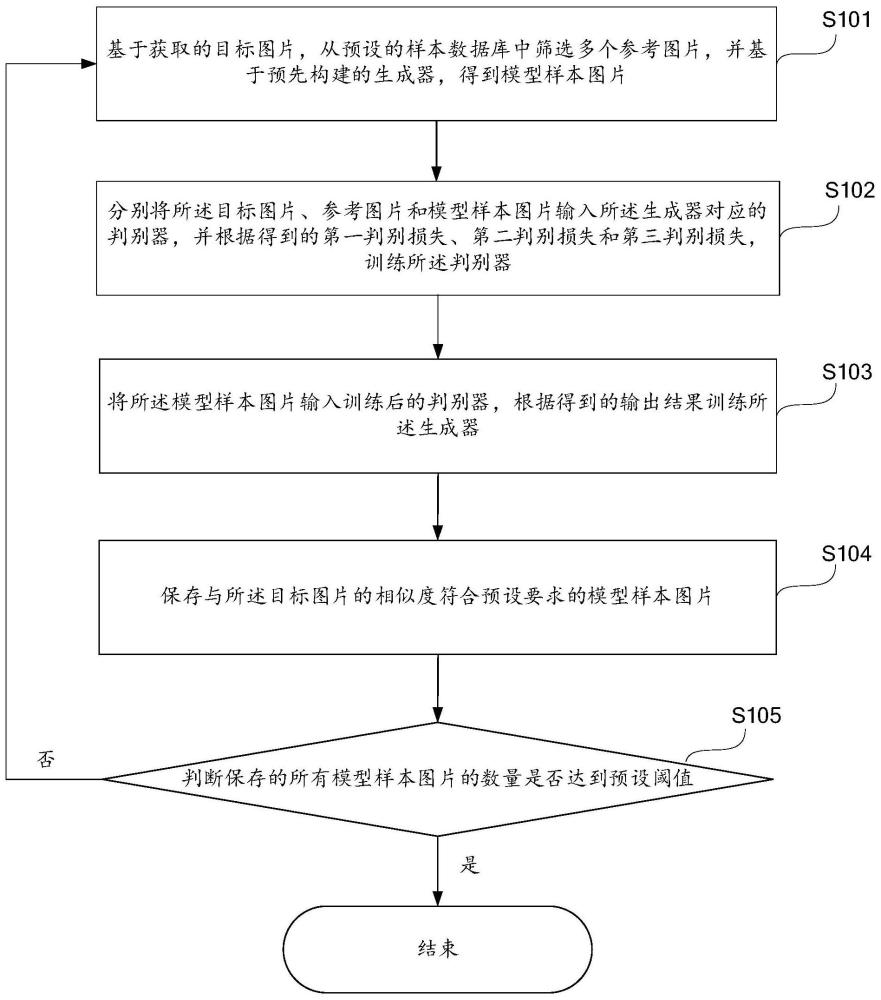

2、第一方面,本发明实施例提供一种样本图片生成方法,该方法包括:

3、基于获取的目标图片,从预设的样本数据库中筛选多个参考图片,并基于预先构建的生成器,得到模型样本图片;

4、分别将所述目标图片、参考图片和模型样本图片输入所述生成器对应的判别器,并根据得到的第一判别损失、第二判别损失和第三判别损失,训练所述判别器;

5、将所述模型样本图片输入训练后的判别器,根据得到的输出结果训练所述生成器;

6、保存与所述目标图片的相似度符合预设要求的模型样本图片;

7、判断保存的所有模型样本图片的数量是否达到预设阈值,若否,则重复执行上述得到模型样本图片、训练判别器和生成器的步骤。

8、在一个或一些可选的实施例中,通过下述方式得到第一判别损失、第二判别损失和第三判别损失,包括:

9、将所述目标图片输入所述判别器,得到第一输出矩阵,根据所述第一输出矩阵与预设的第一真值矩阵,得到第一判别损失;其中,第一输出矩阵与所述第一真值矩阵均为n*n的矩阵,n为正整数,所述第一真值矩阵中表示所述目标图片的前景区域的元素的值大于表示所述目标图片的背景区域的元素的值;

10、将所述参考图片输入所述判别器,得到第二输出矩阵,根据所述第二输出矩阵与预设的第二真值矩阵,得到第二判别损失;其中,第二输出矩阵与所述第二真值矩阵均为n*n的矩阵,所述第二真值矩阵中表示所述参考图片的前景区域的元素的值小于表示所述参考图片的背景区域的元素的值;所述第二真值矩阵中表示所述参考图片的前景区域的元素的值小于表示第一真值矩阵中表示所述目标图片的前景区域的元素的值,所述第二真值矩阵中表示所述参考图片的背景区域的元素的值小于所述第一真值矩阵中表示所述目标图片的背景区域的元素的值;

11、将所述模型样本图片输入所述判别器,得到第三输出矩阵,根据所述第三输出矩阵与预设的第三真值矩阵,得到第三判别损失;其中,第三输出矩阵与所述第三真值矩阵均为n*n的矩阵,所述第三真值矩阵中表示所述模型样本图片的前景区域的元素的值等于表示所述模型样本图片的背景区域的元素的值。

12、在一个或一些可选的实施例中,根据所述第一判别损失、第二判别损失和第三判别损失,训练所述判别器,包括:

13、根据所述第一判别损失、第二判别损失和第三判别损失,计算得到所述判别器的判别损失结果;

14、根据所述判别损失结果训练所述判别器,得到训练后的判别器。

15、在一个或一些可选的实施例中,所述的方法还包括:

16、在得到所述第一判别损失、第二判别损失和第三判别损失之后,分别对所述判别器进行反向传播训练。

17、在一个或一些可选的实施例中,所述将所述模型样本图片输入所述训练后的判别器,根据得到的输出结果训练所述生成器,包括:

18、将所述模型样本图片输入所述训练后的判别器,得到第四输出矩阵,根据所述第四输出矩阵与预设的第四真值矩阵,得到第四判别损失,根据所述第四判别损失更新所述生成器,得到训练后的生成器;其中,所述第四输出矩阵与所述第四真值矩阵均为n*n的矩阵,所述第四真值矩阵中表示所述模型样本图片的前景区域的元素的值等于表示所述模型样本图片的背景区域的元素的值。

19、在一个或一些可选的实施例中,所述的方法还包括:

20、在得到所述第四判别损失之后,对所述生成器进行反向传播训练。

21、在一个或一些可选的实施例中,所述基于获取的目标图片,从预设的样本数据库中筛选多个参考图片,包括:

22、获取所述目标图片的目标特征向量,将所述目标特征向量与所述样本数据库中的图片进行相似度比较,筛选得到所述多个参考图片。

23、在一个或一些可选的实施例中,所述获取所述目标图片的目标特征向量,将所述目标图片与所述样本数据库中的图片进行相似度比较,筛选得到所述多个参考图片,包括:

24、获取所述目标图片的目标特征向量,将所述目标特征向量与所述样本数据库中的图片进行相似度比较,筛选得到多个参考候选图片;

25、从所述多个参考候选图片中,随机筛选得到所述多个参考图片。

26、在一个或一些可选的实施例中,基于预先构建的生成器,通过下述方式得到所述模型样本图片,包括:

27、将所述目标图片与每一参考图片构建模型数据对,将所述模型数据对的参考图片输入所述生成器的编码器进行特征提取,得到参考图片特征向量;

28、将所述参考图片特征向量与所述目标特征向量输入所述生成器的注意力模块进行计算,得到注意力特征向量;

29、将所述注意力特征向量输入所述生成器的解码器进行处理,得到所述模型样本图片。

30、在一个或一些可选的实施例中,在重复执行上述得到模型样本图片、训练判别器和生成器的步骤时,重新从所述多个参考候选图片中,随机筛选得到多个参考图片。

31、在一个或一些可选的实施例中,通过下述方式确定所述目标图片的目标特征向量:

32、将所述目标图片输入预先训练的特征提取模型,得到所述目标特征向量。

33、在一个或一些可选的实施例中,所述保存与所述目标图片的相似度符合预设要求的模型样本图片,包括:

34、判断所述模型样本图片与所述目标图片的相似度是否达到预设阈值;

35、若是,则保存所述模型样本图片。

36、第二方面,本发明实施例提供一种样本图片生成装置,该装置包括:

37、生成模块,用于基于获取的目标图片,从预设的样本数据库中筛选多个参考图片,并基于预先构建的生成器,得到模型样本图片;

38、判别器训练模块,用于分别将所述目标图片、参考图片和模型样本图片输入所述生成器对应的判别器,并根据得到的第一判别损失、第二判别损失和第三判别损失,训练所述判别器;

39、生成器训练模块,用于将所述模型样本图片输入所述训练后的判别器,根据得到的输出结果训练所述生成器;

40、保存模块,用于保存与所述目标图片的相似度符合预设要求的模型样本图片;

41、判断模块,用于判断保存的所有模型样本图片的数量是否达到预设阈值。

42、第三方面,本发明实施例提供一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现如上述的样本图片生成方法。

43、第四方面,本发明实施例提供一种计算机设备,包括存储器,处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现如上述的样本图片生成方法。

44、本发明实施例提供的上述技术方案的有益效果至少包括:

45、本发明提供的样本图片生成方法,通过同时使用目标图片、参考图片和模型样本图片,在gan神经网络的训练过程中增加了两次判别器的使用过程,从而使得生成的模型样本图片同时受到目标图片和参考图片的影响,增强了模型样本图片的混合效果,提升了生成的图片的质量,提高了gan神经网络生成的模型样本图片的鲁棒性。并且,相比于现有技术中的其他基于标签的语义训练得到的图片,本方法得到的模型样本图片是无语义的,因此可以在不同的应用场景重复使用,具有更好的使用灵活性。

46、本发明提供的样本图片生成方法,在三次训练判别器确定判别损失过程中,采用具有掩码性质的真值矩阵,通过设置目标图片、参考图片和模型样本图片分别对应的真值矩阵的背景区域和前景区域的元素的特征值,实现控制生成图片的区域,包括生成的图片的背景区域和前景区域,分别受到目标图片和参考图片影响,从而能更好的控制生成的模型样本图片的质量。

47、本发明的其它特征和优点将在随后的说明书中阐述,并且,部分地从说明书中变得显而易见,或者通过实施本发明而了解。本发明的目的和其他优点可通过在所写的说明书、权利要求书、以及附图中所特别指出的结构来实现和获得。

48、下面通过附图和实施例,对本发明的技术方案做进一步的详细描述。

本文地址:https://www.jishuxx.com/zhuanli/20240914/293786.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。