一种基于门控TCN-attention的高效语言注意力机制的方法及装置与流程

- 国知局

- 2024-09-14 15:04:26

本发明涉及计算机神经网络领域,尤其涉及一种基于门控tcn-attention的高效语言注意力机制的方法及装置。

背景技术:

1、在当今快速发展的信息时代,神经网络模型作为人工智能领域的核心组件,正引领着技术革新与产业升级的浪潮。随着大数据的爆发式增长和计算能力的飞跃提升,深度学习技术,尤其是神经网络模型,展现出前所未有的潜力,在图像识别、自然语言处理、推荐系统、智能驾驶等众多领域取得了突破性进展。然而,随着模型规模的不断扩大和应用场景的日益复杂,如何高效地设计、训练和部署这些模型,成为了亟需解决的关键问题。

技术实现思路

1、本发明提供一种基于门控tcn-attention的高效语言注意力机制的方法及装置,以解决现有神经网络模型的运算速度慢、感受野太小、模型在进行运算时性能不稳定、运行内存占用大的问题。

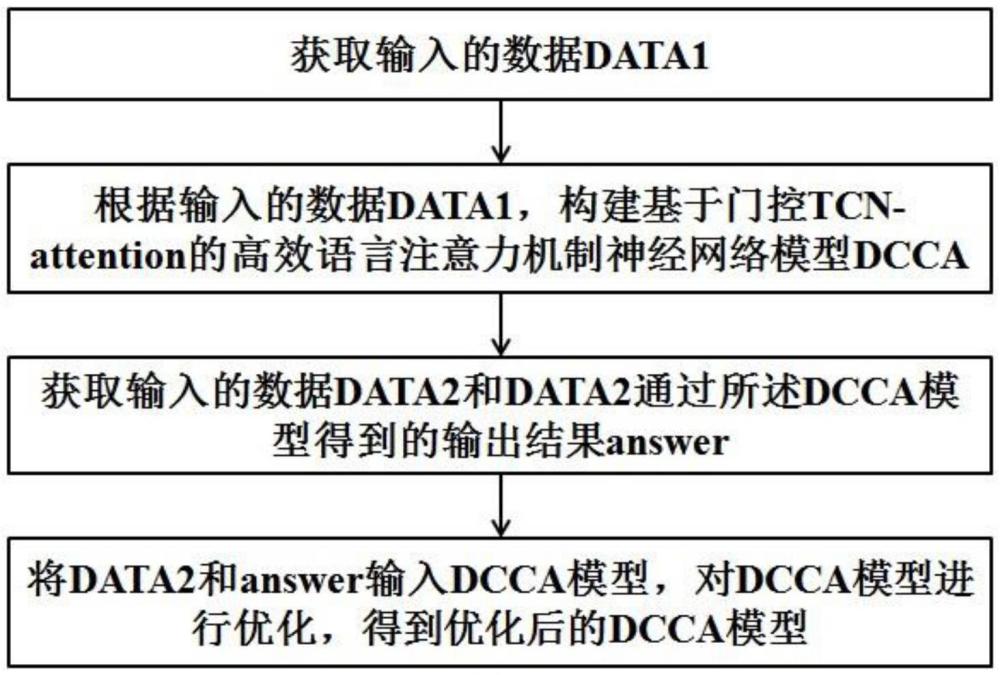

2、第一个方面,本发明提供了一种基于门控tcn-attention的高效语言注意力机制的方法,或者构建基于门控tcn-attention的高效语言注意力机制的神经网络模型的方法,具体包括如下步骤:

3、步骤s1、获取输入的数据data1;

4、步骤s2、根据输入的数据data1,构建基于门控tcn-attention的高效语言注意力机制的神经网络模型dcca;

5、步骤s3、获取输入的数据data2和data2通过所述dcca模型得到的输出结果answer;

6、步骤s4、将data2和answer输入dcca模型,对dcca模型进行优化,得到优化后的dcca模型。

7、优选地,步骤s2中,构建所述基于门控tcn-attention的高效语言注意力机制的dcca模型,具体包括如下步骤:

8、步骤s201、对输入的数据data1进行编码,形成编码形式的输入矩阵x=x1,x2,...,xt;

9、步骤s202、初始化矩阵wq、wk、wv;

10、步骤s203、通过矩阵wq、wk、wv对输入矩阵x进行矩阵变换,形成矩阵q1、矩阵k1、矩阵v1;

11、步骤s204、对矩阵q1进行门控处理,形成数据矩阵a;

12、步骤s205、提取矩阵k1的上下文特征,形成数据矩阵b;

13、步骤s206、将数据矩阵b和矩阵v1进行点乘,形成数据矩阵c;

14、步骤s207、将数据矩阵a和数据矩阵c进行点乘,得到结果o1;

15、步骤s208、计算结果o1和矩阵x的交叉熵损失函数值,输出dcca模型。

16、优选地,步骤s202中,所述矩阵wq,wk,wv∈rd×d均为可学习矩阵。

17、优选地,步骤s203中,矩阵q1、矩阵k1和矩阵v1的计算公式如下所示:

18、q1=xwq

19、k1=xwk

20、v1=xwv

21、其中,x=x1,x2,…,xt∈rt×d表示输入矩阵,q1,k1,v1∈rt×d和输入矩阵x具有相同的维度。

22、优选地,步骤s204中,矩阵q1通过门控激活进行门控处理,用来去除过大或过小的数据。

23、更优选地,所述门控激活函数为sigmoid函数。

24、优选地,步骤s205中,通过dc-conv网络模型提取矩阵k1的上下文特征。

25、其中,所述dc-conv网络模型包括因果卷积神经网络模型(casual convolution,c-conv)和dilation。

26、其中,在dc-conv网络模型中,当前token的输出仅与当前token的输入元素xt以及前序相邻token的输入元素(xt-1,xt-2,…,x2,x1)的卷积有关。

27、其中,dc-conv网络模型在时间t处第n层的卷积过程fdc-conv的表示如下所示:

28、

29、其中,xt表示在时间t时的输入数据,h(i)表示对应隐藏层的第i个滤波器,k表示滤波器的内核大小(也称滤波器的数量),t-di表示时间t的前di时刻。

30、优选地,在通过步骤s205获得数据矩阵b后,将数据矩阵b通过softmax函数进行归一化,得到attention分数,设置attention分数指标是为了引导模型的后续优化。

31、优选地,步骤s208中,所述dcca模型的计算公式如下所示:

32、

33、其中,σ1表示门控激活函数,⊙表示点乘。

34、其中,通过实现对矩阵k1中的数据进行缩放,以减少softmax函数的计算量。

35、优选地,步骤s4中,对dcca模型进行优化,具体包括如下步骤:

36、步骤s401、对输入的数据data2进行编码,形成编码形式的输入矩阵y=y1,y2,…,yt;

37、步骤s402、通过矩阵wq、wk、wv对输入矩阵y进行矩阵变换,形成矩阵q2、矩阵k2、矩阵v2;

38、步骤s403、对矩阵q2进行门控处理,形成数据矩阵e;

39、步骤s404、提取矩阵k2的上下文特征,形成数据矩阵f;

40、步骤s405、将数据矩阵f和矩阵v2进行点乘,形成数据矩阵g;

41、步骤s406、将数据矩阵e和数据矩阵g进行点乘,得到结果o2;

42、步骤s407、计算结果o2和answer的交叉熵损失函数值,输出优化后的dcca模型。

43、优选地,步骤s402中,矩阵q2、矩阵k2和矩阵v2的计算公式如下所示:

44、q2=ywq

45、k2=ywk

46、v2=ywv

47、其中,y=y1,y2,…,yt∈rt×d表示输入矩阵,q2,k2,v2∈rt×d和输入矩阵y具有相同的维度。

48、优选地,步骤s403中,矩阵q2通过门控激活进行门控处理,用来去除过大或过小的数据。

49、更优选地,所述门控激活函数为sigmoid函数。

50、优选地,步骤s404中,通过dc-conv网络模型提取矩阵k2的上下文特征。

51、其中,所述dc-conv网络模型包括因果卷积神经网络模型(casual convolution,c-conv)和dilation。

52、其中,在dc-conv网络模型中,当前token的输出仅与当前token的输入元素yt以及前序相邻token的输入元素(yt-1,yt-2,…,y2,y1)的卷积有关。

53、其中,dc-conv网络模型在时间t处第n层的卷积过程fdc-conv的表示如下所示:

54、

55、其中,yt表示在时间t时的输入数据,h(i)表示对应隐藏层的第i个滤波器,k表示滤波器的内核大小(也称滤波器的数量),t-di表示时间t的前di时刻。

56、优选地,在通过步骤s404获得数据矩阵f后,将数据矩阵f通过softmax函数进行归一化,得到attention分数,设置attention分数指标是为了引导模型的后续优化。

57、优选地,步骤s407中,所述dcca模型的计算公式如下所示:

58、

59、其中,σ2表示门控激活函数,⊙表示点乘。

60、其中,通过实现对矩阵k2中的数据进行缩放,以减少softmax函数的计算量。

61、第二个方面,本发明还提供了一种基于门控tcn-attention的高效语言注意力机制的装置,或者一种构建基于门控tcn-attention的高效语言注意力机制的神经网络模型的装置,具体包括如下模块:

62、输入数据获取模块,用于获取输入的数据data1;

63、模型构建模块,用于根据输入的数据data1,构建基于门控tcn-attention的高效语言注意力机制的神经网络模型dcca;

64、模型优化输入数据获取模块,用于获取输入的数据data2和data2通过所述dcca模型得到的输出结果answer;

65、模型优化模块,用于将data2和answer输入dcca模型,对dcca模型进行优化,得到优化后的dcca模型。

66、优选地,模型构建模块中,具体包括如下子模块:

67、第一输入数据编码子模块,用于对输入的数据data1进行编码,形成编码形式的输入矩阵x=x1,x2,...,xt;

68、第一矩阵初始化子模块,用于初始化矩阵wq、wk、wv;

69、第一矩阵变换子模块,用于通过矩阵wq、wk、wv对输入矩阵x进行矩阵变换,形成矩阵q1、矩阵k1、矩阵v1;

70、第一门控处理子模块,用于对矩阵q1进行门控处理,形成数据矩阵a;

71、第一上下文特征提取子模块,用于提取矩阵k1的上下文特征,形成数据矩阵b;

72、第一点乘子模块,用于将数据矩阵b和矩阵v1进行点乘,形成数据矩阵c;

73、第二点乘子模块,用于将数据矩阵a和数据矩阵c进行点乘,得到结果o1;

74、第一模型输出子模块,用于计算结果o1和矩阵x的交叉熵损失函数值,输出dcca模型。

75、优选地,第一矩阵初始化子模块中,所述矩阵wq,wk,wv∈rd×d均为可学习矩阵。

76、优选地,第一矩阵变换子模块中,矩阵q1、矩阵k1和矩阵v1的计算公式如下所示:

77、q1=xwq

78、k1=xwk

79、v1=xwv

80、其中,x=x1,x2,…,xt∈rt×d表示输入矩阵,q1,k1,v1∈rt×d和输入矩阵x具有相同的维度。

81、优选地,第一门控处理子模块中,矩阵q1通过门控激活进行门控处理,用来去除过大或过小的数据。

82、更优选地,所述门控激活函数为sigmoid函数。

83、优选地,第一上下文特征提取子模块中,通过dc-conv网络模型提取矩阵k1的上下文特征。

84、其中,所述dc-conv网络模型包括因果卷积神经网络模型(casual convolution,c-conv)和dilation。

85、其中,在dc-conv网络模型中,当前token的输出仅与当前token的输入元素xt以及前序相邻token的输入元素(xt-1,xt-2,…,x2,x1)的卷积有关。

86、其中,dc-conv网络模型在时间t处第n层的卷积过程fdc-conv的表示如下所示:

87、

88、其中,xt表示在时间t时的输入数据,h(i)表示对应隐藏层的第i个滤波器,k表示滤波器的内核大小(也称滤波器的数量),t-di表示时间t的前di时刻。

89、优选地,在通过第一上下文特征提取子模块获得数据矩阵b后,将数据矩阵b通过softmax函数进行归一化,得到attention分数,设置attention分数指标是为了引导模型的后续优化。

90、优选地,第一模型输出子模块中,所述dcca模型计算的公式如下所示:

91、

92、其中,σ1表示门控激活函数,⊙表示点乘。

93、其中,通过实现对矩阵k1中的数据进行缩放,以减少softmax函数的计算量。

94、优选地,模型优化模块中,具体包括如下子模块:

95、第二输入数据编码子模块,用于对输入的数据data2进行编码,形成编码形式的输入矩阵y=y1,y2,...,yt;

96、第二矩阵变换子模块,用于通过矩阵wq、wk、wv对输入矩阵y进行矩阵变换,形成矩阵q2、矩阵k2、矩阵v2;

97、第二门控处理子模块,用于对矩阵q2进行门控处理,形成数据矩阵e;

98、第二上下文特征提取子模块,用于提取矩阵k2的上下文特征,形成数据矩阵f;

99、第三点乘子模块,用于将数据矩阵f和矩阵v2进行点乘,形成数据矩阵g;

100、第四点乘子模块,用于将数据矩阵e和数据矩阵g进行点乘,得到结果o2;

101、第二模型输出子模块,用于计算结果o2和answer的交叉熵损失函数值,输出优化后的dcca模型。

102、优选地,第二矩阵变换子模块中,矩阵q2、矩阵k2和矩阵v2的计算公式如下所示:

103、q2=ywq

104、k2=ywk

105、v2=ywv

106、其中,y=y1,y2,…,yt∈rt×d表示输入矩阵,q2,k2,v2∈rt×d和输入矩阵y具有相同的维度。

107、优选地,第二门控处理子模块中,矩阵q2通过门控激活进行门控处理,用来去除过大或过小的数据。

108、更优选地,所述门控激活函数为sigmoid函数。

109、优选地,第二上下文特征提取子模块中,通过dc-conv网络模型提取矩阵k2的上下文特征。

110、其中,所述dc-conv网络模型包括因果卷积神经网络模型(casual convolution,c-conv)和dilation。

111、其中,在dc-conv网络模型中,当前token的输出仅与当前token的输入元素yt以及前序相邻token的输入元素(yt-1,yt-2,…,y2,y1)的卷积有关。

112、其中,dc-conv网络模型在时间t处第n层的卷积过程fdc-conv的表示如下所示:

113、

114、其中,yt表示在时间t时的输入数据,h(i)表示对应隐藏层的第i个滤波器,k表示滤波器的内核大小(也称滤波器的数量),t-di表示时间t的前di时刻。

115、优选地,在通过第二上下文特征提取子模块获得数据矩阵f后,将数据矩阵f通过softmax函数进行归一化,得到attention分数,设置attention分数指标是为了引导模型的后续优化。

116、优选地,第二模型输出子模块中,所述dcca模型的计算公式如下所示:

117、

118、其中,σ2表示门控激活函数,⊙表示点乘。

119、其中,通过实现对矩阵k2中的数据进行缩放,以减少softmax函数的计算量。

120、第三个方面,本发明还提供一种计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现本技术第一方面中任一项所述的一种基于门控tcn-attention的高效语言注意力机制的方法。

121、第四个方面,本发明还提供一种电子设备,所述电子设备包括:存储器,存储有一计算机程序:处理器,与所述存储器通信相连,调用所述计算机程序时执行本技术第一方面中任一项所述的一种基于门控tcn-attention的高效语言注意力机制的方法。

122、本发明与现有技术相比较,具有如下显而易见的突出实质性特点和显著优点:

123、本发明提出了一种基于门控tcn-attention的高效语言注意力机制的方法及装置,解决了现有神经网络模型的运算速度慢、感受野太小、模型在进行运算时性能不稳定、运行内存占用大的问题。通过神经网络模型的合理规划,提升了神经网络模型的感受野、模型的运算速度,降低了模型运算时的运行内存、模型的运算时间,进而实现了神经网络模型对于数据的高效处理。

本文地址:https://www.jishuxx.com/zhuanli/20240914/296849.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。